update at 2024-04-12 16:19:36

parent

9735479315

commit

0eedaca203

|

|

@ -1,3 +0,0 @@

|

|||

# Kubernetes 排障案例

|

||||

|

||||

记录本人多年积累的 Kubernetes 相关的排障案例。

|

||||

|

|

@ -1,76 +0,0 @@

|

|||

# 误删 rancher 的 namespace 导致 node 被清空

|

||||

|

||||

## 问题描述

|

||||

|

||||

集群的节点突然全都不见了 (`kubectl get node` 为空),导致集群瘫痪,但实际上节点对应的虚拟机都还在。因为集群没开审计,所以也不太好查 node 是被什么删除的。

|

||||

|

||||

## 快速恢复

|

||||

|

||||

由于只是 k8s node 资源被删除,实际的机器都还在,我们可以批量重启节点,自动拉起 kubelet 重新注册 node,即可恢复。

|

||||

|

||||

## 可疑操作

|

||||

|

||||

发现在节点消失前,有个可疑的操作: 有同学发现在另外一个集群里有许多乱七八糟的 namespace (比如 `c-dxkxf`),查看这些 namespace 中没有运行任何工作负载,可能是其它人之前创建的测试 namespace,就将其删除掉了。

|

||||

|

||||

## 分析

|

||||

|

||||

删除 namespace 的集群中安装了 rancher,怀疑被删除的 namespace 是 rancher 自动创建的。

|

||||

|

||||

rancher 管理了其它 k8s 集群,架构图:

|

||||

|

||||

|

||||

|

||||

猜想: 删除的 namespace 是 rancher 创建的,删除时清理了 rancher 的资源,也触发了 rancher 清理 node 的逻辑。

|

||||

|

||||

## 模拟复现

|

||||

|

||||

尝试模拟复现,验证猜想:

|

||||

1. 创建一个 k8s 集群,作为 rancher 的 root cluster,并将 rancher 安装进去。

|

||||

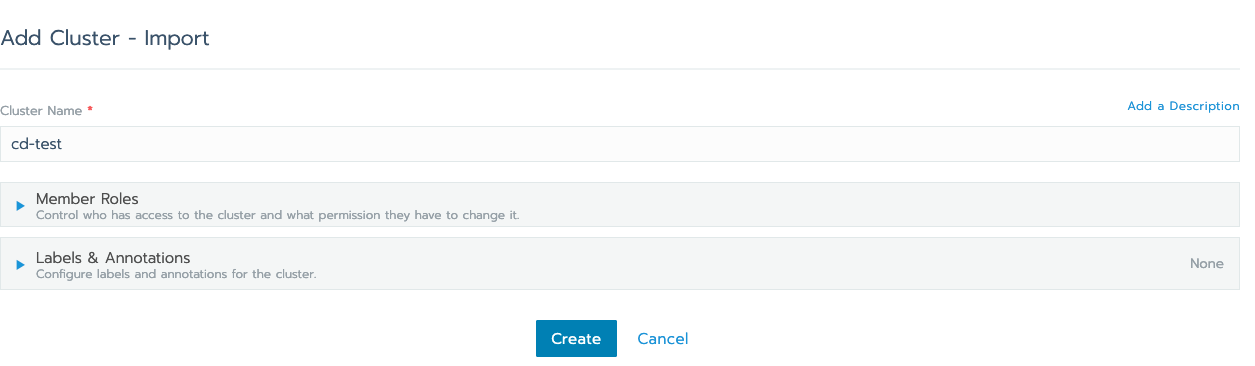

2. 进入 rancher web 界面,创建一个 cluster,使用 import 方式:

|

||||

|

||||

|

||||

|

||||

3. 输入 cluster name:

|

||||

|

||||

|

||||

|

||||

4. 弹出提示,让在另一个集群执行下面的 kubectl 命令将其导入到 rancher:

|

||||

|

||||

|

||||

|

||||

5. 创建另一个 k8s 集群作为被 rancher 管理的集群,并将 kubeconfig 导入本地以便后续使用 kubectl 操作。

|

||||

6. 导入 kubeconfig 并切换 context 后,执行 rancher 提供的 kubectl 命令将集群导入 rancher:

|

||||

|

||||

|

||||

|

||||

可以看到在被管理的 TKE 集群中自动创建了 cattle-system 命名空间,并运行一些 rancher 的 agent:

|

||||

|

||||

|

||||

|

||||

7. 将 context 切换到安装 rancher 的集群 (root cluster),可以发现添加集群后,自动创建了一些 namespace: 1 个 `c-` 开头的,2 个 `p-` 开头的:

|

||||

|

||||

|

||||

|

||||

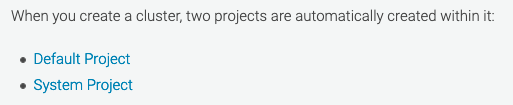

猜想是 `c-` 开头的 namespace 被 rancher 用来存储所添加的 `cluster` 的相关信息;`p-` 用于存储 `project` 相关的信息,官方也说了会自动为每个 cluster 创建 2 个 project:

|

||||

|

||||

|

||||

|

||||

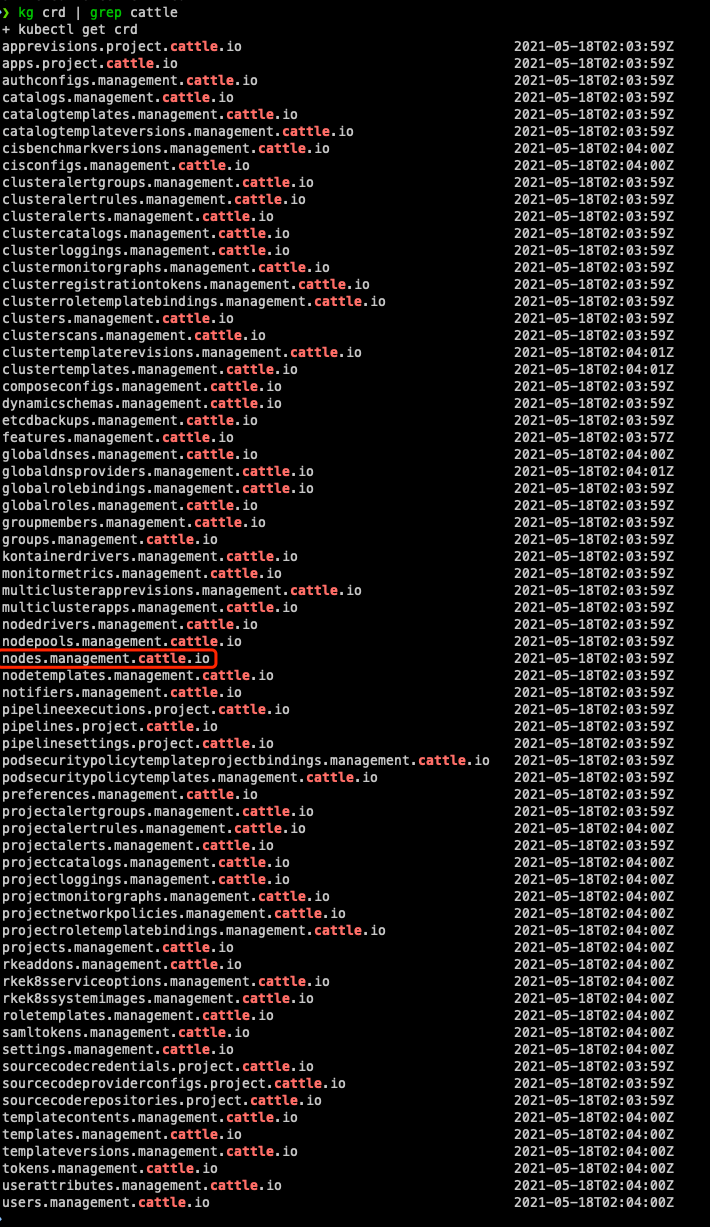

8. 查看有哪些 rancher 的 crd,有个 `nodes.management.cattle.io` 比较显眼,明显用于存储 cluster 的 node 信息:

|

||||

|

||||

|

||||

|

||||

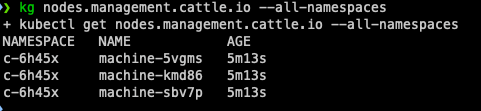

9. 看下 node 存储在哪个 namespace (果然在 `c-` 开头的 namespace 中):

|

||||

|

||||

|

||||

|

||||

10. 尝试删除 `c-` 开头的 namesapce,并切换 context 到被添加的集群,执行 `kubectl get node`:

|

||||

|

||||

|

||||

|

||||

节点被清空,问题复现。

|

||||

|

||||

## 结论

|

||||

|

||||

实验证明,rancher 的 `c-` 开头的 namespace 保存了所添加集群的 node 信息,如果删除了这种 namespace,也就删除了其中所存储的 node 信息,rancher watch 到了就会自动删除所关联集群的 k8s node 资源。

|

||||

|

||||

所以,千万不要轻易去清理 rancher 创建的 namespace,rancher 将一些有状态信息直接存储到了 root cluster 中 (通过 CRD 资源),删除 namespace 可能造成很严重的后果。

|

||||

|

|

@ -1,11 +0,0 @@

|

|||

# kubectl 执行 exec 或 logs 失败

|

||||

|

||||

## 原因

|

||||

|

||||

通常是 `kube-apiserver` 到 `kubelet:10250` 之间的网络不通,10250 是 kubelet 提供接口的端口,`kubectl exec` 和 `kubectl logs` 的原理就是 apiserver 调 kubelet,kubelet 再调运行时 (比如 dockerd) 来实现的。

|

||||

|

||||

## 解决方案

|

||||

|

||||

保证 kubelet 10250 端口对 apiserver 放通。

|

||||

|

||||

检查防火墙、iptables 规则是否对 10250 端口或某些 IP 进行了拦截。

|

||||

|

|

@ -1,173 +0,0 @@

|

|||

# 调度器 cache 快照遗漏部分信息导致 pod pending

|

||||

|

||||

## 问题背景

|

||||

|

||||

新建一个如下的 k8s 集群,有3个master node和1个worker node(worker 和 master在不同的可用区),node信息如下:

|

||||

|

||||

| node | label信息 |

|

||||

|:----|:----|

|

||||

| master-01 | failure-domain.beta.kubernetes.io/region=sh,failure-domain.beta.kubernetes.io/zone=200002 |

|

||||

| master-02 | failure-domain.beta.kubernetes.io/region=sh,failure-domain.beta.kubernetes.io/zone=200002 |

|

||||

| master-03 | failure-domain.beta.kubernetes.io/region=sh,failure-domain.beta.kubernetes.io/zone=200002 |

|

||||

| worker-node-01 | failure-domain.beta.kubernetes.io/region=sh,failure-domain.beta.kubernetes.io/zone=200004 |

|

||||

|

||||

待集群创建好之后,然后创建了一个daemonset对象,就出现了daemonset的某个pod一直卡主pending状态的现象。

|

||||

|

||||

现象如下:

|

||||

|

||||

```bash

|

||||

$ kubectl get pod -o wide

|

||||

NAME READY STATUS RESTARTS AGE NODE

|

||||

debug-4m8lc 1/1 Running 1 89m master-01

|

||||

debug-dn47c 0/1 Pending 0 89m <none>

|

||||

debug-lkmfs 1/1 Running 1 89m master-02

|

||||

debug-qwdbc 1/1 Running 1 89m worker-node-01

|

||||

```

|

||||

|

||||

## 结论先行

|

||||

|

||||

k8s的调度器在调度某个pod时,会从调度器的内部cache中同步一份快照(snapshot),其中保存了pod可以调度的node信息。

|

||||

|

||||

上面问题(daemonset的某个pod实例卡在pending状态)发生的原因就是同步的过程发生了部分node信息丢失,导致了daemonset的部分pod实例无法调度到指定的节点上,出现了pending状态。

|

||||

|

||||

接下来是详细的排查过程。

|

||||

|

||||

## 日志排查

|

||||

|

||||

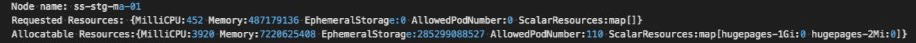

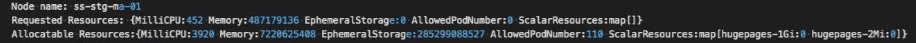

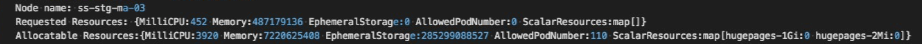

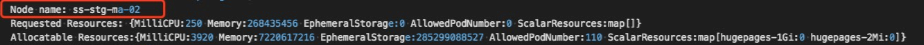

截图中出现的节点信息(来自用户线上集群):

|

||||

* k8s master节点:ss-stg-ma-01、ss-stg-ma-02、ss-stg-ma-03

|

||||

* k8s worker节点:ss-stg-test-01

|

||||

|

||||

1. 获取调度器的日志

|

||||

|

||||

这里首先是通过动态调大调度器的日志级别,比如,直接调大到`V(10)`,尝试获取一些相关日志。

|

||||

|

||||

当日志级别调大之后,有抓取到一些关键信息,信息如下:

|

||||

|

||||

|

||||

|

||||

* 解释一下,当调度某个pod时,有可能会进入到调度器的抢占`preempt`环节,而上面的日志就是出自于抢占环节。 集群中有4个节点(3个master node和1个worker node),但是日志中只显示了3个节点,缺少了一个master节点。所以,这里暂时怀疑下是调度器内部缓存cache中少了`node info`。

|

||||

|

||||

2. 获取调度器内部cache信息

|

||||

|

||||

k8s v1.18已经支持打印调度器内部的缓存cache信息。打印出来的调度器内部缓存cache信息如下:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

可以看出,调度器的内部缓存cache中的`node info`是完整的(3个master node和1个worker node)。

|

||||

|

||||

通过分析日志,可以得到一个初步结论:调度器内部缓存cache中的`node info`是完整的,但是当调度pod时,缓存cache中又会缺少部分node信息。

|

||||

|

||||

## 问题根因

|

||||

|

||||

在进一步分析之前,我们先一起再熟悉下调度器调度pod的流程(部分展示)和nodeTree数据结构。

|

||||

|

||||

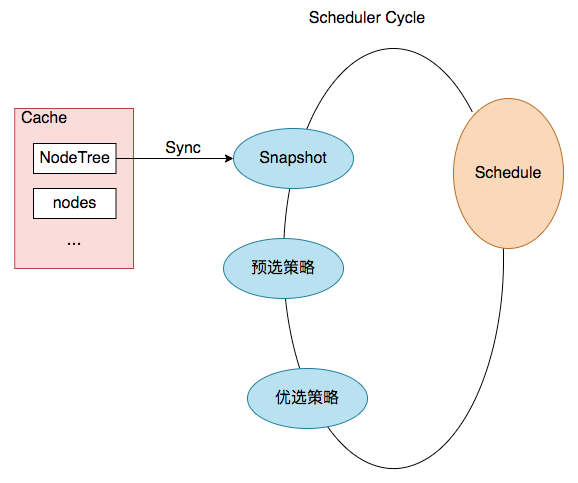

### **pod调度流程(部分展示)**

|

||||

|

||||

|

||||

|

||||

结合上图,一次pod的调度过程就是一次`Scheduler Cycle`。在这个`Cycle`开始时,第一步就是`update snapshot`。snapshot我们可以理解为cycle内的cache,其中保存了pod调度时所需的`node info`,而`update snapshot`,就是一次nodeTree(调度器内部cache中保存的node信息)到`snapshot`的同步过程。

|

||||

|

||||

而同步过程主要是通过`nodeTree.next()`函数来实现,函数逻辑如下:

|

||||

|

||||

```go

|

||||

// next returns the name of the next node. NodeTree iterates over zones and in each zone iterates

|

||||

// over nodes in a round robin fashion.

|

||||

func (nt *nodeTree) next() string {

|

||||

if len(nt.zones) == 0 {

|

||||

return ""

|

||||

}

|

||||

numExhaustedZones := 0

|

||||

for {

|

||||

if nt.zoneIndex >= len(nt.zones) {

|

||||

nt.zoneIndex = 0

|

||||

}

|

||||

zone := nt.zones[nt.zoneIndex]

|

||||

nt.zoneIndex++

|

||||

// We do not check the exhausted zones before calling next() on the zone. This ensures

|

||||

// that if more nodes are added to a zone after it is exhausted, we iterate over the new nodes.

|

||||

nodeName, exhausted := nt.tree[zone].next()

|

||||

if exhausted {

|

||||

numExhaustedZones++

|

||||

if numExhaustedZones >= len(nt.zones) { // all zones are exhausted. we should reset.

|

||||

nt.resetExhausted()

|

||||

}

|

||||

} else {

|

||||

return nodeName

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

再结合上面排查过程得出的结论,我们可以再进一步缩小问题范围:nodeTree(调度器内部cache)到`snapshot.nodeInfoList`的同步过程丢失了某个节点信息。

|

||||

|

||||

### nodeTree数据结构

|

||||

|

||||

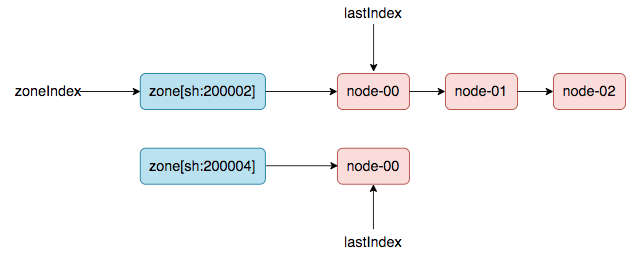

(方便理解,本文使用了链表来展示)

|

||||

|

||||

|

||||

|

||||

### 重现问题,定位根因

|

||||

|

||||

创建k8s集群时,会先加入master node,然后再加入worker node(意思是worker node时间上会晚于master node加入集群的时间)。

|

||||

|

||||

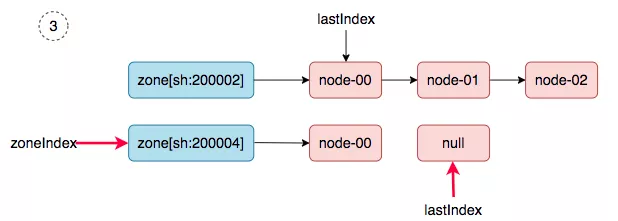

第一轮同步:3台master node创建好,然后发生pod调度(比如,cni 插件,以daemonset的方式部署在集群中),会触发一次nodeTree(调度器内部cache)到`snapshot.nodeInfoList`的同步。同步之后,nodeTree的两个游标就变成了如下结果:

|

||||

|

||||

`nodeTree.zoneIndex = 1, nodeTree.nodeArray[sh:200002].lastIndex = 3,`

|

||||

|

||||

第二轮同步:当worker node加入集群中后,然后新建一个daemonset,就会触发第二轮的同步(nodeTree(调度器内部cache)到`snapshot.nodeInfoList`的同步)。

|

||||

|

||||

同步过程如下:

|

||||

|

||||

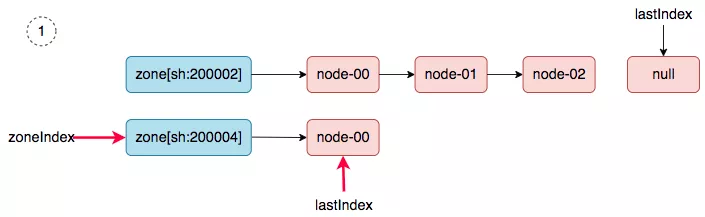

1. zoneIndex=1, nodeArray[sh:200004].lastIndex=0, we get worker-node-01.

|

||||

|

||||

|

||||

|

||||

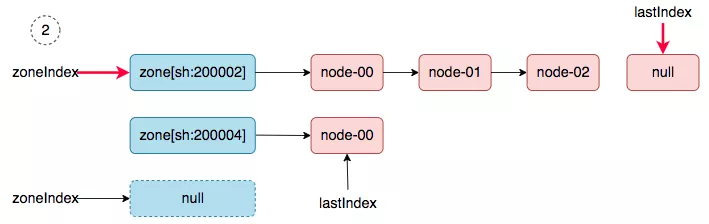

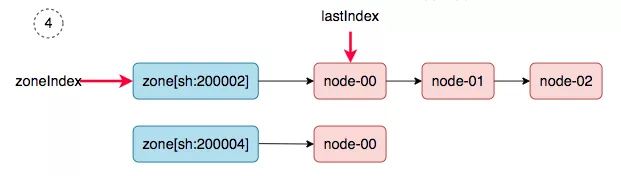

2. zoneIndex=2 >= len(zones); zoneIndex=0, nodeArray[sh:200002].lastIndex=3, return.

|

||||

|

||||

|

||||

|

||||

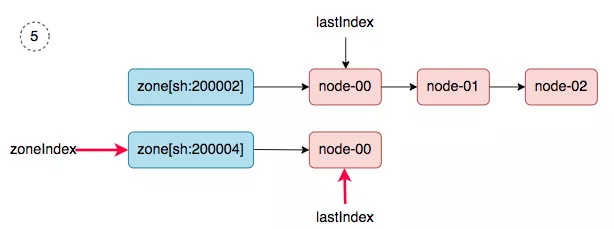

3. zoneIndex=1, nodeArray[sh:200004].lastIndex=1, return.

|

||||

|

||||

|

||||

|

||||

4. zoneIndex=0, nodeArray[sh:200002].lastIndex=0, we get master-01.

|

||||

|

||||

|

||||

|

||||

5. zoneIndex=1, nodeArray[sh:200004].lastIndex=0, we get worker-node-01.

|

||||

|

||||

|

||||

|

||||

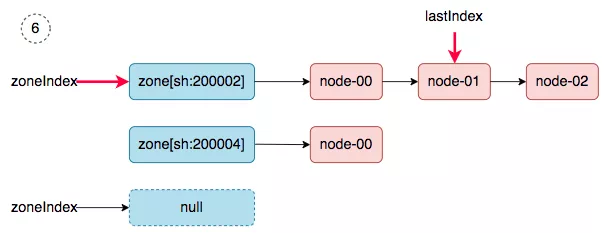

6. zoneIndex=2 >= len(zones); zoneIndex=0, nodeArray[sh:200002].lastIndex=1, we get master-02.

|

||||

|

||||

|

||||

|

||||

同步完成之后,调度器的`snapshot.nodeInfoList`得到如下的结果:

|

||||

|

||||

```json

|

||||

[

|

||||

worker-node-01,

|

||||

master-01,

|

||||

worker-node-01,

|

||||

master-02,

|

||||

]

|

||||

```

|

||||

|

||||

master-03去哪了?在第二轮同步的过程中丢了。

|

||||

|

||||

## 解决方案

|

||||

|

||||

从`问题根因`的分析中,可以看出,导致问题发生的原因,在于nodeTree数据结构中的游标zoneIndex 和 lastIndex(zone级别)值被保留了,所以,解决的方案就是在每次同步SYNC时,强制重置游标(归0)。

|

||||

|

||||

## 参考资料

|

||||

|

||||

* [相关 issue](https://github.com/kubernetes/kubernetes/issues/97120)

|

||||

* [相关pr (k8s v1.18)](https://github.com/kubernetes/kubernetes/pull/93387)

|

||||

* [TKE 修复版本 v1.18.4-tke.5](https://cloud.tencent.com/document/product/457/9315#tke-kubernetes-1.18.4-revisions)

|

||||

|

|

@ -1,40 +0,0 @@

|

|||

# 容器磁盘满导致 CPU 飙高

|

||||

|

||||

## 问题描述

|

||||

|

||||

某服务的其中两个副本异常,CPU 飙高。

|

||||

|

||||

## 排查

|

||||

|

||||

1. 查看 `container_cpu_usage_seconds_total` 监控,CPU 飙升,逼近 limit。

|

||||

2. 查看 `container_cpu_cfs_throttled_periods_total` 监控,CPU 飙升伴随 CPU Throttle 飙升,所以服务异常应该是 CPU 被限流导致。

|

||||

3. 查看 `container_cpu_system_seconds_total` 监控,发现 CPU 飙升主要是 CPU system 占用导致,容器内 `pidstat -u -t 5 1` 可以看到进程 `%system` 占用分布情况。

|

||||

4. `perf top` 看 system 占用高主要是 `vfs_write` 写数据导致。

|

||||

|

||||

|

||||

|

||||

5. `iostat -xhd 2` 看 IO 并不高,磁盘利用率也不高,io wait 也不高。

|

||||

6. `sync_inodes_sb` 看起来是写数据时触发了磁盘同步的耗时逻辑

|

||||

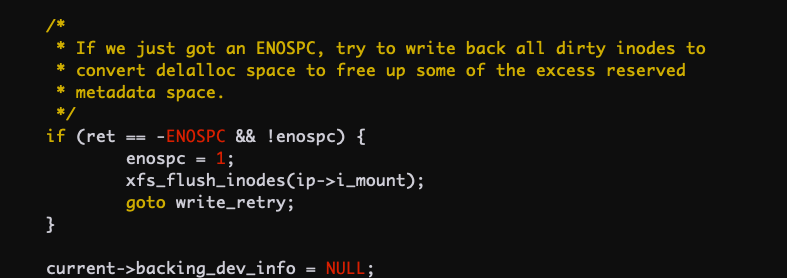

7. 深入看内核代码,当磁盘满的时候会调用 flush 刷磁盘所有数据,这个会一直在内核态运行很久,相当于对这个文件系统做 sync。

|

||||

|

||||

|

||||

|

||||

8. 节点上 `df -h` 看并没有磁盘满。

|

||||

9. 容器内 `df -h` 看根目录空间满了.

|

||||

|

||||

|

||||

|

||||

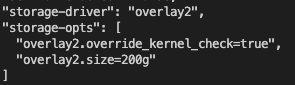

10. 看到 docker `daemon.json` 配置,限制了容器内 rootfs 最大只能占用 200G

|

||||

|

||||

|

||||

|

||||

11. 容器内一级级的 `du -sh *` 排查发现主要是一个 `nohup.log` 文件占满了磁盘。

|

||||

|

||||

|

||||

## 结论

|

||||

|

||||

容器内空间满了继续写数据会导致内核不断刷盘对文件系统同步,会导致内核态 CPU 占用升高,设置了 cpu limit 通常会被 throttle,导致服务处理慢,影响业务。

|

||||

|

||||

## 建议

|

||||

|

||||

对日志进行轮转,或直接打到标准输出,避免写满容器磁盘。

|

||||

|

|

@ -1,17 +0,0 @@

|

|||

# ARP 爆满导致健康检查失败

|

||||

|

||||

## 案例

|

||||

|

||||

一用户某集群节点数 1200+,用户监控方案是 daemonset 部署 node-exporter 暴露节点监控指标,使用 hostNework 方式,statefulset 部署 promethues 且仅有一个实例,落在了一个节点上,promethues 请求所有节点 node-exporter 获取节点监控指标,也就是或扫描所有节点,导致 arp cache 需要存所有 node 的记录,而节点数 1200+,大于了 `net.ipv4.neigh.default.gc_thresh3` 的默认值 1024,这个值是个硬限制,arp cache记录数大于这个就会强制触发 gc,所以会造成频繁gc,当有数据包发送会查本地 arp,如果本地没找到 arp 记录就会判断当前 arp cache 记录数+1是否大于 gc_thresh3,如果没有就会广播 arp 查询 mac 地址,如果大于了就直接报 `arp_cache: neighbor table overflow!`,并且放弃 arp 请求,无法获取 mac 地址也就无法知道探测报文该往哪儿发(即便就在本机某个 veth pair),kubelet 对本机 pod 做存活检查发 arp 查 mac 地址,在 arp cahce 找不到,由于这时 arp cache已经满了,刚要 gc 但还没做所以就只有报错丢包,导致存活检查失败重启 pod。

|

||||

|

||||

## 解决方案

|

||||

|

||||

调整部分节点内核参数,将 arp cache 的 gc 阀值调高 (`/etc/sysctl.conf`):

|

||||

|

||||

``` bash

|

||||

net.ipv4.neigh.default.gc_thresh1 = 80000

|

||||

net.ipv4.neigh.default.gc_thresh2 = 90000

|

||||

net.ipv4.neigh.default.gc_thresh3 = 100000

|

||||

```

|

||||

|

||||

并给 node 打下 label,修改 pod spec,加下 nodeSelector 或者 nodeAffnity,让 pod 只调度到这部分改过内核参数的节点,更多请参考本书 [节点排障: ARP 表爆满](../../troubleshooting/node/arp-cache-overflow)

|

||||

|

|

@ -1,58 +0,0 @@

|

|||

# tcp_tw_recycle 导致跨 VPC 访问 NodePort 超时

|

||||

|

||||

## 现象

|

||||

|

||||

从 VPC a 访问 VPC b 的 TKE 集群的某个节点的 NodePort,有时候正常,有时候会卡住直到超时。

|

||||

|

||||

## 排查

|

||||

|

||||

原因怎么查?

|

||||

|

||||

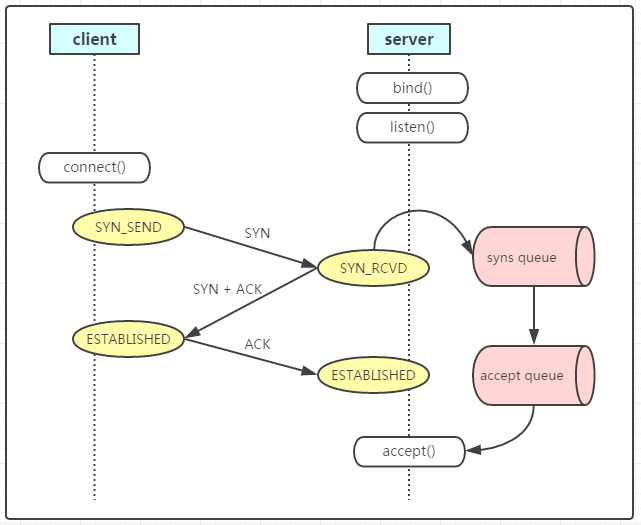

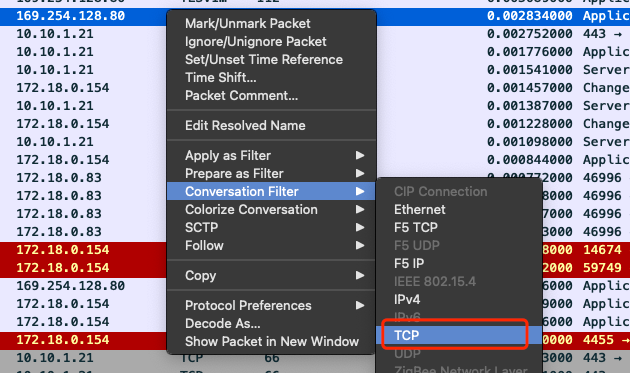

当然是先抓包看看啦,抓 server 端 NodePort 的包,发现异常时 server 能收到 SYN,但没响应 ACK:

|

||||

|

||||

|

||||

|

||||

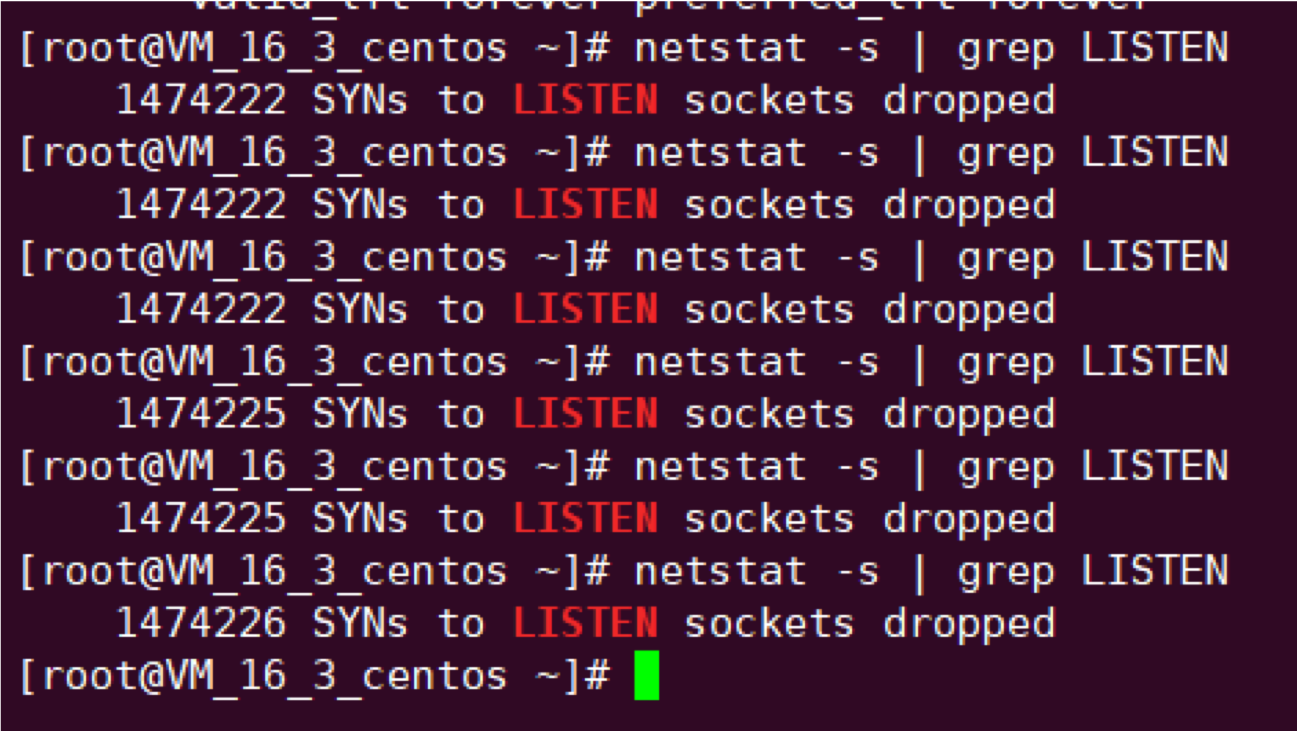

反复执行 `netstat -s | grep LISTEN` 发现 SYN 被丢弃数量不断增加:

|

||||

|

||||

|

||||

|

||||

分析:

|

||||

|

||||

- 两个VPC之间使用对等连接打通的,CVM 之间通信应该就跟在一个内网一样可以互通。

|

||||

- 为什么同一 VPC 下访问没问题,跨 VPC 有问题? 两者访问的区别是什么?

|

||||

|

||||

再仔细看下 client 所在环境,发现 client 是 VPC a 的 TKE 集群节点,捋一下:

|

||||

|

||||

- client 在 VPC a 的 TKE 集群的节点

|

||||

- server 在 VPC b 的 TKE 集群的节点

|

||||

|

||||

因为 TKE 集群中有个叫 `ip-masq-agent` 的 daemonset,它会给 node 写 iptables 规则,默认 SNAT 目的 IP 是 VPC 之外的报文,所以 client 访问 server 会做 SNAT,也就是这里跨 VPC 相比同 VPC 访问 NodePort 多了一次 SNAT,如果是因为多了一次 SNAT 导致的这个问题,直觉告诉我这个应该跟内核参数有关,因为是 server 收到包没回包,所以应该是 server 所在 node 的内核参数问题,对比这个 node 和 普通 TKE node 的默认内核参数,发现这个 node `net.ipv4.tcp_tw_recycle = 1`,这个参数默认是关闭的,跟用户沟通后发现这个内核参数确实在做压测的时候调整过。

|

||||

|

||||

## tcp_tw_recycle 的坑

|

||||

|

||||

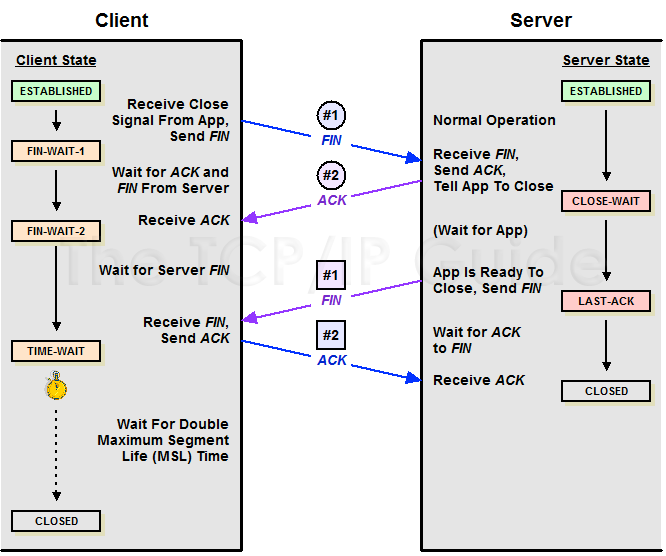

解释一下,TCP 主动关闭连接的一方在发送最后一个 ACK 会进入 `TIME_AWAIT` 状态,再等待 2 个 MSL 时间后才会关闭(因为如果 server 没收到 client 第四次挥手确认报文,server 会重发第三次挥手 FIN 报文,所以 client 需要停留 2 MSL的时长来处理可能会重复收到的报文段;同时等待 2 MSL 也可以让由于网络不通畅产生的滞留报文失效,避免新建立的连接收到之前旧连接的报文),了解更详细的过程请参考 TCP 四次挥手。

|

||||

|

||||

参数 `tcp_tw_recycle` 用于快速回收 `TIME_AWAIT` 连接,通常在增加连接并发能力的场景会开启,比如发起大量短连接,快速回收可避免 `tw_buckets` 资源耗尽导致无法建立新连接 (`time wait bucket table overflow`)

|

||||

|

||||

查得 `tcp_tw_recycle` 有个坑,在 RFC1323 有段描述:

|

||||

|

||||

`

|

||||

An additional mechanism could be added to the TCP, a per-host cache of the last timestamp received from any connection. This value could then be used in the PAWS mechanism to reject old duplicate segments from earlier incarnations of the connection, if the timestamp clock can be guaranteed to have ticked at least once since the old connection was open. This would require that the TIME-WAIT delay plus the RTT together must be at least one tick of the sender’s timestamp clock. Such an extension is not part of the proposal of this RFC.

|

||||

`

|

||||

|

||||

大概意思是说 TCP 有一种行为,可以缓存每个连接最新的时间戳,后续请求中如果时间戳小于缓存的时间戳,即视为无效,相应的数据包会被丢弃。

|

||||

|

||||

Linux 是否启用这种行为取决于 `tcp_timestamps` 和 `tcp_tw_recycle`,因为 `tcp_timestamps` 缺省开启,所以当 `tcp_tw_recycle` 被开启后,实际上这种行为就被激活了,当客户端或服务端以 `NAT` 方式构建的时候就可能出现问题。

|

||||

|

||||

当多个客户端通过 NAT 方式联网并与服务端交互时,服务端看到的是同一个 IP,也就是说对服务端而言这些客户端实际上等同于一个,可惜由于这些客户端的时间戳可能存在差异,于是乎从服务端的视角看,便可能出现时间戳错乱的现象,进而直接导致时间戳小的数据包被丢弃。如果发生了此类问题,具体的表现通常是是客户端明明发送的 SYN,但服务端就是不响应 ACK。

|

||||

|

||||

## 真相大白

|

||||

|

||||

回到我们的问题上,client 所在节点上可能也会有其它 pod 访问到 server 所在节点,而它们都被 SNAT 成了 client 所在节点的 NODE IP,但时间戳存在差异,server 就会看到时间戳错乱,因为开启了 `tcp_tw_recycle` 和 `tcp_timestamps` 激活了上述行为,就丢掉了比缓存时间戳小的报文,导致部分 SYN 被丢弃,这也解释了为什么之前我们抓包发现异常时 server 收到了 SYN,但没有响应 ACK,进而说明为什么 client 的请求部分会卡住直到超时。

|

||||

|

||||

由于 `tcp_tw_recycle` 坑太多,在内核 4.12 之后已移除: [remove tcp_tw_recycle](https://github.com/torvalds/linux/commit/4396e46187ca5070219b81773c4e65088dac50cc)

|

||||

|

||||

## 解决方案

|

||||

|

||||

1. 关闭 tcp_tw_recycle。

|

||||

2. 升级内核,启用 `net.ipv4.tcp_tw_reuse`。

|

||||

|

|

@ -1,191 +0,0 @@

|

|||

# DNS 5 秒延时

|

||||

|

||||

## 现象

|

||||

|

||||

用户反馈从 pod 中访问服务时,总是有些请求的响应时延会达到5秒。正常的响应只需要毫秒级别的时延。

|

||||

|

||||

## 抓包

|

||||

|

||||

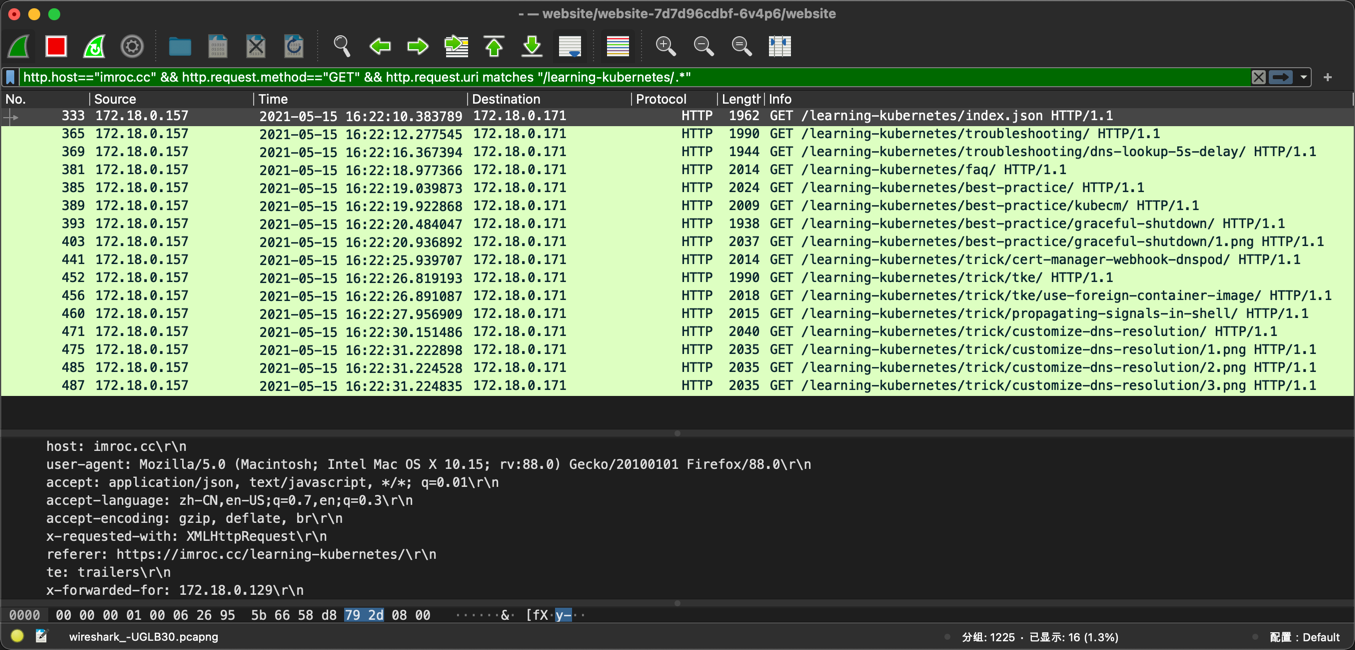

* [使用 nsenter 进入 netns](../../troubleshooting/skill/enter-netns-with-nsenter),然后使用节点上的 tcpdump 抓 pod 中的包,发现是有的 DNS 请求没有收到响应,超时 5 秒后,再次发送 DNS 请求才成功收到响应。

|

||||

* 在 kube-dns pod 抓包,发现是有 DNS 请求没有到达 kube-dns pod,在中途被丢弃了。

|

||||

|

||||

为什么是 5 秒? `man resolv.conf` 可以看到 glibc 的 resolver 的缺省超时时间是 5s:

|

||||

|

||||

```txt

|

||||

timeout:n

|

||||

Sets the amount of time the resolver will wait for a response from a remote name server before retrying the query via a different name server. Measured in seconds, the default is RES_TIMEOUT (currently 5, see

|

||||

<resolv.h>). The value for this option is silently capped to 30.

|

||||

```

|

||||

|

||||

## 丢包原因

|

||||

|

||||

经过搜索发现这是一个普遍问题。

|

||||

|

||||

根本原因是内核 conntrack 模块的 bug,netfilter 做 NAT 时可能发生资源竞争导致部分报文丢弃。

|

||||

|

||||

Weave works 的工程师 `Martynas Pumputis` 对这个问题做了很详细的分析:[Racy conntrack and DNS lookup timeouts](https://www.weave.works/blog/racy-conntrack-and-dns-lookup-timeouts)

|

||||

|

||||

相关结论:

|

||||

|

||||

* 只有多个线程或进程,并发从同一个 socket 发送相同五元组的 UDP 报文时,才有一定概率会发生

|

||||

* glibc, musl\(alpine linux的libc库\)都使用 "parallel query", 就是并发发出多个查询请求,因此很容易碰到这样的冲突,造成查询请求被丢弃

|

||||

* 由于 ipvs 也使用了 conntrack, 使用 kube-proxy 的 ipvs 模式,并不能避免这个问题

|

||||

|

||||

## 问题的根本解决

|

||||

|

||||

Martynas 向内核提交了两个 patch 来 fix 这个问题,不过他说如果集群中有多个DNS server的情况下,问题并没有完全解决。

|

||||

|

||||

其中一个 patch 已经在 2018-7-18 被合并到 linux 内核主线中: [netfilter: nf\_conntrack: resolve clash for matching conntracks](https://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git/commit/?id=ed07d9a021df6da53456663a76999189badc432a)

|

||||

|

||||

目前只有4.19.rc 版本包含这个patch。

|

||||

|

||||

## 规避办法

|

||||

|

||||

### 规避方案一:使用TCP发送DNS请求

|

||||

|

||||

由于TCP没有这个问题,有人提出可以在容器的resolv.conf中增加`options use-vc`, 强制glibc使用TCP协议发送DNS query。下面是这个man resolv.conf中关于这个选项的说明:

|

||||

|

||||

```text

|

||||

use-vc (since glibc 2.14)

|

||||

Sets RES_USEVC in _res.options. This option forces the

|

||||

use of TCP for DNS resolutions.

|

||||

```

|

||||

|

||||

笔者使用镜像"busybox:1.29.3-glibc" \(libc 2.24\) 做了试验,并没有见到这样的效果,容器仍然是通过UDP发送DNS请求。

|

||||

|

||||

### 规避方案二:避免相同五元组DNS请求的并发

|

||||

|

||||

resolv.conf还有另外两个相关的参数:

|

||||

|

||||

* single-request-reopen \(since glibc 2.9\)

|

||||

* single-request \(since glibc 2.10\)

|

||||

|

||||

man resolv.conf中解释如下:

|

||||

|

||||

```text

|

||||

single-request-reopen (since glibc 2.9)

|

||||

Sets RES_SNGLKUPREOP in _res.options. The resolver

|

||||

uses the same socket for the A and AAAA requests. Some

|

||||

hardware mistakenly sends back only one reply. When

|

||||

that happens the client system will sit and wait for

|

||||

the second reply. Turning this option on changes this

|

||||

behavior so that if two requests from the same port are

|

||||

not handled correctly it will close the socket and open

|

||||

a new one before sending the second request.

|

||||

|

||||

single-request (since glibc 2.10)

|

||||

Sets RES_SNGLKUP in _res.options. By default, glibc

|

||||

performs IPv4 and IPv6 lookups in parallel since

|

||||

version 2.9. Some appliance DNS servers cannot handle

|

||||

these queries properly and make the requests time out.

|

||||

This option disables the behavior and makes glibc

|

||||

perform the IPv6 and IPv4 requests sequentially (at the

|

||||

cost of some slowdown of the resolving process).

|

||||

```

|

||||

|

||||

用自己的话解释下:

|

||||

|

||||

* `single-request-reopen`: 发送 A 类型请求和 AAAA 类型请求使用不同的源端口,这样两个请求在 conntrack 表中不占用同一个表项,从而避免冲突

|

||||

* `single-request`: 避免并发,改为串行发送 A 类型和 AAAA 类型请求,没有了并发,从而也避免了冲突

|

||||

|

||||

要给容器的 `resolv.conf` 加上 options 参数,有几个办法:

|

||||

|

||||

1. 在容器的 "ENTRYPOINT" 或者 "CMD" 脚本中,执行 /bin/echo 'options single-request-reopen' >> /etc/resolv.conf**

|

||||

|

||||

2. 在 pod 的 postStart hook 中:

|

||||

|

||||

```yaml

|

||||

lifecycle:

|

||||

postStart:

|

||||

exec:

|

||||

command:

|

||||

- /bin/sh

|

||||

- -c

|

||||

- "/bin/echo 'options single-request-reopen' >> /etc/resolv.conf"

|

||||

```

|

||||

|

||||

3. 使用 template.spec.dnsConfig (k8s v1.9 及以上才支持):

|

||||

|

||||

```yaml

|

||||

template:

|

||||

spec:

|

||||

dnsConfig:

|

||||

options:

|

||||

- name: single-request-reopen

|

||||

```

|

||||

|

||||

4. 使用 ConfigMap 覆盖 pod 里面的 /etc/resolv.conf:

|

||||

|

||||

configmap:

|

||||

|

||||

```yaml

|

||||

apiVersion: v1

|

||||

data:

|

||||

resolv.conf: |

|

||||

nameserver 1.2.3.4

|

||||

search default.svc.cluster.local svc.cluster.local cluster.local ec2.internal

|

||||

options ndots:5 single-request-reopen timeout:1

|

||||

kind: ConfigMap

|

||||

metadata:

|

||||

name: resolvconf

|

||||

```

|

||||

|

||||

pod spec:

|

||||

|

||||

```yaml

|

||||

volumeMounts:

|

||||

- name: resolv-conf

|

||||

mountPath: /etc/resolv.conf

|

||||

subPath: resolv.conf

|

||||

...

|

||||

|

||||

volumes:

|

||||

- name: resolv-conf

|

||||

configMap:

|

||||

name: resolvconf

|

||||

items:

|

||||

- key: resolv.conf

|

||||

path: resolv.conf

|

||||

```

|

||||

|

||||

5. 使用 MutatingAdmissionWebhook

|

||||

|

||||

[MutatingAdmissionWebhook](https://kubernetes.io/docs/reference/access-authn-authz/admission-controllers/#mutatingadmissionwebhook-beta-in-1-9) 是 1.9 引入的 Controller,用于对一个指定的 Resource 的操作之前,对这个 resource 进行变更。 istio 的自动 sidecar注入就是用这个功能来实现的。 我们也可以通过 MutatingAdmissionWebhook,来自动给所有POD,注入以上3\)或者4\)所需要的相关内容。

|

||||

|

||||

以上方法中, 1 和 2 都需要修改镜像, 3 和 4 则只需要修改 pod 的 spec, 能适用于所有镜像。不过还是有不方便的地方:

|

||||

|

||||

* 每个工作负载的yaml都要做修改,比较麻烦

|

||||

* 对于通过helm创建的工作负载,需要修改helm charts

|

||||

|

||||

方法5\)对集群使用者最省事,照常提交工作负载即可。不过初期需要一定的开发工作量。

|

||||

|

||||

### 最佳实践:使用 LocalDNS

|

||||

|

||||

容器的DNS请求都发往本地的DNS缓存服务 (dnsmasq, nscd 等),不需要走DNAT,也不会发生conntrack冲突。另外还有个好处,就是避免DNS服务成为性能瓶颈。

|

||||

|

||||

使用 LocalDNS 缓存有两种方式:

|

||||

|

||||

* 每个容器自带一个DNS缓存服务

|

||||

* 每个节点运行一个DNS缓存服务,所有容器都把本节点的DNS缓存作为自己的 nameserver

|

||||

|

||||

从资源效率的角度来考虑的话,推荐后一种方式。官方也意识到了这个问题比较常见,给出了 coredns 以 cache 模式作为 daemonset 部署的解决方案: [https://kubernetes.io/docs/tasks/administer-cluster/nodelocaldns/](https://kubernetes.io/docs/tasks/administer-cluster/nodelocaldns/)

|

||||

|

||||

### 实施办法

|

||||

|

||||

条条大路通罗马,不管怎么做,最终到达上面描述的效果即可。

|

||||

|

||||

POD中要访问节点上的DNS缓存服务,可以使用节点的IP。 如果节点上的容器都连在一个虚拟bridge上, 也可以使用这个bridge的三层接口的IP(在TKE中,这个三层接口叫cbr0)。 要确保DNS缓存服务监听这个地址。

|

||||

|

||||

如何把 POD 的 /etc/resolv.conf 中的 nameserver 设置为节点IP呢?

|

||||

|

||||

一个办法,是设置 POD.spec.dnsPolicy 为 "Default", 意思是POD里面的 /etc/resolv.conf, 使用节点上的文件。缺省使用节点上的 /etc/resolv.conf (如果kubelet通过参数--resolv-conf指定了其他文件,则使用--resolv-conf所指定的文件)。

|

||||

|

||||

另一个办法,是给每个节点的kubelet指定不同的--cluster-dns参数,设置为节点的IP,POD.spec.dnsPolicy仍然使用缺省值"ClusterFirst"。 kops项目甚至有个issue在讨论如何在部署集群时设置好--cluster-dns指向节点IP: [https://github.com/kubernetes/kops/issues/5584](https://github.com/kubernetes/kops/issues/5584)

|

||||

|

||||

## 参考资料

|

||||

|

||||

* [Racy conntrack and DNS lookup timeouts](https://www.weave.works/blog/racy-conntrack-and-dns-lookup-timeouts)

|

||||

* [5 – 15s DNS lookups on Kubernetes?](https://blog.quentin-machu.fr/2018/06/24/5-15s-dns-lookups-on-kubernetes/)

|

||||

* [DNS intermittent delays of 5s](https://github.com/kubernetes/kubernetes/issues/56903)

|

||||

* [记一次Docker/Kubernetes上无法解释的连接超时原因探寻之旅](https://mp.weixin.qq.com/s/VYBs8iqf0HsNg9WAxktzYQ)

|

||||

|

||||

|

|

@ -1,95 +0,0 @@

|

|||

# dns id 冲突导致解析异常

|

||||

|

||||

## 现象

|

||||

|

||||

有个用户反馈域名解析有时有问题,看报错是解析超时。

|

||||

|

||||

## 排查

|

||||

|

||||

第一反应当然是看 coredns 的 log:

|

||||

|

||||

``` bash

|

||||

[ERROR] 2 loginspub.xxxxmobile-inc.net.

|

||||

A: unreachable backend: read udp 172.16.0.230:43742->10.225.30.181:53: i/o timeout

|

||||

```

|

||||

|

||||

这是上游 DNS 解析异常了,因为解析外部域名 coredns 默认会请求上游 DNS 来查询,这里的上游 DNS 默认是 coredns pod 所在宿主机的 `resolv.conf` 里面的 nameserver (coredns pod 的 dnsPolicy 为 "Default",也就是会将宿主机里的 `resolv.conf` 里的 nameserver 加到容器里的 `resolv.conf`, coredns 默认配置 `proxy . /etc/resolv.conf`, 意思是非 service 域名会使用 coredns 容器中 `resolv.conf` 文件里的 nameserver 来解析)

|

||||

|

||||

确认了下,超时的上游 DNS 10.225.30.181,并不是期望的 nameserver,VPC 默认 DNS 应该是 180 开头的。看了 coredns 所在节点的 `resolv.conf`,发现确实多出了这个非期望的 nameserver,跟用户确认了下,这个 DNS 不是用户自己加上去的,添加节点时这个 nameserver 本身就在 `resolv.conf` 中。

|

||||

|

||||

根据内部同学反馈, 10.225.30.181 是广州一台年久失修将被撤裁的 DNS,物理网络,没有 VIP,撤掉就没有了,所以如果 coredns 用到了这台 DNS 解析时就可能 timeout。后面我们自己测试,某些 VPC 的集群确实会有这个 nameserver,奇了怪了,哪里冒出来的?

|

||||

|

||||

又试了下直接创建 CVM,不加进 TKE 节点发现没有这个 nameserver,只要一加进 TKE 节点就有了 !!!

|

||||

|

||||

看起来是 TKE 的问题,将 CVM 添加到 TKE 集群会自动重装系统,初始化并加进集群成为 K8S 的 node,确认了初始化过程并不会写 `resolv.conf`,会不会是 TKE 的 OS 镜像问题?尝试搜一下除了 `/etc/resolv.conf` 之外哪里还有这个 nameserver 的 IP,最后发现 `/etc/resolvconf/resolv.conf.d/base` 这里面有。

|

||||

|

||||

看下 `/etc/resolvconf/resolv.conf.d/base` 的作用:Ubuntu 的 `/etc/resolv.conf` 是动态生成的,每次重启都会将 `/etc/resolvconf/resolv.conf.d/base` 里面的内容加到 `/etc/resolv.conf` 里。

|

||||

|

||||

经确认: 这个文件确实是 TKE 的 Ubuntu OS 镜像里自带的,可能发布 OS 镜像时不小心加进去的。

|

||||

|

||||

那为什么有些 VPC 的集群的节点 `/etc/resolv.conf` 里面没那个 IP 呢?它们的 OS 镜像里也都有那个文件那个 IP 呀。

|

||||

|

||||

请教其它部门同学发现:

|

||||

|

||||

- 非 dhcp 子机,cvm 的 cloud-init 会覆盖 `/etc/resolv.conf` 来设置 dns

|

||||

- dhcp 子机,cloud-init 不会设置,而是通过 dhcp 动态下发

|

||||

- 2018 年 4 月 之后创建的 VPC 就都是 dhcp 类型了的,比较新的 VPC 都是 dhcp 类型的

|

||||

|

||||

## 真相大白

|

||||

|

||||

`/etc/resolv.conf` 一开始内容都包含 `/etc/resolvconf/resolv.conf.d/base` 的内容,也就是都有那个不期望的 nameserver,但老的 VPC 由于不是 dhcp 类型,所以 cloud-init 会覆盖 `/etc/resolv.conf`,抹掉了不被期望的 nameserver,而新创建的 VPC 都是 dhcp 类型,cloud-init 不会覆盖 `/etc/resolv.conf`,导致不被期望的 nameserver 残留在了 `/etc/resolv.conf`,而 coredns pod 的 dnsPolicy 为 “Default”,也就是会将宿主机的 `/etc/resolv.conf` 中的 nameserver 加到容器里,coredns 解析集群外的域名默认使用这些 nameserver 来解析,当用到那个将被撤裁的 nameserver 就可能 timeout。

|

||||

|

||||

## 解决方案

|

||||

|

||||

临时解决: 删掉 `/etc/resolvconf/resolv.conf.d/base` 重启。

|

||||

长期解决: 我们重新制作 TKE Ubuntu OS 镜像然后发布更新。

|

||||

|

||||

## 再次出问题

|

||||

|

||||

这下应该没问题了吧,But, 用户反馈还是会偶尔解析有问题,但现象不一样了,这次并不是 dns timeout。

|

||||

|

||||

用脚本跑测试仔细分析现象:

|

||||

|

||||

- 请求 `loginspub.xxxxmobile-inc.net` 时,偶尔提示域名无法解析

|

||||

- 请求 `accounts.google.com` 时,偶尔提示连接失败

|

||||

|

||||

进入 dns 解析偶尔异常的容器的 netns 抓包:

|

||||

|

||||

- dns 请求会并发请求 A 和 AAAA 记录

|

||||

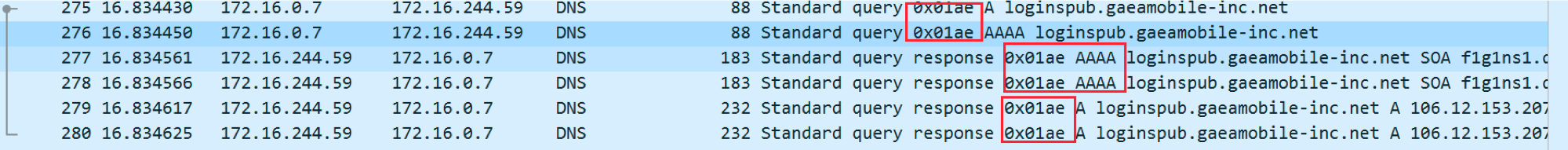

- 测试脚本发请求打印序号,抓包然后 wireshark 分析对比异常时请求序号偏移量,找到异常时的 dns 请求报文,发现异常时 A 和 AAAA 记录的请求 id 冲突,并且 AAAA 响应先返回

|

||||

|

||||

|

||||

|

||||

正常情况下id不会冲突,这里冲突了也就能解释这个 dns 解析异常的现象了:

|

||||

|

||||

- `loginspub.xxxxmobile-inc.net` 没有 AAAA (ipv6) 记录,它的响应先返回告知 client 不存在此记录,由于请求 id 跟 A 记录请求冲突,后面 A 记录响应返回了 client 发现 id 重复就忽略了,然后认为这个域名无法解析

|

||||

- `accounts.google.com` 有 AAAA 记录,响应先返回了,client 就拿这个记录去尝试请求,但当前容器环境不支持 ipv6,所以会连接失败

|

||||

|

||||

## 分析

|

||||

|

||||

那为什么 dns 请求 id 会冲突?

|

||||

|

||||

继续观察发现: 其它节点上的 pod 不会复现这个问题,有问题这个节点上也不是所有 pod 都有这个问题,只有基于 alpine 镜像的容器才有这个问题,在此节点新起一个测试的 `alpine:latest` 的容器也一样有这个问题。

|

||||

|

||||

为什么 alpine 镜像的容器在这个节点上有问题在其它节点上没问题? 为什么其他镜像的容器都没问题?它们跟 alpine 的区别是什么?

|

||||

|

||||

发现一点区别: alpine 使用的底层 c 库是 musl libc,其它镜像基本都是 glibc

|

||||

|

||||

翻 musl libc 源码, 构造 dns 请求时,请求 id 的生成没加锁,而且跟当前时间戳有关 (`network/res_mkquery.c`):

|

||||

|

||||

``` c

|

||||

/* Make a reasonably unpredictable id */

|

||||

clock_gettime(CLOCK_REALTIME, &ts);

|

||||

id = ts.tv_nsec + ts.tv_nsec/65536UL & 0xffff;

|

||||

```

|

||||

|

||||

看注释,作者应该认为这样id基本不会冲突,事实证明,绝大多数情况确实不会冲突,我在网上搜了很久没有搜到任何关于 musl libc 的 dns 请求 id 冲突的情况。这个看起来取决于硬件,可能在某种类型硬件的机器上运行,短时间内生成的 id 就可能冲突。我尝试跟用户在相同地域的集群,添加相同配置相同机型的节点,也复现了这个问题,但后来删除再添加时又不能复现了,看起来后面新建的 cvm 又跑在了另一种硬件的母机上了。

|

||||

|

||||

OK,能解释通了,再底层的细节就不清楚了,我们来看下解决方案:

|

||||

|

||||

- 换基础镜像 (不用alpine)

|

||||

- 完全静态编译业务程序(不依赖底层c库),比如go语言程序编译时可以关闭 cgo (CGO_ENABLED=0),并告诉链接器要静态链接 (`go build` 后面加 `-ldflags '-d'`),但这需要语言和编译工具支持才可以

|

||||

|

||||

## 最终解决方案

|

||||

|

||||

最终建议用户基础镜像换成另一个比较小的镜像: `debian:stretch-slim`。

|

||||

|

|

@ -1,102 +0,0 @@

|

|||

# cgroup 泄露

|

||||

|

||||

## 现象

|

||||

|

||||

创建 Pod 失败,运行时报错 `no space left on device`:

|

||||

|

||||

```txt

|

||||

Dec 24 11:54:31 VM_16_11_centos dockerd[11419]: time="2018-12-24T11:54:31.195900301+08:00" level=error msg="Handler for POST /v1.31/containers/b98d4aea818bf9d1d1aa84079e1688cd9b4218e008c58a8ef6d6c3c106403e7b/start returned error: OCI runtime create failed: container_linux.go:348: starting container process caused \"process_linux.go:279: applying cgroup configuration for process caused \\\"mkdir /sys/fs/cgroup/memory/kubepods/burstable/pod79fe803c-072f-11e9-90ca-525400090c71/b98d4aea818bf9d1d1aa84079e1688cd9b4218e008c58a8ef6d6c3c106403e7b: no space left on device\\\"\": unknown"

|

||||

```

|

||||

|

||||

## 内核 Bug

|

||||

|

||||

`memcg` 是 Linux 内核中用于管理 cgroup 内存的模块,整个生命周期应该是跟随 cgroup 的,但是在低版本内核中\(已知3.10\),一旦给某个 memory cgroup 开启 kmem accounting 中的 `memory.kmem.limit_in_bytes` 就可能会导致不能彻底删除 memcg 和对应的 cssid,也就是说应用即使已经删除了 cgroup \(`/sys/fs/cgroup/memory` 下对应的 cgroup 目录已经删除\), 但在内核中没有释放 cssid,导致内核认为的 cgroup 的数量实际数量不一致,我们也无法得知内核认为的 cgroup 数量是多少。

|

||||

|

||||

关于 cgroup kernel memory,在 [kernel.org](https://www.kernel.org/doc/html/latest/admin-guide/cgroup-v1/memory.html#kernel-memory-extension-config-memcg-kmem) 中有如下描述:

|

||||

|

||||

```

|

||||

2.7 Kernel Memory Extension (CONFIG_MEMCG_KMEM)

|

||||

-----------------------------------------------

|

||||

|

||||

With the Kernel memory extension, the Memory Controller is able to limit

|

||||

the amount of kernel memory used by the system. Kernel memory is fundamentally

|

||||

different than user memory, since it can't be swapped out, which makes it

|

||||

possible to DoS the system by consuming too much of this precious resource.

|

||||

|

||||

Kernel memory accounting is enabled for all memory cgroups by default. But

|

||||

it can be disabled system-wide by passing cgroup.memory=nokmem to the kernel

|

||||

at boot time. In this case, kernel memory will not be accounted at all.

|

||||

|

||||

Kernel memory limits are not imposed for the root cgroup. Usage for the root

|

||||

cgroup may or may not be accounted. The memory used is accumulated into

|

||||

memory.kmem.usage_in_bytes, or in a separate counter when it makes sense.

|

||||

(currently only for tcp).

|

||||

|

||||

The main "kmem" counter is fed into the main counter, so kmem charges will

|

||||

also be visible from the user counter.

|

||||

|

||||

Currently no soft limit is implemented for kernel memory. It is future work

|

||||

to trigger slab reclaim when those limits are reached.

|

||||

```

|

||||

|

||||

这是一个 cgroup memory 的扩展,用于限制对 kernel memory 的使用,但该特性在老于 4.0 版本中是个实验特性,存在泄露问题,在 4.x 较低的版本也还有泄露问题,应该是造成泄露的代码路径没有完全修复,推荐 4.3 以上的内核。

|

||||

|

||||

## 造成容器创建失败

|

||||

|

||||

这个问题可能会导致创建容器失败,因为创建容器为其需要创建 cgroup 来做隔离,而低版本内核有个限制:允许创建的 cgroup 最大数量写死为 65535 \([点我跳转到 commit](https://github.com/torvalds/linux/commit/38460b48d06440de46b34cb778bd6c4855030754#diff-c04090c51d3c6700c7128e84c58b1291R3384)\),如果节点上经常创建和销毁大量容器导致创建很多 cgroup,删除容器但没有彻底删除 cgroup 造成泄露\(真实数量我们无法得知\),到达 65535 后再创建容器就会报创建 cgroup 失败并报错 `no space left on device`,使用 kubernetes 最直观的感受就是 pod 创建之后无法启动成功。

|

||||

|

||||

pod 启动失败,报 event 示例:

|

||||

|

||||

``` bash

|

||||

Events:

|

||||

Type Reason Age From Message

|

||||

---- ------ ---- ---- -------

|

||||

Normal Scheduled 15m default-scheduler Successfully assigned jenkins/jenkins-7845b9b665-nrvks to 10.10.252.4

|

||||

Warning FailedCreatePodContainer 25s (x70 over 15m) kubelet, 10.10.252.4 unable to ensure pod container exists: failed to create container for [kubepods besteffort podc6eeec88-8664-11e9-9524-5254007057ba] : mkdir /sys/fs/cgroup/memory/kubepods/besteffort/podc6eeec88-8664-11e9-9524-5254007057ba: no space left on device

|

||||

```

|

||||

|

||||

dockerd 日志报错示例:

|

||||

|

||||

``` bash

|

||||

Dec 24 11:54:31 VM_16_11_centos dockerd[11419]: time="2018-12-24T11:54:31.195900301+08:00" level=error msg="Handler for POST /v1.31/containers/b98d4aea818bf9d1d1aa84079e1688cd9b4218e008c58a8ef6d6c3c106403e7b/start returned error: OCI runtime create failed: container_linux.go:348: starting container process caused \"process_linux.go:279: applying cgroup configuration for process caused \\\"mkdir /sys/fs/cgroup/memory/kubepods/burstable/pod79fe803c-072f-11e9-90ca-525400090c71/b98d4aea818bf9d1d1aa84079e1688cd9b4218e008c58a8ef6d6c3c106403e7b: no space left on device\\\"\": unknown"

|

||||

```

|

||||

|

||||

kubelet 日志报错示例:

|

||||

|

||||

``` bash

|

||||

Sep 09 18:09:09 VM-0-39-ubuntu kubelet[18902]: I0909 18:09:09.449722 18902 remote_runtime.go:92] RunPodSandbox from runtime service failed: rpc error: code = Unknown desc = failed to start sandbox container for pod "osp-xxx-com-ljqm19-54bf7678b8-bvz9s": Error response from daemon: oci runtime error: container_linux.go:247: starting container process caused "process_linux.go:258: applying cgroup configuration for process caused \"mkdir /sys/fs/cgroup/memory/kubepods/burstable/podf1bd9e87-1ef2-11e8-afd3-fa163ecf2dce/8710c146b3c8b52f5da62e222273703b1e3d54a6a6270a0ea7ce1b194f1b5053: no space left on device\""

|

||||

```

|

||||

|

||||

新版的内核限制为 `2^31` \(可以看成几乎不限制,[点我跳转到代码](https://github.com/torvalds/linux/blob/3120b9a6a3f7487f96af7bd634ec49c87ef712ab/kernel/cgroup/cgroup.c#L5233)\): `cgroup_idr_alloc()` 传入 end 为 0 到 `idr_alloc()`, 再传给 `idr_alloc_u32()`, end 的值最终被三元运算符 `end>0 ? end-1 : INT_MAX` 转成了 `INT_MAX` 常量,即 `2^31`。所以如果新版内核有泄露问题会更难定位,表现形式会是内存消耗严重,幸运的是新版内核已经修复,推荐 4.3 以上。

|

||||

|

||||

### 规避方案

|

||||

|

||||

如果你用的低版本内核\(比如 CentOS 7 v3.10 的内核\)并且不方便升级内核,可以通过不开启 kmem accounting 来实现规避,但会比较麻烦。

|

||||

|

||||

kubelet 和 runc 都会给 memory cgroup 开启 kmem accounting,所以要规避这个问题,就要保证kubelet 和 runc 都别开启 kmem accounting,下面分别进行说明:

|

||||

|

||||

#### runc

|

||||

|

||||

runc 在合并 [这个PR](https://github.com/opencontainers/runc/pull/1350/files) \(2017-02-27\) 之后创建的容器都默认开启了 kmem accounting,后来社区也注意到这个问题,并做了比较灵活的修复, [PR 1921](https://github.com/opencontainers/runc/pull/1921) 给 runc 增加了 "nokmem" 编译选项,缺省的 release 版本没有使用这个选项, 自己使用 nokmem 选项编译 runc 的方法:

|

||||

|

||||

``` bash

|

||||

cd $GO_PATH/src/github.com/opencontainers/runc/

|

||||

make BUILDTAGS="seccomp nokmem"

|

||||

```

|

||||

|

||||

docker-ce v18.09.1 之后的 runc 默认关闭了 kmem accounting,所以也可以直接升级 docker 到这个版本之后。

|

||||

|

||||

#### kubelet

|

||||

|

||||

如果是 1.14 版本及其以上,可以在编译的时候通过 build tag 来关闭 kmem accounting:

|

||||

|

||||

``` bash

|

||||

KUBE_GIT_VERSION=v1.14.1 ./build/run.sh make kubelet GOFLAGS="-tags=nokmem"

|

||||

```

|

||||

|

||||

如果是低版本需要修改代码重新编译。kubelet 在创建 pod 对应的 cgroup 目录时,也会调用 libcontianer 中的代码对 cgroup 做设置,在 `pkg/kubelet/cm/cgroup_manager_linux.go` 的 `Create` 方法中,会调用 `Manager.Apply` 方法,最终调用 `vendor/github.com/opencontainers/runc/libcontainer/cgroups/fs/memory.go` 中的 `MemoryGroup.Apply` 方法,开启 kmem accounting。这里也需要进行处理,可以将这部分代码注释掉然后重新编译 kubelet。

|

||||

|

||||

## 参考资料

|

||||

|

||||

* 一行 kubernetes 1.9 代码引发的血案(与 CentOS 7.x 内核兼容性问题): [http://dockone.io/article/4797](http://dockone.io/article/4797)

|

||||

* Cgroup泄漏--潜藏在你的集群中: [https://tencentcloudcontainerteam.github.io/2018/12/29/cgroup-leaking/](https://tencentcloudcontainerteam.github.io/2018/12/29/cgroup-leaking/)

|

||||

|

|

@ -1,130 +0,0 @@

|

|||

# .Net Core 配置文件无法热加载

|

||||

|

||||

## 问题描述

|

||||

|

||||

在使用 kubernetes 部署应用时, 我使用 `kubernetes` 的 `configmap` 来管理配置文件: `appsettings.json`

|

||||

, 修改configmap 的配置文件后, 我来到了容器里, 通过 `cat /app/config/appsetting.json` 命令查看容器是否已经加载了最新的配置文件, 很幸运的是, 通过命令行查看容器配置发现已经处于最新状态(修改configmap后10-15s 生效), 我尝试请求应用的API, 发现API 在执行过程中使用的配置是老旧的内容, 而不是最新的内容。在本地执行应用时并未出现配置无法热更新的问题。

|

||||

|

||||

```bash

|

||||

# 相关版本

|

||||

kubernetes 版本: 1.14.2

|

||||

# 要求版本大于等于 3.1

|

||||

.Net core: 3.1

|

||||

|

||||

# 容器 os-release (并非 windows)

|

||||

|

||||

NAME="Debian GNU/Linux"

|

||||

VERSION_ID="10"

|

||||

VERSION="10 (buster)"

|

||||

VERSION_CODENAME=buster

|

||||

ID=debian

|

||||

HOME_URL="https://www.debian.org/"

|

||||

SUPPORT_URL="https://www.debian.org/support"

|

||||

BUG_REPORT_URL="https://bugs.debian.org/"

|

||||

|

||||

# 基础镜像:

|

||||

mcr.microsoft.com/dotnet/core/sdk:3.1-buster

|

||||

mcr.microsoft.com/dotnet/core/aspnet:3.1-buster-slim

|

||||

```

|

||||

|

||||

## 问题猜想

|

||||

|

||||

通过命令行排查发现最新的 `configmap` 配置内容已经在容器的指定目录上更新到最新,但是应用仍然使用老旧的配置内容, 这意味着问题发生在: configmap->**容器->应用**, 容器和应用之间, 容器指定目录下的配置更新并没有触发 `.Net` 热加载机制, 那究竟是为什么没有触发配置热加载,需要深挖根本原因, 直觉猜想是: 查看 `.Net Core` 标准库的配置热加载的实现检查触发条件, 很有可能是触发的条件不满足导致应用配置无法重新加载。

|

||||

|

||||

## 问题排查

|

||||

|

||||

猜想方向是热更新的触发条件不满足, 我们熟知使用 `configmap` 挂载文件是使用[symlink](https://en.wikipedia.org/wiki/Symbolic_link)来挂载, 而非常用的物理文件系统, 在修改完 `configmap` , 容器重新加载配置后,这一过程并不会改变文件的修改时间等信息(从容器的角度看)。对此,我们做了一个实验,通过对比configmap修改前和修改后来观察配置( `appsettings.json` )在容器的属性变化(注: 均在容器加载最新配置后对比), 使用 `stat` 命令来佐证了这个细节点。

|

||||

|

||||

**Before:**

|

||||

|

||||

```bash

|

||||

root@app-785bc59df6-gdmnf:/app/Config# stat appsettings.json

|

||||

File: Config/appsettings.json -> ..data/appsettings.json

|

||||

Size: 35 Blocks: 0 IO Block: 4096 symbolic link

|

||||

Device: ca01h/51713d Inode: 27263079 Links: 1

|

||||

Access: (0777/lrwxrwxrwx) Uid: ( 0/ root) Gid: ( 0/ root)

|

||||

Access: 2020-04-25 08:21:18.490453316 +0000

|

||||

Modify: 2020-04-25 08:21:18.490453316 +0000

|

||||

Change: 2020-04-25 08:21:18.490453316 +0000

|

||||

Birth: -

|

||||

```

|

||||

|

||||

**After:**

|

||||

|

||||

```bash

|

||||

root@app-785bc59df6-gdmnf:/app/Config# stat appsettings.json

|

||||

File: appsettings.json -> ..data/appsettings.json

|

||||

Size: 35 Blocks: 0 IO Block: 4096 symbolic link

|

||||

Device: ca01h/51713d Inode: 27263079 Links: 1

|

||||

Access: (0777/lrwxrwxrwx) Uid: ( 0/ root) Gid: ( 0/ root)

|

||||

Access: 2020-04-25 08:21:18.490453316 +0000

|

||||

Modify: 2020-04-25 08:21:18.490453316 +0000

|

||||

Change: 2020-04-25 08:21:18.490453316 +0000

|

||||

Birth: -

|

||||

```

|

||||

|

||||

通过标准库源码发现, `.Net core` 配置热更新机制似乎是基于文件的最后修改日期来触发的, 根据上面的前后对比显而易见, `configmap` 的修改并没有让容器里的指定的文件的最后修改日期改变,也就未触发 `.Net` 应用配置的热加载。

|

||||

|

||||

## 解决办法

|

||||

|

||||

既然猜想基本得到证实, 由于不太熟悉这门语言, 我们尝试在网络上寻找解决办法,很幸运的是我们找到了找到了相关的内容, [fbeltrao](https://github.com/fbeltrao) 开源了一个第三方库([ConfigMapFileProvider](https://github.com/fbeltrao/ConfigMapFileProvider)) 来专门解决这个问题,**通过监听文件内容hash值的变化实现配置热加载**。

|

||||

于是, 我们在修改了项目的代码:

|

||||

|

||||

|

||||

**Before:**

|

||||

|

||||

```csharp

|

||||

// 配置被放在了/app/Config/ 目录下

|

||||

var configPath = Path.Combine(env.ContentRootPath, "Config");

|

||||

config.AddJsonFile(Path.Combine(configPath, "appsettings.json"),

|

||||

optional: false,

|

||||

reloadOnChange: true);

|

||||

```

|

||||

|

||||

**After:**

|

||||

|

||||

```csharp

|

||||

// 配置被放在了/app/Config/ 目录下

|

||||

config.AddJsonFile(ConfigMapFileProvider.FromRelativePath("Config"),

|

||||

"appsettings.json",

|

||||

optional: false,

|

||||

reloadOnChange: true);

|

||||

```

|

||||

|

||||

修改完项目的代码后, 重新构建镜像, 更新部署在 `kubernetes` 上的应用, 然后再次测试, 到此为止, 会出现两种状态:

|

||||

|

||||

1. 一种是你热加载配置完全可用, 非常值得祝贺, 你已经成功修复了这个bug;

|

||||

2. 一种是你的热加载配置功能还存在 bug, 比如: 上一次请求, 配置仍然使用的老旧配置内容, 下一次请求却使用了最新的配置内容,这个时候, 我们需要继续向下排查: `.NET Core` 引入了`Options`模式,使用类来表示相关的设置组,用强类型的类来表达配置项(白话大概表述为: 代码里面有个对象对应配置里的某个字段, 配置里对应的字段更改会触发代码里对象的属性变化), 示例如下:

|

||||

|

||||

**配置示例:**

|

||||

|

||||

```bash

|

||||

$ cat appsettings.json

|

||||

"JwtIssuerOptions": {

|

||||

"Issuer": "test",

|

||||

"Audience": "test",

|

||||

"SecretKey": "test"

|

||||

...

|

||||

}

|

||||

```

|

||||

|

||||

**代码示例:**

|

||||

|

||||

```csharp

|

||||

services.Configure<JwtIssuerOptions>(Configuration.GetSection("JwtIssuerOptions"));

|

||||

```

|

||||

|

||||

而 Options 模式分为三种:

|

||||

|

||||

1. `IOptions`: Singleton(单例),值一旦生成, 除非通过代码的方式更改,否则它的值不会更新

|

||||

2. `IOptionsMonitor`: Singleton(单例), 通过 `IOptionsChangeTokenSource` 能够和配置文件一起更新,也能通过代码的方式更改值

|

||||

3. `IOptionsSnapshot`: Scoped,配置文件更新的下一次访问,它的值会更新,但是它不能跨范围通过代码的方式更改值,只能在当前范围(请求)内有效。

|

||||

|

||||

在知道这三种模式的意义后,我们已经完全找到了问题的根因, 把 `Options` 模式设置为:`IOptionsMonitor`就能解决完全解决配置热加载的问题。

|

||||

|

||||

## 相关链接

|

||||

|

||||

1. [配置监听ConfigMapFileProvider](https://github.com/fbeltrao/ConfigMapFileProvider)

|

||||

2. [相似的Issue: 1175](https://github.com/dotnet/extensions/issues/1175)

|

||||

3. [官方Options 描述](https://docs.microsoft.com/en-us/aspnet/core/fundamentals/configuration/options?view=aspnetcore-3.1)

|

||||

4. [IOptions、IOptionsMonitor以及IOptionsSnapshot 测试](https://www.cnblogs.com/wenhx/p/ioptions-ioptionsmonitor-and-ioptionssnapshot.html)

|

||||

|

|

@ -1,54 +0,0 @@

|

|||

# 多容器场景下修改 hosts 失效

|

||||

|

||||

## 问题现象

|

||||

|

||||

业务容器启动的逻辑中,修改了 `/etc/hosts` 文件,当 Pod 只存在这一个业务容器时,文件可以修改成功,但存在多个时 (比如注入了 istio 的 sidecar),修改可能会失效。

|

||||

|

||||

## 分析

|

||||

|

||||

1. 容器中的 `/etc/hosts` 是由 kubelet 生成并挂载到 Pod 中所有容器,如果 Pod 有多个容器,它们挂载的 `/etc/hosts` 文件都对应宿主机上同一个文件,路径通常为 `/var/lib/kubelet/pods/<pod-uid>/etc-hosts`。

|

||||

> 如果是 docker 运行时,可以通过 `docker inspect <container-id> -f {{.HostsPath}}` 查看。

|

||||

|

||||

2. kubelet 在启动容器时,都会走如下的调用链(`makeMounts->makeHostsMount->ensureHostsFile`)来给容器挂载 `/etc/hosts`,而在 `ensureHostsFile` 函数中都会重新创建一个新的 `etc-hosts` 文件,导致在其他容器中对 `/etc/hosts` 文件做的任何修改都被还原了。

|

||||

|

||||

所以,当 Pod 中存在多个容器时,容器内修改 `/etc/hosts` 的操作可能会被覆盖回去。

|

||||

|

||||

## 解决方案

|

||||

|

||||

通常不推荐在容器内修改 `/etc/hosts`,应该采用更云原生的做法,参考 [自定义域名解析](../../best-practices/dns/customize-dns-resolution)。

|

||||

|

||||

### 使用 HostAliases

|

||||

|

||||

如果只是某一个 workload 需要 hosts,可以用 HostAliases:

|

||||

|

||||

```yaml

|

||||

apiVersion: apps/v1

|

||||

kind: Deployment

|

||||

metadata:

|

||||

name: host

|

||||

spec:

|

||||

replicas: 1

|

||||

selector:

|

||||

matchLabels:

|

||||

app: host

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

app: host

|

||||

spec:

|

||||

hostAliases: # 这下面定义 hosts

|

||||

- ip: "10.10.10.10"

|

||||

hostnames:

|

||||

- "mysql.example.com"

|

||||

containers:

|

||||

- name: nginx

|

||||

image: nginx:latest

|

||||

```

|

||||

|

||||

> 参考官方文档 [Adding entries to Pod /etc/hosts with HostAliases](https://kubernetes.io/docs/tasks/network/customize-hosts-file-for-pods/)。

|

||||

|

||||

### CoreDNS hosts

|

||||

|

||||

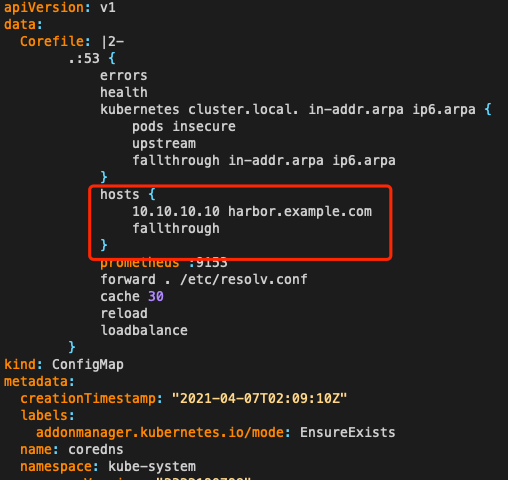

如果是多个 workload 都需要共同的 hosts,可以修改集群 CoreDNS 配置,在集群级别增加 hosts:

|

||||

|

||||

|

||||

|

|

@ -1,15 +0,0 @@

|

|||

# Job 无法被删除

|

||||

|

||||

## 原因

|

||||

|

||||

* 可能是 k8s 的一个bug: [https://github.com/kubernetes/kubernetes/issues/43168](https://github.com/kubernetes/kubernetes/issues/43168)

|

||||

* 本质上是脏数据问题,Running+Succeed != 期望Completions 数量,低版本 kubectl 不容忍,delete job 的时候打开debug(加-v=8),会看到kubectl不断在重试,直到达到timeout时间。新版kubectl会容忍这些,删除job时会删除关联的pod

|

||||

|

||||

## 解决方法

|

||||

|

||||

1. 升级 kubectl 版本,1.12 以上

|

||||

2. 低版本 kubectl 删除 job 时带 `--cascade=false` 参数\(如果job关联的pod没删完,加这个参数不会删除关联的pod\)

|

||||

|

||||

```bash

|

||||

kubectl delete job --cascade=false <job name>

|

||||

```

|

||||

|

|

@ -1,116 +0,0 @@

|

|||

# 系统时间被修改导致 sandbox 冲突

|

||||

|

||||

## 问题描述

|

||||

|

||||

节点重启后,节点上的存量 pod 出现无法正常 running,容器(sandbox)在不断重启的现象。

|

||||

|

||||

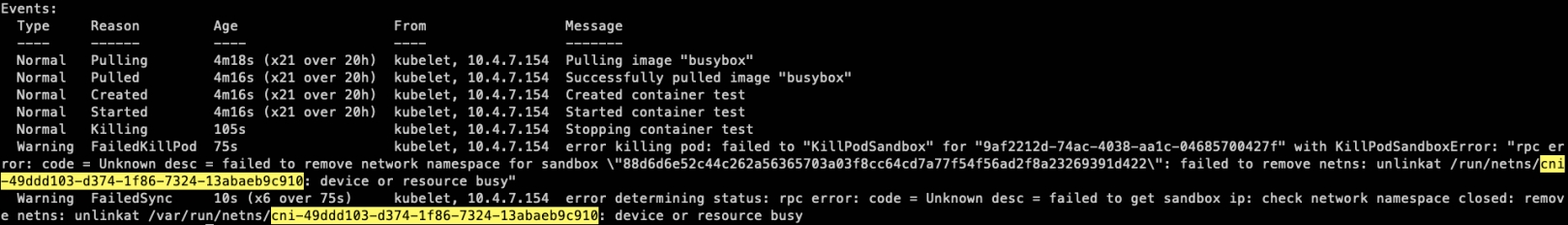

查看事件,提示是 sandbox 的 name 存在冲突 (`The container name xxx is already used by yyy`),具体事件如下:

|

||||

|

||||

|

||||

|

||||

## 结论先行

|

||||

|

||||

这个问题的根因是节点的时间问题,节点重启前的系统时间比节点重启后的系统时间提前,影响了 kubelet 内部缓存 cache 中的 sandbox 的排序,导致 kubelet 每次起了一个新 sandbox 之后,都只会拿到旧的 sandbox,导致了 sandbox 的不断创建和 name 冲突。

|

||||

|

||||

## 排查日志

|

||||

|

||||

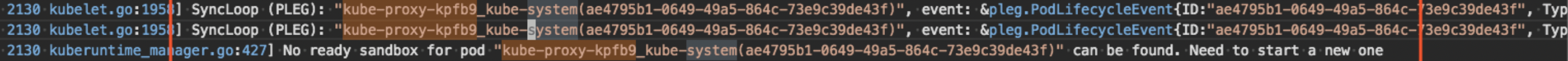

先来看下 kubelet 的日志,部分截图如下:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

截图上是同一个 pod(kube-proxy)最近的两次 podWorker 逻辑截图,都抛出了同一个提示:`No ready sandbox for pod <pod-name> can be found, Need to start a new one`。这个应该就是造成容器冲突的来源,每次沉浸到 podWorker 的逻辑之后,podWorker 都要尝试去创建一个新的sandbox,进而造成容器冲突。

|

||||

|

||||

疑问:为啥 podWorker 每次都去创建一个新的 sandbox?

|

||||

|

||||

接下来继续调大 kubelet 的日志级别(k8s v1.16已经支持动态调整,这里调大日志级别到V(6)),这里主要是尝试拿到某个 pod 所关联的所有 sandbox,截图如下:

|

||||

|

||||

|

||||

|

||||

通过配合节点上执行 docker inspect(ps)相关命令发现,异常的 pod(kube-proxy)存在两个 sandbox(重启前的+重启后的),并且在 sandboxID 数组中的排序为 `[重启前的sandbox, 重启后的 sandbox]` (这里先 mark 一下)。

|

||||

|

||||

## 相关知识

|

||||

|

||||

在进一步分析之前,我们先介绍下相关背景知识。

|

||||

|

||||

### Pod 创建流程

|

||||

|

||||

先来一起熟悉下 pod 创建流程:

|

||||

|

||||

|

||||

|

||||

### PLEG 组件

|

||||

|

||||

再看下 `PLEG` 的工作流程。kubelet 启动之后,会运行起 `PLEG` 组件,定期的缓存 pod 的信息(包括 pod status)。在 `PLEG` 的每次 relist 逻辑中,会对比 `old pod` 和 `new pod`,检查是否存在变化,如果新旧 pod 之间存在变化,则开始执行下面两个逻辑:

|

||||

1. 生成 event 事件,比如 containerStart 等,最后再投递到 `eventChannel` 中,供 podWorker 来消费。

|

||||

2. 更新内部缓存 cache。在跟新缓存 `updateCache` 的逻辑中,会调用 runtime 的相关接口获取到与 pod 相关的 status 状态信息,然后并缓存到内部缓存 cache中,最后发起通知 ( podWorker 会发起订阅) 。

|

||||

|

||||

podStatus的数据结构如下:

|

||||

|

||||

```go

|

||||

# podStatus

|

||||

type PodStatus struct {

|

||||

// ID of the pod.

|

||||

ID types.UID

|

||||

...

|

||||

...

|

||||

// Only for kuberuntime now, other runtime may keep it nil.

|

||||

SandboxStatuses []*runtimeapi.PodSandboxStatus

|

||||

}

|

||||

|

||||

# SandboxStatus

|

||||

// PodSandboxStatus contains the status of the PodSandbox.

|

||||

type PodSandboxStatus struct {

|

||||

// ID of the sandbox.

|

||||

Id string `protobuf:"bytes,1,opt,name=id,proto3" json:"id,omitempty"`

|

||||

...

|

||||

// Creation timestamp of the sandbox in nanoseconds. Must be > 0.

|

||||

CreatedAt int64 `protobuf:"varint,4,opt,name=created_at,json=createdAt,proto3" json:"created_at,omitempty"`

|

||||

...

|

||||

}

|

||||

```

|

||||

|

||||

podStatus 会保存 pod 的一些基础信息,再加上 containerStatus 和 sandboxStatus 信息。

|

||||

|

||||

这里重点关注下 SandboxStatus 的排序问题,配合代码可以发现,排序是按照 sandbox 的 Create time 来执行的,并且时间越新,位置越靠前。排序相关的代码部分如下:

|

||||

|

||||

```go

|

||||

// Newest first.

|

||||

type podSandboxByCreated []*runtimeapi.PodSandbox

|

||||

|

||||

func (p podSandboxByCreated) Len() int { return len(p) }

|

||||

func (p podSandboxByCreated) Swap(i, j int) { p[i], p[j] = p[j], p[i] }

|

||||

func (p podSandboxByCreated) Less(i, j int) bool { return p[i].CreatedAt > p[j].CreatedAt }

|

||||

```

|

||||

|

||||

### podWorker 组件

|

||||

|

||||

最后再看下 podWorker 的工作流程。podWorker 的工作就是负责 pod 在节点上的正确运行(比如挂载 volume,新起 sandbox,新起 container 等),一个 pod 对应一个 podWorker,直到 pod 销毁。当节点重启后,kubelet 会收到 `type=ADD` 的事件来创建 pod 对象。

|

||||

|

||||

当 pod 更新之后,会触发 `event=containerStart` 事件的投递,然后 kubelet 就会收到 `type=SYNC` 的事件,来更新 pod 对象。在每次 podWorker 的内部逻辑中(`managePodLoop()`) 中,会存在一个 podStatus(内部缓存)的订阅,如下:

|

||||

|

||||

```go

|

||||

// This is a blocking call that would return only if the cache

|

||||

// has an entry for the pod that is newer than minRuntimeCache

|

||||

// Time. This ensures the worker doesn't start syncing until

|

||||

// after the cache is at least newer than the finished time of

|

||||

// the previous sync.

|

||||

status, err := p.podCache.GetNewerThan(podUID, lastSyncTime)

|

||||

```

|

||||

|

||||

来等待内部 cache 中的 podStatus 更新,然后再操作后续动作(是否重新挂载 volume、是否重建 sandbox,是否重建 container 等)。

|

||||

|

||||

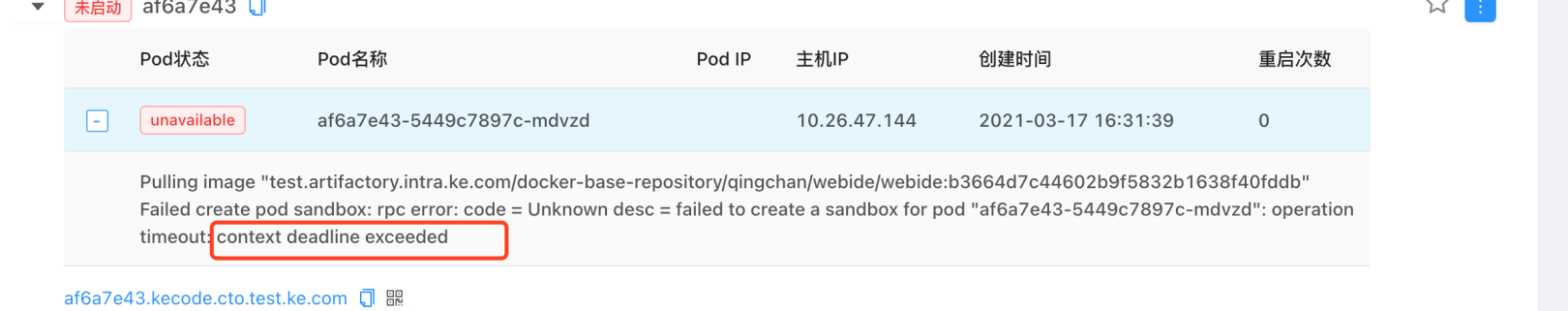

## 复现问题,定位根因

|

||||

|

||||

接下来,我们一起来模拟复现下问题现场。

|

||||

|

||||

|

||||

|

||||

在节点重启之前,由于是新建节点后,所以对于 pod 来说,status 中只有一个命名以 `_0` 结尾的 sandbox。当操作重启节点之后,kubelet 收到 `type=ADD` 的事件,podWorker 开始创建 pod,由于之前以 `_0` 命名结尾的 sandbox 已经 died 了,所以会新建一个新的以 `_1` 命名结尾的 sandbox,当新的以 `_1` 命名结尾的 sandbox 运行之后(containerStarted),就会投递一个 `type=SYNC` 的事件给到 kubelet,然后 podWorker 会被再次触发(内部 cache 也更新了,通知也发出了)。正常情况下,podWorker 会拿到 podStatus 中新的 sandbox(以 `_1` 命名结尾的),就不会再创建 sandbox 了,也就是不会发生 name 冲突的问题。而用户的环境却是,此时拿到了以 `_0` 命名结尾的旧的 sandbox,所以再新一轮的 podWorker 逻辑中,会再次创建一个新的以 `_1` 命名的 sandbox,从而产生冲突。

|

||||

|

||||

而这里的根因就是时间问题,节点重启前的sandbox(以 `_0` 命名结尾的)的 `create time` ,比节点重启后的sandbox(以 `_1` 命名结尾的)的 `create time` 还要提前,所以导致了内部 cache 中 sandbox 的排序发生了错乱,从而触发 name 冲突问题。

|

||||

|

||||

## 解决方案

|

||||

|

||||

根据上面的排查发现,kubelet 的内部缓存中,sandbox 的排序是有系统时间来决定的,所以,尽量保证 k8s 集群中的时间有正确同步,或者不要乱改节点上的时间。

|

||||

|

|

@ -1,53 +0,0 @@

|

|||

# 磁盘 IO 过高导致 Pod 创建超时

|

||||

|

||||

## 问题背景

|

||||

|

||||

在创建 TKE 集群的 worker node 时,用户往往会单独再购买一块云盘,绑到节点上,用于 docker 目录挂载所用(将 docker 目录单独放到数据盘上)。此时,docker 的读写层(RWLayer)就会落到云盘上。

|

||||

|

||||

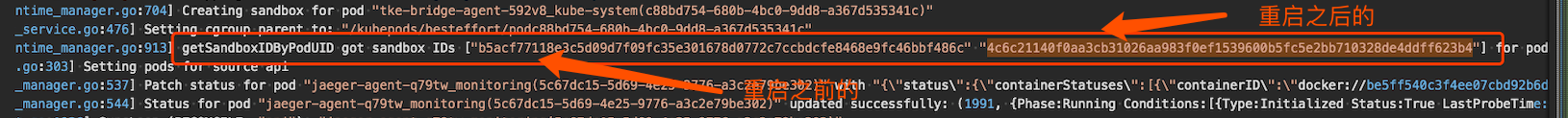

在该使用场景下,有用户反馈,在创建 Pod 时,会偶现 Pod 创建超时的报错,具体报错如下:

|

||||

|

||||

|

||||

|

||||

## 结论先行

|

||||

|

||||

当单独挂载一块云盘用于 docker 目录挂载使用时,会出现如下情况:云盘的真实使用超过云盘所支持的最大吞吐,导致 pod 创建超时。

|

||||

|

||||

## pod 失败的异常事件

|

||||

|

||||

从报错的事件上来看,可以看到报错是 create sandbox 时,rpc 调用超时了。

|

||||

|

||||

在 create sandbox 时,dockershim 会发起两次dockerd调用,分别是:`POST /containers/create` 和 `POST /containers/start`。而事件上给出的报错,就是 `POST /containers/create` 时的报错。

|

||||

|

||||

## 日志和堆栈分析

|

||||

|

||||

开启dockerd的debug模式后,在异常报错时间段内,能够看到有与 `POST /containers/create` 相关的日志,但是并没有看到与 `POST /containers/start` 相关的日志,说明 docker daemon 有收到 create container 的 rpc 请求,但是并没有在timeout的时间内,完成请求。可以对应到 pod 的异常报错事件。

|

||||

|

||||

当稳定复现问题(rpc timeout)之后,手动尝试在节点上通过curl命令,向docker daemon请求create containber。

|

||||

|

||||

命令如下:

|

||||

|

||||

```bash

|

||||

$ curl --unix-socket /var/run/docker.sock "http://1.38/containers/create?name=test01" -v -X POST -H "Content-Type: application/json" -d '{"Image": "nginx:latest"}'

|

||||

```

|

||||

|

||||

当执行 curl 命令之后,确实要等很长时间(>2min)才返回。

|

||||

|

||||

并抓取 dockerd 的堆栈信息,发现如下:**在问题发生时,有一个 delete container 动作,长时间卡在了 unlinkat 系统调用。**

|

||||

|

||||

|

||||

|

||||

container 的 create 和 delete 请求都会沉浸到 layer store组件,来创建或者删除容器的读写层。

|

||||

|

||||

在 layer store 组件中,维护了一个内部数据结构(layerStore),其中有一个字段 `mounts map[string]*mountedLayer` 用于维护所有容器的读写层信息,并且还配置了一个读写锁用于保护该信息(数据mounts的任何增删操作都需要先获取一个读写锁)。如果某个请求(比如container delete)长时间没有返回,就会阻塞其他 container 的创建或者删除。

|

||||

|

||||

|

||||

|

||||

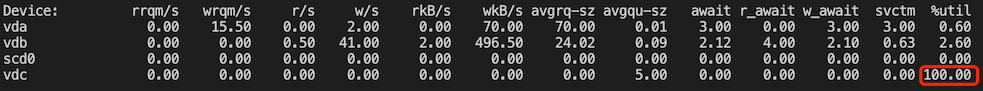

## 云盘监控

|

||||

|

||||

云盘的相关监控可以重点关注以下三个指标:云盘写流量、IO await、IO %util。

|

||||

|

||||

## 解决方案

|

||||

|

||||

配合业务场景需求,更换更高性能的云盘。

|

||||

|

||||

腾讯云上的云硬盘种类和吞吐指标可以 [官方参考文档](https://cloud.tencent.com/document/product/362/2353) 。

|

||||

|

|

@ -1,286 +0,0 @@

|

|||

# 挂载根目录导致 device or resource busy

|

||||

|

||||

## 现象

|

||||

|

||||

在删除 pod 时,可能会遇到如下事件 `unlinkat xxxxx: device or resource busy`,设备或资源忙导致某个文件无法被删除,进而导致 pod 卡在 Terminating 状态。

|

||||

|

||||

接下来,就单独针对在 **containerd运行时环境** 下,发生的相关报错进行回顾分析,具体的报错现象如下:

|

||||

|

||||

```txt

|

||||

unlinkat /var/run/netns/cni-49ddd103-d374-1f86-7324-13abaeb9c910: device or resource busy

|

||||

```

|

||||

|

||||

## 复现场景

|

||||

|

||||

环境:

|

||||

|

||||

* containerd 运行时

|

||||

* centos 7.6 操作系统

|

||||

|

||||

通过先后创建如下两个服务(sleeping 和 rootfsmount)可以复现问题。

|

||||

|

||||

1. 先创建 sleeping 服务:

|

||||

|

||||

```bash

|

||||

$ cat <<EOF | kubectl apply -f -

|

||||

apiVersion: apps/v1

|

||||

kind: Deployment

|

||||

metadata:

|

||||

name: sleepping

|

||||

spec:

|

||||

replicas: 1

|

||||

selector:

|

||||

matchLabels:

|

||||

app: sleepping

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

app: sleepping

|

||||

spec:

|

||||

containers:

|

||||

- name: test

|

||||

image: busybox

|

||||

args: ["sleep", "1h"]

|

||||

EOF

|

||||

```

|

||||

|

||||

2. 再创建 rootfsmount 服务,并且保证 pod 实例调度到与 sleeping 服务相同的节点上。

|

||||

|

||||

```bash

|

||||

$ cat <<EOF | kubectl apply -f -

|

||||

apiVersion: apps/v1

|

||||

kind: Deployment

|

||||

metadata:

|

||||

name: rootfsmount

|

||||

spec:

|

||||

replicas: 1

|

||||

selector:

|

||||

matchLabels:

|

||||

app: rootfsmount

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

app: rootfsmount

|

||||

spec:

|

||||

containers:

|

||||

- name: rootfsmount

|

||||

image: busybox

|

||||

args: ["sleep", "1h"]

|

||||

volumeMounts:

|

||||

- mountPath: /rootfs

|

||||

name: host-rootfs

|

||||

volumes:

|

||||

- hostPath:

|

||||

path: /

|

||||

type: ""

|

||||

name: host-rootfs

|

||||

EOF

|

||||

```

|

||||

|

||||

3. 操作删除 sleeping 服务的 pod,此时可以观察到 pod 实例卡在 Terminating 状态。

|

||||

|

||||

|

||||

|

||||

## 相关知识

|

||||

|

||||

在进一步了解之前,先熟悉下几个相关知识

|

||||

|

||||

1. `/run/netns/cni-xxxx` 文件:

|

||||

|

||||

这个文件实际上就是容器的 net nanemspace 的 mount point,可以通过如下命令进入到容器的 net ns 中:

|

||||

|

||||

```bash

|

||||

nsenter --net=/var/run/netns/cni-49ddd103-d374-1f86-7324-13abaeb9c910

|

||||

```

|

||||

|

||||

2. Shared subtrees 技术

|

||||

|

||||

> 此部分为引用说明,详情可见参考链接1

|

||||

|

||||

* 内核特性,用于控制某个挂载点下的子挂载点是否"传播"给其他挂载点,只应用于 bind mount 和 mount namespace 场景中。

|

||||

* Shared subtrees 技术引入了两个概念,分别是 peer group 和 propagation type,接下来一一介绍。

|

||||

|

||||

2.1 peer group

|

||||

|

||||

共享挂载信息的一组挂载点,来源主要两种:

|

||||

* bind mount,此时源和目的挂载点属于同一 peer group,要求源也是挂载点。

|

||||

* 新的 namespace 创建,新的 namespace 会拷贝旧的一份挂载信息,于是,新旧中相同挂载点属于同一 peer group。

|

||||

|

||||

2.2 propagation type

|

||||

|

||||

每个挂载点都有这样的一个元数据(propagation type),用于控制当一个挂载点的下面创建和移除挂载点的时候,是否会传播到属于相同peer group的其他挂载点下去,主要有三种:

|

||||

|

||||

* `MS_SHARED`: 挂载信息在同一个 peer group 里会相互传播。比如把节点上的主目录挂载到容器内的 `/rootfs`,如果节点上的主目录创建了新的挂载点X,则* 在容器内的 `/rootfs` 下面也会出现新的挂载点 `/rootfs/X`。

|

||||

* `MS_PRIVATE`:挂载信息在同一个 peer group 里不会相互传播。比如把节点上的主目录挂载到容器内的 `/rootfs`,如果节点上的主目录创建了新的挂载点X,则容器内的 `/rootfs` 下面不会出现新的挂载点 `/rootfs/X`。

|

||||

* `MS_SLAVE`:挂载信息传播是单向的。比如把节点上的主目录挂载到容器内的 `/rootfs`,如果节点上的主目录创建了新的挂载点 X,则在容器内的 `/rootfs` 下面也会出现新的挂载点 `/rootfs/X` ,反之则不行。

|

||||

|

||||

这个对应到 k8s 中 `Container.volumeMounts` 的 `mountPropagation` 字段,分别是:Bidirectional、None、HostToContainer。

|

||||

|

||||

## 进一步分析

|

||||

|

||||

让我们再回到复现场景中的第二步,创建 rootfsmount 服务时,发生了什么。

|

||||

|

||||

通过命令抓取下 contianerd 的所有 mount 系统调用,发现有如下两个 mount 记录:

|

||||

|

||||

```bash

|

||||

$ strace -f -e trace=mount -p <pid>

|

||||

...

|

||||

[pid 15532] mount("/", "/run/containerd/io.containerd.runtime.v2.task/k8s.io/5b498caf152857cf1c797761e1f52d64c2ce7d4602b72304da7e154ed31043c8/rootfs/rootfs", 0xc0000f7500, MS_BIND|MS_REC, NULL) = 0

|

||||

[pid 15532] mount("", "/run/containerd/io.containerd.runtime.v2.task/k8s.io/5b498caf152857cf1c797761e1f52d64c2ce7d4602b72304da7e154ed31043c8/rootfs/rootfs", 0xc0000f7506, MS_REC|MS_PRIVATE, NULL) = 0

|

||||

...

|

||||

```

|

||||

|

||||

这个就对应于 pod 配置中的 volumeMount,我们再进一步看下 container 中的 mount 信息。

|

||||

|

||||

将节点上的主目录 `/` (挂载点) 挂载到了容器中的 `/rootfs` (挂载点),并且 propagation type 为 rprivate。

|

||||

|

||||

```bash

|

||||

$ crictl inspect <container-id>

|

||||

...

|

||||

{

|

||||

"destination": "/rootfs",

|

||||

"type": "bind",

|

||||

"source": "/",

|

||||

"options": [

|

||||

"rbind",

|

||||

"rprivate",

|

||||

"rw"

|

||||

]

|

||||

},

|

||||

...

|

||||

```

|

||||

|

||||

让我们再看下pod(或者容器内)的挂载情况:

|

||||

|

||||

```bash

|

||||

$ cat /proc/self/mountinfo

|

||||

...

|

||||

# 对应pod的volumeMount设置,将宿主机上的主目录/ 挂载到了容器内的/rootfs目录下

|

||||

651 633 253:1 / /rootfs rw,relatime - ext4 /dev/vda1 rw,data=ordered

|

||||

695 677 0:3 / /rootfs/run/netns/cni-49ddd103-d374-1f86-7324-13abaeb9c910 rw,nosuid,nodev,noexec,relatime - proc proc rw

|

||||

...

|

||||

```

|

||||

|

||||

节点上的挂载点(/var/run/netns/cni-49ddd103-d374-1f86-7324-13abaeb9c910)在容器内,也是挂载点(/rootfs/run/netns/cni-49ddd103-d374-1f86-7324-13abaeb9c910)。

|

||||

|

||||

## 结论

|

||||

|

||||

当测试服务 rootfsmount 的 pod 实例创建时,会把节点上的主目录 `/` 挂载到容器内(比如 `/rootfs`),由于主目录在节点上是一个挂载点,所以节点上的主目录和容器内的/rootfs属于同一个 peer group,并且采用了默认的 propagation type:rprivate。

|

||||

|

||||

当测试服务 sleepping 的 pod 实例销毁时,需要解挂和销毁对应的 netns 文件(/var/run/netns/cni-49ddd103-d374-1f86-7324-13abaeb9c910),由于此时的 propagation type 是 rprivate,节点上主目录下的子挂载点解挂不会传递到容器的 net namespace 内,所以,这个 netns 文件(/rootfs/run/netns/cni-49ddd103-d374-1f86-7324-13abaeb9c910)依然是一个挂载点,导致在销毁 netns 文件时会失败。

|

||||

|

||||

|

||||

## 解决方案

|

||||

|

||||

1. 给 rootfsmount 服务的 volumeMount 配置新增 propagation type,设置为 HostToContainer 或者 Bidirectional。

|

||||

|

||||

```yaml

|

||||

apiVersion: apps/v1

|

||||

kind: Deployment

|

||||

metadata:

|

||||

name: rootfsmount

|

||||

spec:

|

||||

replicas: 1

|

||||

selector:

|

||||

matchLabels:

|

||||

app: rootfsmount

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

app: rootfsmount

|

||||

spec:

|

||||

containers:

|

||||

- name: rootfsmount

|

||||

image: busybox

|

||||

args: ["sleep", "1h"]

|

||||

volumeMounts:

|

||||

- mountPath: /rootfs

|

||||

name: host-rootfs

|

||||

mountPropagation: HostToContainer # 这里显示声明mountPropagation为HostToContainer 或者 Bidirectional

|

||||

volumes:

|

||||

- hostPath:

|

||||

path: /

|

||||

type: ""

|

||||

name: host-rootfs

|

||||

```

|

||||

|

||||

|

||||

2. centos 和 redhat 的内核,可以开启如下内核参数:

|

||||

|

||||

```bash

|

||||

echo 1 > /proc/sys/fs/may_detach_mounts

|

||||

```

|

||||

|

||||

## 疑问:为啥 dockerd 运行时没有这个问题?

|

||||

|

||||

这里主要有两点:

|

||||

|

||||

1. dockerd 在启动的时候,开启了内核参数 `fs.may\_detach\_mounts`。

|

||||

|

||||

```go

|

||||

// This is used to allow removal of mountpoints that may be mounted in other

|

||||

// namespaces on RHEL based kernels starting from RHEL 7.4.

|

||||

// Without this setting, removals on these RHEL based kernels may fail with

|

||||

// "device or resource busy".

|

||||

// This setting is not available in upstream kernels as it is not configurable,

|

||||

// but has been in the upstream kernels since 3.15.

|

||||

func setMayDetachMounts() error {

|

||||

f, err := os.OpenFile("/proc/sys/fs/may_detach_mounts", os.O_WRONLY, 0)

|

||||

if err != nil {

|

||||

if os.IsNotExist(err) {

|

||||

return nil

|

||||

}

|

||||

return errors.Wrap(err, "error opening may_detach_mounts kernel config file")

|

||||

}

|

||||

defer f.Close()

|

||||

|

||||

_, err = f.WriteString("1")

|

||||

if os.IsPermission(err) {

|

||||

// Setting may_detach_mounts does not work in an

|

||||

// unprivileged container. Ignore the error, but log

|

||||

// it if we appear not to be in that situation.

|

||||

if !rsystem.RunningInUserNS() {

|

||||

logrus.Debugf("Permission denied writing %q to /proc/sys/fs/may_detach_mounts", "1")

|

||||

}

|

||||

return nil

|

||||

}

|

||||

return err

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

2. dockerd 在挂载目录时,会验证挂载的源目录与 daemon 的 root 目录的关系,如果源目录是 root 目录的子目录或者 root 目录是源目录的子目录,则将 propagation type 设置为 `MS_SLAVE`。

|

||||

|

||||

```go

|

||||

// validateBindDaemonRoot ensures that if a given mountpoint's source is within

|

||||

// the daemon root path, that the propagation is setup to prevent a container

|

||||

// from holding private refereneces to a mount within the daemon root, which

|

||||

// can cause issues when the daemon attempts to remove the mountpoint.

|

||||

func (daemon *Daemon) validateBindDaemonRoot(m mount.Mount) (bool, error) {

|

||||

if m.Type != mount.TypeBind {

|

||||

return false, nil

|

||||

}

|

||||

|

||||

// check if the source is within the daemon root, or if the daemon root is within the source

|

||||