first commit

commit

fab3b241c1

|

|

@ -0,0 +1,20 @@

|

|||

# Dependencies

|

||||

/node_modules

|

||||

|

||||

# Production

|

||||

/build

|

||||

|

||||

# Generated files

|

||||

.docusaurus

|

||||

.cache-loader

|

||||

|

||||

# Misc

|

||||

.DS_Store

|

||||

.env.local

|

||||

.env.development.local

|

||||

.env.test.local

|

||||

.env.production.local

|

||||

|

||||

npm-debug.log*

|

||||

yarn-debug.log*

|

||||

yarn-error.log*

|

||||

|

|

@ -0,0 +1,15 @@

|

|||

SHELL := /bin/bash

|

||||

|

||||

start:

|

||||

npm run start

|

||||

install:

|

||||

npm install

|

||||

outdated:

|

||||

npm outdated

|

||||

init: install

|

||||

git clone --depth=1 git@gitee.com:imroc/kubernetes-guide.git build

|

||||

gen:

|

||||

npx docusaurus build --out-dir=./build/out

|

||||

push:

|

||||

cd build && git add -a && git commit -m update && git push

|

||||

update: gen push

|

||||

|

|

@ -0,0 +1,23 @@

|

|||

# Kubernetes 实践指南

|

||||

|

||||

本书将介绍 Kubernetes 相关实战经验与总结,助你成为一名云原生老司机 😎。

|

||||

|

||||

## 关于本书

|

||||

|

||||

本书为电子书形式,内容为本人多年的云原生与 Kubernetes 实战经验进行系统性整理的结果,不废话,纯干货。

|

||||

|

||||

## 在线阅读

|

||||

|

||||

地址:https://imroc.cc/kubernetes

|

||||

|

||||

## 评论与互动

|

||||

|

||||

本书已集成 [giscus](https://giscus.app/zh-CN) 评论系统,欢迎对感兴趣的文章进行评论与交流。

|

||||

|

||||

## 贡献

|

||||

|

||||

本书使用 [docusaurus](https://docusaurus.io/) 构建,已集成自动构建和发布,欢迎 Fork 并 PR 来贡献干货内容 (点击左下角 `编辑此页` 按钮可快速修改文章)。

|

||||

|

||||

## 许可证

|

||||

|

||||

您可以使用 [署名 - 非商业性使用 - 相同方式共享 4.0 (CC BY-NC-SA 4.0)](https://creativecommons.org/licenses/by-nc-sa/4.0/deed.zh) 协议共享。

|

||||

|

|

@ -0,0 +1,3 @@

|

|||

module.exports = {

|

||||

presets: [require.resolve('@docusaurus/core/lib/babel/preset')],

|

||||

};

|

||||

|

|

@ -0,0 +1,11 @@

|

|||

package main

|

||||

|

||||

import (

|

||||

"fmt"

|

||||

)

|

||||

|

||||

func main() {

|

||||

for i := 0; i < 10; i++ {

|

||||

fmt.Println("hello world", i)

|

||||

}

|

||||

}

|

||||

|

|

@ -0,0 +1,23 @@

|

|||

# Kubernetes 实践指南

|

||||

|

||||

本书将介绍 Kubernetes 相关实战经验与总结,助你成为一名云原生老司机 😎。

|

||||

|

||||

## 关于本书

|

||||

|

||||

本书为电子书形式,内容为本人多年的云原生与 Kubernetes 实战经验进行系统性整理的结果,不废话,纯干货。

|

||||

|

||||

## 在线阅读

|

||||

|

||||

地址:https://imroc.cc/kubernetes

|

||||

|

||||

## 评论与互动

|

||||

|

||||

本书已集成 [giscus](https://giscus.app/zh-CN) 评论系统,欢迎对感兴趣的文章进行评论与交流。

|

||||

|

||||

## 贡献

|

||||

|

||||

本书使用 [docusaurus](https://docusaurus.io/) 构建,已集成自动构建和发布,欢迎 Fork 并 PR 来贡献干货内容 (点击左下角 `编辑此页` 按钮可快速修改文章)。

|

||||

|

||||

## 许可证

|

||||

|

||||

您可以使用 [署名 - 非商业性使用 - 相同方式共享 4.0 (CC BY-NC-SA 4.0)](https://creativecommons.org/licenses/by-nc-sa/4.0/deed.zh) 协议共享。

|

||||

|

|

@ -0,0 +1,139 @@

|

|||

# kubectl 速查手册

|

||||

|

||||

## 使用 kubectl get --raw

|

||||

|

||||

### 获取节点 cadvisor 指标

|

||||

|

||||

```bash

|

||||

kubectl get --raw=/api/v1/nodes/11.185.19.215/proxy/metrics/cadvisor

|

||||

|

||||

# 查看有哪些指标名

|

||||

kubectl get --raw=/api/v1/nodes/11.185.19.215/proxy/metrics/cadvisor | grep -v "#" | awk -F '{' '{print $1}' | awk '{print $1}' | sort | uniq

|

||||

```

|

||||

|

||||

### 获取节点 kubelet 指标

|

||||

|

||||

```bash

|

||||

kubectl get --raw=/api/v1/nodes/11.185.19.215/proxy/metrics

|

||||

```

|

||||

|

||||

### 获取 node-exporter pod 指标

|

||||

|

||||

```bash

|

||||

kubectl get --raw=/api/v1/namespaces/monitoring/pods/node-exporter-n5rz2:9100/proxy/metrics

|

||||

```

|

||||

|

||||

### 获取节点 summary 数据

|

||||

|

||||

```bash

|

||||

kubectl get --raw=/api/v1/nodes/11.185.19.21/proxy/stats/summary

|

||||

```

|

||||

|

||||

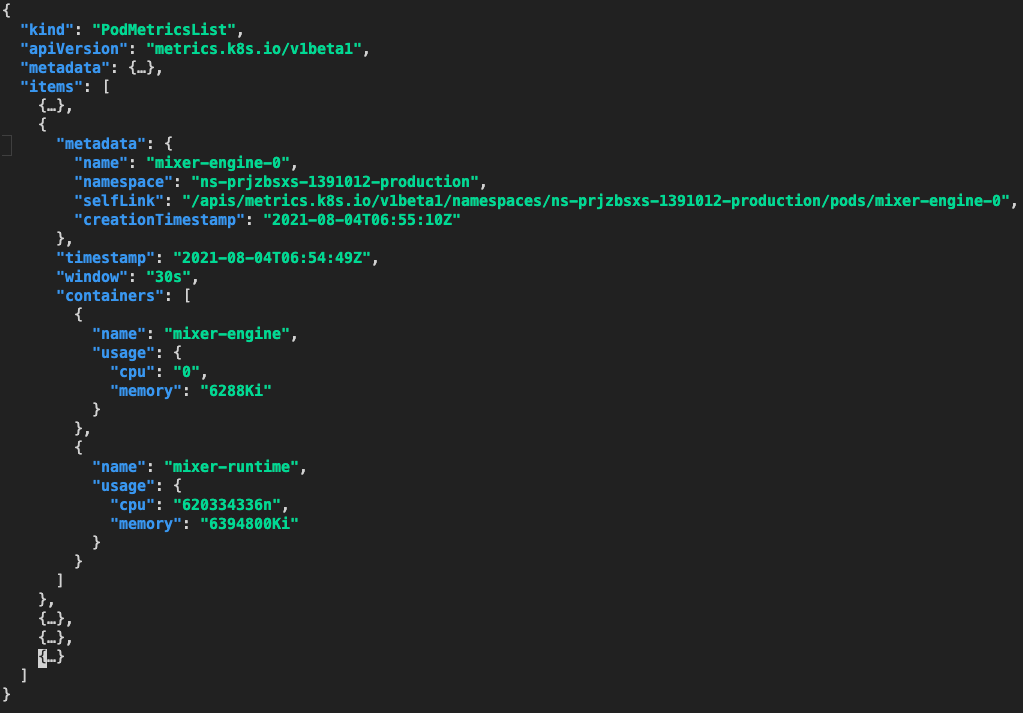

### 测试 Resource Metrics API

|

||||

|

||||

获取指定 namespace 下所有 pod 指标:

|

||||

|

||||

```bash

|

||||

kubectl get --raw "/apis/metrics.k8s.io/v1beta1/namespaces/ns-prjzbsxs-1391012-production/pods/"

|

||||

```

|

||||

|

||||

|

||||

|

||||

获取指定 pod 的指标:

|

||||

|

||||

```bash

|

||||

kubectl get --raw "/apis/metrics.k8s.io/v1beta1/namespaces/ns-prjzbsxs-1391012-production/pods/mixer-engine-0"

|

||||

```

|

||||

|

||||

|

||||

|

||||

## Node 相关

|

||||

|

||||

### 表格输出各节点占用的 podCIDR

|

||||

|

||||

``` bash

|

||||

$ kubectl get no -o=custom-columns=INTERNAL-IP:.metadata.name,EXTERNAL-IP:.status.addresses[1].address,CIDR:.spec.podCIDR

|

||||

INTERNAL-IP EXTERNAL-IP CIDR

|

||||

10.100.12.194 152.136.146.157 10.101.64.64/27

|

||||

10.100.16.11 10.100.16.11 10.101.66.224/27

|

||||

```

|

||||

|

||||

### 表格输出各节点总可用资源 (Allocatable)

|

||||

|

||||

``` bash

|

||||

$ kubectl get no -o=custom-columns="NODE:.metadata.name,ALLOCATABLE CPU:.status.allocatable.cpu,ALLOCATABLE MEMORY:.status.allocatable.memory"

|

||||

NODE ALLOCATABLE CPU ALLOCATABLE MEMORY

|

||||

10.0.0.2 3920m 7051692Ki

|

||||

10.0.0.3 3920m 7051816Ki

|

||||

```

|

||||

|

||||

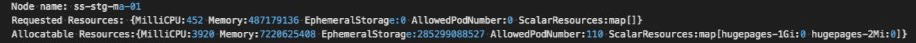

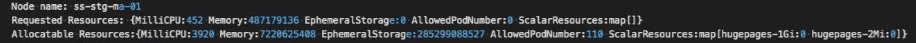

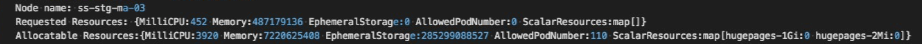

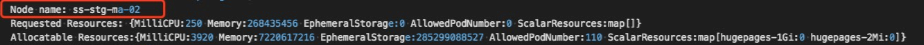

### 输出各节点已分配资源的情况

|

||||

|

||||

所有种类的资源已分配情况概览:

|

||||

|

||||

``` bash

|

||||

$ kubectl get nodes --no-headers | awk '{print $1}' | xargs -I {} sh -c "echo {} ; kubectl describe node {} | grep Allocated -A 5 | grep -ve Event -ve Allocated -ve percent -ve --;"

|

||||

10.0.0.2

|

||||

Resource Requests Limits

|

||||

cpu 3040m (77%) 19800m (505%)

|

||||

memory 4843402752 (67%) 15054901888 (208%)

|

||||

10.0.0.3

|

||||

Resource Requests Limits

|

||||

cpu 300m (7%) 1 (25%)

|

||||

memory 250M (3%) 2G (27%)

|

||||

```

|

||||

|

||||

表格输出 cpu 已分配情况:

|

||||

|

||||

``` bash

|

||||

$ kubectl get nodes --no-headers | awk '{print $1}' | xargs -I {} sh -c 'echo -ne "{}\t" ; kubectl describe node {} | grep Allocated -A 5 | grep -ve Event -ve Allocated -ve percent -ve -- | grep cpu | awk '\''{print $2$3}'\'';'

|

||||

10.0.0.10 460m(48%)

|

||||

10.0.0.12 235m(25%)

|

||||

```

|

||||

|

||||

表格输出 memory 已分配情况:

|

||||

|

||||

``` bash

|

||||

$ kubectl get nodes --no-headers | awk '{print $1}' | xargs -I {} sh -c 'echo -ne "{}\t" ; kubectl describe node {} | grep Allocated -A 5 | grep -ve Event -ve Allocated -ve percent -ve -- | grep memory | awk '\''{print $2$3}'\'';'

|

||||

10.0.0.10 257460608(41%)

|

||||

10.0.0.12 59242880(9%)

|

||||

```

|

||||

|

||||

### 查看节点可用区分布情况

|

||||

|

||||

```bash

|

||||

$ kubectl get nodes -o=jsonpath='{range .items[*]}{.metadata.name}{"\t"}{.metadata.labels.failure-domain\.beta\.kubernetes\.io\/zone}{"\n"}{end}'

|

||||

10.83.96.127 100004

|

||||

10.83.96.132 100004

|

||||

10.83.96.139 100004

|

||||

10.83.96.8 100004

|

||||

10.83.96.93 100004

|

||||

```

|

||||

|

||||

## Pod 相关

|

||||

|

||||

### 清理 Evicted 的 pod

|

||||

|

||||

``` bash

|

||||

kubectl get pod -o wide --all-namespaces | awk '{if($4=="Evicted"){cmd="kubectl -n "$1" delete pod "$2; system(cmd)}}'

|

||||

```

|

||||

|

||||

### 清理非 Running 的 pod

|

||||

|

||||

``` bash

|

||||

kubectl get pod -o wide --all-namespaces | awk '{if($4!="Running"){cmd="kubectl -n "$1" delete pod "$2; system(cmd)}}'

|

||||

```

|

||||

|

||||

### 升级镜像

|

||||

|

||||

``` bash

|

||||

export NAMESPACE="kube-system"

|

||||

export WORKLOAD_TYPE="daemonset"

|

||||

export WORKLOAD_NAME="ip-masq-agent"

|

||||

export CONTAINER_NAME="ip-masq-agent"

|

||||

export IMAGE="ccr.ccs.tencentyun.com/library/ip-masq-agent:v2.5.0"

|

||||

```

|

||||

|

||||

``` bash

|

||||

kubectl -n $NAMESPACE patch $WORKLOAD_TYPE $WORKLOAD_NAME --patch '{"spec": {"template": {"spec": {"containers": [{"name": "$CONTAINER_NAME","image": "$IMAGE" }]}}}}'

|

||||

```

|

||||

|

|

@ -0,0 +1,48 @@

|

|||

# TKE Serverless 集群

|

||||

|

||||

```hcl title="main.tf"

|

||||

terraform {

|

||||

required_providers {

|

||||

tencentcloud = {

|

||||

source = "tencentcloudstack/tencentcloud"

|

||||

version = "1.80.4"

|

||||

}

|

||||

}

|

||||

}

|

||||

|

||||

provider "tencentcloud" {

|

||||

secret_id = "************************************" # 云 API 密钥 SecretId

|

||||

secret_key = "********************************" # 云 API 密钥 SecretKey

|

||||

region = "ap-shanghai" # 地域,完整可用地域列表参考: https://cloud.tencent.com/document/product/213/6091

|

||||

}

|

||||

|

||||

|

||||

data "tencentcloud_vpc_instances" "myvpc" {

|

||||

name = "myvpc" # 指定 VPC 名称

|

||||

}

|

||||

|

||||

data "tencentcloud_vpc_subnets" "mysubnet" {

|

||||

vpc_id = data.tencentcloud_vpc_instances.myvpc.instance_list.0.vpc_id

|

||||

name = "mysubnet" # 指定子网名称

|

||||

}

|

||||

|

||||

resource "tencentcloud_eks_cluster" "myserverless" {

|

||||

cluster_name = "roc-test-serverless" # 指定 serverless 集群名称

|

||||

k8s_version = "1.24.4" # 指定 serverless 集群版本

|

||||

|

||||

public_lb {

|

||||

enabled = true # 打开公网访问 (kubectl 远程操作集群)

|

||||

allow_from_cidrs = ["0.0.0.0/0"]

|

||||

}

|

||||

|

||||

vpc_id = data.tencentcloud_vpc_instances.roctest.instance_list.0.vpc_id

|

||||

subnet_ids = [

|

||||

data.tencentcloud_vpc_subnets.mysubnet.instance_list.0.subnet_id

|

||||

]

|

||||

cluster_desc = "roc test cluster" # 集群描述

|

||||

service_subnet_id = data.tencentcloud_vpc_subnets.mysubnet.instance_list.0.subnet_id

|

||||

enable_vpc_core_dns = true

|

||||

need_delete_cbs = true

|

||||

}

|

||||

```

|

||||

|

||||

|

|

@ -0,0 +1,154 @@

|

|||

# TKE 集群(VPC-CNI)

|

||||

|

||||

```hcl title="main.tf"

|

||||

terraform {

|

||||

required_providers {

|

||||

# highlight-next-line

|

||||

tencentcloud = {

|

||||

source = "tencentcloudstack/tencentcloud"

|

||||

version = "1.81.24"

|

||||

}

|

||||

}

|

||||

}

|

||||

|

||||

variable "secret_id" {

|

||||

default = "************************************" # 替换 secret id

|

||||

}

|

||||

|

||||

variable "secret_key" {

|

||||

default = "********************************" # 替换 secret key

|

||||

}

|

||||

|

||||

variable "region" {

|

||||

default = "ap-shanghai"

|

||||

}

|

||||

|

||||

provider "tencentcloud" {

|

||||

secret_id = var.secret_id # 云 API 密钥 SecretId

|

||||

secret_key = var.secret_key # 云 API 密钥 SecretKey

|

||||

region = var.region # 地域,完整可用地域列表参考: https://cloud.tencent.com/document/product/213/6091

|

||||

}

|

||||

|

||||

variable "availability_zone_first" {

|

||||

default = "ap-shanghai-4" # 替换首选可用区

|

||||

}

|

||||

|

||||

variable "availability_zone_second" {

|

||||

default = "ap-shanghai-2" # 替换备选可用区

|

||||

}

|

||||

|

||||

variable "default_instance_type" {

|

||||

default = "S5.MEDIUM4"

|

||||

}

|

||||

|

||||

variable "vpc_name" {

|

||||

default = "roc-test" # 替换 VPC 名称

|

||||

}

|

||||

|

||||

variable "cluster_name" {

|

||||

default = "roc-test-cluster" # 替换集群名称

|

||||

}

|

||||

|

||||

variable "image_id" {

|

||||

default = "img-1tmhysjj" # TencentOS Server 3.2 with Driver

|

||||

}

|

||||

|

||||

variable "security_group" {

|

||||

default = "sg-616bnwjw" # 替换安全组 ID

|

||||

}

|

||||

|

||||

variable "skey_id" {

|

||||

default = "skey-3t01mlvf" # 替换 ssh 密钥 ID

|

||||

}

|

||||

|

||||

variable "service_cidr" {

|

||||

default = "192.168.6.0/24" # 替换 service 网段

|

||||

}

|

||||

|

||||

data "tencentcloud_vpc_instances" "vpc" {

|

||||

name = var.vpc_name

|

||||

}

|

||||

|

||||

data "tencentcloud_vpc_subnets" "zone_first" {

|

||||

vpc_id = data.tencentcloud_vpc_instances.vpc.instance_list.0.vpc_id

|

||||

availability_zone = var.availability_zone_first

|

||||

}

|

||||

|

||||

data "tencentcloud_vpc_subnets" "zone_second" {

|

||||

vpc_id = data.tencentcloud_vpc_instances.vpc.instance_list.0.vpc_id

|

||||

availability_zone = var.availability_zone_second

|

||||

}

|

||||

|

||||

resource "tencentcloud_kubernetes_cluster" "managed_cluster" {

|

||||

vpc_id = data.tencentcloud_vpc_instances.vpc.instance_list.0.vpc_id

|

||||

cluster_max_pod_num = 256

|

||||

cluster_name = var.cluster_name

|

||||

cluster_desc = "roc test cluster" # 替换集群描述

|

||||

cluster_version = "1.26.1"

|

||||

cluster_max_service_num = 256

|

||||

cluster_internet = true

|

||||

cluster_internet_security_group = var.security_group

|

||||

cluster_deploy_type = "MANAGED_CLUSTER"

|

||||

|

||||

container_runtime = "containerd"

|

||||

kube_proxy_mode = "ipvs"

|

||||

network_type = "VPC-CNI" # 集群网络模式,GR 或 VPC-CNI,推荐用 VPC-CNI。如果用 GR,还需要设置集群网段(cluster_cidr)

|

||||

service_cidr = var.service_cidr

|

||||

eni_subnet_ids = [

|

||||

data.tencentcloud_vpc_subnets.zone_first.instance_list.0.subnet_id,

|

||||

data.tencentcloud_vpc_subnets.zone_second.instance_list.0.subnet_id

|

||||

]

|

||||

worker_config { # 集群创建时自动创建的 cvm worker 节点(非节点池),如果不需要,可以删除此代码块。

|

||||

instance_name = "roc-test" # 替换节点cvm名称

|

||||

count = 1 # 替换初始节点数量

|

||||

availability_zone = var.availability_zone_first

|

||||

instance_type = var.default_instance_type

|

||||

|

||||

system_disk_type = "CLOUD_PREMIUM"

|

||||

system_disk_size = 50

|

||||

internet_charge_type = "TRAFFIC_POSTPAID_BY_HOUR"

|

||||

internet_max_bandwidth_out = 0 # 节点是否需要公网带宽,0 为不需要,1 为需要。

|

||||

public_ip_assigned = false

|

||||

security_group_ids = [var.security_group]

|

||||

subnet_id = data.tencentcloud_vpc_subnets.zone_first.instance_list.0.subnet_id

|

||||

|

||||

enhanced_security_service = false

|

||||

enhanced_monitor_service = false

|

||||

key_ids = [var.skey_id]

|

||||

img_id = var.image_id

|

||||

}

|

||||

}

|

||||

|

||||

# 集群初始化时自动创建的节点池,如果不需要,可删除此代码块

|

||||

resource "tencentcloud_kubernetes_node_pool" "mynodepool" {

|

||||

name = "roc-test-pool" # 替换节点池名称

|

||||

cluster_id = tencentcloud_kubernetes_cluster.managed_cluster.id

|

||||

max_size = 6 # 最大节点数量

|

||||

min_size = 0 # 最小节点数量

|

||||

vpc_id = data.tencentcloud_vpc_instances.vpc.instance_list.0.vpc_id

|

||||

subnet_ids = [data.tencentcloud_vpc_subnets.zone_first.instance_list.0.subnet_id]

|

||||

retry_policy = "INCREMENTAL_INTERVALS"

|

||||

desired_capacity = 2 # 节点池的期望节点数量

|

||||

enable_auto_scale = false

|

||||

multi_zone_subnet_policy = "EQUALITY"

|

||||

node_os = "tlinux3.1x86_64"

|

||||

delete_keep_instance = false

|

||||

|

||||

auto_scaling_config {

|

||||

instance_type = var.default_instance_type

|

||||

system_disk_type = "CLOUD_PREMIUM"

|

||||

system_disk_size = "50"

|

||||

orderly_security_group_ids = [var.security_group]

|

||||

|

||||

instance_charge_type = "SPOTPAID"

|

||||

spot_instance_type = "one-time"

|

||||

spot_max_price = "1000"

|

||||

public_ip_assigned = false

|

||||

|

||||

key_ids = [var.skey_id]

|

||||

enhanced_security_service = false

|

||||

enhanced_monitor_service = false

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

|

|

@ -0,0 +1,267 @@

|

|||

# 实用 YAML

|

||||

|

||||

## RBAC 相关

|

||||

|

||||

### 给 roc 授权 test 命名空间所有权限,istio-system 命名空间的只读权限

|

||||

|

||||

```yaml

|

||||

kind: Role

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

metadata:

|

||||

name: admin

|

||||

namespace: test

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["*"]

|

||||

|

||||

---

|

||||

|

||||

kind: RoleBinding

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

metadata:

|

||||

name: admin-to-roc

|

||||

namespace: test

|

||||

subjects:

|

||||

- kind: User

|

||||

name: roc

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

roleRef:

|

||||

kind: Role

|

||||

name: admin

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

|

||||

---

|

||||

|

||||

kind: Role

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

metadata:

|

||||

name: readonly

|

||||

namespace: istio-system

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["get", "watch", "list"]

|

||||

|

||||

---

|

||||

kind: RoleBinding

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

metadata:

|

||||

name: readonly-to-roc

|

||||

namespace: istio-system

|

||||

subjects:

|

||||

- kind: User

|

||||

name: roc

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

roleRef:

|

||||

kind: Role

|

||||

name: readonly

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

```

|

||||

|

||||

### 给 roc 授权整个集群的只读权限

|

||||

|

||||

```yaml

|

||||

kind: ClusterRole

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

metadata:

|

||||

name: readonly

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["get", "watch", "list"]

|

||||

|

||||

---

|

||||

kind: ClusterRoleBinding

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

metadata:

|

||||

name: readonly-to-roc

|

||||

subjects:

|

||||

- kind: User

|

||||

name: roc

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

roleRef:

|

||||

kind: ClusterRole

|

||||

name: readonly

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

```

|

||||

|

||||

### 给 manager 用户组里所有用户授权 secret 读权限

|

||||

|

||||

``` yaml

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: secret-reader

|

||||

rules:

|

||||

- apiGroups: [""]

|

||||

resources: ["secrets"]

|

||||

verbs: ["get", "watch", "list"]

|

||||

---

|

||||

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRoleBinding

|

||||

metadata:

|

||||

name: read-secrets-global

|

||||

subjects:

|

||||

- kind: Group

|

||||

name: manager

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

roleRef:

|

||||

kind: ClusterRole

|

||||

name: secret-reader

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

```

|

||||

|

||||

### 给 roc 授权集群只读权限 (secret读权限除外)

|

||||

|

||||

secret 读权限比较敏感,不要轻易放开,k8s 的 Role/ClusterRole 没有提供类似 "某资源除外" 的能力,secret 在 core group 下,所以只排除 secret 读权限的话需要列举其它所有 core 下面的资源,另外加上其它所有可能的 group 所有资源(包括CRD):

|

||||

|

||||

```yaml

|

||||

kind: ClusterRole

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

metadata:

|

||||

name: readonly

|

||||

rules:

|

||||

- apiGroups: [""]

|

||||

resources:

|

||||

- bindings

|

||||

- componentstatuses

|

||||

- configmaps

|

||||

- endpoints

|

||||

- events

|

||||

- limitranges

|

||||

- namespaces

|

||||

- nodes

|

||||

- persistentvolumeclaims

|

||||

- persistentvolumes

|

||||

- pods

|

||||

- podtemplates

|

||||

- replicationcontrollers

|

||||

- resourcequotas

|

||||

- serviceaccounts

|

||||

- services

|

||||

verbs: ["get", "list"]

|

||||

- apiGroups:

|

||||

- cert-manager.io

|

||||

- admissionregistration.k8s.io

|

||||

- apiextensions.k8s.io

|

||||

- apiregistration.k8s.io

|

||||

- apps

|

||||

- authentication.k8s.io

|

||||

- autoscaling

|

||||

- batch

|

||||

- certificaterequests.cert-manager.io

|

||||

- certificates.cert-manager.io

|

||||

- certificates.k8s.io

|

||||

- cloud.tencent.com

|

||||

- coordination.k8s.io

|

||||

- discovery.k8s.io

|

||||

- events.k8s.io

|

||||

- extensions

|

||||

- install.istio.io

|

||||

- metrics.k8s.io

|

||||

- monitoring.coreos.com

|

||||

- networking.istio.io

|

||||

- node.k8s.io

|

||||

- policy

|

||||

- rbac.authorization.k8s.io

|

||||

- scheduling.k8s.io

|

||||

- security.istio.io

|

||||

- storage.k8s.io

|

||||

resources: ["*"]

|

||||

verbs: [ "get", "list" ]

|

||||

|

||||

---

|

||||

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRoleBinding

|

||||

metadata:

|

||||

name: roc

|

||||

roleRef:

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

kind: ClusterRole

|

||||

name: readonly

|

||||

subjects:

|

||||

- apiGroup: rbac.authorization.k8s.io

|

||||

kind: User

|

||||

name: roc

|

||||

```

|

||||

|

||||

> 可以借助 `kubectl api-resources -o name` 来列举。

|

||||

|

||||

### 限制 ServiceAccount 权限

|

||||

|

||||

授权 `build-robot` 这个 ServiceAccount 读取 build 命名空间中 Pod 的信息和 log 的权限:

|

||||

|

||||

``` yaml

|

||||

apiVersion: v1

|

||||

kind: ServiceAccount

|

||||

metadata:

|

||||

name: build-robot

|

||||

namespace: build

|

||||

|

||||

---

|

||||

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: Role

|

||||

metadata:

|

||||

namespace: build

|

||||

name: pod-reader

|

||||

rules:

|

||||

- apiGroups: [""]

|

||||

resources: ["pods", "pods/log"]

|

||||

verbs: ["get", "list"]

|

||||

|

||||

---

|

||||

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: RoleBinding

|

||||

metadata:

|

||||

name: read-pods

|

||||

namespace: build

|

||||

subjects:

|

||||

- kind: ServiceAccount

|

||||

name: build-robot

|

||||

namespace: build

|

||||

roleRef:

|

||||

kind: Role

|

||||

name: pod-reader

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

```

|

||||

|

||||

### ServiceAccount 最高权限

|

||||

|

||||

```yaml

|

||||

apiVersion: v1

|

||||

kind: ServiceAccount

|

||||

metadata:

|

||||

name: cluster-admin

|

||||

namespace: kube-system

|

||||

|

||||

---

|

||||

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: cluster-admin

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["*"]

|

||||

|

||||

---

|

||||

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRoleBinding

|

||||

metadata:

|

||||

name: cluster-admin

|

||||

subjects:

|

||||

- kind: ServiceAccount

|

||||

name: cluster-admin

|

||||

namespace: kube-system

|

||||

roleRef:

|

||||

kind: ClusterRole

|

||||

name: cluster-admin

|

||||

apiGroup: rbac.authorization.k8s.io

|

||||

```

|

||||

|

|

@ -0,0 +1,254 @@

|

|||

# 灵活调节 HPA 扩缩容速率

|

||||

## HPA v2beta2 版本开始支持调节扩缩容速率

|

||||

|

||||

在 K8S 1.18 之前,HPA 扩容是无法调整灵敏度的:

|

||||

|

||||

1. 对于缩容,由 `kube-controller-manager` 的 `--horizontal-pod-autoscaler-downscale-stabilization-window` 参数控制缩容时间窗口,默认 5 分钟,即负载减小后至少需要等 5 分钟才会缩容。

|

||||

2. 对于扩容,由 hpa controller 固定的算法、硬编码的常量因子来控制扩容速度,无法自定义。

|

||||

|

||||

这样的设计逻辑导致用户无法自定义 HPA 的扩缩容速率,而不同的业务场景对于扩容容灵敏度要求可能是不一样的,比如:

|

||||

|

||||

1. 对于有流量突发的关键业务,在需要的时候应该快速扩容 (即便可能不需要,以防万一),但缩容要慢 (防止另一个流量高峰)。

|

||||

2. 处理关键数据的应用,数据量飙升时它们应该尽快扩容以减少数据处理时间,数据量降低时应尽快缩小规模以降低成本,数据量的短暂抖动导致不必要的频繁扩缩是可以接受的。

|

||||

3. 处理常规数据/网络流量的业务,不是很重要,它们可能会以一般的方式扩大和缩小规模,以减少抖动。

|

||||

|

||||

HPA 在 K8S 1.18 迎来了一次更新,在之前 v2beta2 版本上新增了扩缩容灵敏度的控制,不过版本号依然保持 v2beta2 不变。

|

||||

## 原理与误区

|

||||

|

||||

HPA 在进行扩缩容时,先是由固定的算法计算出期望副本数:

|

||||

|

||||

```txt

|

||||

期望副本数 = ceil[当前副本数 * (当前指标 / 期望指标)]

|

||||

```

|

||||

|

||||

其中 `当前指标 / 期望指标` 的比例如果接近 1 (在容忍度范围内,默认为 0.1,即比例在 0.9~1.1 之间),则不进行伸缩,避免抖动导致频繁扩缩容。

|

||||

|

||||

> 容忍度是由 `kube-controller-manager` 参数 `--horizontal-pod-autoscaler-tolerance` 决定,默认是 0.1,即 10%。

|

||||

|

||||

本文要介绍的扩缩容速率调节,不是指要调整期望副本数的算法,它并不会加大或缩小扩缩容比例或数量,仅仅是控制扩缩容的速率,实现的效果是: 控制 HPA 在 XX 时间内最大允许扩容/缩容 XX 比例/数量的 Pod。

|

||||

|

||||

## 如何使用

|

||||

|

||||

这次更新实际就是在 HPA Spec 下新增了一个 `behavior` 字段,下面有 `scaleUp` 和 `scaleDown` 两个字段分别控制扩容和缩容的行为,具体可参考 [官方 API 文档](https://kubernetes.io/docs/reference/generated/kubernetes-api/v1.24/#hpascalingrules-v2beta2-autoscaling)。

|

||||

|

||||

使用示例:

|

||||

```yaml

|

||||

apiVersion: autoscaling/v2beta2

|

||||

kind: HorizontalPodAutoscaler

|

||||

metadata:

|

||||

name: web

|

||||

spec:

|

||||

minReplicas: 1

|

||||

maxReplicas: 1000

|

||||

metrics:

|

||||

- pods:

|

||||

metric:

|

||||

name: k8s_pod_rate_cpu_core_used_limit

|

||||

target:

|

||||

averageValue: "80"

|

||||

type: AverageValue

|

||||

type: Pods

|

||||

scaleTargetRef:

|

||||

apiVersion: apps/v1

|

||||

kind: Deployment

|

||||

name: web

|

||||

behavior: # 这里是重点

|

||||

scaleDown:

|

||||

stabilizationWindowSeconds: 300 # 需要缩容时,先观察 5 分钟,如果一直持续需要缩容才执行缩容

|

||||

policies:

|

||||

- type: Percent

|

||||

value: 100 # 允许全部缩掉

|

||||

periodSeconds: 15

|

||||

scaleUp:

|

||||

stabilizationWindowSeconds: 0 # 需要扩容时,立即扩容

|

||||

policies:

|

||||

- type: Percent

|

||||

value: 100

|

||||

periodSeconds: 15 # 每 15s 最大允许扩容当前 1 倍数量的 Pod

|

||||

- type: Pods

|

||||

value: 4

|

||||

periodSeconds: 15 # 每 15s 最大允许扩容 4 个 Pod

|

||||

selectPolicy: Max # 使用以上两种扩容策略中算出来扩容 Pod 数量最大的

|

||||

```

|

||||

|

||||

* 以上 `behavior` 配置是默认的,即如果不配置,会默认加上。

|

||||

* `scaleUp` 和 `scaleDown` 都可以配置1个或多个策略,最终扩缩时用哪个策略,取决于 `selectPolicy`。

|

||||

* `selectPolicy` 默认是 `Max`,即扩缩时,评估多个策略算出来的结果,最终选取扩缩 Pod 数量最多的那个策略的结果。

|

||||

* `stabilizationWindowSeconds` 是稳定窗口时长,即需要指标高于或低于阈值,并持续这个窗口的时长才会真正执行扩缩,以防止抖动导致频繁扩缩容。扩容时,稳定窗口默认为0,即立即扩容;缩容时,稳定窗口默认为5分钟。

|

||||

* `policies` 中定义扩容或缩容策略,`type` 的值可以是 `Pods` 或 `Percent`,表示每 `periodSeconds` 时间范围内,允许扩缩容的最大副本数或比例。

|

||||

|

||||

|

||||

## 场景与示例

|

||||

|

||||

下面给出一些使用场景的示例。

|

||||

### 快速扩容

|

||||

|

||||

当你的应用需要快速扩容时,可以使用类似如下的 HPA 配置:

|

||||

|

||||

```yaml

|

||||

behavior:

|

||||

scaleUp:

|

||||

policies:

|

||||

- type: Percent

|

||||

value: 900

|

||||

periodSeconds: 15 # 每 15s 最多允许扩容 9 倍于当前副本数

|

||||

```

|

||||

|

||||

上面的配置表示扩容时最大一次性新增当前 9 倍数量的副本数,当然也不能超过 `maxReplicas` 的限制。

|

||||

|

||||

假如一开始只有 1 个 Pod,如果遭遇流量突发,且指标持续超阈值 9 倍以上,它将以飞快的速度进行扩容,扩容时 Pod 数量变化趋势如下:

|

||||

|

||||

```txt

|

||||

1 -> 10 -> 100 -> 1000

|

||||

```

|

||||

|

||||

没有配置缩容策略,将等待全局默认的缩容时间窗口 (默认5分钟) 后开始缩容。

|

||||

|

||||

### 快速扩容,缓慢缩容

|

||||

|

||||

如果流量高峰过了,并发量骤降,如果用默认的缩容策略,等几分钟后 Pod 数量也会随之骤降,如果 Pod 缩容后突然又来一个流量高峰,虽然可以快速扩容,但扩容的过程毕竟还是需要一定时间的,如果流量高峰足够高,在这段时间内还是可能造成后端处理能力跟不上,导致部分请求失败。这时候我们可以为 HPA 加上缩容策略,HPA `behavior` 配置示例如下:

|

||||

|

||||

```yaml

|

||||

behavior:

|

||||

scaleUp:

|

||||

policies:

|

||||

- type: Percent

|

||||

value: 900

|

||||

periodSeconds: 15 # 每 15s 最多允许扩容 9 倍于当前副本数

|

||||

scaleDown:

|

||||

policies:

|

||||

- type: Pods

|

||||

value: 1

|

||||

periodSeconds: 600 # 每 10 分钟最多只允许缩掉 1 个 Pod

|

||||

```

|

||||

|

||||

上面示例中增加了 `scaleDown` 的配置,指定缩容时每 10 分钟才缩掉 1 个 Pod,大大降低了缩容速度,缩容时的 Pod 数量变化趋势如下:

|

||||

|

||||

```txt

|

||||

1000 -> … (10 min later) -> 999

|

||||

```

|

||||

|

||||

这个可以让关键业务在可能有流量突发的情况下保持处理能力,避免流量高峰导致部分请求失败。

|

||||

|

||||

### 缓慢扩容

|

||||

|

||||

如果想要你的应用不太关键,希望扩容时不要太敏感,可以让它扩容平稳缓慢一点,为 HPA 加入下面的 `behavior`:

|

||||

|

||||

```yaml

|

||||

behavior:

|

||||

scaleUp:

|

||||

policies:

|

||||

- type: Pods

|

||||

value: 1

|

||||

periodSeconds: 300 # 每 5 分钟最多只允许扩容 1 个 Pod

|

||||

```

|

||||

|

||||

假如一开始只有 1 个 Pod,指标一直持续超阈值,扩容时它的 Pod 数量变化趋势如下:

|

||||

|

||||

```txt

|

||||

1 -> 2 -> 3 -> 4

|

||||

```

|

||||

|

||||

### 禁止自动缩容

|

||||

|

||||

如果应用非常关键,希望扩容后不自动缩容,需要人工干预或其它自己开发的 controller 来判断缩容条件,可以使用类型如下的 `behavior` 配置来禁止自动缩容:

|

||||

|

||||

```yaml

|

||||

behavior:

|

||||

scaleDown:

|

||||

selectPolicy: Disabled

|

||||

```

|

||||

|

||||

### 延长缩容时间窗口

|

||||

|

||||

缩容默认时间窗口是 5 分钟,如果我们需要延长时间窗口以避免一些流量毛刺造成的异常,可以指定下缩容的时间窗口,`behavior` 配置示例如下:

|

||||

|

||||

```yaml

|

||||

behavior:

|

||||

scaleDown:

|

||||

stabilizationWindowSeconds: 600 # 等待 10 分钟再开始缩容

|

||||

policies:

|

||||

- type: Pods

|

||||

value: 5

|

||||

periodSeconds: 600 # 每 10 分钟最多只允许缩掉 5 个 Pod

|

||||

```

|

||||

|

||||

上面的示例表示当负载降下来时,会等待 600s (10 分钟) 再缩容,每 10 分钟最多只允许缩掉 5 个 Pod。

|

||||

|

||||

### 延长扩容时间窗口

|

||||

|

||||

有些应用经常会有数据毛刺导致频繁扩容,而扩容出来的 Pod 其实没太大必要,反而浪费资源。比如数据处理管道的场景,需要的副本数取决于队列中的事件数量,当队列中堆积了大量事件时,我们希望可以快速扩容,但又不希望太灵敏,因为可能只是短时间内的事件堆积,即使不扩容也可以很快处理掉。

|

||||

|

||||

默认的扩容算法会在较短的时间内扩容,针对这种场景我们可以给扩容增加一个时间窗口以避免毛刺导致扩容带来的资源浪费,`behavior` 配置示例如下:

|

||||

|

||||

```yaml

|

||||

behavior:

|

||||

scaleUp:

|

||||

stabilizationWindowSeconds: 300 # 扩容前等待 5 分钟的时间窗口

|

||||

policies:

|

||||

- type: Pods

|

||||

value: 20

|

||||

periodSeconds: 60 # 每分钟最多只允许扩容 20 个 Pod

|

||||

```

|

||||

|

||||

上面的示例表示扩容时,需要先等待 5 分钟的时间窗口,如果在这段时间内指标又降下来了就不再扩容,如果一直持续超过阈值才扩容,并且每分钟最多只允许扩容 20 个 Pod。

|

||||

|

||||

## FAQ

|

||||

|

||||

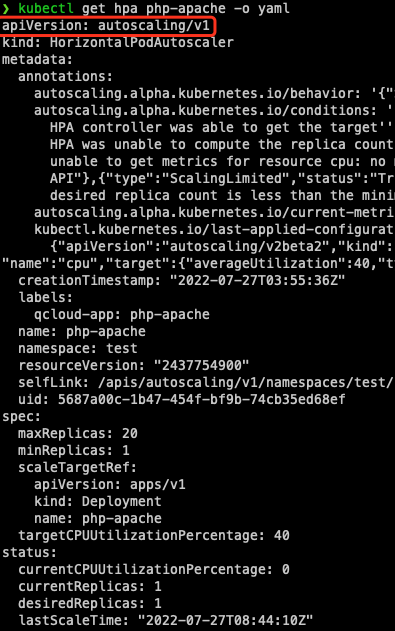

### 为什么我用 v2beta2 创建的 HPA,创建后获取到的 yaml 版本是 v1 或 v2beta1?

|

||||

|

||||

|

||||

|

||||

这是因为 HPA 有多个 apiVersion 版本:

|

||||

|

||||

```bash

|

||||

kubectl api-versions | grep autoscaling

|

||||

autoscaling/v1

|

||||

autoscaling/v2beta1

|

||||

autoscaling/v2beta2

|

||||

```

|

||||

|

||||

以任意一种版本创建,都可以以任意版本获取(自动转换)。

|

||||

|

||||

如果是用 kubectl 获取,kubectl 在进行 API discovery 时,会缓存 apiserver 返回的各种资源与版本信息,有些资源存在多个版本,在 get 时如果不指定版本,会使用默认版本获取,对于 HPA,默认是 v1。

|

||||

|

||||

如果是通过一些平台的界面获取,取决于平台的实现方式,比如腾讯云容器服务控制台,默认用 v2beta1 版本展示:

|

||||

|

||||

|

||||

|

||||

如何使用 v2beta2 版本获取或编辑?指定包含版本信息的完整资源名即可:

|

||||

|

||||

```bash

|

||||

kubectl get horizontalpodautoscaler.v2beta2.autoscaling php-apache -o yaml

|

||||

# kubectl edit horizontalpodautoscaler.v2beta2.autoscaling php-apache

|

||||

```

|

||||

|

||||

### 配置快速扩容,为什么快不起来?

|

||||

|

||||

比如这个配置:

|

||||

|

||||

```yaml

|

||||

behavior:

|

||||

scaleUp:

|

||||

policies:

|

||||

- type: Percent

|

||||

value: 900

|

||||

periodSeconds: 10

|

||||

```

|

||||

|

||||

含义是允许每 10 秒最大允许扩出 9 倍于当前数量的 Pod,实测中可能发现压力已经很大了,但扩容却并不快。

|

||||

|

||||

通常原因是计算周期与指标延时:

|

||||

* 期望副本数的计算有个计算周期,默认是 15 秒 (由 `kube-controller-manager` 的 `--horizontal-pod-autoscaler-sync-period` 参数决定)。

|

||||

* 每次计算时,都会通过相应的 metrics API 去获取当前监控指标的值,这个返回的值通常不是实时的,对于腾讯云容器服务而言,监控数据是每分钟上报一次;对于自建的 prometheus + prometheus-adapter 而言,监控数据的更新取决于监控数据抓取间隔,prometheus-adapter 的 `--metrics-relist-interval` 参数决定监控指标刷新周期(从 prometheus 中查询),这两部分时长之和为监控数据更新的最长时间。

|

||||

|

||||

通常都不需要 HPA 极度的灵敏,有一定的延时一般都是可以接受的。如果实在有对灵敏度特别敏感的场景,可以考虑使用 prometheus,缩小监控指标抓取间隔和 prometheus-adapter 的 `--metrics-relist-interval`。

|

||||

|

||||

## 小结

|

||||

|

||||

本文介绍了如何利用 HPA 的新特性来控制扩缩容的速率,以更好的满足各种不同场景对扩容速度的需求,也提供了常见的几种场景与配置示例,可自行根据自己需求对号入座。

|

||||

|

||||

## 参考资料

|

||||

|

||||

* [HPA 官方介绍文档](https://kubernetes.io/zh-cn/docs/tasks/run-application/horizontal-pod-autoscale/)

|

||||

* [控制 HPA 扩容速度的提案](https://github.com/kubernetes/enhancements/tree/master/keps/sig-autoscaling/853-configurable-hpa-scale-velocity)

|

||||

|

|

@ -0,0 +1,312 @@

|

|||

# HPA 使用自定义指标进行伸缩

|

||||

|

||||

Kubernetes 默认提供 CPU 和内存作为 HPA 弹性伸缩的指标,如果有更复杂的场景需求,比如基于业务单副本 QPS 大小来进行自动扩缩容,可以考虑自行安装 [prometheus-adapter](https://github.com/DirectXMan12/k8s-prometheus-adapter) 来实现基于自定义指标的 Pod 弹性伸缩。

|

||||

|

||||

## 实现原理

|

||||

|

||||

Kubernetes 提供了 [Custom Metrics API](https://github.com/kubernetes/community/blob/master/contributors/design-proposals/instrumentation/custom-metrics-api.md) 与 [External Metrics API](https://github.com/kubernetes/community/blob/master/contributors/design-proposals/instrumentation/external-metrics-api.md) 来对 HPA 的指标进行扩展,让用户能够根据实际需求进行自定义。

|

||||

|

||||

prometheus-adapter 对这两种 API 都有支持,通常使用 Custom Metrics API 就够了,本文也主要针对此 API 来实现使用自定义指标进行弹性伸缩。

|

||||

|

||||

## 前提条件

|

||||

|

||||

* 部署有 Prometheus 并做了相应的自定义指标采集。

|

||||

* 已安装 [helm](https://helm.sh/docs/intro/install/) 。

|

||||

|

||||

## 业务暴露监控指标

|

||||

|

||||

这里以一个简单的 golang 业务程序为例,暴露 HTTP 请求的监控指标:

|

||||

|

||||

``` go

|

||||

package main

|

||||

|

||||

import (

|

||||

"github.com/prometheus/client_golang/prometheus"

|

||||

"github.com/prometheus/client_golang/prometheus/promhttp"

|

||||

"net/http"

|

||||

"strconv"

|

||||

)

|

||||

|

||||

var (

|

||||

HTTPRequests = prometheus.NewCounterVec(

|

||||

prometheus.CounterOpts{

|

||||

Name: "httpserver_requests_total",

|

||||

Help: "Number of the http requests received since the server started",

|

||||

},

|

||||

[]string{"status"},

|

||||

)

|

||||

)

|

||||

|

||||

func init() {

|

||||

prometheus.MustRegister(HTTPRequests)

|

||||

}

|

||||

|

||||

func main() {

|

||||

http.HandleFunc("/", func(w http.ResponseWriter, r *http.Request) {

|

||||

path := r.URL.Path

|

||||

code := 200

|

||||

switch path {

|

||||

case "/test":

|

||||

w.WriteHeader(200)

|

||||

w.Write([]byte("OK"))

|

||||

case "/metrics":

|

||||

promhttp.Handler().ServeHTTP(w, r)

|

||||

default:

|

||||

w.WriteHeader(404)

|

||||

w.Write([]byte("Not Found"))

|

||||

}

|

||||

HTTPRequests.WithLabelValues(strconv.Itoa(code)).Inc()

|

||||

})

|

||||

http.ListenAndServe(":80", nil)

|

||||

}

|

||||

```

|

||||

|

||||

该示例程序暴露了 `httpserver_requests_total` 指标,记录 HTTP 的请求,通过这个指标可以计算出该业务程序的 QPS 值。

|

||||

|

||||

## 部署业务程序

|

||||

|

||||

将前面的程序打包成容器镜像,然后部署到集群,比如使用 Deployment 部署:

|

||||

|

||||

``` yaml

|

||||

apiVersion: apps/v1

|

||||

kind: Deployment

|

||||

metadata:

|

||||

name: httpserver

|

||||

namespace: httpserver

|

||||

spec:

|

||||

replicas: 1

|

||||

selector:

|

||||

matchLabels:

|

||||

app: httpserver

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

app: httpserver

|

||||

spec:

|

||||

containers:

|

||||

- name: httpserver

|

||||

image: registry.imroc.cc/test/httpserver:custom-metrics

|

||||

imagePullPolicy: Always

|

||||

|

||||

---

|

||||

|

||||

apiVersion: v1

|

||||

kind: Service

|

||||

metadata:

|

||||

name: httpserver

|

||||

namespace: httpserver

|

||||

labels:

|

||||

app: httpserver

|

||||

annotations:

|

||||

prometheus.io/scrape: "true"

|

||||

prometheus.io/path: "/metrics"

|

||||

prometheus.io/port: "http"

|

||||

spec:

|

||||

type: ClusterIP

|

||||

ports:

|

||||

- port: 80

|

||||

protocol: TCP

|

||||

name: http

|

||||

selector:

|

||||

app: httpserver

|

||||

```

|

||||

|

||||

## Prometheus 采集业务监控

|

||||

|

||||

业务部署好了,我们需要让我们的 Promtheus 去采集业务暴露的监控指标。

|

||||

|

||||

### 方式一: 配置 Promtheus 采集规则

|

||||

|

||||

在 Promtheus 的采集规则配置文件添加采集规则:

|

||||

|

||||

``` yaml

|

||||

- job_name: httpserver

|

||||

scrape_interval: 5s

|

||||

kubernetes_sd_configs:

|

||||

- role: endpoints

|

||||

namespaces:

|

||||

names:

|

||||

- httpserver

|

||||

relabel_configs:

|

||||

- action: keep

|

||||

source_labels:

|

||||

- __meta_kubernetes_service_label_app

|

||||

regex: httpserver

|

||||

- action: keep

|

||||

source_labels:

|

||||

- __meta_kubernetes_endpoint_port_name

|

||||

regex: http

|

||||

```

|

||||

|

||||

### 方式二: 配置 ServiceMonitor

|

||||

|

||||

若已安装 prometheus-operator,则可通过创建 ServiceMonitor 的 CRD 对象配置 Prometheus。示例如下:

|

||||

|

||||

``` yaml

|

||||

apiVersion: monitoring.coreos.com/v1

|

||||

kind: ServiceMonitor

|

||||

metadata:

|

||||

name: httpserver

|

||||

spec:

|

||||

endpoints:

|

||||

- port: http

|

||||

interval: 5s

|

||||

namespaceSelector:

|

||||

matchNames:

|

||||

- httpserver

|

||||

selector:

|

||||

matchLabels:

|

||||

app: httpserver

|

||||

```

|

||||

|

||||

## 安装 prometheus-adapter

|

||||

|

||||

我们使用 helm 安装 [prometheus-adapter](https://artifacthub.io/packages/helm/prometheus-community/prometheus-adapter),安装前最重要的是确定并配置自定义指标,按照前面的示例,我们业务中使用 `httpserver_requests_total` 这个指标来记录 HTTP 请求,那么我们可以通过类似下面的 PromQL 计算出每个业务 Pod 的 QPS 监控:

|

||||

|

||||

```

|

||||

sum(rate(http_requests_total[2m])) by (pod)

|

||||

```

|

||||

|

||||

我们需要将其转换为 prometheus-adapter 的配置,准备一个 `values.yaml`:

|

||||

|

||||

``` yaml

|

||||

rules:

|

||||

default: false

|

||||

custom:

|

||||

- seriesQuery: 'httpserver_requests_total'

|

||||

resources:

|

||||

template: <<.Resource>>

|

||||

name:

|

||||

matches: "httpserver_requests_total"

|

||||

as: "httpserver_requests_qps" # PromQL 计算出来的 QPS 指标

|

||||

metricsQuery: sum(rate(<<.Series>>{<<.LabelMatchers>>}[1m])) by (<<.GroupBy>>)

|

||||

prometheus:

|

||||

url: http://prometheus.monitoring.svc.cluster.local # 替换 Prometheus API 的地址 (不写端口)

|

||||

port: 9090u

|

||||

```

|

||||

|

||||

执行 helm 命令进行安装:

|

||||

|

||||

``` bash

|

||||

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

|

||||

helm repo update

|

||||

# Helm 3

|

||||

helm install prometheus-adapter prometheus-community/prometheus-adapter -f values.yaml

|

||||

# Helm 2

|

||||

# helm install --name prometheus-adapter prometheus-community/prometheus-adapter -f values.yaml

|

||||

```

|

||||

|

||||

## 测试是否安装正确

|

||||

|

||||

如果安装正确,是可以看到 Custom Metrics API 返回了我们配置的 QPS 相关指标:

|

||||

|

||||

``` bash

|

||||

$ kubectl get --raw /apis/custom.metrics.k8s.io/v1beta1

|

||||

{

|

||||

"kind": "APIResourceList",

|

||||

"apiVersion": "v1",

|

||||

"groupVersion": "custom.metrics.k8s.io/v1beta1",

|

||||

"resources": [

|

||||

{

|

||||

"name": "jobs.batch/httpserver_requests_qps",

|

||||

"singularName": "",

|

||||

"namespaced": true,

|

||||

"kind": "MetricValueList",

|

||||

"verbs": [

|

||||

"get"

|

||||

]

|

||||

},

|

||||

{

|

||||

"name": "pods/httpserver_requests_qps",

|

||||

"singularName": "",

|

||||

"namespaced": true,

|

||||

"kind": "MetricValueList",

|

||||

"verbs": [

|

||||

"get"

|

||||

]

|

||||

},

|

||||

{

|

||||

"name": "namespaces/httpserver_requests_qps",

|

||||

"singularName": "",

|

||||

"namespaced": false,

|

||||

"kind": "MetricValueList",

|

||||

"verbs": [

|

||||

"get"

|

||||

]

|

||||

}

|

||||

]

|

||||

}

|

||||

```

|

||||

|

||||

也能看到业务 Pod 的 QPS 值:

|

||||

|

||||

``` bash

|

||||

$ kubectl get --raw /apis/custom.metrics.k8s.io/v1beta1/namespaces/httpserver/pods/*/httpserver_requests_qps

|

||||

{

|

||||

"kind": "MetricValueList",

|

||||

"apiVersion": "custom.metrics.k8s.io/v1beta1",

|

||||

"metadata": {

|

||||

"selfLink": "/apis/custom.metrics.k8s.io/v1beta1/namespaces/httpserver/pods/%2A/httpserver_requests_qps"

|

||||

},

|

||||

"items": [

|

||||

{

|

||||

"describedObject": {

|

||||

"kind": "Pod",

|

||||

"namespace": "httpserver",

|

||||

"name": "httpserver-6f94475d45-7rln9",

|

||||

"apiVersion": "/v1"

|

||||

},

|

||||

"metricName": "httpserver_requests_qps",

|

||||

"timestamp": "2020-11-17T09:14:36Z",

|

||||

"value": "500m",

|

||||

"selector": null

|

||||

}

|

||||

]

|

||||

}

|

||||

```

|

||||

|

||||

> 上面示例 QPS 为 `500m`,表示 QPS 值为 0.5

|

||||

|

||||

## 测试 HPA

|

||||

|

||||

假如我们设置每个业务 Pod 的平均 QPS 达到 50,就触发扩容,最小副本为 1 个,最大副本为1000,HPA 可以这么配置:

|

||||

|

||||

``` yaml

|

||||

apiVersion: autoscaling/v2beta2

|

||||

kind: HorizontalPodAutoscaler

|

||||

metadata:

|

||||

name: httpserver

|

||||

namespace: httpserver

|

||||

spec:

|

||||

minReplicas: 1

|

||||

maxReplicas: 1000

|

||||

scaleTargetRef:

|

||||

apiVersion: apps/v1

|

||||

kind: Deployment

|

||||

name: httpserver

|

||||

metrics:

|

||||

- type: Pods

|

||||

pods:

|

||||

metric:

|

||||

name: httpserver_requests_qps

|

||||

target:

|

||||

averageValue: 50

|

||||

type: AverageValue

|

||||

```

|

||||

|

||||

然后对业务进行压测,观察是否扩容:

|

||||

|

||||

``` bash

|

||||

$ kubectl get hpa

|

||||

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE

|

||||

httpserver Deployment/httpserver 83933m/50 1 1000 2 18h

|

||||

|

||||

$ kubectl get pods

|

||||

NAME READY STATUS RESTARTS AGE

|

||||

httpserver-6f94475d45-47d5w 1/1 Running 0 3m41s

|

||||

httpserver-6f94475d45-7rln9 1/1 Running 0 37h

|

||||

httpserver-6f94475d45-6c5xm 0/1 ContainerCreating 0 1s

|

||||

httpserver-6f94475d45-wl78d 0/1 ContainerCreating 0 1s

|

||||

```

|

||||

|

||||

扩容正常则说明已经实现 HPA 基于业务自定义指标进行弹性伸缩。

|

||||

|

|

@ -0,0 +1,109 @@

|

|||

# 健康检查配置

|

||||

|

||||

> 本文视频教程: [https://www.bilibili.com/video/BV16q4y1y7B9](https://www.bilibili.com/video/BV16q4y1y7B9)

|

||||

|

||||

本文分享 K8S 健康检查配置的最佳实践,文末也分享配置不当的案例。

|

||||

|

||||

## Kubernetes 健康检查介绍

|

||||

|

||||

K8S 支持三种健康检查:

|

||||

1. 就绪检查(`readinessProbe`): Pod启动后,如果配了就绪检查,要等就绪检查探测成功,Pod Ready 状态变为 True,允许放流量进来;在运行期间如果突然探测失败,Ready 状态变为 False,摘除流量。

|

||||

2. 存活检查(`livenessProbe`): Pod 在运行时,如果存活检查探测失败,会自动重启容器;值得注意的是,存活探测的结果不影响 Pod 的 Ready 状态,这也是许多同学可能误解的地方。

|

||||

3. 启动检查(`startupProbe`): 作用是让存活检查和就绪检查的开始探测时间延后,等启动检查成功后再开始探测,通常用于避免业务进程启动慢导致存活检查失败而被无限重启。

|

||||

|

||||

三种健康检查配置格式都是一样的,以 `readinessProbe` 为例:

|

||||

|

||||

```yaml

|

||||

readinessProbe:

|

||||

successThreshold: 1 # 1 次探测成功就认为健康

|

||||

failureThreshold: 2 # 连续 2 次探测失败认为不健康

|

||||

periodSeconds: 3 # 3s 探测一次

|

||||

timeoutSeconds: 2 # 2s 超时还没返回成功就认为不健康

|

||||

httpGet: # 使用 http 接口方式探测,GET 请求 80 端口的 "/healthz" 这个 http 接口,响应状态码在200~399之间视为健康,否则不健康。

|

||||

port: 80

|

||||

path: "/healthz"

|

||||

#exec: # 使用脚本探测,执行容器内 "/check-health.sh" 这个脚本文件,退出状态码等于0视为健康,否则不健康。

|

||||

# command: ["/check-health.sh"]

|

||||

#tcp: # 使用 TCP 探测,看 9000 端口是否监听。

|

||||

# port: 9000

|

||||

```

|

||||

|

||||

## 探测结果一定要真实反应业务健康状态

|

||||

|

||||

### 首选 HTTP 探测

|

||||

|

||||

通常是推荐业务自身提供 http 探测接口,如果业务层面健康就返回 200 状态码;否则,就返回 500。

|

||||

|

||||

### 备选脚本探测

|

||||

|

||||

如果业务还不支持 http 探测接口,或者有探测接口但不是 http 协议,也可以将探测逻辑写到脚本文件里,然后配置脚本方式探测。

|

||||

|

||||

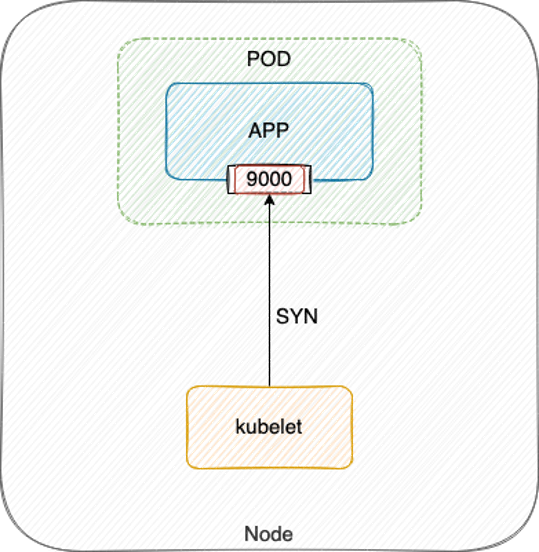

### 尽量避免 TCP 探测

|

||||

|

||||

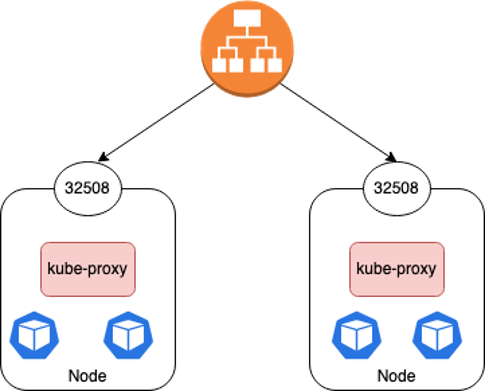

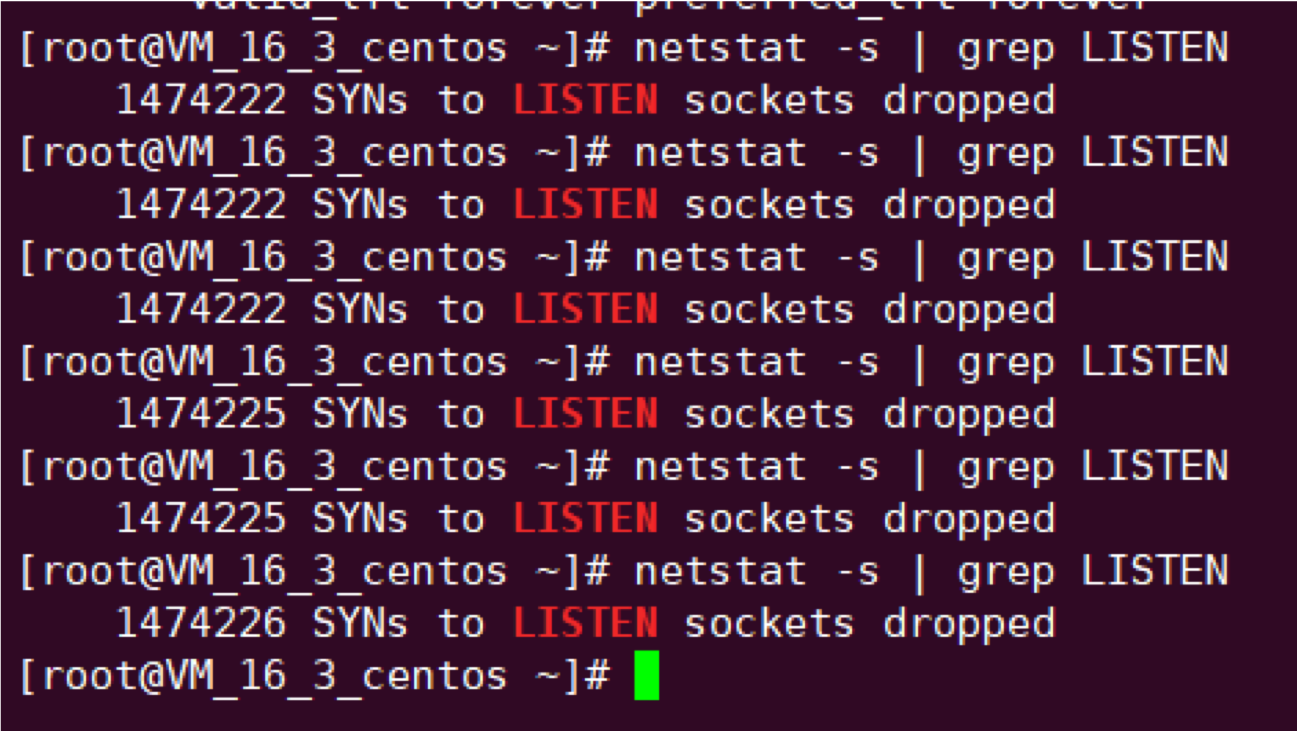

另外,应尽量避免使用 TCP 探测,因为 TCP 探测实际就是 kubelet 向指定端口发送 TCP SYN 握手包,当端口被监听内核就会直接响应 ACK,探测就会成功:

|

||||

|

||||

|

||||

|

||||

当程序死锁或 hang 死,这些并不影响端口监听,所以探测结果还是健康,流量打到表面健康但实际不健康的 Pod 上,就无法处理请求,从而引发业务故障。

|

||||

|

||||

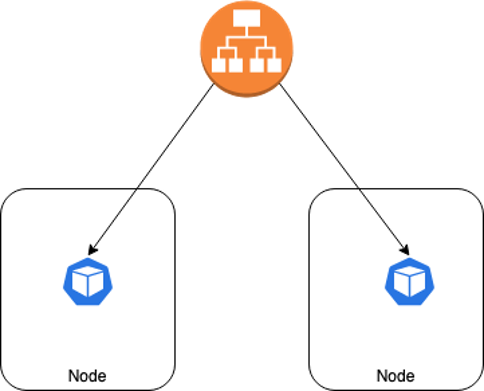

## 所有提供服务的 container 都要加上 ReadinessProbe

|

||||

|

||||

如果你的容器对外提供了服务,监听了端口,那么都应该配上 ReadinessProbe,ReadinessProbe 不通过就视为 Pod 不健康,然后会自动将不健康的 Pod 踢出去,避免将业务流量转发给异常 Pod。

|

||||

|

||||

|

||||

|

||||

## 谨慎使用 LivenessProbe

|

||||

|

||||

LivenessProbe 失败会重启 Pod,不要轻易使用,除非你了解后果并且明白为什么你需要它,参考 [Liveness Probes are Dangerous](https://srcco.de/posts/kubernetes-liveness-probes-are-dangerous.html) 。

|

||||

|

||||

### 探测条件要更宽松

|

||||

|

||||

如果使用 LivenessProbe,不要和 ReadinessProbe 设置成一样,需要更宽松一点,避免因抖动导致 Pod 频繁被重启。

|

||||

|

||||

通常是失败阈值 (`failureThreshold`) 设置得更大一点,避免因探测太敏感导致 Pod 很容易被重启。

|

||||

|

||||

另外如果有必要,超时时间 (`timeoutSeconds`) 和探测间隔 (`periodSeconds`) 也可以根据情况适当延长。

|

||||

|

||||

### 保护慢启动容器

|

||||

|

||||

有些应用本身可能启动慢(比如 Java),或者用的富容器,需要起一大堆依赖,导致容器启动需要的较长,如果配置了存活检查,可能会造成启动过程中达到失败阈值被重启,如此循环,无限重启。

|

||||

|

||||

对于这类启动慢的容器,我们需要保护下,等待应用完全启动后才开始探测:

|

||||

|

||||

1. 如果 K8S 版本低于 1.18,可以设置 LivenessProbe 的初始探测延时 (`initialDelaySeconds`)。

|

||||

2. 如果 K8S 版本在 1.18 及其以上,可以配置 [StartProbe](https://kubernetes.io/docs/tasks/configure-pod-container/configure-liveness-readiness-startup-probes/#define-startup-probes),保证等应用完全启动后才开始探测。

|

||||

|

||||

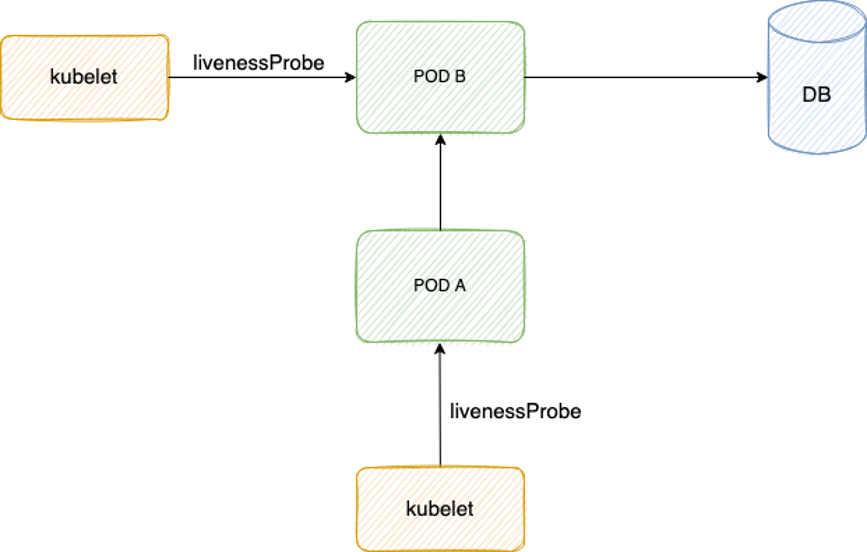

### 避免依赖导致级联故障

|

||||

|

||||

LivenessProbe 探测逻辑里不要有外部依赖 (db, 其它 pod 等),避免抖动导致级联故障。

|

||||

|

||||

|

||||

|

||||

如上图,Pod B 探测逻辑里查 DB,Pod A 探测逻辑里调用 Pod B,如果 DB 抖动,Pod B 变为不健康,Pod A 调用 Pod B 也失败,也变为不健康,从而级联故障。

|

||||

|

||||

## 反面教材

|

||||

|

||||

### 突然无限重启且流量异常

|

||||

|

||||

故障现象: Pod 突然不断重启,期间有流量进入,这部分流量异常。

|

||||

|

||||

原因:

|

||||

1. Pod 之前所在节点异常,重建漂移到了其它节点去启动。

|

||||

2. Pod 重建后由于基础镜像中依赖的一个服务有问题导致启动较慢,因为同时配置了 ReadinessProbe 与 LivenessProbe,大概率是启动时所有健康检查都失败,达到 LivenessProbe 失败次数阈值,又被重启。

|

||||

3. Pod 配置了 preStop 实现优雅终止,被重启前会先执行 preStop,优雅终止的时长较长,preStop 期间 ReadinessProbe 还会继续探测。

|

||||

4. 探测方式使用的 TCP 探测,进程优雅终止过程中 TCP 探测仍然会成功(没完全退出前端口监听仍然存在),但实际此时进程已不会处理新请求了。

|

||||

5. LivenessProbe 结果不会影响 Pod Ready 状态,是否 Ready 主要取决于 ReadinessProbe 结果,由于 preStop 期间 ReadinessProbe 是成功的,Pod 就变 Ready 了。

|

||||

6. Pod Ready 但实际无法处理请求,业务就会异常。

|

||||

|

||||

总结:

|

||||

1. Pod 慢启动 + 存活探测 导致被无限重启。需要延长 `initialDelaySeconds` 或 [StartProbe](https://kubernetes.io/docs/tasks/configure-pod-container/configure-liveness-readiness-startup-probes/#define-startup-probes) 来保护慢启动容器。

|

||||

2. TCP 探测方式不能完全真实反应业务健康状态,导致在优雅终止过程中,ReadinessProbe 探测成功让流量放进来而业务却不会处理,导致流量异常。需要使用更好的探测方式,建议业务提供 HTTP 探活接口,使用 HTTP 探测业务真实健康状态。

|

||||

|

||||

### netstat 探测超时

|

||||

|

||||

故障现象: 探测脚本经常 2s 超时。

|

||||

|

||||

原因: 使用脚本探测,超时时间为 2s,脚本里使用了 netstat 检测端口是否存活来判断业务进程是否正常,当流量较大时,连接数多,netstat 运行所需时间就较长 (因为 netstat 会遍历 `/proc` 下每个 pid 内容来进行统计,执行时长受连接数波动所影响),所以在业务高峰时往往容易执行超时,从而探测失败。

|

||||

|

||||

总结: 这种探测方式比 TCP 探测方式更原始,强烈不推荐,参考最佳实践优化探测配置。

|

||||

|

||||

|

|

@ -0,0 +1,48 @@

|

|||

# 在容器中使用 crontab

|

||||

|

||||

## 准备 crontab 配置文件

|

||||

|

||||

新建一个名为 `crontab` 的配置文件,写定时任务规则:

|

||||

|

||||

```txt

|

||||

* * * * * echo "Crontab is working" > /proc/1/fd/1

|

||||

```

|

||||

|

||||

> `/proc/1/fd/1` 表示输出到容器主进程的标准输出,这样我们可以利用 `kubectl logs` 来查看到执行日志。

|

||||

|

||||

## 准备 Dockerfile

|

||||

|

||||

### CentOS 镜像

|

||||

|

||||

```dockerfile

|

||||

FROM docker.io/centos:7

|

||||

|

||||

RUN yum -y install crontabs && rm -rf /etc/cron.*/*

|

||||

|

||||

ADD crontab /etc/crontab

|

||||

RUN chmod 0644 /etc/crontab

|

||||

RUN crontab /etc/crontab

|

||||

|

||||

CMD ["crond", "-n"]

|

||||

```

|

||||

|

||||

### Ubuntu 镜像

|

||||

|

||||

```dockerfile

|

||||

FROM docker.io/ubuntu:20.04

|

||||

|

||||

RUN apt-get update && apt-get install -y cron && rm -rf /etc/cron.*/*

|

||||

|

||||

ADD crontab /etc/crontab

|

||||

RUN chmod 0644 /etc/crontab

|

||||

RUN crontab /etc/crontab

|

||||

|

||||

CMD ["cron", "-f", "-l", "2"]

|

||||

```

|

||||

|

||||

## 打包镜像

|

||||

|

||||

```bash

|

||||

docker build -t docker.io/imroc/crontab:latest -f Dockerfile .

|

||||

# podman build -t docker.io/imroc/crontab:latest -f Dockerfile .

|

||||

```

|

||||

|

|

@ -0,0 +1,47 @@

|

|||

# Go 应用容器化

|

||||

|

||||

## 使用多阶段构建编译

|

||||

|

||||

可以使用 golang 的官方镜像进行编译,建议使用静态编译,因为 golang 官方镜像默认使用的基础镜像是 debian,如果使用默认的编译,会依赖依赖一些动态链接库,当业务镜像使用了其它发行版基础镜像,且动态链接库不一样的话 (比如 alpine),就会导致程序启动时发现依赖的动态链接库找不到而无法启动:

|

||||

|

||||

```txt

|

||||

standard_init_linux.go:211: exec user process caused "no such file or directory"

|

||||

```

|

||||

|

||||

以下是多阶段构建静态编译 golang 程序的 Dockerfile 示例:

|

||||

|

||||

```Dockerfile

|

||||

FROM golang:latest as builder

|

||||

|

||||

COPY . /build

|

||||

|

||||

WORKDIR /build

|

||||

|

||||

RUN CGO_ENABLED=0 go build -trimpath -ldflags='-s -w -extldflags=-static' -o /app

|

||||

|

||||

FROM ubuntu:22.10

|

||||

|

||||

COPY --from=builder /app /

|

||||

|

||||

CMD ["/app"]

|

||||

```

|

||||

|

||||

如果希望最小化镜像,可以用空基础镜像,让镜像中只包含一个静态编译后 go 二进制:

|

||||

|

||||

```Dockerfile

|

||||

FROM golang:latest as builder

|

||||

|

||||

COPY . /build

|

||||

|

||||

WORKDIR /build

|

||||

|

||||

RUN CGO_ENABLED=0 go build -trimpath -ldflags='-s -w -extldflags=-static' -o /app

|

||||

|

||||

FROM scratch

|

||||

|

||||

COPY --from=builder /app /

|

||||

|

||||

CMD ["/app"]

|

||||

```

|

||||

|

||||

> 建议 k8s 1.23 及其以上版本使用 scratch 基础镜像,即使镜像中不包含 bash 等调试工具,也可以 [使用临时容器来进行调试](https://kubernetes.io/zh-cn/docs/tasks/debug/debug-application/debug-running-pod/#ephemeral-container)。

|

||||

|

|

@ -0,0 +1,141 @@

|

|||

# Java 应用容器化

|

||||

|

||||

本文介绍 Java 应用容器化相关注意事项。

|

||||

|

||||

## 避免低版本 JDK

|

||||

|

||||

JDK 低版本对容器不友好,感知不到自己在容器内:

|

||||

1. 不知道被分配了多少内存,很容易造成消耗过多内容而触发 Cgroup OOM 被杀死。

|

||||

2. 不知道被分配了多少 CPU,认为可用 CPU 数量就是宿主机的 CPU 数量,导致 JVM 创建过多线程,容易高负载被 Cgroup CPU 限流(throttle)。

|

||||

|

||||

在高版本的 JDK 中 (JDK10) 对容器进行了很好的支持,同时也 backport 到了低版本 (JDK8):

|

||||

1. 如果使用的 `Oracle JDK`,确保版本大于等于 `8u191`。

|

||||

2. 如果使用的 `OpenJDK`,确保版本大于等于 `8u212`。

|

||||

|

||||

## 常见问题

|

||||

|

||||

### 相同镜像在部分机器上跑有问题

|

||||

|

||||

* 现象: 经常会有人说,我的 java 容器镜像,在 A 机器上跑的好好的,在 B 机器上就有问题,都是用的同一个容器镜像啊。

|

||||

* 根因:java 类加载的顺序问题,如果有不同版本的重复 jar 包,只会加载其中一个,并且不保证顺序。

|

||||

* 解决方案:业务去掉重复的 jar 包。

|

||||

* 类似 case 的分析文章:[关于Jar加载顺序的问题分析](https://www.jianshu.com/p/dcad5330b06f)

|

||||

|

||||

### java 默认线程池的线程数问题

|

||||

|

||||

* 现象:java 应用创建大量线程。

|

||||

* 根因:低版本 jdk,无法正确识别 cgroup 的 limit,所以 cpu 的数量及内存的大小是直接从宿主机获取的,跟 cgroup 里的 limit 不一致。

|

||||

* 解决方案:业务升级 jdk 版本。

|

||||

|

||||

## 使用 Maven 构建 Java 容器镜像

|

||||

本文介绍如果在容器环境将 Maven 项目构建成 Java 容器镜像,完整示例源码请参考 Github [maven-docker-example](https://github.com/imroc/maven-docker-example)。

|

||||

|

||||

### pom.xml

|

||||

|

||||

以下是 maven `pom.xml` 示例:

|

||||

|

||||

```xml

|

||||

<?xml version="1.0" encoding="UTF-8"?>

|

||||

<project xmlns="http://maven.apache.org/POM/4.0.0"

|

||||

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

|

||||

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

|

||||

<modelVersion>4.0.0</modelVersion>

|

||||

|

||||

<groupId>org.example</groupId>

|

||||

<artifactId>http</artifactId>

|

||||

<version>1.0-SNAPSHOT</version>

|

||||

|

||||

<properties>

|

||||

<!-- 指定 maven 编译时用的 jdk 版本,与 maven 基础镜像中的版本一致 -->

|

||||

<maven.compiler.source>11</maven.compiler.source>

|

||||

<maven.compiler.target>11</maven.compiler.target>

|

||||

</properties>

|

||||

|

||||

<build>

|

||||

<!-- 指定项目最终生成的 jar 文件名,建议固定下来,方便在 Dockerfile 中 COPY 固定文件名 -->

|

||||

<finalName>app</finalName>

|

||||

<plugins>

|

||||

<plugin>

|

||||

<!-- 将项目源码编译成一个可执行 jar 包 -->

|

||||

<groupId>org.apache.maven.plugins</groupId>

|

||||

<artifactId>maven-jar-plugin</artifactId>

|

||||

<configuration>

|

||||

<archive>

|

||||

<manifest>

|

||||

<!-- 运行 jar 包时运行的主类,要求类全名 -->

|

||||

<mainClass>org.example.http.HttpTest</mainClass>

|

||||

<!-- 是否指定项目 classpath 下的依赖 -->

|

||||

<addClasspath>true</addClasspath>

|

||||

<!-- 指定依赖的时候声明前缀 -->

|

||||

<classpathPrefix>./lib/</classpathPrefix>

|

||||

<!-- 依赖是否使用带有时间戳的唯一版本号,如:xxx-1.3.0-20121225.012733.jar -->

|

||||

<useUniqueVersions>false</useUniqueVersions>

|

||||

</manifest>

|

||||

</archive>

|

||||

</configuration>

|

||||

</plugin>

|

||||

<plugin>

|

||||

<!-- 利用 maven-dependency-plugin 把当前项目的所有依赖放到 target 目录下的 lib 文件夹下 -->

|

||||

<groupId>org.apache.maven.plugins</groupId>

|

||||

<artifactId>maven-dependency-plugin</artifactId>

|

||||

<executions>

|

||||

<execution>

|

||||

<id>copy</id>

|

||||

<phase>package</phase>

|

||||

<goals>

|

||||

<goal>copy-dependencies</goal>

|

||||

</goals>

|

||||

<configuration>

|

||||

<outputDirectory>${project.build.directory}/lib</outputDirectory>

|

||||

</configuration>

|

||||

</execution>

|

||||

</executions>

|

||||

</plugin>

|

||||

</plugins>

|

||||

</build>

|

||||

|

||||

<dependencies>

|

||||

<dependency>

|

||||

<groupId>org.apache.httpcomponents.client5</groupId>

|

||||

<artifactId>httpclient5</artifactId>

|

||||

<version>5.1.3</version>

|

||||

</dependency>

|

||||

</dependencies>

|

||||

|

||||

</project>

|

||||

```

|

||||

|

||||

关键点:

|

||||

* 利用 `maven-dependency-plugin` 插件将所有依赖 jar 包拷贝到 `./lib` 下。

|

||||

* 利用 `maven-jar-plugin` 插件在打包 jar 时指定 main 函数所在 Class,让 jar 可执行;将依赖包放到 jar 包相对路径的 `./lib` 下并自动加上 `CLASSPATH`。

|

||||

|

||||

### Dockerfile

|

||||

|

||||

以下是用于构建镜像的 `Dockerfile` 示例:

|

||||

|

||||

```dockerfile

|

||||

FROM docker.io/library/maven:3.8-jdk-11 AS build

|

||||

|

||||

COPY src /app/src

|

||||

COPY pom.xml /app

|

||||

|

||||

RUN mvn -f /app/pom.xml clean package

|

||||

|

||||

FROM openjdk:11-jre-slim

|

||||

COPY --from=build /app/target/app.jar /app/app.jar

|

||||

COPY --from=build /app/target/lib /app/lib

|

||||

ENTRYPOINT ["java","-jar","/app/app.jar"]

|

||||

```

|

||||

|

||||

关键点:

|

||||

* 利用多阶段构建,只将生成的 jar 包及其依赖拷贝到最终镜像中,减小镜像体积。

|

||||

* 镜像指定启动命令,给 `java` 指定要运行的 jar 包。

|

||||

|

||||

## 参考资料

|

||||

|

||||

* [JDK 8u191 Update Release Notes ](https://www.oracle.com/java/technologies/javase/8u191-relnotes.html)

|

||||

* [Docker support in Java 8 — finally!](https://blog.softwaremill.com/docker-support-in-new-java-8-finally-fd595df0ca54)

|

||||

* [Better Containerized JVMs in JDK10](http://blog.gilliard.lol/2018/01/10/Java-in-containers-jdk10.html)

|

||||

* [JVM in a Container](https://merikan.com/2019/04/jvm-in-a-container/#java-8u131-and-java-9)

|

||||

* [14 best practices for containerising your Java applications](https://www.tutorialworks.com/docker-java-best-practices/)

|

||||

* [Best Practices: Java Memory Arguments for Containers](https://dzone.com/articles/best-practices-java-memory-arguments-for-container)

|

||||

|

|

@ -0,0 +1,122 @@

|

|||

# 在容器内使用 systemd

|

||||

|

||||

## 概述

|

||||

|

||||

某些情况下我们需要在容器内使用 systemd 去拉起进程,比如业务历史包袱重,有许多依赖组件,不能仅仅只启动1个业务进程,还有许多其它进程需要启动,短时间内不好改造好,过渡期间使用 systemd 作为主进程拉起所有依赖进程。

|

||||

|

||||

## 安装 systemd

|

||||

|

||||

如果你用的基础镜像是 centos,那么已经内置了 systemd,建议使用 `centos:8`,启动入口是 `/sbin/init`;如果是 ubuntu,那么需要安装一下 systemd,启动入口是 `/usr/sbin/systemd`,Dockerfile 示例:

|

||||

|

||||

```dockerfile

|

||||

FROM ubuntu:22.04

|

||||

RUN apt update -y

|

||||

RUN apt install -y systemd

|

||||

```

|

||||

|

||||

## 示例

|

||||

|

||||

systemd 相比业务进程比较特殊,它运行起来需要以下条件:

|

||||

1. 自己必须是 1 号进程,所以不能启用 `shareProcessNamespace`。

|