1.9 KiB

1.9 KiB

容器磁盘满导致 CPU 飙高

问题描述

某服务的其中两个副本异常,CPU 飙高。

排查

-

查看

container_cpu_usage_seconds_total监控,CPU 飙升,逼近 limit。 -

查看

container_cpu_cfs_throttled_periods_total监控,CPU 飙升伴随 CPU Throttle 飙升,所以服务异常应该是 CPU 被限流导致。 -

查看

container_cpu_system_seconds_total监控,发现 CPU 飙升主要是 CPU system 占用导致,容器内pidstat -u -t 5 1可以看到进程%system占用分布情况。 -

perf top看 system 占用高主要是vfs_write写数据导致。 -

iostat -xhd 2看 IO 并不高,磁盘利用率也不高,io wait 也不高。 -

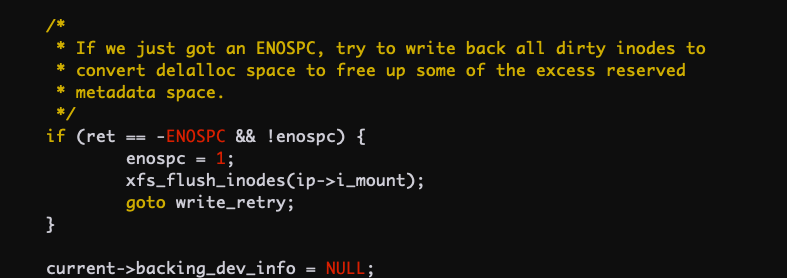

sync_inodes_sb看起来是写数据时触发了磁盘同步的耗时逻辑 -

深入看内核代码,当磁盘满的时候会调用 flush 刷磁盘所有数据,这个会一直在内核态运行很久,相当于对这个文件系统做 sync。

-

节点上

df -h看并没有磁盘满。 -

容器内

df -h看根目录空间满了. -

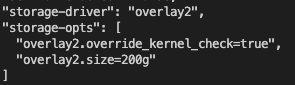

看到 docker

daemon.json配置,限制了容器内 rootfs 最大只能占用 200G -

容器内一级级的

du -sh *排查发现主要是一个nohup.log文件占满了磁盘。

结论

容器内空间满了继续写数据会导致内核不断刷盘对文件系统同步,会导致内核态 CPU 占用升高,设置了 cpu limit 通常会被 throttle,导致服务处理慢,影响业务。

建议

对日志进行轮转,或直接打到标准输出,避免写满容器磁盘。