diff --git a/README.md b/README.md

index 7ca14fd..9192f69 100644

--- a/README.md

+++ b/README.md

@@ -31,56 +31,37 @@

> - 🔁 项目同步维护:[Github](https://github.com/dunwu/db-tutorial/) | [Gitee](https://gitee.com/turnon/db-tutorial/)

> - 📖 电子书阅读:[Github Pages](https://dunwu.github.io/db-tutorial/) | [Gitee Pages](https://turnon.gitee.io/db-tutorial/)

-## 分布式

-

-### 分布式综合

-

-- [分布式面试总结](https://dunwu.github.io/blog/pages/f9209d/)

-

-### 分布式理论

-

-- [分布式理论](https://dunwu.github.io/blog/pages/286bb3/) - 关键词:`拜占庭将军`、`CAP`、`BASE`、`错误的分布式假设`

-- [共识性算法 Paxos](https://dunwu.github.io/blog/pages/0276bb/) - 关键词:`共识性算法`

-- [共识性算法 Raft](https://dunwu.github.io/blog/pages/4907dc/) - 关键词:`共识性算法`

-- [分布式算法 Gossip](https://dunwu.github.io/blog/pages/71539a/) - 关键词:`数据传播`

-

-### 分布式关键技术

-

-- 集群

-- 复制

-- 分区

-- 选主

-

-#### 流量调度

-

-- [流量控制](https://dunwu.github.io/blog/pages/60bb6d/) - 关键词:`限流`、`熔断`、`降级`、`计数器法`、`时间窗口法`、`令牌桶法`、`漏桶法`

-- [负载均衡](https://dunwu.github.io/blog/pages/98a1c1/) - 关键词:`轮询`、`随机`、`最少连接`、`源地址哈希`、`一致性哈希`、`虚拟 hash 槽`

-- [服务路由](https://dunwu.github.io/blog/pages/3915e8/) - 关键词:`路由`、`条件路由`、`脚本路由`、`标签路由`

-- 服务网关

-- [分布式会话](https://dunwu.github.io/blog/pages/95e45f/) - 关键词:`粘性 Session`、`Session 复制共享`、`基于缓存的 session 共享`

-

-#### 数据调度

-

-- [数据缓存](https://dunwu.github.io/blog/pages/fd0aaa/) - 关键词:`进程内缓存`、`分布式缓存`、`缓存雪崩`、`缓存穿透`、`缓存击穿`、`缓存更新`、`缓存预热`、`缓存降级`

-- [读写分离](https://dunwu.github.io/blog/pages/3faf18/)

-- [分库分表](https://dunwu.github.io/blog/pages/e1046e/) - 关键词:`分片`、`路由`、`迁移`、`扩容`、`双写`、`聚合`

-- [分布式 ID](https://dunwu.github.io/blog/pages/3ae455/) - 关键词:`UUID`、`自增序列`、`雪花算法`、`Leaf`

-- [分布式事务](https://dunwu.github.io/blog/pages/e1881c/) - 关键词:`2PC`、`3PC`、`TCC`、`本地消息表`、`MQ 消息`、`SAGA`

-- [分布式锁](https://dunwu.github.io/blog/pages/40ac64/) - 关键词:`数据库`、`Redis`、`ZooKeeper`、`互斥`、`可重入`、`死锁`、`容错`、`自旋尝试`

-

-#### 资源调度

-

-- 弹性伸缩

-

-#### 服务治理

-

-- [服务注册和发现](https://dunwu.github.io/blog/pages/1a90aa/)

-- [服务容错](https://dunwu.github.io/blog/pages/e32c7e/)

-- 服务编排

-- 服务版本管理

-

## 数据库综合

+### 分布式存储原理

+

+#### 分布式理论

+

+- [分布式一致性](https://dunwu.github.io/blog/pages/dac0e2/)

+- [深入剖析共识性算法 Paxos](https://dunwu.github.io/blog/pages/874539/)

+- [深入剖析共识性算法 Raft](https://dunwu.github.io/blog/pages/e40812/)

+- [分布式算法 Gossip](https://dunwu.github.io/blog/pages/d15993/)

+

+#### 分布式关键技术

+

+##### 流量调度

+

+- [流量控制](https://dunwu.github.io/blog/pages/282676/)

+- [负载均衡](https://dunwu.github.io/blog/pages/98a1c1/)

+- [服务路由](https://dunwu.github.io/blog/pages/d04ece/)

+- [分布式会话基本原理](https://dunwu.github.io/blog/pages/3e66c2/)

+

+##### 数据调度

+

+- [缓存基本原理](https://dunwu.github.io/blog/pages/471208/)

+- [读写分离基本原理](https://dunwu.github.io/blog/pages/7da6ca/)

+- [分库分表基本原理](https://dunwu.github.io/blog/pages/103382/)

+- [分布式 ID 基本原理](https://dunwu.github.io/blog/pages/0b2e59/)

+- [分布式事务基本原理](https://dunwu.github.io/blog/pages/910bad/)

+- [分布式锁基本原理](https://dunwu.github.io/blog/pages/69360c/)

+

+### 其他

+

- [Nosql 技术选型](docs/12.数据库/01.数据库综合/01.Nosql技术选型.md)

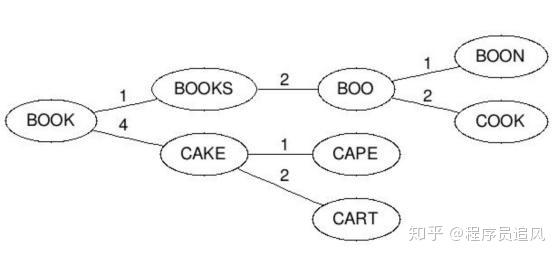

- [数据结构与数据库索引](docs/12.数据库/01.数据库综合/02.数据结构与数据库索引.md)

@@ -94,11 +75,13 @@

> [关系型数据库](docs/12.数据库/03.关系型数据库) 整理主流关系型数据库知识点。

-### 公共知识

+### 关系型数据库综合

- [关系型数据库面试总结](docs/12.数据库/03.关系型数据库/01.综合/01.关系型数据库面试.md) 💯

-- [SQL Cheat Sheet](docs/12.数据库/03.关系型数据库/01.综合/02.SqlCheatSheet.md) 是一个 SQL 入门教程。

-- [扩展 SQL](docs/12.数据库/03.关系型数据库/01.综合/03.扩展SQL.md) 是一个 SQL 入门教程。

+- [SQL 语法基础特性](docs/12.数据库/03.关系型数据库/01.综合/02.SQL语法基础特性.md)

+- [SQL 语法高级特性](docs/12.数据库/03.关系型数据库/01.综合/03.SQL语法高级特性.md)

+- [扩展 SQL](docs/12.数据库/03.关系型数据库/01.综合/03.扩展SQL.md)

+- [SQL Cheat Sheet](docs/12.数据库/03.关系型数据库/01.综合/99.SqlCheatSheet.md)

### Mysql

@@ -161,12 +144,16 @@

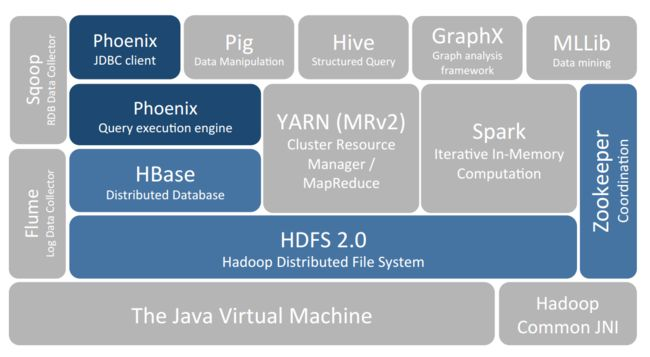

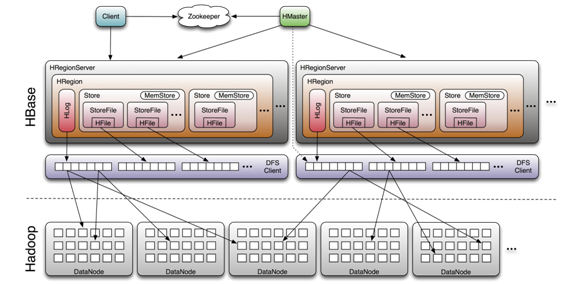

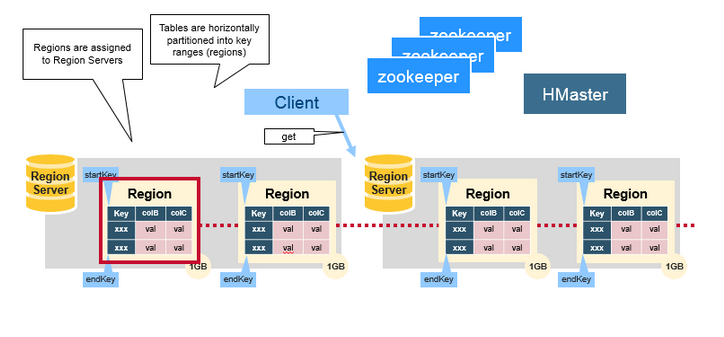

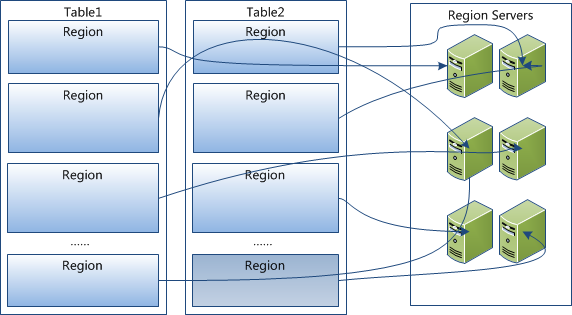

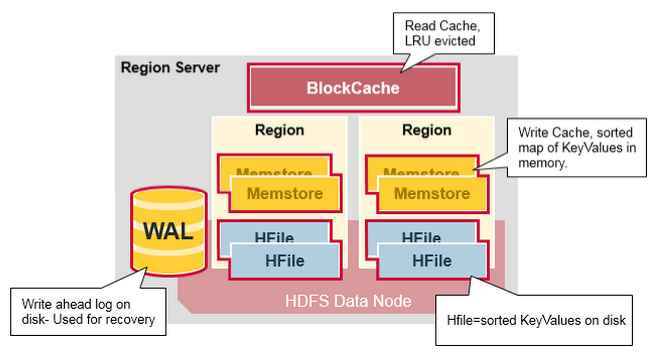

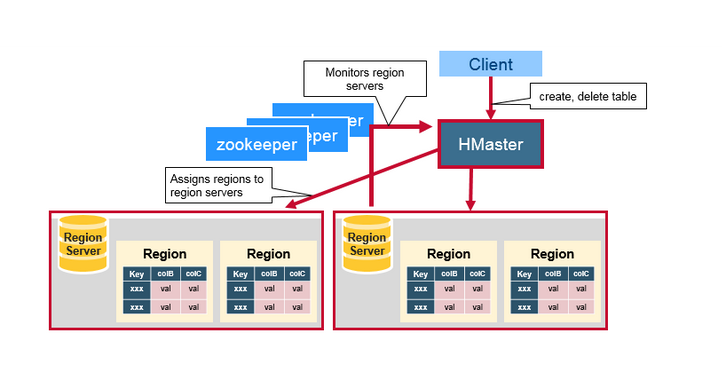

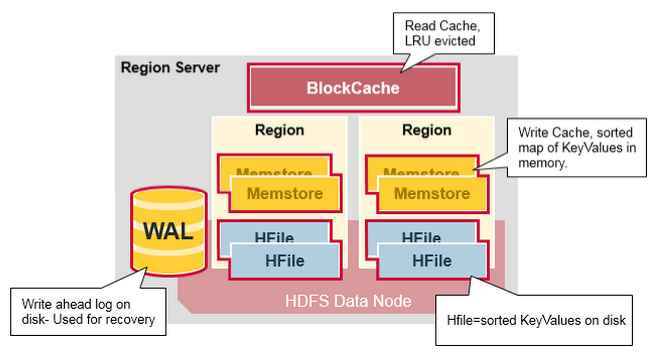

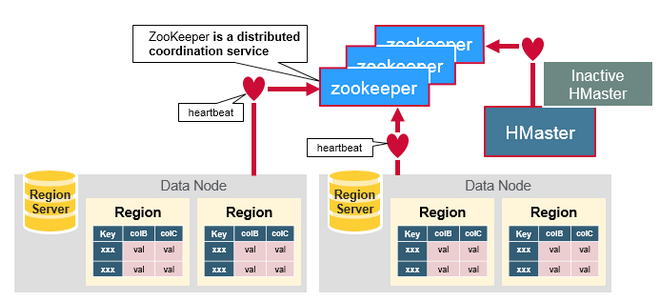

### HBase

-> [HBase](https://dunwu.github.io/bigdata-tutorial/hbase) 📚 因为常用于大数据项目,所以将其文档和源码整理在 [bigdata-tutorial](https://dunwu.github.io/bigdata-tutorial/) 项目中。

-

-- [HBase 原理](https://github.com/dunwu/bigdata-tutorial/blob/master/docs/hbase/HBase原理.md) ⚡

-- [HBase 命令](https://github.com/dunwu/bigdata-tutorial/blob/master/docs/hbase/HBase命令.md)

-- [HBase 应用](https://github.com/dunwu/bigdata-tutorial/blob/master/docs/hbase/HBase应用.md)

-- [HBase 运维](https://github.com/dunwu/bigdata-tutorial/blob/master/docs/hbase/HBase运维.md)

+- [HBase 快速入门](docs/12.数据库/06.列式数据库/01.HBase/01.HBase快速入门.md)

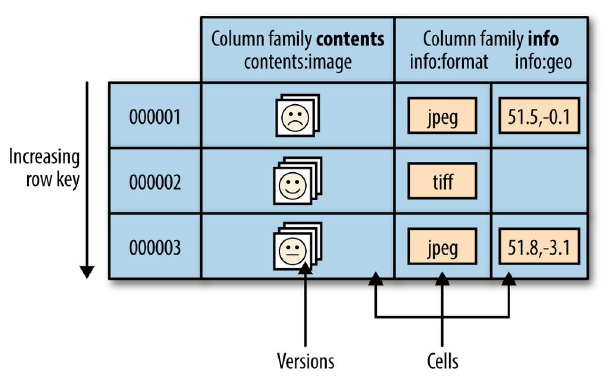

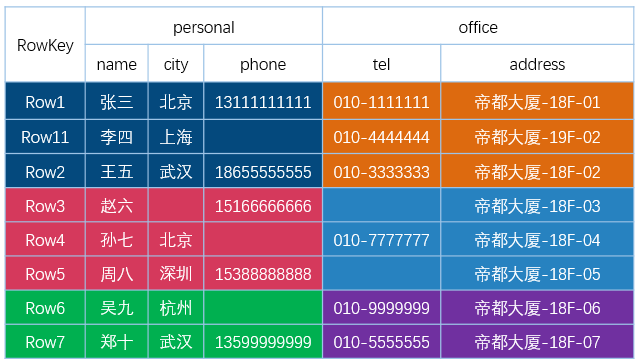

+- [HBase 数据模型](docs/12.数据库/06.列式数据库/01.HBase/02.HBase数据模型.md)

+- [HBase Schema 设计](docs/12.数据库/06.列式数据库/01.HBase/03.HBaseSchema设计.md)

+- [HBase 架构](docs/12.数据库/06.列式数据库/01.HBase/04.HBase架构.md)

+- [HBase Java API 基础特性](docs/12.数据库/06.列式数据库/01.HBase/10.HBaseJavaApi基础特性.md)

+- [HBase Java API 高级特性之过滤器](docs/12.数据库/06.列式数据库/01.HBase/11.HBaseJavaApi高级特性之过滤器.md)

+- [HBase Java API 高级特性之协处理器](docs/12.数据库/06.列式数据库/01.HBase/12.HBaseJavaApi高级特性之协处理器.md)

+- [HBase Java API 其他高级特性](docs/12.数据库/06.列式数据库/01.HBase/13.HBaseJavaApi其他高级特性.md)

+- [HBase 运维](docs/12.数据库/06.列式数据库/01.HBase/21.HBase运维.md)

+- [HBase 命令](docs/12.数据库/06.列式数据库/01.HBase/22.HBase命令.md)

## 搜索引擎数据库

diff --git a/docs/12.数据库/01.数据库综合/01.Nosql技术选型.md b/docs/12.数据库/01.数据库综合/01.Nosql技术选型.md

index bff8ebf..087e9e2 100644

--- a/docs/12.数据库/01.数据库综合/01.Nosql技术选型.md

+++ b/docs/12.数据库/01.数据库综合/01.Nosql技术选型.md

@@ -386,4 +386,4 @@ Neo4j 中,存储节点时使用了”index-free adjacency”,即每个节点

## 参考资料

-- [NoSQL 还是 SQL ?这一篇讲清楚](https://juejin.im/post/5b6d62ddf265da0f491bd200)

+- [NoSQL 还是 SQL ?这一篇讲清楚](https://juejin.im/post/5b6d62ddf265da0f491bd200)

\ No newline at end of file

diff --git a/docs/12.数据库/01.数据库综合/02.数据结构与数据库索引.md b/docs/12.数据库/01.数据库综合/02.数据结构与数据库索引.md

index c2443fa..5c728d0 100644

--- a/docs/12.数据库/01.数据库综合/02.数据结构与数据库索引.md

+++ b/docs/12.数据库/01.数据库综合/02.数据结构与数据库索引.md

@@ -214,4 +214,4 @@ LSM 树的这些特点,使得它相对于 B+ 树,在写入性能上有大幅

- [数据结构与算法之美](https://time.geekbang.org/column/intro/100017301)

- [检索技术核心 20 讲](https://time.geekbang.org/column/intro/100048401)

- [Data Structures for Databases](https://www.cise.ufl.edu/~mschneid/Research/papers/HS05BoCh.pdf)

-- [Data Structures and Algorithms for Big Databases](https://people.csail.mit.edu/bradley/BenderKuszmaul-tutorial-xldb12.pdf)

+- [Data Structures and Algorithms for Big Databases](https://people.csail.mit.edu/bradley/BenderKuszmaul-tutorial-xldb12.pdf)

\ No newline at end of file

diff --git a/docs/12.数据库/01.数据库综合/README.md b/docs/12.数据库/01.数据库综合/README.md

index ef9771a..d2b801e 100644

--- a/docs/12.数据库/01.数据库综合/README.md

+++ b/docs/12.数据库/01.数据库综合/README.md

@@ -22,4 +22,4 @@ hidden: true

## 🚪 传送

-◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

+◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

\ No newline at end of file

diff --git a/docs/12.数据库/02.数据库中间件/01.Shardingsphere/01.ShardingSphere简介.md b/docs/12.数据库/02.数据库中间件/01.Shardingsphere/01.ShardingSphere简介.md

index 4aff27b..ed2deac 100644

--- a/docs/12.数据库/02.数据库中间件/01.Shardingsphere/01.ShardingSphere简介.md

+++ b/docs/12.数据库/02.数据库中间件/01.Shardingsphere/01.ShardingSphere简介.md

@@ -91,4 +91,4 @@ Apache ShardingSphere 是多接入端共同组成的生态圈。 通过混合使

## 参考资料

- [shardingsphere Github](https://github.com/apache/incubator-shardingsphere)

-- [shardingsphere 官方文档](https://shardingsphere.apache.org/document/current/cn/overview/)

+- [shardingsphere 官方文档](https://shardingsphere.apache.org/document/current/cn/overview/)

\ No newline at end of file

diff --git a/docs/12.数据库/02.数据库中间件/01.Shardingsphere/02.ShardingSphereJdbc.md b/docs/12.数据库/02.数据库中间件/01.Shardingsphere/02.ShardingSphereJdbc.md

index 35fb523..dab4e33 100644

--- a/docs/12.数据库/02.数据库中间件/01.Shardingsphere/02.ShardingSphereJdbc.md

+++ b/docs/12.数据库/02.数据库中间件/01.Shardingsphere/02.ShardingSphereJdbc.md

@@ -137,4 +137,4 @@ SQL 解析作为分库分表类产品的核心,其性能和兼容性是最重

### 执行引擎

-### 归并引擎

+### 归并引擎

\ No newline at end of file

diff --git a/docs/12.数据库/02.数据库中间件/02.Flyway.md b/docs/12.数据库/02.数据库中间件/02.Flyway.md

index 03806f3..3c2a94a 100644

--- a/docs/12.数据库/02.数据库中间件/02.Flyway.md

+++ b/docs/12.数据库/02.数据库中间件/02.Flyway.md

@@ -501,4 +501,4 @@ Flyway 的功能主要围绕着 7 个基本命令:[Migrate](https://flywaydb.o

## :door: 传送门

-| [钝悟的博客](https://dunwu.github.io/blog/) | [db-tutorial 首页](https://github.com/dunwu/db-tutorial) |

+| [钝悟的博客](https://dunwu.github.io/blog/) | [db-tutorial 首页](https://github.com/dunwu/db-tutorial) |

\ No newline at end of file

diff --git a/docs/12.数据库/02.数据库中间件/README.md b/docs/12.数据库/02.数据库中间件/README.md

index 95cda94..cdadf2f 100644

--- a/docs/12.数据库/02.数据库中间件/README.md

+++ b/docs/12.数据库/02.数据库中间件/README.md

@@ -30,4 +30,4 @@ hidden: true

## 🚪 传送

-◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

+◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/01.综合/01.关系型数据库面试.md b/docs/12.数据库/03.关系型数据库/01.综合/01.关系型数据库面试.md

index ee0bc74..dc959f2 100644

--- a/docs/12.数据库/03.关系型数据库/01.综合/01.关系型数据库面试.md

+++ b/docs/12.数据库/03.关系型数据库/01.综合/01.关系型数据库面试.md

@@ -8,12 +8,13 @@ categories:

tags:

- 数据库

- 关系型数据库

+ - 面试

permalink: /pages/9bb28f/

---

# 关系型数据库面试

-## 一、索引和约束

+## 索引和约束

### 什么是索引

@@ -252,7 +253,7 @@ MySQL 会一直向右匹配直到遇到范围查询 `(>,<,BETWEEN,LIKE)` 就停

- `FOREIGN KEY` - 在一个表中存在的另一个表的主键称此表的外键。用于预防破坏表之间连接的动作,也能防止非法数据插入外键列,因为它必须是它指向的那个表中的值之一。

- `CHECK` - 用于控制字段的值范围。

-## 二、并发控制

+## 并发控制

### 乐观锁和悲观锁

@@ -336,7 +337,7 @@ MVCC 不能解决幻读问题,**Next-Key 锁就是为了解决幻读问题**

当两个事务同时执行,一个锁住了主键索引,在等待其他相关索引。另一个锁定了非主键索引,在等待主键索引。这样就会发生死锁。发生死锁后,`InnoDB` 一般都可以检测到,并使一个事务释放锁回退,另一个获取锁完成事务。

-## 三、事务

+## 事务

> 事务简单来说:**一个 Session 中所进行所有的操作,要么同时成功,要么同时失败**。具体来说,事务指的是满足 ACID 特性的一组操作,可以通过 `Commit` 提交一个事务,也可以使用 `Rollback` 进行回滚。

@@ -441,7 +442,7 @@ T1 读取某个范围的数据,T2 在这个范围内插

| 并发性能 | 无影响 | 严重衰退 | 略微衰退 |

| 适合场景 | 业务方处理不一致 | 短事务 & 低并发 | 长事务 & 高并发 |

-## 四、分库分表

+## 分库分表

### 什么是分库分表

@@ -577,7 +578,7 @@ T1 读取某个范围的数据,T2 在这个范围内插

来自淘宝综合业务平台团队,它利用对 2 的倍数取余具有向前兼容的特性(如对 4 取余得 1 的数对 2 取余也是 1)来分配数据,避免了行级别的数据迁移,但是依然需要进行表级别的迁移,同时对扩容规模和分表数量都有限制。总得来说,这些方案都不是十分的理想,多多少少都存在一些缺点,这也从一个侧面反映出了 Sharding 扩容的难度。

-## 五、集群

+## 集群

> 这个专题需要根据熟悉哪个数据库而定,但是主流、成熟的数据库都会实现一些基本功能,只是实现方式、策略上有所差异。由于本人较为熟悉 Mysql,所以下面主要介绍 Mysql 系统架构问题。

@@ -609,7 +610,7 @@ MySQL 读写分离能提高性能的原因在于:

-## 六、数据库优化

+## 数据库优化

数据库优化的路线一般为:SQL 优化、结构优化、配置优化、硬件优化。前两个方向一般是普通开发的考量点,而后两个方向一般是 DBA 的考量点。

@@ -842,7 +843,7 @@ SQL 关键字尽量大写,如:Oracle 默认会将 SQL 语句中的关键字

数据库扩容、使用高配设备等等。核心就是一个字:钱。

-## 七、数据库理论

+## 数据库理论

### 函数依赖

@@ -960,7 +961,7 @@ Sname, Sdept 和 Mname 都部分依赖于键码,当一个学生选修了多门

| 学院-1 | 院长-1 |

| 学院-2 | 院长-2 |

-## 八、Mysql 存储引擎

+## 存储引擎

Mysql 有多种存储引擎,**不同的存储引擎保存数据和索引的方式是不同的,但表的定义则是在 Mysql 服务层统一处理的**。

@@ -986,7 +987,7 @@ InnoDB 和 MyISAM 是目前使用的最多的两种 Mysql 存储引擎。

- InnoDB 支持故障恢复。

- MyISAM 不支持故障恢复。

-## 九、数据库比较

+## 数据库比较

### 常见数据库比较

@@ -1070,6 +1071,78 @@ where rr>5 and rr<=10;

> 数据类型对比表摘自 [SQL 通用数据类型](https://www.runoob.com/sql/sql-datatypes-general.html)、[SQL 用于各种数据库的数据类型](https://www.runoob.com/sql/sql-datatypes.html)

+## SQL FAQ

+

+### SELECT COUNT(\*)、SELECT COUNT(1) 和 SELECT COUNT(具体字段) 性能有差别吗?

+

+在 MySQL InnoDB 存储引擎中,`COUNT(*)` 和 `COUNT(1)` 都是对所有结果进行 `COUNT`。因此`COUNT(*)`和`COUNT(1)`本质上并没有区别,执行的复杂度都是 `O(N)`,也就是采用全表扫描,进行循环 + 计数的方式进行统计。

+

+如果是 MySQL MyISAM 存储引擎,统计数据表的行数只需要`O(1)`的复杂度,这是因为每张 MyISAM 的数据表都有一个 meta 信息存储了`row_count`值,而一致性则由表级锁来保证。因为 InnoDB 支持事务,采用行级锁和 MVCC 机制,所以无法像 MyISAM 一样,只维护一个`row_count`变量,因此需要采用扫描全表,进行循环 + 计数的方式来完成统计。

+

+需要注意的是,在实际执行中,`COUNT(*)`和`COUNT(1)`的执行时间可能略有差别,不过你还是可以把它俩的执行效率看成是相等的。

+

+另外在 InnoDB 引擎中,如果采用`COUNT(*)`和`COUNT(1)`来统计数据行数,要尽量采用二级索引。因为主键采用的索引是聚簇索引,聚簇索引包含的信息多,明显会大于二级索引(非聚簇索引)。对于`COUNT(*)`和`COUNT(1)`来说,它们不需要查找具体的行,只是统计行数,系统会自动采用占用空间更小的二级索引来进行统计。

+

+然而如果想要查找具体的行,那么采用主键索引的效率更高。如果有多个二级索引,会使用 key_len 小的二级索引进行扫描。当没有二级索引的时候,才会采用主键索引来进行统计。

+

+这里我总结一下:

+

+1. 一般情况下,三者执行的效率为 `COUNT(*)`= `COUNT(1)`> `COUNT(字段)`。我们尽量使用`COUNT(*)`,当然如果你要统计的是某个字段的非空数据行数,则另当别论,毕竟比较执行效率的前提是结果一样才可以。

+2. 如果要统计`COUNT(*)`,尽量在数据表上建立二级索引,系统会自动采用`key_len`小的二级索引进行扫描,这样当我们使用`SELECT COUNT(*)`的时候效率就会提升,有时候可以提升几倍甚至更高。

+

+> ——摘自[极客时间 - SQL 必知必会](https://time.geekbang.org/column/intro/192)

+

+### ORDER BY 是对分的组排序还是对分组中的记录排序呢?

+

+ORDER BY 就是对记录进行排序。如果你在 ORDER BY 前面用到了 GROUP BY,实际上这是一种分组的聚合方式,已经把一组的数据聚合成为了一条记录,再进行排序的时候,相当于对分的组进行了排序。

+

+### SELECT 语句内部的执行步骤

+

+一条完整的 SELECT 语句内部的执行顺序是这样的:

+

+1. FROM 子句组装数据(包括通过 ON 进行连接);

+2. WHERE 子句进行条件筛选;

+3. GROUP BY 分组 ;

+4. 使用聚集函数进行计算;

+5. HAVING 筛选分组;

+6. 计算所有的表达式;

+7. SELECT 的字段;

+8. ORDER BY 排序;

+9. LIMIT 筛选。

+

+> ——摘自[极客时间 - SQL 必知必会](https://time.geekbang.org/column/intro/192)

+

+### 解哪种情况下应该使用 EXISTS,哪种情况应该用 IN

+

+索引是个前提,其实选择与否还是要看表的大小。你可以将选择的标准理解为小表驱动大表。在这种方式下效率是最高的。

+

+比如下面这样:

+

+```

+ SELECT * FROM A WHERE cc IN (SELECT cc FROM B)

+ SELECT * FROM A WHERE EXISTS (SELECT cc FROM B WHERE B.cc=A.cc)

+```

+

+当 A 小于 B 时,用 EXISTS。因为 EXISTS 的实现,相当于外表循环,实现的逻辑类似于:

+

+```

+ for i in A

+ for j in B

+ if j.cc == i.cc then ...

+```

+

+当 B 小于 A 时用 IN,因为实现的逻辑类似于:

+

+```

+ for i in B

+ for j in A

+ if j.cc == i.cc then ...

+```

+

+哪个表小就用哪个表来驱动,A 表小就用 EXISTS,B 表小就用 IN。

+

+> ——摘自[极客时间 - SQL 必知必会](https://time.geekbang.org/column/intro/192)

+

## 参考资料

- [数据库面试题(开发者必看)](https://juejin.im/post/5a9ca0d6518825555c1d1acd)

@@ -1081,4 +1154,4 @@ where rr>5 and rr<=10;

- [ShardingSphere 分布式事务](https://shardingsphere.apache.org/document/current/cn/features/transaction/)

- [mysql 和 oracle 的区别](https://zhuanlan.zhihu.com/p/39651803)

- [RUNOOB SQL 教程](https://www.runoob.com/sql/sql-tutorial.html)

-- [如果有人问你数据库的原理,叫他看这篇文章](https://gameinstitute.qq.com/community/detail/107154)

+- [如果有人问你数据库的原理,叫他看这篇文章](https://gameinstitute.qq.com/community/detail/107154)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/01.综合/02.SQL语法基础特性.md b/docs/12.数据库/03.关系型数据库/01.综合/02.SQL语法基础特性.md

new file mode 100644

index 0000000..e018850

--- /dev/null

+++ b/docs/12.数据库/03.关系型数据库/01.综合/02.SQL语法基础特性.md

@@ -0,0 +1,601 @@

+---

+title: SQL 语法基础特性

+date: 2018-06-15 16:07:17

+categories:

+ - 数据库

+ - 关系型数据库

+ - 综合

+tags:

+ - 数据库

+ - 关系型数据库

+ - SQL

+permalink: /pages/b71c9e/

+---

+

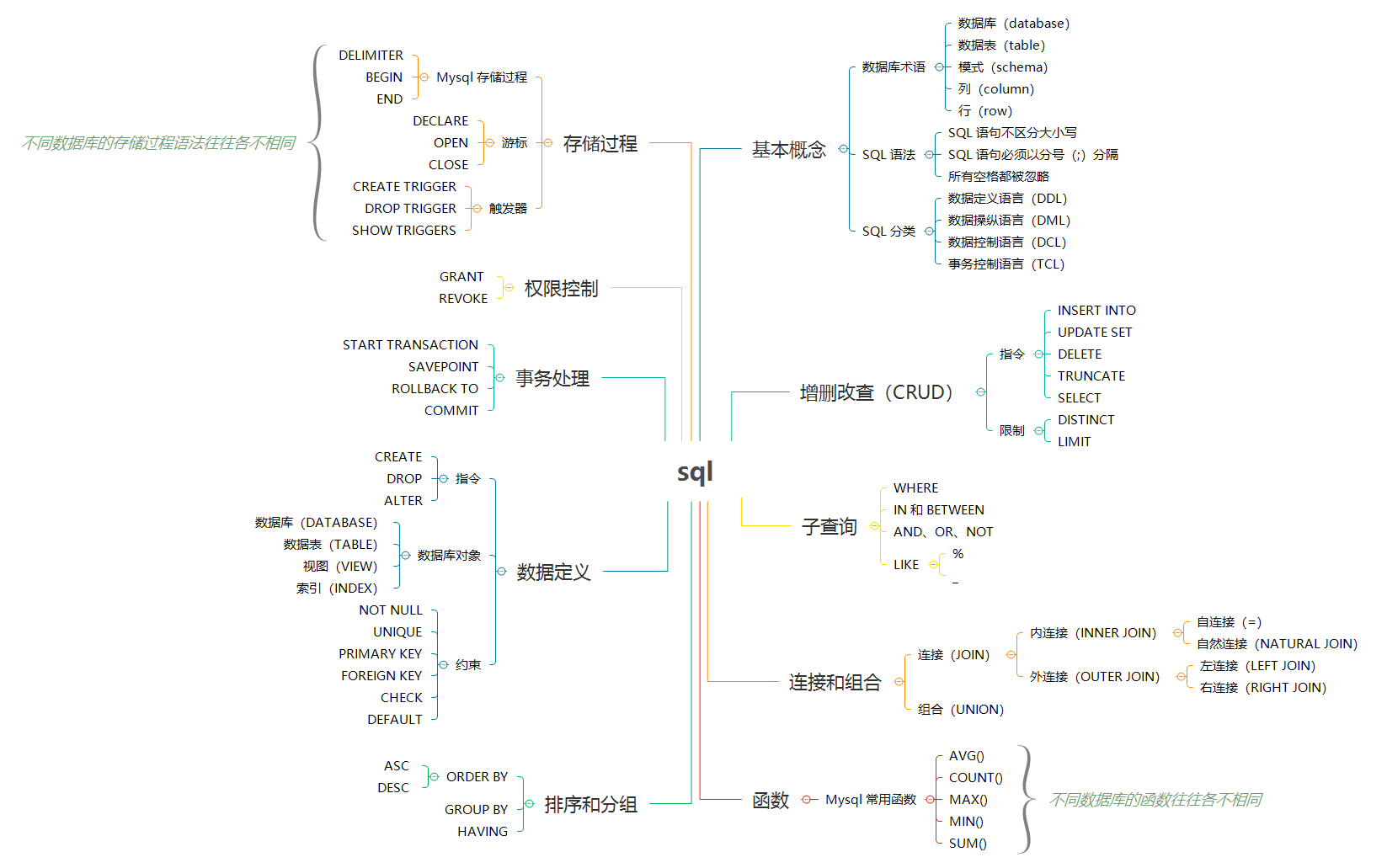

+# SQL 语法基础特性

+

+> 本文针对关系型数据库的基本语法。限于篇幅,本文侧重说明用法,不会展开讲解特性、原理。

+>

+> 本文语法主要针对 Mysql,但大部分的语法对其他关系型数据库也适用。

+

+

+

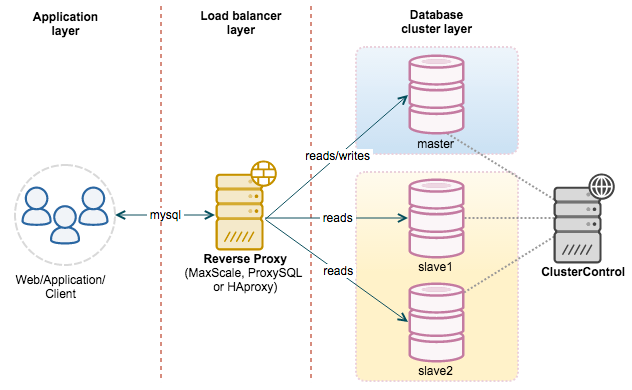

+## SQL 简介

+

+### 数据库术语

+

+- `数据库(database)` - 保存有组织的数据的容器(通常是一个文件或一组文件)。

+- `数据表(table)` - 某种特定类型数据的结构化清单。

+- `模式(schema)` - 关于数据库和表的布局及特性的信息。模式定义了数据在表中如何存储,包含存储什么样的数据,数据如何分解,各部分信息如何命名等信息。数据库和表都有模式。

+- `列(column)` - 表中的一个字段。所有表都是由一个或多个列组成的。

+- `行(row)` - 表中的一个记录。

+- `主键(primary key)` - 一列(或一组列),其值能够唯一标识表中每一行。

+

+### SQL 语法

+

+> SQL(Structured Query Language),标准 SQL 由 ANSI 标准委员会管理,从而称为 ANSI SQL。各个 DBMS 都有自己的实现,如 PL/SQL、Transact-SQL 等。

+

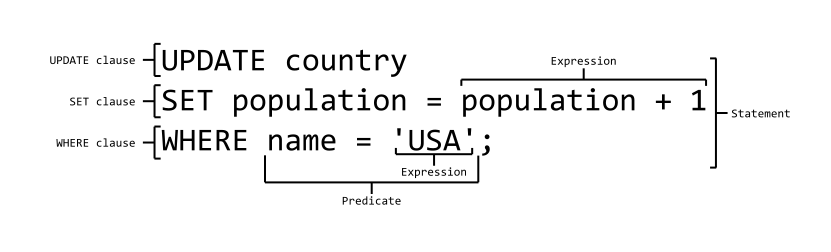

+#### SQL 语法结构

+

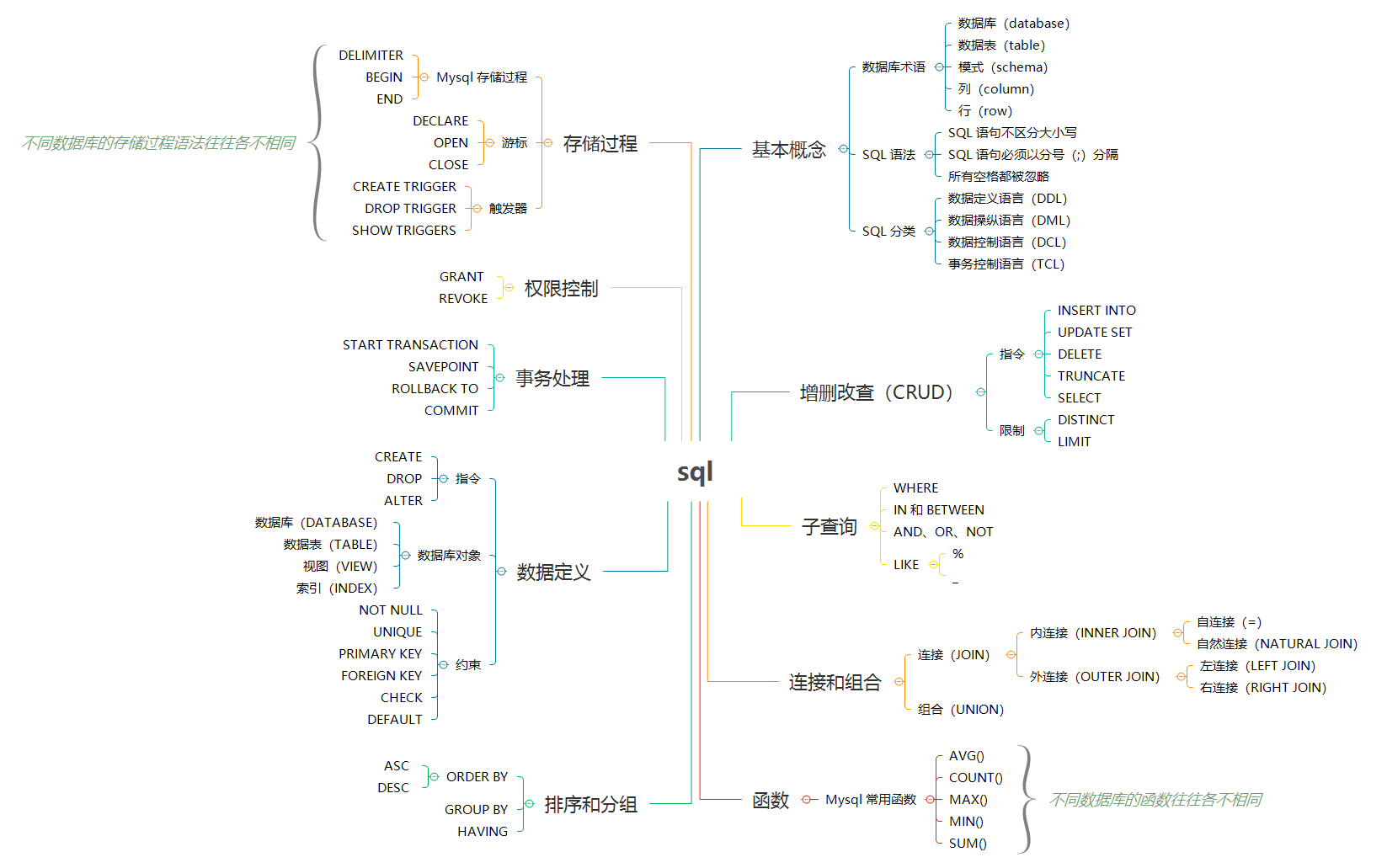

+

+

+SQL 语法结构包括:

+

+- **`子句`** - 是语句和查询的组成成分。(在某些情况下,这些都是可选的。)

+- **`表达式`** - 可以产生任何标量值,或由列和行的数据库表

+- **`谓词`** - 给需要评估的 SQL 三值逻辑(3VL)(true/false/unknown)或布尔真值指定条件,并限制语句和查询的效果,或改变程序流程。

+- **`查询`** - 基于特定条件检索数据。这是 SQL 的一个重要组成部分。

+- **`语句`** - 可以持久地影响纲要和数据,也可以控制数据库事务、程序流程、连接、会话或诊断。

+

+#### SQL 语法要点

+

+- **SQL 语句不区分大小写**,但是数据库表名、列名和值是否区分,依赖于具体的 DBMS 以及配置。

+

+例如:`SELECT` 与 `select` 、`Select` 是相同的。

+

+- **多条 SQL 语句必须以分号(`;`)分隔**。

+

+- 处理 SQL 语句时,**所有空格都被忽略**。SQL 语句可以写成一行,也可以分写为多行。

+

+```sql

+-- 一行 SQL 语句

+UPDATE user SET username='robot', password='robot' WHERE username = 'root';

+

+-- 多行 SQL 语句

+UPDATE user

+SET username='robot', password='robot'

+WHERE username = 'root';

+```

+

+- SQL 支持三种注释

+

+```sql

+## 注释1

+-- 注释2

+/* 注释3 */

+```

+

+#### SQL 分类

+

+#### 数据定义语言(DDL)

+

+数据定义语言(Data Definition Language,DDL)是 SQL 语言集中负责数据结构定义与数据库对象定义的语言。

+

+DDL 的主要功能是**定义数据库对象**。

+

+DDL 的核心指令是 `CREATE`、`ALTER`、`DROP`。

+

+#### 数据操纵语言(DML)

+

+数据操纵语言(Data Manipulation Language, DML)是用于数据库操作,对数据库其中的对象和数据运行访问工作的编程语句。

+

+DML 的主要功能是 **访问数据**,因此其语法都是以**读写数据库**为主。

+

+DML 的核心指令是 `INSERT`、`UPDATE`、`DELETE`、`SELECT`。这四个指令合称 CRUD(Create, Read, Update, Delete),即增删改查。

+

+#### 事务控制语言(TCL)

+

+事务控制语言 (Transaction Control Language, TCL) 用于**管理数据库中的事务**。这些用于管理由 DML 语句所做的更改。它还允许将语句分组为逻辑事务。

+

+TCL 的核心指令是 `COMMIT`、`ROLLBACK`。

+

+#### 数据控制语言(DCL)

+

+数据控制语言 (Data Control Language, DCL) 是一种可对数据访问权进行控制的指令,它可以控制特定用户账户对数据表、查看表、预存程序、用户自定义函数等数据库对象的控制权。

+

+DCL 的核心指令是 `GRANT`、`REVOKE`。

+

+DCL 以**控制用户的访问权限**为主,因此其指令作法并不复杂,可利用 DCL 控制的权限有:`CONNECT`、`SELECT`、`INSERT`、`UPDATE`、`DELETE`、`EXECUTE`、`USAGE`、`REFERENCES`。

+

+根据不同的 DBMS 以及不同的安全性实体,其支持的权限控制也有所不同。

+

+---

+

+**(以下为 DML 语句用法)**

+

+## 增删改查(CRUD)

+

+增删改查,又称为 **`CRUD`**,是数据库基本操作中的基本操作。

+

+### 插入数据

+

+> - `INSERT INTO` 语句用于向表中插入新记录。

+

+#### 插入完整的行

+

+```sql

+INSERT INTO user

+VALUES (10, 'root', 'root', 'xxxx@163.com');

+```

+

+#### 插入行的一部分

+

+```sql

+INSERT INTO user(username, password, email)

+VALUES ('admin', 'admin', 'xxxx@163.com');

+```

+

+#### 插入查询出来的数据

+

+```sql

+INSERT INTO user(username)

+SELECT name

+FROM account;

+```

+

+### 更新数据

+

+> - `UPDATE` 语句用于更新表中的记录。

+

+```sql

+UPDATE user

+SET username='robot', password='robot'

+WHERE username = 'root';

+```

+

+### 删除数据

+

+> - `DELETE` 语句用于删除表中的记录。

+> - `TRUNCATE TABLE` 可以清空表,也就是删除所有行。

+

+#### 删除表中的指定数据

+

+```sql

+DELETE FROM user WHERE username = 'robot';

+```

+

+#### 清空表中的数据

+

+```sql

+TRUNCATE TABLE user;

+```

+

+### 查询数据

+

+> - `SELECT` 语句用于从数据库中查询数据。

+> - `DISTINCT` 用于返回唯一不同的值。它作用于所有列,也就是说所有列的值都相同才算相同。

+> - `LIMIT` 限制返回的行数。可以有两个参数,第一个参数为起始行,从 0 开始;第二个参数为返回的总行数。

+> - `ASC` :升序(默认)

+> - `DESC` :降序

+

+#### 查询单列

+

+```sql

+SELECT prod_name FROM products;

+```

+

+#### 查询多列

+

+```sql

+SELECT prod_id, prod_name, prod_price FROM products;

+```

+

+#### 查询所有列

+

+```sql

+SELECT * FROM products;

+```

+

+#### 查询不同的值

+

+```sql

+SELECT DISTINCT vend_id FROM products;

+```

+

+#### 限制查询数量

+

+```sql

+-- 返回前 5 行

+SELECT * FROM products LIMIT 5;

+SELECT * FROM products LIMIT 0, 5;

+-- 返回第 3 ~ 5 行

+SELECT * FROM products LIMIT 2, 3;

+```

+

+## 过滤数据(WHERE)

+

+子查询是嵌套在较大查询中的 SQL 查询。子查询也称为**内部查询**或**内部选择**,而包含子查询的语句也称为**外部查询**或**外部选择**。

+

+- 子查询可以嵌套在 `SELECT`,`INSERT`,`UPDATE` 或 `DELETE` 语句内或另一个子查询中。

+

+- 子查询通常会在另一个 `SELECT` 语句的 `WHERE` 子句中添加。

+

+- 您可以使用比较运算符,如 `>`,`<`,或 `=`。比较运算符也可以是多行运算符,如 `IN`,`ANY` 或 `ALL`。

+

+- 子查询必须被圆括号 `()` 括起来。

+

+- 内部查询首先在其父查询之前执行,以便可以将内部查询的结果传递给外部查询。执行过程可以参考下图:

+

+

+  +

+

+

+**子查询的子查询**

+

+```sql

+SELECT cust_name, cust_contact

+FROM customers

+WHERE cust_id IN (SELECT cust_id

+ FROM orders

+ WHERE order_num IN (SELECT order_num

+ FROM orderitems

+ WHERE prod_id = 'RGAN01'));

+```

+

+### WHERE 子句

+

+在 SQL 语句中,数据根据 `WHERE` 子句中指定的搜索条件进行过滤。

+

+`WHERE` 子句的基本格式如下:

+

+```sql

+SELECT ……(列名) FROM ……(表名) WHERE ……(子句条件)

+```

+

+`WHERE` 子句用于过滤记录,即缩小访问数据的范围。`WHERE` 后跟一个返回 `true` 或 `false` 的条件。

+

+`WHERE` 可以与 `SELECT`,`UPDATE` 和 `DELETE` 一起使用。

+

+**`SELECT` 语句中的 `WHERE` 子句**

+

+```sql

+SELECT * FROM Customers

+WHERE cust_name = 'Kids Place';

+```

+

+**`UPDATE` 语句中的 `WHERE` 子句**

+

+```sql

+UPDATE Customers

+SET cust_name = 'Jack Jones'

+WHERE cust_name = 'Kids Place';

+```

+

+**`DELETE` 语句中的 `WHERE` 子句**

+

+```sql

+DELETE FROM Customers

+WHERE cust_name = 'Kids Place';

+```

+

+可以在 `WHERE` 子句中使用的操作符:

+

+### 比较操作符

+

+| 运算符 | 描述 |

+| ------ | ------------------------------------------------------ |

+| `=` | 等于 |

+| `<>` | 不等于。注释:在 SQL 的一些版本中,该操作符可被写成 != |

+| `>` | 大于 |

+| `<` | 小于 |

+| `>=` | 大于等于 |

+| `<=` | 小于等于 |

+

+### 范围操作符

+

+| 运算符 | 描述 |

+| --------- | -------------------------- |

+| `BETWEEN` | 在某个范围内 |

+| `IN` | 指定针对某个列的多个可能值 |

+

+- `IN` 操作符在 `WHERE` 子句中使用,作用是在指定的几个特定值中任选一个值。

+

+- `BETWEEN` 操作符在 `WHERE` 子句中使用,作用是选取介于某个范围内的值。

+

+**IN 示例**

+

+```sql

+SELECT *

+FROM products

+WHERE vend_id IN ('DLL01', 'BRS01');

+```

+

+**BETWEEN 示例**

+

+```sql

+SELECT *

+FROM products

+WHERE prod_price BETWEEN 3 AND 5;

+```

+

+### 逻辑操作符

+

+| 运算符 | 描述 |

+| ------ | ---------- |

+| `AND` | 并且(与) |

+| `OR` | 或者(或) |

+| `NOT` | 否定(非) |

+

+`AND`、`OR`、`NOT` 是用于对过滤条件的逻辑处理指令。

+

+- `AND` 优先级高于 `OR`,为了明确处理顺序,可以使用 `()`。`AND` 操作符表示左右条件都要满足。

+- `OR` 操作符表示左右条件满足任意一个即可。

+

+- `NOT` 操作符用于否定一个条件。

+

+**AND 示例**

+

+```sql

+SELECT prod_id, prod_name, prod_price

+FROM products

+WHERE vend_id = 'DLL01' AND prod_price <= 4;

+```

+

+**OR 示例**

+

+```sql

+SELECT prod_id, prod_name, prod_price

+FROM products

+WHERE vend_id = 'DLL01' OR vend_id = 'BRS01';

+```

+

+**NOT 示例**

+

+```sql

+SELECT *

+FROM products

+WHERE prod_price NOT BETWEEN 3 AND 5;

+```

+

+### 通配符

+

+| 运算符 | 描述 |

+| ------ | -------------------------- |

+| `LIKE` | 搜索某种模式 |

+| `%` | 表示任意字符出现任意次数 |

+| `_` | 表示任意字符出现一次 |

+| `[]` | 必须匹配指定位置的一个字符 |

+

+`LIKE` 操作符在 `WHERE` 子句中使用,作用是确定字符串是否匹配模式。只有字段是文本值时才使用 `LIKE`。

+

+`LIKE` 支持以下通配符匹配选项:

+

+- `%` 表示任何字符出现任意次数。

+- `_` 表示任何字符出现一次。

+- `[]` 必须匹配指定位置的一个字符。

+

+> 注意:**不要滥用通配符,通配符位于开头处匹配会非常慢**。

+

+`%` 示例:

+

+```sql

+SELECT prod_id, prod_name, prod_price

+FROM products

+WHERE prod_name LIKE '%bean bag%';

+```

+

+`_` 示例:

+

+```sql

+SELECT prod_id, prod_name, prod_price

+FROM products

+WHERE prod_name LIKE '__ inch teddy bear';

+```

+

+-

+

+## 排序(ORDER BY)

+

+> `ORDER BY` 用于对结果集进行排序。

+

+`ORDER BY` 有两种排序模式:

+

+- `ASC` :升序(默认)

+- `DESC` :降序

+

+可以按多个列进行排序,并且为每个列指定不同的排序方式。

+

+指定多个列的排序示例:

+

+```sql

+SELECT * FROM products

+ORDER BY prod_price DESC, prod_name ASC;

+```

+

+## 数据定义(CREATE、ALTER、DROP)

+

+> DDL 的主要功能是定义数据库对象(如:数据库、数据表、视图、索引等)。

+

+### 数据库(DATABASE)

+

+#### 创建数据库

+

+```sql

+CREATE DATABASE IF NOT EXISTS db_tutorial;

+```

+

+#### 删除数据库

+

+```sql

+DROP DATABASE IF EXISTS db_tutorial;

+```

+

+#### 选择数据库

+

+```sql

+USE db_tutorial;

+```

+

+### 数据表(TABLE)

+

+#### 删除数据表

+

+```sql

+DROP TABLE IF EXISTS user;

+DROP TABLE IF EXISTS vip_user;

+```

+

+#### 创建数据表

+

+**普通创建**

+

+```sql

+CREATE TABLE user (

+ id INT(10) UNSIGNED NOT NULL COMMENT 'Id',

+ username VARCHAR(64) NOT NULL DEFAULT 'default' COMMENT '用户名',

+ password VARCHAR(64) NOT NULL DEFAULT 'default' COMMENT '密码',

+ email VARCHAR(64) NOT NULL DEFAULT 'default' COMMENT '邮箱'

+) COMMENT ='用户表';

+```

+

+**根据已有的表创建新表**

+

+```sql

+CREATE TABLE vip_user AS

+SELECT *

+FROM user;

+```

+

+#### 修改数据表

+

+##### 添加列

+

+```sql

+ALTER TABLE user

+ADD age int(3);

+```

+

+##### 删除列

+

+```sql

+ALTER TABLE user

+DROP COLUMN age;

+```

+

+##### 修改列

+

+```sql

+ALTER TABLE `user`

+MODIFY COLUMN age tinyint;

+```

+

+### 视图(VIEW)

+

+> 视图是基于 SQL 语句的结果集的可视化的表。**视图是虚拟的表,本身不存储数据,也就不能对其进行索引操作**。对视图的操作和对普通表的操作一样。

+

+视图的作用:

+

+- 简化复杂的 SQL 操作,比如复杂的连接。

+- 只使用实际表的一部分数据。

+- 通过只给用户访问视图的权限,保证数据的安全性。

+- 更改数据格式和表示。

+

+#### 创建视图

+

+```sql

+CREATE VIEW top_10_user_view AS

+SELECT id, username

+FROM user

+WHERE id < 10;

+```

+

+#### 删除视图

+

+```sql

+DROP VIEW top_10_user_view;

+```

+

+### 索引(INDEX)

+

+> 通过索引可以更加快速高效地查询数据。用户无法看到索引,它们只能被用来加速查询。

+

+更新一个包含索引的表需要比更新一个没有索引的表花费更多的时间,这是由于索引本身也需要更新。因此,理想的做法是仅仅在常常被搜索的列(以及表)上面创建索引。

+

+唯一索引:唯一索引表明此索引的每一个索引值只对应唯一的数据记录。

+

+#### 创建索引

+

+```sql

+CREATE INDEX idx_email

+ ON user(email);

+```

+

+#### 创建唯一索引

+

+```sql

+CREATE UNIQUE INDEX uniq_username

+ ON user(username);

+```

+

+#### 删除索引

+

+```sql

+ALTER TABLE user

+DROP INDEX idx_email;

+ALTER TABLE user

+DROP INDEX uniq_username;

+```

+

+#### 添加主键

+

+```sql

+ALTER TABLE user

+ADD PRIMARY KEY (id);

+```

+

+#### 删除主键

+

+```sql

+ALTER TABLE user

+DROP PRIMARY KEY;

+```

+

+### 约束

+

+> SQL 约束用于规定表中的数据规则。

+

+- 如果存在违反约束的数据行为,行为会被约束终止。

+- 约束可以在创建表时规定(通过 CREATE TABLE 语句),或者在表创建之后规定(通过 ALTER TABLE 语句)。

+- 约束类型

+ - `NOT NULL` - 指示某列不能存储 NULL 值。

+ - `UNIQUE` - 保证某列的每行必须有唯一的值。

+ - `PRIMARY KEY` - NOT NULL 和 UNIQUE 的结合。确保某列(或两个列多个列的结合)有唯一标识,有助于更容易更快速地找到表中的一个特定的记录。

+ - `FOREIGN KEY` - 保证一个表中的数据匹配另一个表中的值的参照完整性。

+ - `CHECK` - 保证列中的值符合指定的条件。

+ - `DEFAULT` - 规定没有给列赋值时的默认值。

+

+创建表时使用约束条件:

+

+```sql

+CREATE TABLE Users (

+ Id INT(10) UNSIGNED NOT NULL AUTO_INCREMENT COMMENT '自增Id',

+ Username VARCHAR(64) NOT NULL UNIQUE DEFAULT 'default' COMMENT '用户名',

+ Password VARCHAR(64) NOT NULL DEFAULT 'default' COMMENT '密码',

+ Email VARCHAR(64) NOT NULL DEFAULT 'default' COMMENT '邮箱地址',

+ Enabled TINYINT(4) DEFAULT NULL COMMENT '是否有效',

+ PRIMARY KEY (Id)

+) ENGINE=InnoDB AUTO_INCREMENT=2 DEFAULT CHARSET=utf8mb4 COMMENT='用户表';

+```

+

+## 参考资料

+

+- [《SQL 必知必会》](https://book.douban.com/subject/35167240/)

+- [『浅入深出』MySQL 中事务的实现](https://draveness.me/mysql-transaction)

+- [MySQL 的学习--触发器](https://www.cnblogs.com/CraryPrimitiveMan/p/4206942.html)

+- [维基百科词条 - SQL](https://zh.wikipedia.org/wiki/SQL)

+- [https://www.sitesbay.com/sql/index](https://www.sitesbay.com/sql/index)

+- [SQL Subqueries](https://www.w3resource.com/sql/subqueries/understanding-sql-subqueries.php)

+- [Quick breakdown of the types of joins](https://stackoverflow.com/questions/6294778/mysql-quick-breakdown-of-the-types-of-joins)

+- [SQL UNION](https://www.w3resource.com/sql/sql-union.php)

+- [SQL database security](https://www.w3resource.com/sql/database-security/create-users.php)

+- [Mysql 中的存储过程](https://www.cnblogs.com/chenpi/p/5136483.html)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/01.综合/02.SqlCheatSheet.md b/docs/12.数据库/03.关系型数据库/01.综合/02.SqlCheatSheet.md

deleted file mode 100644

index d9ec04e..0000000

--- a/docs/12.数据库/03.关系型数据库/01.综合/02.SqlCheatSheet.md

+++ /dev/null

@@ -1,1119 +0,0 @@

----

-title: sql-cheat-sheet

-date: 2018-06-15 16:07:17

-categories:

- - 数据库

- - 关系型数据库

- - 综合

-tags:

- - 数据库

- - 关系型数据库

- - SQL

-permalink: /pages/b71c9e/

----

-

-# SQL Cheat Sheet

-

-> 本文针对关系型数据库的基本语法。限于篇幅,本文侧重说明用法,不会展开讲解特性、原理。

->

-> 本文语法主要针对 Mysql,但大部分的语法对其他关系型数据库也适用。

-

-

-

-## 一、基本概念

-

-### 数据库术语

-

-- `数据库(database)` - 保存有组织的数据的容器(通常是一个文件或一组文件)。

-- `数据表(table)` - 某种特定类型数据的结构化清单。

-- `模式(schema)` - 关于数据库和表的布局及特性的信息。模式定义了数据在表中如何存储,包含存储什么样的数据,数据如何分解,各部分信息如何命名等信息。数据库和表都有模式。

-- `列(column)` - 表中的一个字段。所有表都是由一个或多个列组成的。

-- `行(row)` - 表中的一个记录。

-- `主键(primary key)` - 一列(或一组列),其值能够唯一标识表中每一行。

-

-### SQL 语法

-

-> SQL(Structured Query Language),标准 SQL 由 ANSI 标准委员会管理,从而称为 ANSI SQL。各个 DBMS 都有自己的实现,如 PL/SQL、Transact-SQL 等。

-

-#### SQL 语法结构

-

-

-

-SQL 语法结构包括:

-

-- **`子句`** - 是语句和查询的组成成分。(在某些情况下,这些都是可选的。)

-- **`表达式`** - 可以产生任何标量值,或由列和行的数据库表

-- **`谓词`** - 给需要评估的 SQL 三值逻辑(3VL)(true/false/unknown)或布尔真值指定条件,并限制语句和查询的效果,或改变程序流程。

-- **`查询`** - 基于特定条件检索数据。这是 SQL 的一个重要组成部分。

-- **`语句`** - 可以持久地影响纲要和数据,也可以控制数据库事务、程序流程、连接、会话或诊断。

-

-#### SQL 语法要点

-

-- **SQL 语句不区分大小写**,但是数据库表名、列名和值是否区分,依赖于具体的 DBMS 以及配置。

-

-例如:`SELECT` 与 `select` 、`Select` 是相同的。

-

-- **多条 SQL 语句必须以分号(`;`)分隔**。

-

-- 处理 SQL 语句时,**所有空格都被忽略**。SQL 语句可以写成一行,也可以分写为多行。

-

-```sql

--- 一行 SQL 语句

-UPDATE user SET username='robot', password='robot' WHERE username = 'root';

-

--- 多行 SQL 语句

-UPDATE user

-SET username='robot', password='robot'

-WHERE username = 'root';

-```

-

-- SQL 支持三种注释

-

-```sql

-## 注释1

--- 注释2

-/* 注释3 */

-```

-

-#### SQL 分类

-

-#### 数据定义语言(DDL)

-

-数据定义语言(Data Definition Language,DDL)是 SQL 语言集中负责数据结构定义与数据库对象定义的语言。

-

-DDL 的主要功能是**定义数据库对象**。

-

-DDL 的核心指令是 `CREATE`、`ALTER`、`DROP`。

-

-#### 数据操纵语言(DML)

-

-数据操纵语言(Data Manipulation Language, DML)是用于数据库操作,对数据库其中的对象和数据运行访问工作的编程语句。

-

-DML 的主要功能是 **访问数据**,因此其语法都是以**读写数据库**为主。

-

-DML 的核心指令是 `INSERT`、`UPDATE`、`DELETE`、`SELECT`。这四个指令合称 CRUD(Create, Read, Update, Delete),即增删改查。

-

-#### 事务控制语言(TCL)

-

-事务控制语言 (Transaction Control Language, TCL) 用于**管理数据库中的事务**。这些用于管理由 DML 语句所做的更改。它还允许将语句分组为逻辑事务。

-

-TCL 的核心指令是 `COMMIT`、`ROLLBACK`。

-

-#### 数据控制语言(DCL)

-

-数据控制语言 (Data Control Language, DCL) 是一种可对数据访问权进行控制的指令,它可以控制特定用户账户对数据表、查看表、预存程序、用户自定义函数等数据库对象的控制权。

-

-DCL 的核心指令是 `GRANT`、`REVOKE`。

-

-DCL 以**控制用户的访问权限**为主,因此其指令作法并不复杂,可利用 DCL 控制的权限有:`CONNECT`、`SELECT`、`INSERT`、`UPDATE`、`DELETE`、`EXECUTE`、`USAGE`、`REFERENCES`。

-

-根据不同的 DBMS 以及不同的安全性实体,其支持的权限控制也有所不同。

-

----

-

-**(以下为 DML 语句用法)**

-

-## 二、增删改查

-

-> 增删改查,又称为 CRUD,数据库基本操作中的基本操作。

-

-### 插入数据

-

-> - `INSERT INTO` 语句用于向表中插入新记录。

-

-**插入完整的行**

-

-```sql

-INSERT INTO user

-VALUES (10, 'root', 'root', 'xxxx@163.com');

-```

-

-**插入行的一部分**

-

-```sql

-INSERT INTO user(username, password, email)

-VALUES ('admin', 'admin', 'xxxx@163.com');

-```

-

-**插入查询出来的数据**

-

-```sql

-INSERT INTO user(username)

-SELECT name

-FROM account;

-```

-

-### 更新数据

-

-> - `UPDATE` 语句用于更新表中的记录。

-

-```sql

-UPDATE user

-SET username='robot', password='robot'

-WHERE username = 'root';

-```

-

-### 删除数据

-

-> - `DELETE` 语句用于删除表中的记录。

-> - `TRUNCATE TABLE` 可以清空表,也就是删除所有行。

-

-**删除表中的指定数据**

-

-```sql

-DELETE FROM user

-WHERE username = 'robot';

-```

-

-**清空表中的数据**

-

-```sql

-TRUNCATE TABLE user;

-```

-

-### 查询数据

-

-> - `SELECT` 语句用于从数据库中查询数据。

-> - `DISTINCT` 用于返回唯一不同的值。它作用于所有列,也就是说所有列的值都相同才算相同。

-> - `LIMIT` 限制返回的行数。可以有两个参数,第一个参数为起始行,从 0 开始;第二个参数为返回的总行数。

-> - `ASC` :升序(默认)

-> - `DESC` :降序

-

-**查询单列**

-

-```sql

-SELECT prod_name

-FROM products;

-```

-

-**查询多列**

-

-```sql

-SELECT prod_id, prod_name, prod_price

-FROM products;

-```

-

-**查询所有列**

-

-```sql

-ELECT *

-FROM products;

-```

-

-**查询不同的值**

-

-```sql

-SELECT DISTINCT

-vend_id FROM products;

-```

-

-**限制查询结果**

-

-```sql

--- 返回前 5 行

-SELECT * FROM mytable LIMIT 5;

-SELECT * FROM mytable LIMIT 0, 5;

--- 返回第 3 ~ 5 行

-SELECT * FROM mytable LIMIT 2, 3;

-```

-

-## 三、子查询

-

-> 子查询是嵌套在较大查询中的 SQL 查询。子查询也称为**内部查询**或**内部选择**,而包含子查询的语句也称为**外部查询**或**外部选择**。

-

-- 子查询可以嵌套在 `SELECT`,`INSERT`,`UPDATE` 或 `DELETE` 语句内或另一个子查询中。

-

-- 子查询通常会在另一个 `SELECT` 语句的 `WHERE` 子句中添加。

-

-- 您可以使用比较运算符,如 `>`,`<`,或 `=`。比较运算符也可以是多行运算符,如 `IN`,`ANY` 或 `ALL`。

-

-- 子查询必须被圆括号 `()` 括起来。

-

-- 内部查询首先在其父查询之前执行,以便可以将内部查询的结果传递给外部查询。执行过程可以参考下图:

-

-

-  -

-

-

-**子查询的子查询**

-

-```sql

-SELECT cust_name, cust_contact

-FROM customers

-WHERE cust_id IN (SELECT cust_id

- FROM orders

- WHERE order_num IN (SELECT order_num

- FROM orderitems

- WHERE prod_id = 'RGAN01'));

-```

-

-### WHERE

-

-> `WHERE` 子句用于过滤记录,即缩小访问数据的范围。`WHERE` 后跟一个返回 `true` 或 `false` 的条件。

->

-> `WHERE` 可以与 `SELECT`,`UPDATE` 和 `DELETE` 一起使用。

-

-可以在 `WHERE` 子句中使用的操作符:

-

-| 运算符 | 描述 |

-| ------- | ------------------------------------------------------ |

-| = | 等于 |

-| <> | 不等于。注释:在 SQL 的一些版本中,该操作符可被写成 != |

-| > | 大于 |

-| < | 小于 |

-| >= | 大于等于 |

-| <= | 小于等于 |

-| BETWEEN | 在某个范围内 |

-| LIKE | 搜索某种模式 |

-| IN | 指定针对某个列的多个可能值 |

-

-**`SELECT` 语句中的 `WHERE` 子句**

-

-```sql

-SELECT * FROM Customers

-WHERE cust_name = 'Kids Place';

-```

-

-**`UPDATE` 语句中的 `WHERE` 子句**

-

-```sql

-UPDATE Customers

-SET cust_name = 'Jack Jones'

-WHERE cust_name = 'Kids Place';

-```

-

-**`DELETE` 语句中的 `WHERE` 子句**

-

-```sql

-DELETE FROM Customers

-WHERE cust_name = 'Kids Place';

-```

-

-### IN 和 BETWEEN

-

-> `IN` 操作符在 `WHERE` 子句中使用,作用是在指定的几个特定值中任选一个值。

->

-> `BETWEEN` 操作符在 `WHERE` 子句中使用,作用是选取介于某个范围内的值。

-

-**IN 示例**

-

-```sql

-SELECT *

-FROM products

-WHERE vend_id IN ('DLL01', 'BRS01');

-```

-

-**BETWEEN 示例**

-

-```sql

-SELECT *

-FROM products

-WHERE prod_price BETWEEN 3 AND 5;

-```

-

-### AND、OR、NOT

-

-> `AND`、`OR`、`NOT` 是用于对过滤条件的逻辑处理指令。

->

-> `AND` 优先级高于 `OR`,为了明确处理顺序,可以使用 `()`。`AND` 操作符表示左右条件都要满足。

->

-> `OR` 操作符表示左右条件满足任意一个即可。

->

-> `NOT` 操作符用于否定一个条件。

-

-**AND 示例**

-

-```sql

-SELECT prod_id, prod_name, prod_price

-FROM products

-WHERE vend_id = 'DLL01' AND prod_price <= 4;

-```

-

-**OR 示例**

-

-```sql

-SELECT prod_id, prod_name, prod_price

-FROM products

-WHERE vend_id = 'DLL01' OR vend_id = 'BRS01';

-```

-

-**NOT 示例**

-

-```sql

-SELECT *

-FROM products

-WHERE prod_price NOT BETWEEN 3 AND 5;

-```

-

-### LIKE

-

-> `LIKE` 操作符在 `WHERE` 子句中使用,作用是确定字符串是否匹配模式。只有字段是文本值时才使用 `LIKE`。

->

-> `LIKE` 支持两个通配符匹配选项:`%` 和 `_`。

->

-> - `%` 表示任何字符出现任意次数。

-> - `_` 表示任何字符出现一次。

->

-> 不要滥用通配符,通配符位于开头处匹配会非常慢。

-

-`%` 示例:

-

-```sql

-SELECT prod_id, prod_name, prod_price

-FROM products

-WHERE prod_name LIKE '%bean bag%';

-```

-

-`_` 示例:

-

-```sql

-SELECT prod_id, prod_name, prod_price

-FROM products

-WHERE prod_name LIKE '__ inch teddy bear';

-```

-

-## 四、连接和组合

-

-### 连接(JOIN)

-

-> 连接用于连接多个表,使用 `JOIN` 关键字,并且条件语句使用 `ON` 而不是 `WHERE`。

-

-如果一个 `JOIN` 至少有一个公共字段并且它们之间存在关系,则该 `JOIN` 可以在两个或多个表上工作。

-

-`JOIN` 保持基表(结构和数据)不变。**连接可以替换子查询,并且比子查询的效率一般会更快**。

-

-`JOIN` 有两种连接类型:内连接和外连接。

-

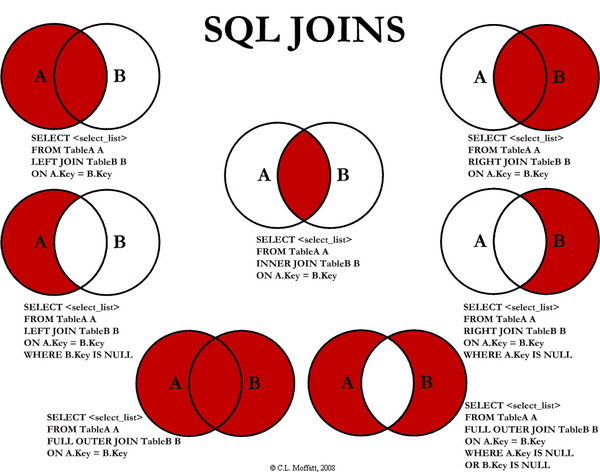

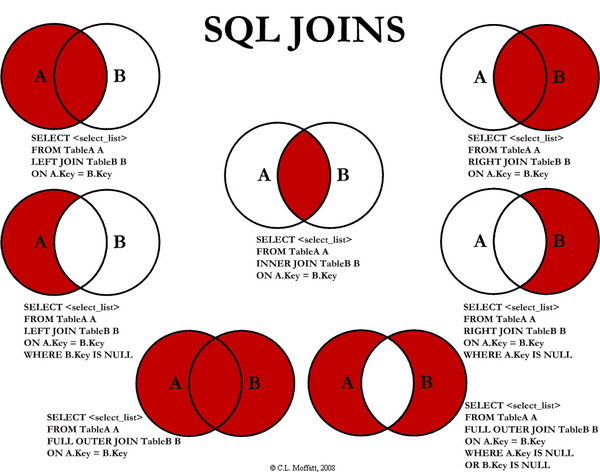

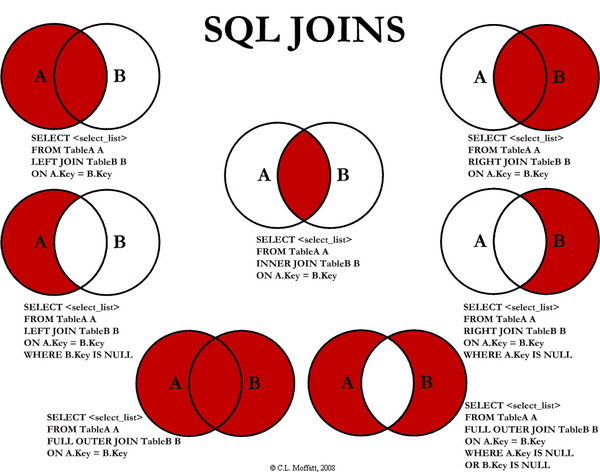

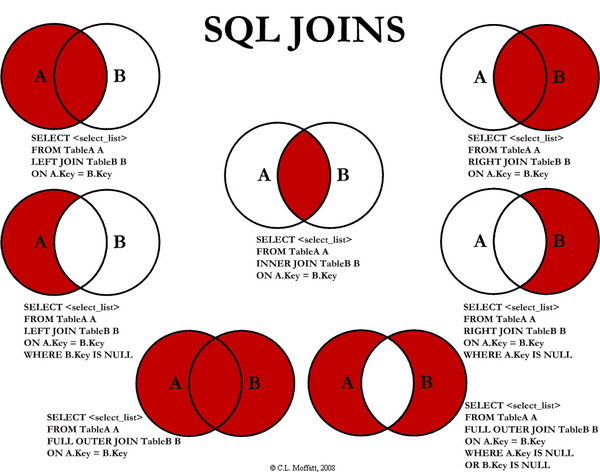

-

-

-

+

+

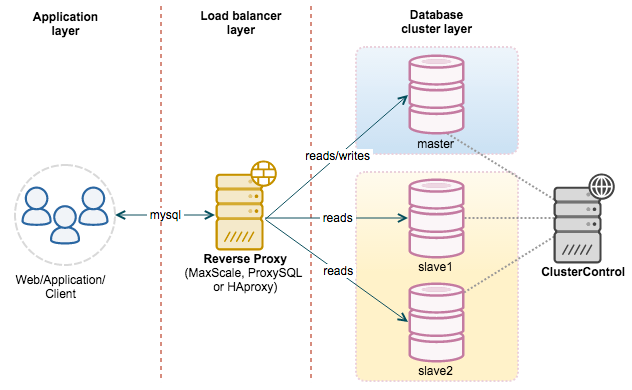

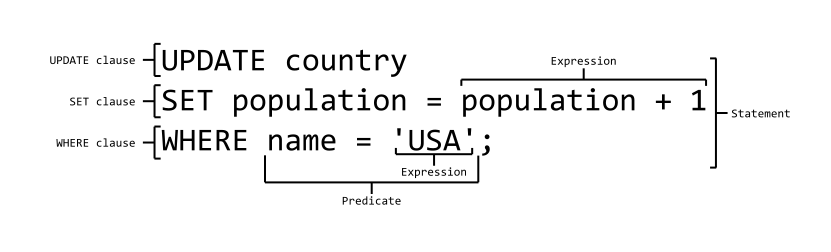

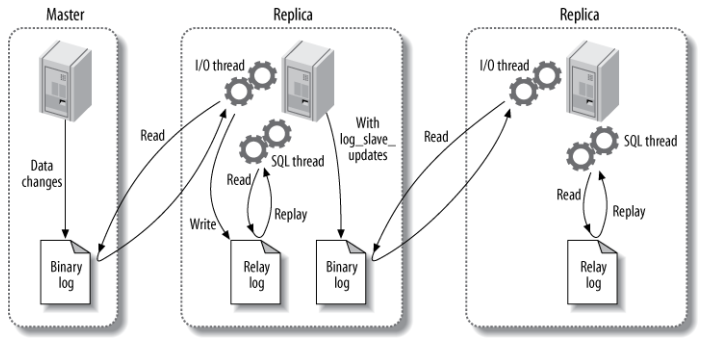

-### 8.2. 读写分离

+### 读写分离

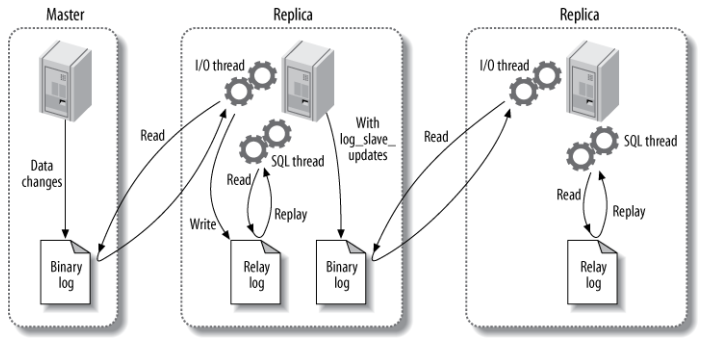

主服务器用来处理写操作以及实时性要求比较高的读操作,而从服务器用来处理读操作。

@@ -212,25 +212,14 @@ MySQL 读写分离能提高性能的原因在于:

-------

-(分割线)以下为高级特性,也是关系型数据库通用方案

-

-## 9. 分布式事务

-

-> 参考:[分布式事务基本原理](https://dunwu.github.io/blog/pages/e1881c/)

-

-## 10. 分库分表

-

-> 参考:[分库分表基本原理](https://dunwu.github.io/blog/pages/e1046e/)

-

-## 11. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

- [20+ 条 MySQL 性能优化的最佳经验](https://www.jfox.info/20-tiao-mysql-xing-nen-you-hua-de-zui-jia-jing-yan.html)

- [How to create unique row ID in sharded databases?](https://stackoverflow.com/questions/788829/how-to-create-unique-row-id-in-sharded-databases)

- [SQL Azure Federation – Introduction](http://geekswithblogs.net/shaunxu/archive/2012/01/07/sql-azure-federation-ndash-introduction.aspx)

-## 12. 传送门

+## 传送门

-◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

+◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md b/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md

index e39244b..d5019e2 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md

@@ -14,7 +14,7 @@ permalink: /pages/8262aa/

# MySQL 工作流

-## 1. 基础架构

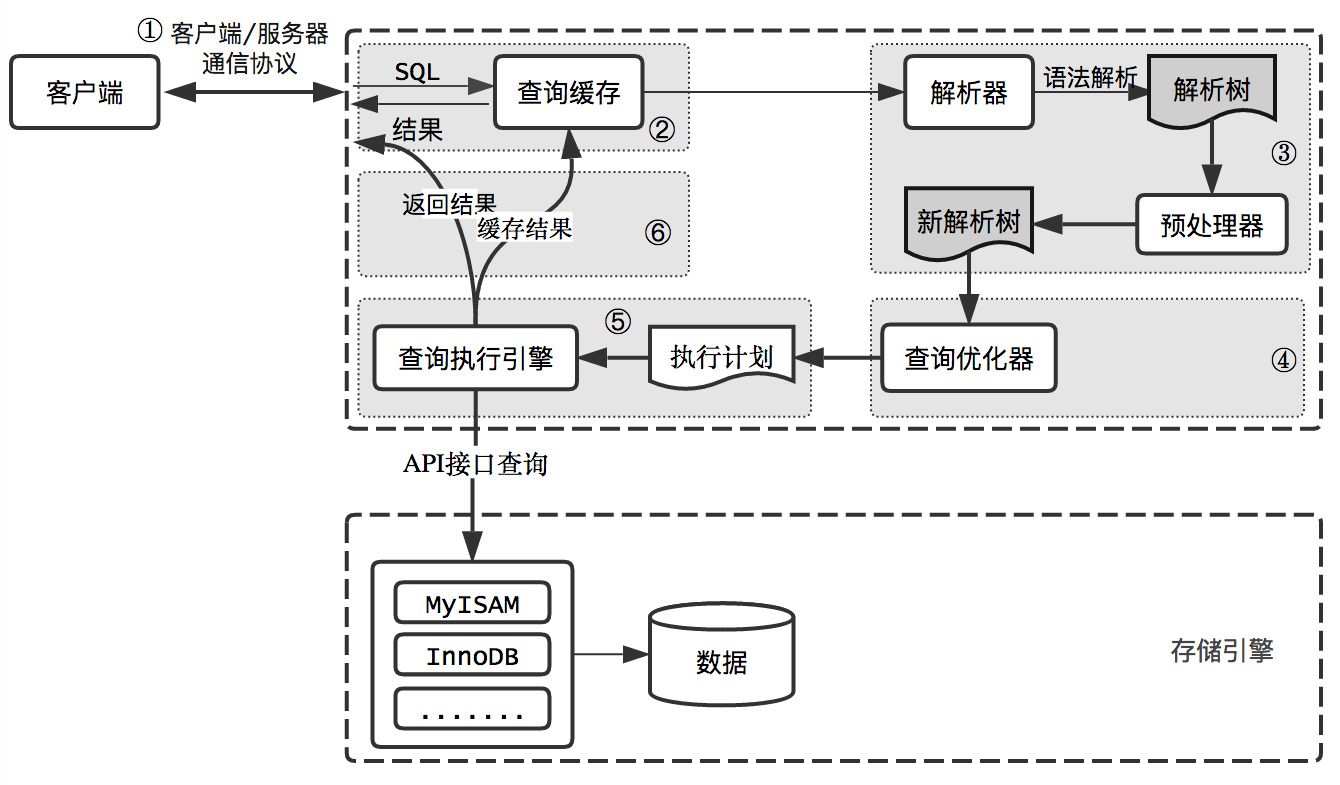

+## 基础架构

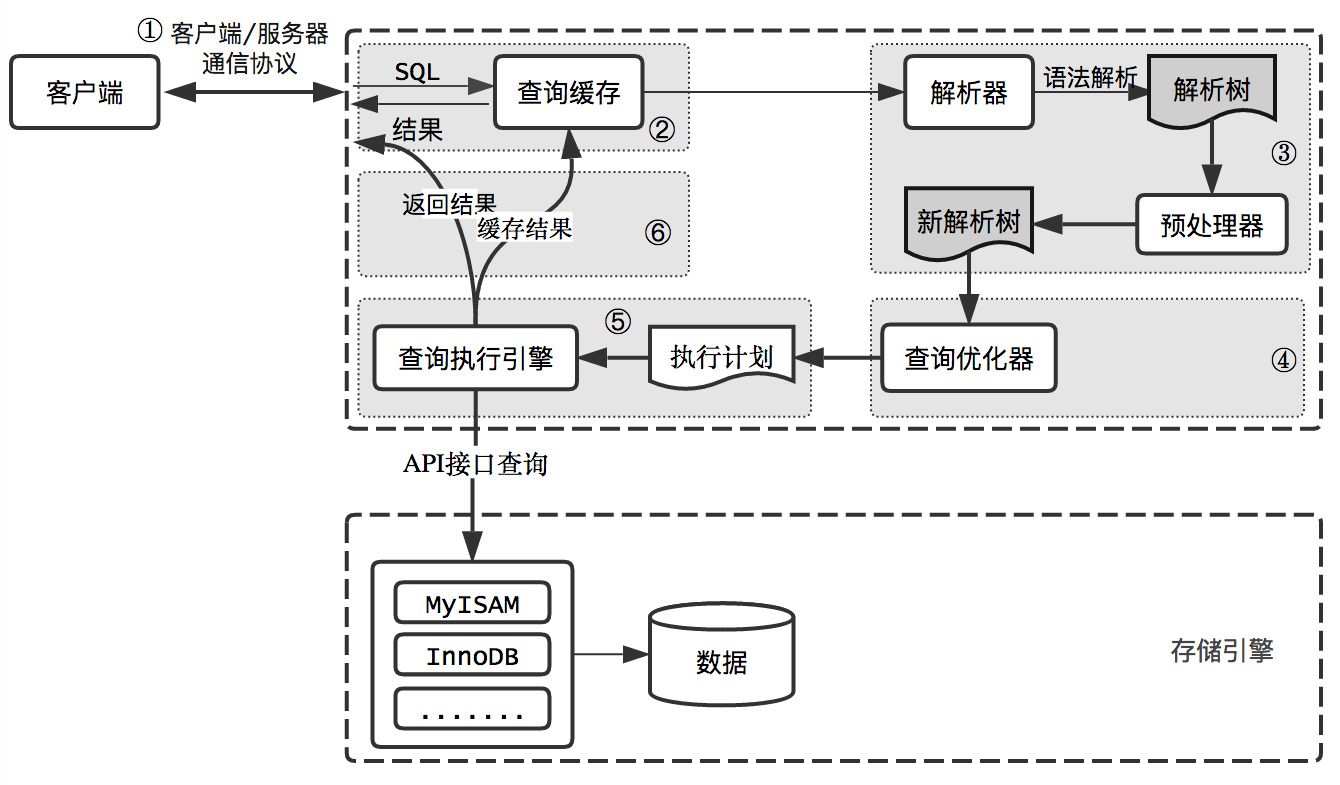

大体来说,MySQL 可以分为 Server 层和存储引擎层两部分。

@@ -24,22 +24,22 @@ permalink: /pages/8262aa/

-## 2. 查询过程

+## 查询过程

SQL 语句在 MySQL 中是如何执行的?

-MySQL 整个查询执行过程,总的来说分为 6 个步骤:

+MySQL 整个查询执行过程,总的来说分为 6 个步骤,分别对应 6 个组件:

-1. 客户端和 MySQL 服务器建立连接;客户端向 MySQL 服务器发送一条查询请求。

+1. 连接器:客户端和 MySQL 服务器建立连接;连接器负责跟客户端建立连接、获取权限、维持和管理连接。

2. MySQL 服务器首先检查查询缓存,如果命中缓存,则立刻返回结果。否则进入下一阶段。

3. MySQL 服务器进行 SQL 分析:语法分析、词法分析。

4. MySQL 服务器用优化器生成对应的执行计划。

5. MySQL 服务器根据执行计划,调用存储引擎的 API 来执行查询。

6. MySQL 服务器将结果返回给客户端,同时缓存查询结果。

-### 2.1. (一)连接

+### (一)连接器

-使用 MySQL 第一步自然是要连接数据库。

+使用 MySQL 第一步自然是要连接数据库。**连接器负责跟客户端建立连接、获取权限、维持和管理连接**。

MySQL 客户端/服务端通信是**半双工模式**:即任一时刻,要么是服务端向客户端发送数据,要么是客户端向服务器发送数据。客户端用一个单独的数据包将查询请求发送给服务器,所以当查询语句很长的时候,需要设置`max_allowed_packet`参数。但是需要注意的是,如果查询实在是太大,服务端会拒绝接收更多数据并抛出异常。

@@ -56,7 +56,7 @@ MySQL 客户端连接命令:`mysql -h<主机> -P<端口> -u<用户名> -p<密

- **定期断开长连接**。使用一段时间,或者程序里面判断执行过一个占用内存的大查询后,断开连接,之后要查询再重连。

- 如果你用的是 MySQL 5.7 或更新版本,可以在每次执行一个比较大的操作后,通过执行 `mysql_reset_connection` 来重新初始化连接资源。这个过程不需要重连和重新做权限验证,但是会将连接恢复到刚刚创建完时的状态。

-### 2.2. (二)查询缓存

+### (二)查询缓存

> **不建议使用数据库缓存,因为往往弊大于利**。

@@ -76,14 +76,14 @@ select SQL_CACHE * from T where ID=10;

> 注意:MySQL 8.0 版本直接将查询缓存的整块功能删掉了。

-### 2.3. (三)语法分析

+### (三)语法分析

如果没有命中查询缓存,就要开始真正执行语句了。首先,MySQL 需要知道你要做什么,因此需要对 SQL 语句做解析。MySQL 通过关键字对 SQL 语句进行解析,并生成一颗对应的语法解析树。这个过程中,分析器主要通过语法规则来验证和解析。比如 SQL 中是否使用了错误的关键字或者关键字的顺序是否正确等等。预处理则会根据 MySQL 规则进一步检查解析树是否合法。比如检查要查询的数据表和数据列是否存在等等。

- 分析器先会先做“**词法分析**”。你输入的是由多个字符串和空格组成的一条 SQL 语句,MySQL 需要识别出里面的字符串分别是什么,代表什么。MySQL 从你输入的"select"这个关键字识别出来,这是一个查询语句。它也要把字符串“T”识别成“表名 T”,把字符串“ID”识别成“列 ID”。

- 接下来,要做“**语法分析**”。根据词法分析的结果,语法分析器会根据语法规则,判断你输入的这个 SQL 语句是否满足 MySQL 语法。如果你的语句不对,就会收到“You have an error in your SQL syntax”的错误提醒,比如下面这个语句 select 少打了开头的字母“s”。

-### 2.4. (四)查询优化

+### (四)查询优化

经过了分析器,MySQL 就知道你要做什么了。在开始执行之前,还要先经过优化器的处理。

@@ -116,11 +116,11 @@ MySQL 的查询优化器是一个非常复杂的部件,它使用了非常多

随着 MySQL 的不断发展,优化器使用的优化策略也在不断的进化,这里仅仅介绍几个非常常用且容易理解的优化策略,其他的优化策略,大家自行查阅吧。

-### 2.5. (五)查询执行引擎

+### (五)查询执行引擎

在完成解析和优化阶段以后,MySQL 会生成对应的执行计划,查询执行引擎根据执行计划给出的指令逐步执行得出结果。整个执行过程的大部分操作均是通过调用存储引擎实现的接口来完成,这些接口被称为`handler API`。查询过程中的每一张表由一个`handler`实例表示。实际上,MySQL 在查询优化阶段就为每一张表创建了一个`handler`实例,优化器可以根据这些实例的接口来获取表的相关信息,包括表的所有列名、索引统计信息等。存储引擎接口提供了非常丰富的功能,但其底层仅有几十个接口,这些接口像搭积木一样完成了一次查询的大部分操作。

-### 2.6. (六)返回结果

+### (六)返回结果

查询过程的最后一个阶段就是将结果返回给客户端。即使查询不到数据,MySQL 仍然会返回这个查询的相关信息,比如该查询影响到的行数以及执行时间等等。

@@ -128,11 +128,11 @@ MySQL 的查询优化器是一个非常复杂的部件,它使用了非常多

结果集返回客户端是一个增量且逐步返回的过程。有可能 MySQL 在生成第一条结果时,就开始向客户端逐步返回结果集了。这样服务端就无须存储太多结果而消耗过多内存,也可以让客户端第一时间获得返回结果。需要注意的是,结果集中的每一行都会以一个满足 ① 中所描述的通信协议的数据包发送,再通过 TCP 协议进行传输,在传输过程中,可能对 MySQL 的数据包进行缓存然后批量发送。

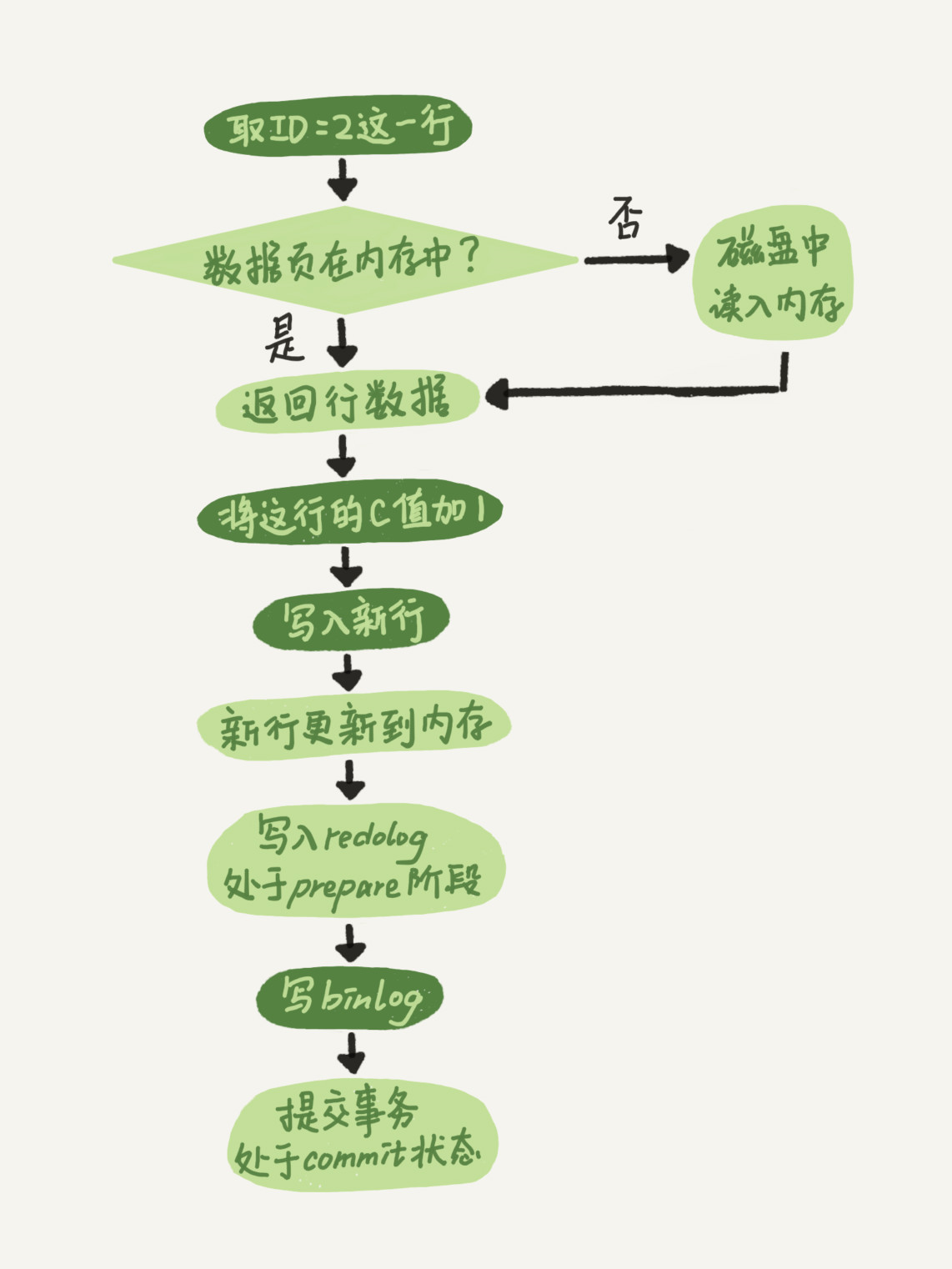

-## 3. 更新过程

+## 更新过程

MySQL 更新过程和 MySQL 查询过程类似,也会将流程走一遍。不一样的是:**更新流程还涉及两个重要的日志模块,:redo log(重做日志)和 binlog(归档日志)**。

-### 3.1. redo log

+### redo log

**redo log 是 InnoDB 引擎特有的日志**。**redo log 即重做日志**。redo log 是物理日志,记录的是“在某个数据页上做了什么修改”。

@@ -144,7 +144,7 @@ InnoDB 的 redo log 是固定大小的,比如可以配置为一组 4 个文件

有了 redo log,InnoDB 就可以保证即使数据库发生异常重启,之前提交的记录都不会丢失,这个能力称为**crash-safe**。

-### 3.2. bin log

+### bin log

**bin log 即归档日志**。binlog 是逻辑日志,记录的是这个语句的原始逻辑。

@@ -154,7 +154,7 @@ binlog 是可以追加写入的,即写到一定大小后会切换到下一个

`sync_binlog` 这个参数设置成 1 的时候,表示每次事务的 binlog 都持久化到磁盘。这个参数我也建议你设置成 1,这样可以保证 MySQL 异常重启之后 binlog 不丢失。

-### 3.3. redo log vs. bin log

+### redo log vs. bin log

这两种日志有以下三点不同。

@@ -174,7 +174,7 @@ binlog 是可以追加写入的,即写到一定大小后会切换到下一个

-### 3.4. 两阶段提交

+### 两阶段提交

redo log 的写入拆成了两个步骤:prepare 和 commit,这就是"两阶段提交"。为什么日志需要“两阶段提交”。

@@ -187,7 +187,7 @@ redo log 的写入拆成了两个步骤:prepare 和 commit,这就是"两阶

可以看到,如果不使用“两阶段提交”,那么数据库的状态就有可能和用它的日志恢复出来的库的状态不一致。

-## 4. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

-- [MySQL 实战 45 讲](https://time.geekbang.org/column/intro/139)

+- [MySQL 实战 45 讲](https://time.geekbang.org/column/intro/139)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md b/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md

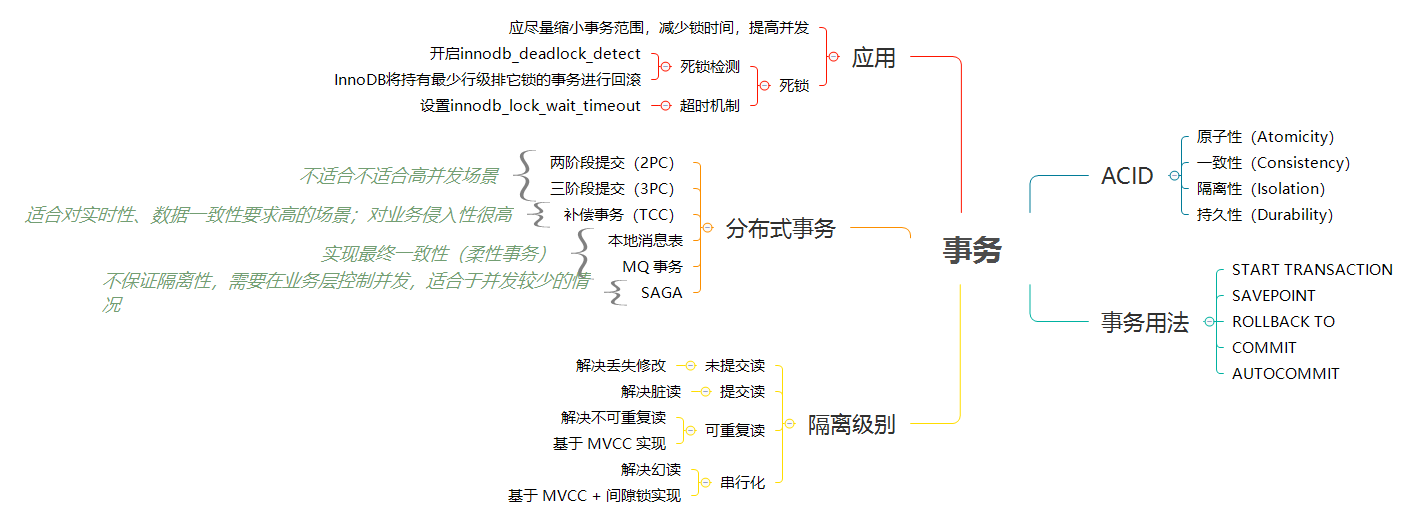

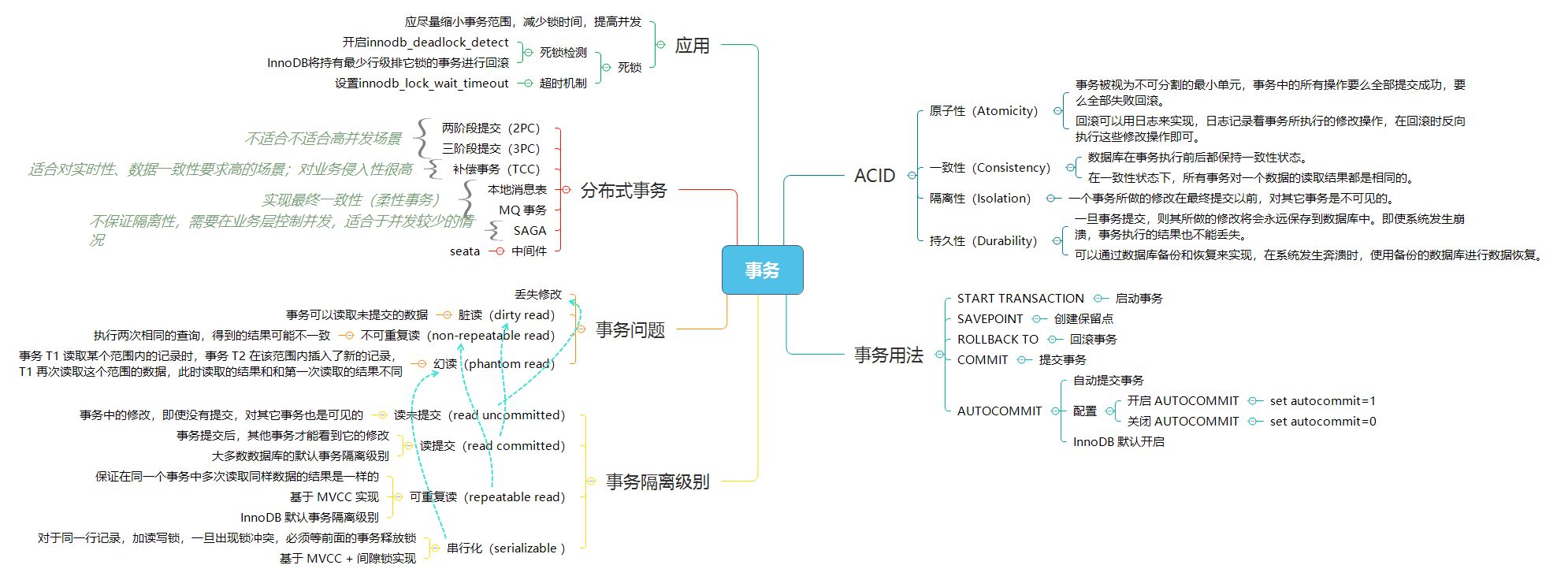

index 16f761f..e0c2df9 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md

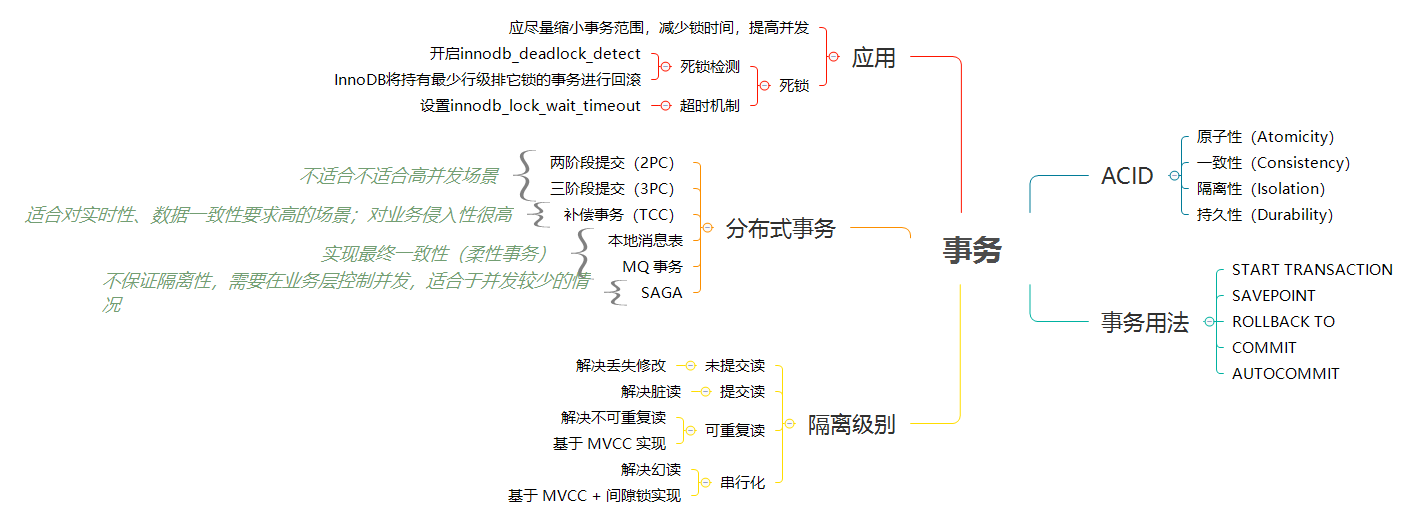

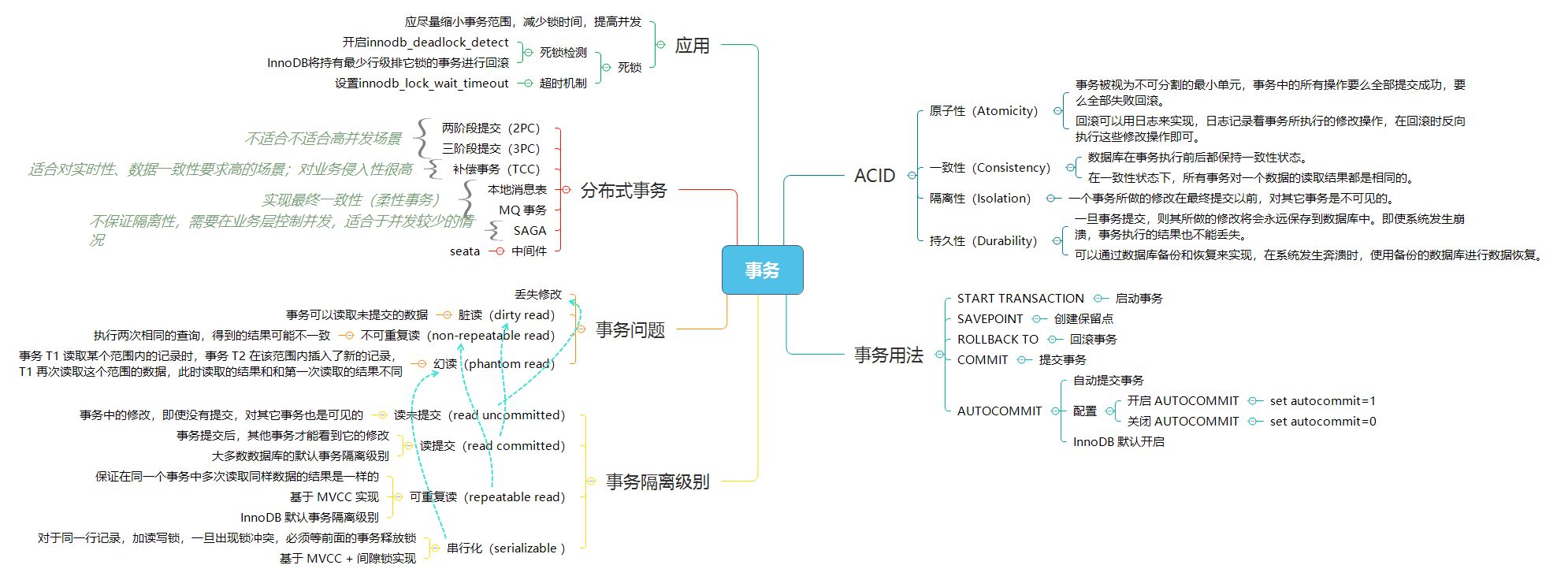

@@ -19,9 +19,9 @@ permalink: /pages/00b04d/

>

> 用户可以根据业务是否需要事务处理(事务处理可以保证数据安全,但会增加系统开销),选择合适的存储引擎。

-

+

-## 1. 事务简介

+## 事务简介

> 事务简单来说:**一个 Session 中所进行所有的操作,要么同时成功,要么同时失败**。进一步说,事务指的是满足 ACID 特性的一组操作,可以通过 `Commit` 提交一个事务,也可以使用 `Rollback` 进行回滚。

@@ -39,9 +39,9 @@ T1 和 T2 两个线程都对一个数据进行修改,T

-### 8.2. 读写分离

+### 读写分离

主服务器用来处理写操作以及实时性要求比较高的读操作,而从服务器用来处理读操作。

@@ -212,25 +212,14 @@ MySQL 读写分离能提高性能的原因在于:

-------

-(分割线)以下为高级特性,也是关系型数据库通用方案

-

-## 9. 分布式事务

-

-> 参考:[分布式事务基本原理](https://dunwu.github.io/blog/pages/e1881c/)

-

-## 10. 分库分表

-

-> 参考:[分库分表基本原理](https://dunwu.github.io/blog/pages/e1046e/)

-

-## 11. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

- [20+ 条 MySQL 性能优化的最佳经验](https://www.jfox.info/20-tiao-mysql-xing-nen-you-hua-de-zui-jia-jing-yan.html)

- [How to create unique row ID in sharded databases?](https://stackoverflow.com/questions/788829/how-to-create-unique-row-id-in-sharded-databases)

- [SQL Azure Federation – Introduction](http://geekswithblogs.net/shaunxu/archive/2012/01/07/sql-azure-federation-ndash-introduction.aspx)

-## 12. 传送门

+## 传送门

-◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

+◾ 💧 [钝悟的 IT 知识图谱](https://dunwu.github.io/waterdrop/) ◾ 🎯 [钝悟的博客](https://dunwu.github.io/blog/) ◾

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md b/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md

index e39244b..d5019e2 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/02.MySQL工作流.md

@@ -14,7 +14,7 @@ permalink: /pages/8262aa/

# MySQL 工作流

-## 1. 基础架构

+## 基础架构

大体来说,MySQL 可以分为 Server 层和存储引擎层两部分。

@@ -24,22 +24,22 @@ permalink: /pages/8262aa/

-## 2. 查询过程

+## 查询过程

SQL 语句在 MySQL 中是如何执行的?

-MySQL 整个查询执行过程,总的来说分为 6 个步骤:

+MySQL 整个查询执行过程,总的来说分为 6 个步骤,分别对应 6 个组件:

-1. 客户端和 MySQL 服务器建立连接;客户端向 MySQL 服务器发送一条查询请求。

+1. 连接器:客户端和 MySQL 服务器建立连接;连接器负责跟客户端建立连接、获取权限、维持和管理连接。

2. MySQL 服务器首先检查查询缓存,如果命中缓存,则立刻返回结果。否则进入下一阶段。

3. MySQL 服务器进行 SQL 分析:语法分析、词法分析。

4. MySQL 服务器用优化器生成对应的执行计划。

5. MySQL 服务器根据执行计划,调用存储引擎的 API 来执行查询。

6. MySQL 服务器将结果返回给客户端,同时缓存查询结果。

-### 2.1. (一)连接

+### (一)连接器

-使用 MySQL 第一步自然是要连接数据库。

+使用 MySQL 第一步自然是要连接数据库。**连接器负责跟客户端建立连接、获取权限、维持和管理连接**。

MySQL 客户端/服务端通信是**半双工模式**:即任一时刻,要么是服务端向客户端发送数据,要么是客户端向服务器发送数据。客户端用一个单独的数据包将查询请求发送给服务器,所以当查询语句很长的时候,需要设置`max_allowed_packet`参数。但是需要注意的是,如果查询实在是太大,服务端会拒绝接收更多数据并抛出异常。

@@ -56,7 +56,7 @@ MySQL 客户端连接命令:`mysql -h<主机> -P<端口> -u<用户名> -p<密

- **定期断开长连接**。使用一段时间,或者程序里面判断执行过一个占用内存的大查询后,断开连接,之后要查询再重连。

- 如果你用的是 MySQL 5.7 或更新版本,可以在每次执行一个比较大的操作后,通过执行 `mysql_reset_connection` 来重新初始化连接资源。这个过程不需要重连和重新做权限验证,但是会将连接恢复到刚刚创建完时的状态。

-### 2.2. (二)查询缓存

+### (二)查询缓存

> **不建议使用数据库缓存,因为往往弊大于利**。

@@ -76,14 +76,14 @@ select SQL_CACHE * from T where ID=10;

> 注意:MySQL 8.0 版本直接将查询缓存的整块功能删掉了。

-### 2.3. (三)语法分析

+### (三)语法分析

如果没有命中查询缓存,就要开始真正执行语句了。首先,MySQL 需要知道你要做什么,因此需要对 SQL 语句做解析。MySQL 通过关键字对 SQL 语句进行解析,并生成一颗对应的语法解析树。这个过程中,分析器主要通过语法规则来验证和解析。比如 SQL 中是否使用了错误的关键字或者关键字的顺序是否正确等等。预处理则会根据 MySQL 规则进一步检查解析树是否合法。比如检查要查询的数据表和数据列是否存在等等。

- 分析器先会先做“**词法分析**”。你输入的是由多个字符串和空格组成的一条 SQL 语句,MySQL 需要识别出里面的字符串分别是什么,代表什么。MySQL 从你输入的"select"这个关键字识别出来,这是一个查询语句。它也要把字符串“T”识别成“表名 T”,把字符串“ID”识别成“列 ID”。

- 接下来,要做“**语法分析**”。根据词法分析的结果,语法分析器会根据语法规则,判断你输入的这个 SQL 语句是否满足 MySQL 语法。如果你的语句不对,就会收到“You have an error in your SQL syntax”的错误提醒,比如下面这个语句 select 少打了开头的字母“s”。

-### 2.4. (四)查询优化

+### (四)查询优化

经过了分析器,MySQL 就知道你要做什么了。在开始执行之前,还要先经过优化器的处理。

@@ -116,11 +116,11 @@ MySQL 的查询优化器是一个非常复杂的部件,它使用了非常多

随着 MySQL 的不断发展,优化器使用的优化策略也在不断的进化,这里仅仅介绍几个非常常用且容易理解的优化策略,其他的优化策略,大家自行查阅吧。

-### 2.5. (五)查询执行引擎

+### (五)查询执行引擎

在完成解析和优化阶段以后,MySQL 会生成对应的执行计划,查询执行引擎根据执行计划给出的指令逐步执行得出结果。整个执行过程的大部分操作均是通过调用存储引擎实现的接口来完成,这些接口被称为`handler API`。查询过程中的每一张表由一个`handler`实例表示。实际上,MySQL 在查询优化阶段就为每一张表创建了一个`handler`实例,优化器可以根据这些实例的接口来获取表的相关信息,包括表的所有列名、索引统计信息等。存储引擎接口提供了非常丰富的功能,但其底层仅有几十个接口,这些接口像搭积木一样完成了一次查询的大部分操作。

-### 2.6. (六)返回结果

+### (六)返回结果

查询过程的最后一个阶段就是将结果返回给客户端。即使查询不到数据,MySQL 仍然会返回这个查询的相关信息,比如该查询影响到的行数以及执行时间等等。

@@ -128,11 +128,11 @@ MySQL 的查询优化器是一个非常复杂的部件,它使用了非常多

结果集返回客户端是一个增量且逐步返回的过程。有可能 MySQL 在生成第一条结果时,就开始向客户端逐步返回结果集了。这样服务端就无须存储太多结果而消耗过多内存,也可以让客户端第一时间获得返回结果。需要注意的是,结果集中的每一行都会以一个满足 ① 中所描述的通信协议的数据包发送,再通过 TCP 协议进行传输,在传输过程中,可能对 MySQL 的数据包进行缓存然后批量发送。

-## 3. 更新过程

+## 更新过程

MySQL 更新过程和 MySQL 查询过程类似,也会将流程走一遍。不一样的是:**更新流程还涉及两个重要的日志模块,:redo log(重做日志)和 binlog(归档日志)**。

-### 3.1. redo log

+### redo log

**redo log 是 InnoDB 引擎特有的日志**。**redo log 即重做日志**。redo log 是物理日志,记录的是“在某个数据页上做了什么修改”。

@@ -144,7 +144,7 @@ InnoDB 的 redo log 是固定大小的,比如可以配置为一组 4 个文件

有了 redo log,InnoDB 就可以保证即使数据库发生异常重启,之前提交的记录都不会丢失,这个能力称为**crash-safe**。

-### 3.2. bin log

+### bin log

**bin log 即归档日志**。binlog 是逻辑日志,记录的是这个语句的原始逻辑。

@@ -154,7 +154,7 @@ binlog 是可以追加写入的,即写到一定大小后会切换到下一个

`sync_binlog` 这个参数设置成 1 的时候,表示每次事务的 binlog 都持久化到磁盘。这个参数我也建议你设置成 1,这样可以保证 MySQL 异常重启之后 binlog 不丢失。

-### 3.3. redo log vs. bin log

+### redo log vs. bin log

这两种日志有以下三点不同。

@@ -174,7 +174,7 @@ binlog 是可以追加写入的,即写到一定大小后会切换到下一个

-### 3.4. 两阶段提交

+### 两阶段提交

redo log 的写入拆成了两个步骤:prepare 和 commit,这就是"两阶段提交"。为什么日志需要“两阶段提交”。

@@ -187,7 +187,7 @@ redo log 的写入拆成了两个步骤:prepare 和 commit,这就是"两阶

可以看到,如果不使用“两阶段提交”,那么数据库的状态就有可能和用它的日志恢复出来的库的状态不一致。

-## 4. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

-- [MySQL 实战 45 讲](https://time.geekbang.org/column/intro/139)

+- [MySQL 实战 45 讲](https://time.geekbang.org/column/intro/139)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md b/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md

index 16f761f..e0c2df9 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/03.Mysql事务.md

@@ -19,9 +19,9 @@ permalink: /pages/00b04d/

>

> 用户可以根据业务是否需要事务处理(事务处理可以保证数据安全,但会增加系统开销),选择合适的存储引擎。

-

+

-## 1. 事务简介

+## 事务简介

> 事务简单来说:**一个 Session 中所进行所有的操作,要么同时成功,要么同时失败**。进一步说,事务指的是满足 ACID 特性的一组操作,可以通过 `Commit` 提交一个事务,也可以使用 `Rollback` 进行回滚。

@@ -39,9 +39,9 @@ T1 和 T2 两个线程都对一个数据进行修改,T MySQL 默认采用自动提交模式(`AUTO COMMIT`)。也就是说,如果不显式使用 `START TRANSACTION` 语句来开始一个事务,那么每个查询操作都会被当做一个事务并自动提交。

-## 4. 事务隔离级别

+## 事务隔离级别

-### 4.1. 事务隔离简介

+### 事务隔离简介

在并发环境下,事务的隔离性很难保证,因此会出现很多并发一致性问题:

@@ -160,8 +160,8 @@ ACID 是数据库事务正确执行的四个基本要素。

在 SQL 标准中,定义了四种事务隔离级别(级别由低到高):

-- **未提交读**

-- **提交读**

+- **读未提交**

+- **读提交**

- **可重复读**

- **串行化**

@@ -184,63 +184,61 @@ SET SESSION TRANSACTION ISOLATION LEVEL REPEATABLE READ;

SET SESSION TRANSACTION ISOLATION LEVEL SERIALIZABLE;

```

-### 4.2. 未提交读

+### 读未提交

-**`未提交读(READ UNCOMMITTED)` 是指:事务中的修改,即使没有提交,对其它事务也是可见的**。

+**`读未提交(read uncommitted)` 是指:事务中的修改,即使没有提交,对其它事务也是可见的**。

-未提交读的问题:事务可以读取未提交的数据,也被称为 **脏读(Dirty Read)**。

+读未提交的问题:事务可以读取未提交的数据,也被称为 **脏读(Dirty Read)**。

T1 修改一个数据,T2 随后读取这个数据。如果 T1 撤销了这次修改,那么 T2 读取的数据是脏数据。

-### 4.3. 提交读

+### 读提交

-**`提交读(READ COMMITTED)` 是指:事务提交后,其他事务才能看到它的修改**。换句话说,一个事务所做的修改在提交之前对其它事务是不可见的。提交读解决了脏读的问题。

+**`读提交(read committed)` 是指:事务提交后,其他事务才能看到它的修改**。换句话说,一个事务所做的修改在提交之前对其它事务是不可见的。读提交解决了脏读的问题。

-提交读是大多数数据库的默认事务隔离级别。

+读提交是大多数数据库的默认事务隔离级别。

-提交读有时也叫不可重复读,它的问题是:执行两次相同的查询,得到的结果可能不一致。

+读提交有时也叫不可重复读,它的问题是:执行两次相同的查询,得到的结果可能不一致。

T2 读取一个数据,T1 对该数据做了修改。如果 T2 再次读取这个数据,此时读取的结果和第一次读取的结果不同。

-### 4.4. 可重复读

+### 可重复读

**`可重复读(REPEATABLE READ)` 是指:保证在同一个事务中多次读取同样数据的结果是一样的**。可重复读解决了不可重复读问题。

可重复读是 Mysql 的默认事务隔离级别。

-可重复读的问题:当某个事务读取某个范围内的记录时,另外一个事务又在该范围内插入了新的记录,当之前的事务又再次读取该范围的记录时,会产生 **幻读(Phantom Read)**。

-

-T1 读取某个范围的数据,T2 在这个范围内插入新的数据,T1 再次读取这个范围的数据,此时读取的结果和和第一次读取的结果不同。

+可重复读的问题:事务 T1 读取某个范围内的记录时,事务 T2 在该范围内插入了新的记录,T1 再次读取这个范围的数据,此时读取的结果和和第一次读取的结果不同,即为 **幻读(Phantom Read)**。

-### 4.5. 串行化

+### 串行化

-**`串行化(SERIALIXABLE)` 是指:强制事务串行执行**。

+**`串行化(SERIALIXABLE)` 是指:强制事务串行执行,对于同一行记录,加读写锁,一旦出现锁冲突,必须等前面的事务释放锁**。

强制事务串行执行,则避免了所有的并发问题。串行化策略会在读取的每一行数据上都加锁,这可能导致大量的超时和锁竞争。这对于高并发应用基本上是不可接受的,所以一般不会采用这个级别。

-### 4.6. 隔离级别小结

+### 隔离级别小结

-- **`未提交读(READ UNCOMMITTED)`** - 事务中的修改,即使没有提交,对其它事务也是可见的。

-- **`提交读(READ COMMITTED)`** - 一个事务只能读取已经提交的事务所做的修改。换句话说,一个事务所做的修改在提交之前对其它事务是不可见的。

+- **`读未提交(READ UNCOMMITTED)`** - 事务中的修改,即使没有提交,对其它事务也是可见的。

+- **`读提交(READ COMMITTED)`** - 一个事务只能读取已经提交的事务所做的修改。换句话说,一个事务所做的修改在提交之前对其它事务是不可见的。

- **`重复读(REPEATABLE READ)`** - 保证在同一个事务中多次读取同样数据的结果是一样的。

-- **`串行化(SERIALIXABLE)`** - 强制事务串行执行。

+- **`串行化(SERIALIXABLE)`** - 对于同一行记录,加读写锁,一旦出现锁冲突,必须等前面的事务释放锁。

数据库隔离级别解决的问题:

| 隔离级别 | 丢失修改 | 脏读 | 不可重复读 | 幻读 |

| :------: | :------: | :--: | :--------: | :--: |

-| 未提交读 | ✔️ | ❌ | ❌ | ❌ |

-| 提交读 | ✔️ | ✔️ | ❌ | ❌ |

+| 读未提交 | ✔️ | ❌ | ❌ | ❌ |

+| 读提交 | ✔️ | ✔️ | ❌ | ❌ |

| 可重复读 | ✔️ | ✔️ | ✔️ | ❌ |

| 可串行化 | ✔️ | ✔️ | ✔️ | ✔️ |

-## 5. 死锁

+## 死锁

**死锁是指两个或多个事务竞争同一资源,并请求锁定对方占用的资源,从而导致恶性循环的现象**。

@@ -250,7 +248,7 @@ T1 读取某个范围的数据,T2 在这个范围内插

- 多个事务同时锁定同一个资源时,也会产生死锁。

-### 5.1. 死锁的原因

+### 死锁的原因

行锁的具体实现算法有三种:record lock、gap lock 以及 next-key lock。record lock 是专门对索引项加锁;gap lock 是对索引项之间的间隙加锁;next-key lock 则是前面两种的组合,对索引项以其之间的间隙加锁。

@@ -282,7 +280,7 @@ InnoDB 存储引擎的主键索引为聚簇索引,其它索引为辅助索引

综上可知,在更新操作时,我们应该尽量使用主键来更新表字段,这样可以有效避免一些不必要的死锁发生。

-### 5.2. 避免死锁

+### 避免死锁

预防死锁的注意事项:

@@ -296,7 +294,7 @@ InnoDB 存储引擎的主键索引为聚簇索引,其它索引为辅助索引

我们还可以使用其它的方式来代替数据库实现幂等性校验。例如,使用 Redis 以及 ZooKeeper 来实现,运行效率比数据库更佳。

-### 5.3. 解决死锁

+### 解决死锁

当出现死锁以后,有两种策略:

@@ -311,7 +309,7 @@ InnoDB 存储引擎的主键索引为聚簇索引,其它索引为辅助索引

主动死锁检测在发生死锁的时候,是能够快速发现并进行处理的,但是它也是有额外负担的。你可以想象一下这个过程:每当一个事务被锁的时候,就要看看它所依赖的线程有没有被别人锁住,如此循环,最后判断是否出现了循环等待,也就是死锁。

-## 6. 分布式事务

+## 分布式事务

在单一数据节点中,事务仅限于对单一数据库资源的访问控制,称之为 **本地事务**。几乎所有的成熟的关系型数据库都提供了对本地事务的原生支持。

@@ -338,19 +336,19 @@ InnoDB 存储引擎的主键索引为聚簇索引,其它索引为辅助索引

> 分布式事务详细说明、分析请参考:[分布式事务基本原理](https://dunwu.github.io/blog/pages/e1881c/)

-## 7. 事务最佳实践

+## 事务最佳实践

高并发场景下的事务到底该如何调优?

-### 7.1. 尽量使用低级别事务隔离

+### 尽量使用低级别事务隔离

结合业务场景,尽量使用低级别事务隔离

-### 7.2. 避免行锁升级表锁

+### 避免行锁升级表锁

在 InnoDB 中,行锁是通过索引实现的,如果不通过索引条件检索数据,行锁将会升级到表锁。我们知道,表锁是会严重影响到整张表的操作性能的,所以应该尽力避免。

-### 7.3. 缩小事务范围

+### 缩小事务范围

有时候,数据库并发访问量太大,会出现以下异常:

@@ -370,8 +368,8 @@ MySQLQueryInterruptedException: Query execution was interrupted

知道了这个设定,对我们使用事务有什么帮助呢?那就是,如果你的事务中需要锁多个行,要把最可能造成锁冲突、最可能影响并发度的锁尽量往后放。

-## 8. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

- [《Java 性能调优实战》](https://time.geekbang.org/column/intro/100028001)

-- [ShardingSphere 分布式事务](https://shardingsphere.apache.org/document/current/cn/features/transaction/)

+- [ShardingSphere 分布式事务](https://shardingsphere.apache.org/document/current/cn/features/transaction/)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/04.Mysql锁.md b/docs/12.数据库/03.关系型数据库/02.Mysql/04.Mysql锁.md

index 866e9c5..1b7e68a 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/04.Mysql锁.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/04.Mysql锁.md

@@ -17,7 +17,7 @@ permalink: /pages/f1f151/

-## 1. 悲观锁和乐观锁

+## 悲观锁和乐观锁

确保在多个事务同时存取数据库中同一数据时不破坏事务的隔离性和统一性以及数据库的统一性,**乐观锁和悲观锁是并发控制主要采用的技术手段。**

@@ -42,7 +42,7 @@ where id=#{id} and version=#{version};

> 更详细的乐观锁说可以参考:[使用 mysql 乐观锁解决并发问题](https://www.cnblogs.com/laoyeye/p/8097684.html)

-## 2. 表级锁和行级锁

+## 表级锁和行级锁

从数据库的锁粒度来看,MySQL 中提供了两种封锁粒度:行级锁和表级锁。

@@ -55,7 +55,7 @@ where id=#{id} and version=#{version};

在 `InnoDB` 中,**行锁是通过给索引上的索引项加锁来实现的**。**如果没有索引,`InnoDB` 将会通过隐藏的聚簇索引来对记录加锁**。

-## 3. 读写锁

+## 读写锁

- 独享锁(Exclusive),简写为 X 锁,又称写锁。使用方式:`SELECT ... FOR UPDATE;`

- 共享锁(Shared),简写为 S 锁,又称读锁。使用方式:`SELECT ... LOCK IN SHARE MODE;`

@@ -64,7 +64,7 @@ where id=#{id} and version=#{version};

**`InnoDB` 下的行锁、间隙锁、next-key 锁统统属于独享锁**。

-## 4. 意向锁

+## 意向锁

**当存在表级锁和行级锁的情况下,必须先申请意向锁(表级锁,但不是真的加锁),再获取行级锁**。使用意向锁(Intention Locks)可以更容易地支持多粒度封锁。

@@ -95,13 +95,13 @@ where id=#{id} and version=#{version};

- 任意 IS/IX 锁之间都是兼容的,因为它们只表示想要对表加锁,而不是真正加锁;

- 这里兼容关系针对的是表级锁,而表级的 IX 锁和行级的 X 锁兼容,两个事务可以对两个数据行加 X 锁。(事务 T1 想要对数据行 R1 加 X 锁,事务 T2 想要对同一个表的数据行 R2 加 X 锁,两个事务都需要对该表加 IX 锁,但是 IX 锁是兼容的,并且 IX 锁与行级的 X 锁也是兼容的,因此两个事务都能加锁成功,对同一个表中的两个数据行做修改。)

-## 5. MVCC

+## MVCC

**多版本并发控制(Multi-Version Concurrency Control, MVCC)可以视为行级锁的一个变种。它在很多情况下都避免了加锁操作,因此开销更低**。不仅是 Mysql,包括 Oracle、PostgreSQL 等其他数据库都实现了各自的 MVCC,实现机制没有统一标准。

MVCC 是 `InnoDB` 存储引擎实现隔离级别的一种具体方式,**用于实现提交读和可重复读这两种隔离级别**。而未提交读隔离级别总是读取最新的数据行,要求很低,无需使用 MVCC。可串行化隔离级别需要对所有读取的行都加锁,单纯使用 MVCC 无法实现。

-### 5.1. MVCC 思想

+### MVCC 思想

加锁能解决多个事务同时执行时出现的并发一致性问题。在实际场景中读操作往往多于写操作,因此又引入了读写锁来避免不必要的加锁操作,例如读和读没有互斥关系。读写锁中读和写操作仍然是互斥的。

@@ -110,14 +110,14 @@ MVCC 的思想是:

- **保存数据在某个时间点的快照,写操作(DELETE、INSERT、UPDATE)更新最新的版本快照;而读操作去读旧版本快照,没有互斥关系**。这一点和 `CopyOnWrite` 类似。

- 脏读和不可重复读最根本的原因是**事务读取到其它事务未提交的修改**。在事务进行读取操作时,为了解决脏读和不可重复读问题,**MVCC 规定只能读取已经提交的快照**。当然一个事务可以读取自身未提交的快照,这不算是脏读。

-### 5.2. 版本号

+### 版本号

InnoDB 的 MVCC 实现是:在每行记录后面保存两个隐藏列,一个列保存行的创建时间,另一个列保存行的过期时间(这里的时间是指系统版本号)。每开始一个新事务,系统版本号会自动递增,事务开始时刻的系统版本号会作为事务的版本号,用来和查询到的每行记录的版本号进行比较。

- 系统版本号 `SYS_ID`:是一个递增的数字,每开始一个新的事务,系统版本号就会自动递增。

- 事务版本号 `TRX_ID` :事务开始时的系统版本号。

-### 5.3. Undo 日志

+### Undo 日志

MVCC 的多版本指的是多个版本的快照,快照存储在 Undo 日志中,该日志通过回滚指针 `ROLL_PTR` 把一个数据行的所有快照连接起来。

@@ -133,7 +133,7 @@ UPDATE t SET x="c" WHERE id=1;

`INSERT`、`UPDATE`、`DELETE` 操作会创建一个日志,并将事务版本号 `TRX_ID` 写入。`DELETE` 可以看成是一个特殊的 `UPDATE`,还会额外将 DEL 字段设置为 1。

-### 5.4. ReadView

+### ReadView

MVCC 维护了一个一致性读视图 `consistent read view` ,主要包含了当前系统**未提交的事务列表** `TRX_IDs {TRX_ID_1, TRX_ID_2, ...}`,还有该列表的最小值 `TRX_ID_MIN` 和 `TRX_ID_MAX`。

@@ -157,7 +157,7 @@ MVCC 维护了一个一致性读视图 `consistent read view` ,主要包含了

在数据行快照不可使用的情况下,需要沿着 Undo Log 的回滚指针 ROLL_PTR 找到下一个快照,再进行上面的判断。

-### 5.5. 快照读与当前读

+### 快照读与当前读

快照读

@@ -184,7 +184,7 @@ SELECT * FROM table WHERE ? lock in share mode;

SELECT * FROM table WHERE ? for update;

```

-## 6. 行锁

+## 行锁

行锁的具体实现算法有三种:record lock、gap lock 以及 next-key lock。

@@ -200,10 +200,10 @@ MVCC 不能解决幻读问题,**Next-Key 锁就是为了解决幻读问题**

当两个事务同时执行,一个锁住了主键索引,在等待其他相关索引。另一个锁定了非主键索引,在等待主键索引。这样就会发生死锁。发生死锁后,`InnoDB` 一般都可以检测到,并使一个事务释放锁回退,另一个获取锁完成事务。

-## 7. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

- [《Java 性能调优实战》](https://time.geekbang.org/column/intro/100028001)

- [数据库系统原理](https://github.com/CyC2018/Interview-Notebook/blob/master/notes/数据库系统原理.md)

- [数据库两大神器【索引和锁】](https://juejin.im/post/5b55b842f265da0f9e589e79)

-- [使用 mysql 乐观锁解决并发问题](https://www.cnblogs.com/laoyeye/p/8097684.html)

+- [使用 mysql 乐观锁解决并发问题](https://www.cnblogs.com/laoyeye/p/8097684.html)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/05.Mysql索引.md b/docs/12.数据库/03.关系型数据库/02.Mysql/05.Mysql索引.md

index e499782..807f082 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/05.Mysql索引.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/05.Mysql索引.md

@@ -21,13 +21,13 @@ permalink: /pages/fcb19c/

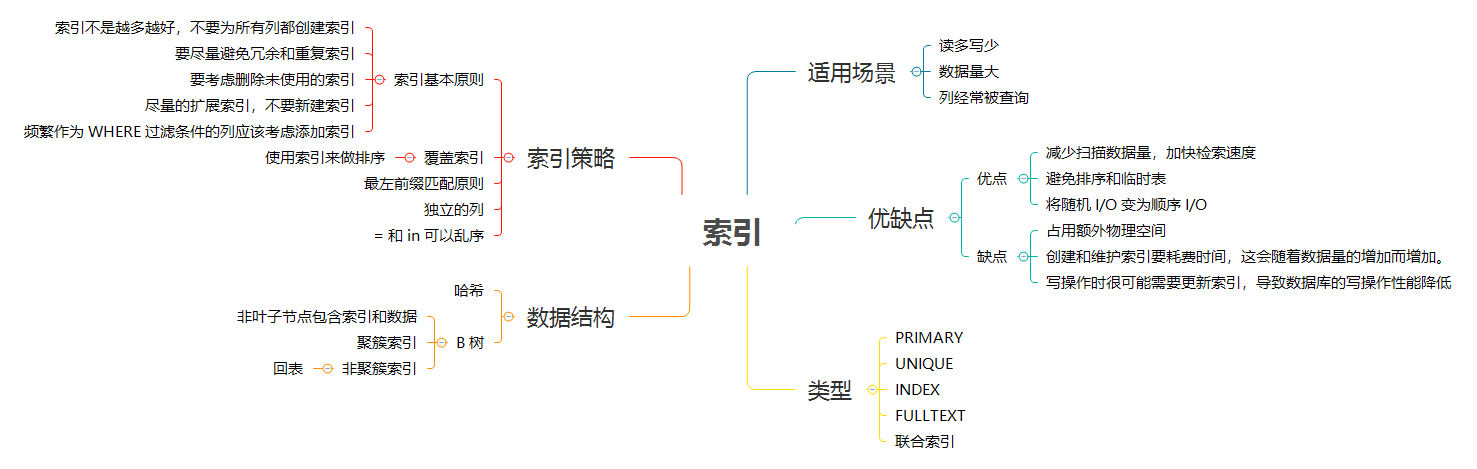

-## 1. 索引简介

+## 索引简介

**索引是数据库为了提高查找效率的一种数据结构**。

索引对于良好的性能非常关键,在数据量小且负载较低时,不恰当的索引对于性能的影响可能还不明显;但随着数据量逐渐增大,性能则会急剧下降。因此,索引优化应该是查询性能优化的最有效手段。

-### 1.1. 索引的优缺点

+### 索引的优缺点

B 树是最常见的索引,按照顺序存储数据,所以 Mysql 可以用来做 `ORDER BY` 和 `GROUP BY` 操作。因为数据是有序的,所以 B 树也就会将相关的列值都存储在一起。最后,因为索引中存储了实际的列值,所以某些查询只使用索引就能够完成全部查询。

@@ -45,7 +45,7 @@ B 树是最常见的索引,按照顺序存储数据,所以 Mysql 可以用

- **索引需要占用额外的物理空间**,除了数据表占数据空间之外,每一个索引还要占一定的物理空间,如果要建立组合索引那么需要的空间就会更大。

- **写操作(`INSERT`/`UPDATE`/`DELETE`)时很可能需要更新索引,导致数据库的写操作性能降低**。

-### 1.2. 何时使用索引

+### 何时使用索引

> 索引能够轻易将查询性能提升几个数量级。

@@ -62,7 +62,7 @@ B 树是最常见的索引,按照顺序存储数据,所以 Mysql 可以用

- **非常小的表**,对于非常小的表,大部分情况下简单的全表扫描更高效。

- **特大型的表**,建立和使用索引的代价将随之增长。可以考虑使用分区技术或 Nosql。

-## 2. 索引的数据结构

+## 索引的数据结构

在 Mysql 中,索引是在存储引擎层而不是服务器层实现的。所以,并没有统一的索引标准;不同存储引擎的索引的数据结构也不相同。

@@ -79,7 +79,7 @@ B 树是最常见的索引,按照顺序存储数据,所以 Mysql 可以用

这意味着,如果使用数组作为索引,如果要保证数组有序,其更新操作代价高昂。

-### 2.1. 哈希索引

+### 哈希索引

哈希表是一种以键 - 值(key-value)对形式存储数据的结构,我们只要输入待查找的值即 key,就可以找到其对应的值即 Value。

@@ -112,7 +112,7 @@ B 树是最常见的索引,按照顺序存储数据,所以 Mysql 可以用

> 因为种种限制,所以哈希索引只适用于特定的场合。而一旦使用哈希索引,则它带来的性能提升会非常显著。

-### 2.2. B 树索引

+### B 树索引

通常我们所说的索引是指`B-Tree`索引,它是目前关系型数据库中查找数据最为常用和有效的索引,大多数存储引擎都支持这种索引。使用`B-Tree`这个术语,是因为 MySQL 在`CREATE TABLE`或其它语句中使用了这个关键字,但实际上不同的存储引擎可能使用不同的数据结构,比如 InnoDB 就是使用的`B+Tree`。

@@ -164,7 +164,7 @@ B+ 树索引适用于**全键值查找**、**键值范围查找**和**键前缀

这时候我们就要优先考虑上一段提到的“尽量使用主键查询”原则,直接将这个索引设置为主键,可以避免每次查询需要搜索两棵树。

-### 2.3. 全文索引

+### 全文索引

MyISAM 存储引擎支持全文索引,用于查找文本中的关键词,而不是直接比较是否相等。查找条件使用 MATCH AGAINST,而不是普通的 WHERE。

@@ -172,17 +172,17 @@ MyISAM 存储引擎支持全文索引,用于查找文本中的关键词,而

InnoDB 存储引擎在 MySQL 5.6.4 版本中也开始支持全文索引。

-### 2.4. 空间数据索引

+### 空间数据索引

MyISAM 存储引擎支持空间数据索引(R-Tree),可以用于地理数据存储。空间数据索引会从所有维度来索引数据,可以有效地使用任意维度来进行组合查询。

必须使用 GIS 相关的函数来维护数据。

-## 3. 索引的类型

+## 索引的类型

主流的关系型数据库一般都支持以下索引类型:

-### 3.1. 主键索引(`PRIMARY`)

+### 主键索引(`PRIMARY`)

主键索引:一种特殊的唯一索引,不允许有空值。一个表只能有一个主键(在 InnoDB 中本质上即聚簇索引),一般是在建表的时候同时创建主键索引。

@@ -194,7 +194,7 @@ CREATE TABLE `table` (

)

```

-### 3.2. 唯一索引(`UNIQUE`)

+### 唯一索引(`UNIQUE`)

唯一索引:**索引列的值必须唯一,但允许有空值**。如果是组合索引,则列值的组合必须唯一。

@@ -205,7 +205,7 @@ CREATE TABLE `table` (

)

```

-### 3.3. 普通索引(`INDEX`)

+### 普通索引(`INDEX`)

普通索引:最基本的索引,没有任何限制。

@@ -216,7 +216,7 @@ CREATE TABLE `table` (

)

```

-### 3.4. 全文索引(`FULLTEXT`)

+### 全文索引(`FULLTEXT`)

全文索引:主要用来查找文本中的关键字,而不是直接与索引中的值相比较。

@@ -230,7 +230,7 @@ CREATE TABLE `table` (

)

```

-### 3.5. 联合索引

+### 联合索引

组合索引:多个字段上创建的索引,只有在查询条件中使用了创建索引时的第一个字段,索引才会被使用。使用组合索引时遵循最左前缀集合。

@@ -241,7 +241,7 @@ CREATE TABLE `table` (

)

```

-## 4. 索引的策略

+## 索引的策略

假设有以下表:

@@ -257,7 +257,7 @@ CREATE TABLE `t` (

) ENGINE=InnoDB;

```

-### 4.1. 索引基本原则

+### 索引基本原则

- **索引不是越多越好,不要为所有列都创建索引**。要考虑到索引的维护代价、空间占用和查询时回表的代价。索引一定是按需创建的,并且要尽可能确保足够轻量。一旦创建了多字段的联合索引,我们要考虑尽可能利用索引本身完成数据查询,减少回表的成本。

- 要**尽量避免冗余和重复索引**。

@@ -265,7 +265,7 @@ CREATE TABLE `t` (

- **尽量的扩展索引,不要新建索引**。

- **频繁作为 `WHERE` 过滤条件的列应该考虑添加索引**。

-### 4.2. 独立的列

+### 独立的列

**“独立的列” 是指索引列不能是表达式的一部分,也不能是函数的参数**。

@@ -280,7 +280,7 @@ SELECT actor_id FROM actor WHERE actor_id + 1 = 5;

SELECT ... WHERE TO_DAYS(current_date) - TO_DAYS(date_col) <= 10;

```

-### 4.3. 覆盖索引

+### 覆盖索引

**覆盖索引是指,索引上的信息足够满足查询请求,不需要回表查询数据。**

@@ -313,7 +313,7 @@ select * from T where k between 3 and 5

**由于覆盖索引可以减少树的搜索次数,显著提升查询性能,所以使用覆盖索引是一个常用的性能优化手段。**

-### 4.4. 使用索引来排序

+### 使用索引来排序

Mysql 有两种方式可以生成排序结果:通过排序操作;或者按索引顺序扫描。

@@ -325,7 +325,7 @@ Mysql 有两种方式可以生成排序结果:通过排序操作;或者按

2. 从索引 (city,name,age) 取下一个记录,同样取出这三个字段的值,作为结果集的一部分直接返回;

3. 重复执行步骤 2,直到查到第 1000 条记录,或者是不满足 city='杭州’条件时循环结束。

-### 4.5. 前缀索引

+### 前缀索引

有时候需要索引很长的字符列,这会让索引变得大且慢。

@@ -358,7 +358,7 @@ from SUser;

此外,**`order by` 无法使用前缀索引,无法把前缀索引用作覆盖索引**。

-### 4.6. 最左前缀匹配原则

+### 最左前缀匹配原则

不只是索引的全部定义,只要满足最左前缀,就可以利用索引来加速检索。这个最左前缀可以是联合索引的最左 N 个字段,也可以是字符串索引的最左 M 个字符。

@@ -391,21 +391,21 @@ customer_id_selectivity: 0.0373

COUNT(*): 16049

```

-### 4.7. = 和 in 可以乱序

+### = 和 in 可以乱序

**不需要考虑 `=`、`IN` 等的顺序**,Mysql 会自动优化这些条件的顺序,以匹配尽可能多的索引列。

【示例】如有索引 (a, b, c, d),查询条件 `c > 3 and b = 2 and a = 1 and d < 4` 与 `a = 1 and c > 3 and b = 2 and d < 4` 等顺序都是可以的,MySQL 会自动优化为 a = 1 and b = 2 and c > 3 and d < 4,依次命中 a、b、c、d。

-## 5. 索引最佳实践

+## 索引最佳实践

创建了索引,并非一定有效。比如不满足前缀索引、最左前缀匹配原则、查询条件涉及函数计算等情况都无法使用索引。此外,即使 SQL 本身符合索引的使用条件,MySQL 也会通过评估各种查询方式的代价,来决定是否走索引,以及走哪个索引。

因此,在尝试通过索引进行 SQL 性能优化的时候,务必通过执行计划(`EXPLAIN`)或实际的效果来确认索引是否能有效改善性能问题,否则增加了索引不但没解决性能问题,还增加了数据库增删改的负担。如果对 EXPLAIN 给出的执行计划有疑问的话,你还可以利用 `optimizer_trace` 查看详细的执行计划做进一步分析。

-## 6. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

- [数据库两大神器【索引和锁】](https://juejin.im/post/5b55b842f265da0f9e589e79)

- [MySQL 索引背后的数据结构及算法原理](http://blog.codinglabs.org/articles/theory-of-mysql-index.html)

-- [MySQL 实战 45 讲](https://time.geekbang.org/column/intro/139)

+- [MySQL 实战 45 讲](https://time.geekbang.org/column/intro/139)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/06.Mysql性能优化.md b/docs/12.数据库/03.关系型数据库/02.Mysql/06.Mysql性能优化.md

index 9ec7ceb..c1c29c6 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/06.Mysql性能优化.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/06.Mysql性能优化.md

@@ -15,11 +15,11 @@ permalink: /pages/396816/

# Mysql 性能优化

-## 1. 数据结构优化

+## 数据结构优化

良好的逻辑设计和物理设计是高性能的基石。

-### 1.1. 数据类型优化

+### 数据类型优化

#### 数据类型优化基本原则

@@ -38,7 +38,7 @@ permalink: /pages/396816/

- 应该尽量避免用字符串类型作为标识列,因为它们很消耗空间,并且通常比数字类型慢。对于 `MD5`、`SHA`、`UUID` 这类随机字符串,由于比较随机,所以可能分布在很大的空间内,导致 `INSERT` 以及一些 `SELECT` 语句变得很慢。

- 如果存储 UUID ,应该移除 `-` 符号;更好的做法是,用 `UNHEX()` 函数转换 UUID 值为 16 字节的数字,并存储在一个 `BINARY(16)` 的列中,检索时,可以通过 `HEX()` 函数来格式化为 16 进制格式。

-### 1.2. 表设计

+### 表设计

应该避免的设计问题:

@@ -47,7 +47,7 @@ permalink: /pages/396816/

- **枚举** - 尽量不要用枚举,因为添加和删除字符串(枚举选项)必须使用 `ALTER TABLE`。

- 尽量避免 `NULL`

-### 1.3. 范式和反范式

+### 范式和反范式

**范式化目标是尽量减少冗余,而反范式化则相反**。

@@ -63,7 +63,7 @@ permalink: /pages/396816/

在真实世界中,很少会极端地使用范式化或反范式化。实际上,应该权衡范式和反范式的利弊,混合使用。

-### 1.4. 索引优化

+### 索引优化

> 索引优化应该是查询性能优化的最有效手段。

>

@@ -92,7 +92,7 @@ permalink: /pages/396816/

- **覆盖索引**

- **自增字段作主键**

-## 2. SQL 优化

+## SQL 优化

使用 `EXPLAIN` 命令查看当前 SQL 是否使用了索引,优化后,再通过执行计划(`EXPLAIN`)来查看优化效果。

@@ -106,7 +106,7 @@ SQL 优化基本思路:

- **使用索引来覆盖查询**

-### 2.1. 优化 `COUNT()` 查询

+### 优化 `COUNT()` 查询

`COUNT()` 有两种作用:

@@ -130,7 +130,7 @@ FROM world.city WHERE id <= 5;

有时候某些业务场景并不需要完全精确的统计值,可以用近似值来代替,`EXPLAIN` 出来的行数就是一个不错的近似值,而且执行 `EXPLAIN` 并不需要真正地去执行查询,所以成本非常低。通常来说,执行 `COUNT()` 都需要扫描大量的行才能获取到精确的数据,因此很难优化,MySQL 层面还能做得也就只有覆盖索引了。如果不还能解决问题,只有从架构层面解决了,比如添加汇总表,或者使用 Redis 这样的外部缓存系统。

-### 2.2. 优化关联查询

+### 优化关联查询

在大数据场景下,表与表之间通过一个冗余字段来关联,要比直接使用 `JOIN` 有更好的性能。

@@ -167,11 +167,11 @@ while(outer_row) {

可以看到,最外层的查询是根据`A.xx`列来查询的,`A.c`上如果有索引的话,整个关联查询也不会使用。再看内层的查询,很明显`B.c`上如果有索引的话,能够加速查询,因此只需要在关联顺序中的第二张表的相应列上创建索引即可。

-### 2.3. 优化 `GROUP BY` 和 `DISTINCT`

+### 优化 `GROUP BY` 和 `DISTINCT`

Mysql 优化器会在内部处理的时候相互转化这两类查询。它们都**可以使用索引来优化,这也是最有效的优化方法**。

-### 2.4. 优化 `LIMIT`

+### 优化 `LIMIT`

当需要分页操作时,通常会使用 `LIMIT` 加上偏移量的办法实现,同时加上合适的 `ORDER BY` 字句。**如果有对应的索引,通常效率会不错,否则,MySQL 需要做大量的文件排序操作**。

@@ -204,13 +204,13 @@ SELECT id FROM t WHERE id > 10000 LIMIT 10;

其他优化的办法还包括使用预先计算的汇总表,或者关联到一个冗余表,冗余表中只包含主键列和需要做排序的列。

-### 2.5. 优化 UNION

+### 优化 UNION

MySQL 总是通过创建并填充临时表的方式来执行 `UNION` 查询。因此很多优化策略在`UNION`查询中都没有办法很好的时候。经常需要手动将`WHERE`、`LIMIT`、`ORDER BY`等字句“下推”到各个子查询中,以便优化器可以充分利用这些条件先优化。

除非确实需要服务器去重,否则就一定要使用`UNION ALL`,如果没有`ALL`关键字,MySQL 会给临时表加上`DISTINCT`选项,这会导致整个临时表的数据做唯一性检查,这样做的代价非常高。当然即使使用 ALL 关键字,MySQL 总是将结果放入临时表,然后再读出,再返回给客户端。虽然很多时候没有这个必要,比如有时候可以直接把每个子查询的结果返回给客户端。

-### 2.6. 优化查询方式

+### 优化查询方式

#### 切分大查询

@@ -251,7 +251,7 @@ SELECT * FROM tag_post WHERE tag_id=1234;

SELECT * FROM post WHERE post.id IN (123,456,567,9098,8904);

```

-## 3. 执行计划(`EXPLAIN`)

+## 执行计划(`EXPLAIN`)

如何判断当前 SQL 是否使用了索引?如何检验修改后的 SQL 确实有优化效果?

@@ -304,7 +304,7 @@ possible_keys: PRIMARY

> 更多内容请参考:[MySQL 性能优化神器 Explain 使用分析](https://segmentfault.com/a/1190000008131735)

-## 4. optimizer trace

+## optimizer trace

在 MySQL 5.6 及之后的版本中,我们可以使用 optimizer trace 功能查看优化器生成执行计划的整个过程。有了这个功能,我们不仅可以了解优化器的选择过程,更可以了解每一个执行环节的成本,然后依靠这些信息进一步优化查询。

@@ -317,14 +317,14 @@ SELECT * FROM information_schema.OPTIMIZER_TRACE;

SET optimizer_trace="enabled=off";

```

-## 5. 数据模型和业务

+## 数据模型和业务

- 表字段比较复杂、易变动、结构难以统一的情况下,可以考虑使用 Nosql 来代替关系数据库表存储,如 ElasticSearch、MongoDB。

- 在高并发情况下的查询操作,可以使用缓存(如 Redis)代替数据库操作,提高并发性能。

- 数据量增长较快的表,需要考虑水平分表或分库,避免单表操作的性能瓶颈。

- 除此之外,我们应该通过一些优化,尽量避免比较复杂的 JOIN 查询操作,例如冗余一些字段,减少 JOIN 查询;创建一些中间表,减少 JOIN 查询。

-## 6. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

- [《Java 性能调优实战》](https://time.geekbang.org/column/intro/100028001)

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/20.Mysql运维.md b/docs/12.数据库/03.关系型数据库/02.Mysql/20.Mysql运维.md

index a22d9d2..ab2b648 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/20.Mysql运维.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/20.Mysql运维.md

@@ -17,9 +17,9 @@ permalink: /pages/e33b92/

> 如果你的公司有 DBA,那么我恭喜你,你可以无视 Mysql 运维。如果你的公司没有 DBA,那你就好好学两手 Mysql 基本运维操作,行走江湖,防身必备。

-## 1. 安装部署

+## 安装部署

-### 1.1. Windows 安装

+### Windows 安装

(1)下载 Mysql 5.7 免安装版

@@ -66,7 +66,7 @@ mysqld -install

在控制台执行 `net start mysql` 启动服务。

-### 1.2. CentOS 安装

+### CentOS 安装

> 本文仅介绍 rpm 安装方式

@@ -156,7 +156,7 @@ systemctl restart mysqld

systemctl stop mysqld

```

-### 1.3. 初始化数据库密码

+### 初始化数据库密码

查看一下初始密码

@@ -179,7 +179,7 @@ ALTER user 'root'@'localhost' IDENTIFIED BY '你的密码';

注:密码强度默认为中等,大小写字母、数字、特殊符号,只有修改成功后才能修改配置再设置更简单的密码

-### 1.4. 配置远程访问

+### 配置远程访问

```sql

CREATE USER 'root'@'%' IDENTIFIED BY '你的密码';

@@ -188,7 +188,7 @@ ALTER USER 'root'@'%' IDENTIFIED WITH mysql_native_password BY '你的密码';

FLUSH PRIVILEGES;

```

-### 1.5. 跳过登录认证

+### 跳过登录认证

```shell

vim /etc/my.cnf

@@ -200,9 +200,9 @@ vim /etc/my.cnf

执行 `systemctl restart mysqld`,重启 mysql

-## 2. 基本运维

+## 基本运维

-### 2.1. 客户端连接

+### 客户端连接

语法:`mysql -h<主机> -P<端口> -u<用户名> -p<密码>`

@@ -228,13 +228,13 @@ Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

mysql>

```

-### 2.2. 查看连接

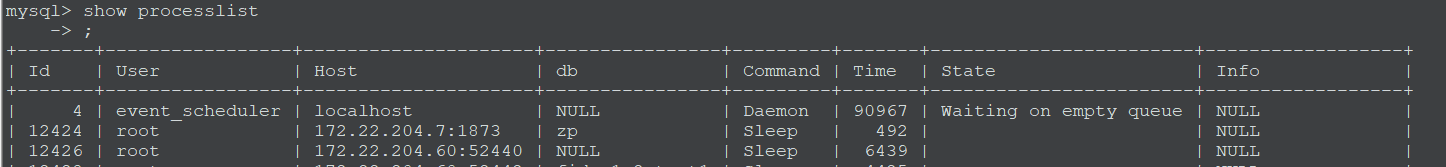

+### 查看连接

连接完成后,如果你没有后续的动作,这个连接就处于空闲状态,你可以在 `show processlist` 命令中看到它。客户端如果太长时间没动静,连接器就会自动将它断开。这个时间是由参数 `wait_timeout` 控制的,默认值是 8 小时。

-### 2.3. 创建用户

+### 创建用户

```sql

CREATE USER 'username'@'host' IDENTIFIED BY 'password';

@@ -260,7 +260,7 @@ CREATE USER 'pig'@'%';

>

> 所以,需要加上 `IDENTIFIED WITH mysql_native_password`,例如:`CREATE USER 'slave'@'%' IDENTIFIED WITH mysql_native_password BY '123456';`

-### 2.4. 查看用户

+### 查看用户

```sql

-- 查看所有用户

@@ -268,7 +268,7 @@ SELECT DISTINCT CONCAT('User: ''', user, '''@''', host, ''';') AS query

FROM mysql.user;

```

-### 2.5. 授权

+### 授权

命令:

@@ -301,7 +301,7 @@ GRANT privileges ON databasename.tablename TO 'username'@'host' WITH GRANT OPTIO

GRANT ALL ON *.* TO 'root'@'%' IDENTIFIED BY '密码' WITH GRANT OPTION;

```

-### 2.6. 撤销授权

+### 撤销授权

命令:

@@ -325,14 +325,14 @@ REVOKE SELECT ON *.* FROM 'pig'@'%';

具体信息可以用命令`SHOW GRANTS FOR 'pig'@'%';` 查看。

-### 2.7. 查看授权

+### 查看授权

```SQL

-- 查看用户权限

SHOW GRANTS FOR 'root'@'%';

```

-### 2.8. 更改用户密码

+### 更改用户密码

```sql

SET PASSWORD FOR 'username'@'host' = PASSWORD('newpassword');

@@ -350,7 +350,7 @@ SET PASSWORD = PASSWORD("newpassword");

SET PASSWORD FOR 'pig'@'%' = PASSWORD("123456");

```

-### 2.9. 备份与恢复

+### 备份与恢复

Mysql 备份数据使用 mysqldump 命令。

@@ -401,7 +401,7 @@ mysql -h -P -u -p < backup.sql

mysql -u -p --all-databases < backup.sql

```

-### 2.10. 卸载

+### 卸载

(1)查看已安装的 mysql

@@ -421,7 +421,7 @@ mysql-community-libs-8.0.12-1.el7.x86_64

yum remove mysql-community-server.x86_64

```

-### 2.11. 主从节点部署

+### 主从节点部署

假设需要配置一个主从 Mysql 服务器环境

@@ -627,13 +627,57 @@ mysql> show global variables like "%read_only%";

> 注:设置 slave 服务器为只读,并不影响主从同步。

-## 3. 服务器配置

+### 慢查询

+

+查看慢查询是否开启

+

+```sql

+show variables like '%slow_query_log';

+```

+

+可以通过 `set global slow_query_log` 命令设置慢查询是否开启:ON 表示开启;OFF 表示关闭。

+

+```sql

+set global slow_query_log='ON';

+```

+

+查看慢查询时间阈值

+

+```sql

+show variables like '%long_query_time%';

+```

+

+设置慢查询阈值

+

+```sql

+set global long_query_time = 3;

+```

+

+### 隔离级别

+

+查看隔离级别:

+

+```sql

+mysql> show variables like 'transaction_isolation';

+

++-----------------------+----------------+

+

+| Variable_name | Value |

+

++-----------------------+----------------+

+

+| transaction_isolation | READ-COMMITTED |

+

++-----------------------+----------------+

+```

+

+## 服务器配置

> **_大部分情况下,默认的基本配置已经足够应付大多数场景,不要轻易修改 Mysql 服务器配置,除非你明确知道修改项是有益的。_**

>

> 尽量不要使用 Mysql 的缓存功能,因为其要求每次请求参数完全相同,才能命中缓存。这种方式实际上并不高效,还会增加额外开销,实际业务场景中一般使用 Redis 等 key-value 存储来解决缓存问题,性能远高于 Mysql 的查询缓存。

-### 3.1. 配置文件路径

+### 配置文件路径

配置 Mysql 首先要确定配置文件在哪儿。

@@ -649,7 +693,7 @@ Default options are read from the following files in the given order:

/etc/my.cnf /etc/mysql/my.cnf /usr/etc/my.cnf ~/.my.cnf

```

-### 3.2. 配置项语法

+### 配置项语法

**Mysql 配置项设置都使用小写,单词之间用下划线或横线隔开(二者是等价的)。**

@@ -661,7 +705,7 @@ Default options are read from the following files in the given order:

/usr/sbin/mysqld --auto_increment_offset=5

```

-### 3.3. 常用配置项说明

+### 常用配置项说明

> 这里介绍比较常用的基本配置,更多配置项说明可以参考:[Mysql 服务器配置说明](21.Mysql配置.md)

@@ -760,9 +804,9 @@ port = 3306

- 注意:仍然可能出现报错信息 Can't create a new thread;此时观察系统 `cat /proc/mysql` 进程号/limits,观察进程 ulimit 限制情况

- 过小的话,考虑修改系统配置表,`/etc/security/limits.conf` 和 `/etc/security/limits.d/90-nproc.conf`

-## 4. 常见问题

+## 常见问题

-### 4.1. Too many connections

+### Too many connections

**现象**

@@ -833,7 +877,7 @@ mysql soft nofile 65535

如果是使用 rpm 方式安装 mysql,检查 **mysqld.service** 文件中的 `LimitNOFILE` 是否配置的太小。

-### 4.2. 时区(time_zone)偏差

+### 时区(time_zone)偏差

**现象**

@@ -874,7 +918,7 @@ Query OK, 0 rows affected (0.00 sec)

修改 `my.cnf` 文件,在 `[mysqld]` 节下增加 `default-time-zone='+08:00'` ,然后重启。

-### 4.3. 数据表损坏如何修复

+### 数据表损坏如何修复

使用 myisamchk 来修复,具体步骤:

@@ -884,7 +928,7 @@ Query OK, 0 rows affected (0.00 sec)

使用 repair table 或者 OPTIMIZE table 命令来修复,REPAIR TABLE table_name 修复表 OPTIMIZE TABLE table_name 优化表 REPAIR TABLE 用于修复被破坏的表。 OPTIMIZE TABLE 用于回收闲置的数据库空间,当表上的数据行被删除时,所占据的磁盘空间并没有立即被回收,使用了 OPTIMIZE TABLE 命令后这些空间将被回收,并且对磁盘上的数据行进行重排(注意:是磁盘上,而非数据库)

-### 4.4. 数据结构

+### 数据结构

> 问题现象:ERROR 1071: Specified key was too long; max key length is 767 bytes

@@ -892,14 +936,14 @@ Query OK, 0 rows affected (0.00 sec)

解决方法:优化索引结构,索引字段不宜过长。

-## 5. 脚本

+## 脚本

这里推荐我写的几个一键运维脚本,非常方便,欢迎使用:

- [Mysql 安装脚本](https://github.com/dunwu/linux-tutorial/tree/master/codes/linux/soft/mysql-install.sh)

- [Mysql 备份脚本](https://github.com/dunwu/linux-tutorial/tree/master/codes/linux/soft/mysql-backup.sh)

-## 6. 参考资料

+## 参考资料

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/)

- https://www.cnblogs.com/xiaopotian/p/8196464.html

@@ -909,4 +953,4 @@ Query OK, 0 rows affected (0.00 sec)

- https://www.cnblogs.com/xyabk/p/8967990.html

- [MySQL 8.0 主从(Master-Slave)配置](https://blog.csdn.net/zyhlwzy/article/details/80569422)

- [Mysql 主从同步实战](https://juejin.im/post/58eb5d162f301e00624f014a)

-- [MySQL 备份和恢复机制](https://juejin.im/entry/5a0aa2026fb9a045132a369f)

+- [MySQL 备份和恢复机制](https://juejin.im/entry/5a0aa2026fb9a045132a369f)

\ No newline at end of file

diff --git a/docs/12.数据库/03.关系型数据库/02.Mysql/21.Mysql配置.md b/docs/12.数据库/03.关系型数据库/02.Mysql/21.Mysql配置.md

index 81aad76..d558d80 100644

--- a/docs/12.数据库/03.关系型数据库/02.Mysql/21.Mysql配置.md

+++ b/docs/12.数据库/03.关系型数据库/02.Mysql/21.Mysql配置.md

@@ -17,7 +17,7 @@ permalink: /pages/5da42d/

> 版本:

-## 1. 基本配置

+## 基本配置

```ini

[mysqld]

@@ -62,7 +62,7 @@ socket = /var/lib/mysql/mysql.sock

port = 3306

```

-## 2. 配置项说明

+## 配置项说明

```ini

[client]

@@ -260,7 +260,8 @@ max_binlog_size = 1000M

# 关于 binlog 日志格式问题,请查阅网络资料

binlog_format = row

-# 默认值 N=1,使 binlog 在每 N 次 binlog 写入后与硬盘同步,ps:1 最慢

+# 表示每 N 次写入 binlog 后,持久化到磁盘,默认值 N=1

+# 建议设置成 1,这样可以保证 MySQL 异常重启之后 binlog 不丢失。

# sync_binlog = 1

# MyISAM 引擎配置

@@ -419,8 +420,9 @@ innodb_flush_log_at_timeout = 1

# 说明:参数可设为 0,1,2;

# 参数 0:表示每秒将 log buffer 内容刷新到系统 buffer 中,再调用系统 flush 操作写入磁盘文件。

-# 参数 1:表示每次事物提交,将 log buffer 内容刷新到系统 buffer 中,再调用系统 flush 操作写入磁盘文件。