diff --git a/docker/docs/ali_docker.md b/docker/docs/ali_docker.md

deleted file mode 100644

index 292d93913..000000000

--- a/docker/docs/ali_docker.md

+++ /dev/null

@@ -1,93 +0,0 @@

-# 阿里超大规模docker化之路

-

-Docker化之前,阿里主要交易业务已经容器化。采用T4做容器化,T4是2011年开发的一套系统,基于LXC开发,在开发T4的过程中,跟业界很大的不同在于,T4更像VM的容器。当用户登进T4后,看起来与标准的KVM等几乎完全一样,对用户来讲是非常透明化的。所以,容器化不是我们推进Docker的原因。

-

- a)触发我们Docker化的主要原因一:Docker最重要的一点是镜像化,可以做到拿着镜像就可以从一台完全空的机器的应用环境搭建起来,可以把单机环境完全从零搭好。Docker化之前,阿里巴巴的应用部署方式主要由Java、C来编写的,不同的业务BU可能采用完全不同的部署方式,没有统一标准。内部尝试通过基线来建立部署标准,定义的基线包括应用依赖的基础环境(OS、JDK版本等)、应用依赖的脚本,基础环境的配置(启动脚本、Nginx配置等)、应用目录结构、应用包、应用依赖的DNS、VIP、ACI等,但不成功。部署标准做不了,直接导致自动化很难做到。

-

- b)触发我们Docker化的主要原因二:DevOps是一个更好的方向,阿里巴巴做了很多运维和研发融合的调整。Docker是帮助DevOps思想真正落地的一种手段,所有的思想最终都体现在工具或框架上,变成一个强制性的手段,Docker会通过Dockerfile的描述,来声明应用的整个运行环境是怎样的,也就意味着在编写Dockerfile过程中,就已经清楚在不同环境中的依赖状况到底是怎样的,而且,这个环境是通过一个团队来维护的。

-

- **Docker化目标**

-

- 2016年7月,阿里巴巴制定了两个Docker化目标:

-

- 交易核心应用100%Docker化;

-

- DB其中一个交易单元全部Docker化。

-

-## Docker化之路

-

- 推进Dcoker之前,我们有一个准备的过程。在准备阶段,我们需要Docker更像VM和更贴合阿里运维体系的Docker,我们将改造过的Docker称为AliDocker;除了AliDocker以外,我们需要支持AliDocker的工具体系,比如编译、镜像库、镜像分发机制,在完成这些准备工作后,我们认为可以一帆风顺地开始大规模的AliDocker上线。但事实并非如此。

-

- **第一轮Docker化**

-

- 我们碰到了很多问题:

-

- 工具不完善,阿里很多应用之前都是在T4容器中,怎样将T4容器转换成AliDocker是首要面临的问题;

-

- 镜像Build后上传,以前阿里一个应用转成多个,很多时候需要在自己的机器上做Build,然后自己上传,导致做应用时很痛苦;

-

- 应用从T4切换成走Docker的链路,链路没有完全准备好,从资源创建到发布,很多需要手工去做,大规模去做效率非常低。

-

- **第二轮Docker化**

-

- 在推进的过程中,我们又遭遇了新的问题。Docker的发布模式是典型的通过镜像,拉到镜像后将原来的容器销毁,重新创建一个容器,把镜像放进去,拉起来。Docker单一化的发布方式支持不了多种发布模式,更改velocity模板发布效率低;有本地内存cache的发布,重启本地内存cache就会消失。怎样在基于镜像模式情况下又能支持多种发布模式呢?

-

- 我们在Docker的镜像模式基础上做出一个crofix的模式,这个模式不是绕开镜像,而是从镜像中拉起我们需要的文件,去做覆盖等动作,这样就可以完成整个发布。Docker化镜像模式是必须坚持的,否则失去了Docker化的意义。

-

- **第三轮Docker化**

-

- 继续推进到很多应用切换到Docker的时候,我们又遇到了更大的问题:

-

- 首先,很多研发人员都有明显的感受,切换到Docker后变慢。第一,编译打包镜像慢,编译打包完应用的压缩包后,还需要把整个环境打包成镜像,这是在原有基础上增加的过程,如果编译时每次都是新机器,以前依赖的所有环境都要重新拉,一个应用Docker的完整镜像通常会很大,因为它包括依赖的所有环境。对此,我们在编译层做了很多优化,尽可能让你每次都在之前编译的基础上进行编译。第二,镜像压缩问题,Go在1.6以前的版本压缩是单线程,意味着压缩整个镜像时效率会非常低,所以我们选择暂时把镜像压缩关闭掉。

-

- 其次是发布问题,Docker的镜像化模式决定了分发一定是镜像分发,使用Docker时不能完全把它当作透明化东西去用,对所有研发人员来说,要非常清楚依赖的环境、Dockerfile中镜像的分层改怎么做,将频繁变化部分与不频繁变化部分做好分层,镜像分层是改变Docker慢的重要方案;阿里制定了镜像分发多机房优化,比如打包后将所有镜像同步到所有机房;阿里也做了发布优化(P2P、镜像预分发、流式发布),还通过Docker Volume将目录绑定到Dockerfile中,可以保证镜像文件每次拉起时不会被删掉。

-

- 在整个Docker化的过程中,我们在“慢”这个问题上遇到了最大的挑战,不管是编译慢还是发布慢,都做了很多突击的改造项目,最后才让整个编译过程、发布过程在可控的响应速度内。

-

- **第四轮Docker化**

-

- 在推进过程中,我们还遇到规模问题:

-

- 由于规模比较大,开源软件很容易碰到支撑规模不够,稳定性差的问题。目前我们使用Swarm来管理,Swarm的规模能力大概可以支撑1000个节点、50000个容器,而我们需要单Swarm实例健康节点数在3W+,对此,我们对Swarm进行了优化。

-

-

-

-

-

-

-

- 规模我们做到从支撑1000到3W+,压力减小了很多。而Swarm的稳定性对我们来讲,最大的问题在HA上,一个Swarm实例如果挂掉,重新拉起需要时间,所以我们在用Swarm时进行了改造。在前面加了一层Proxy,不同业务、不同场景都可以通过Proxy转换到自己不同的Swarm实例上。另外,所有的Swarm节点我们都会用一个备方案在旁边,而且都是不同机房去备。

-

- 通过改造增强HA机制后,可以做到每次切换、简单发布。

-

-## Bugfix和功能增强

-

- 除了上面四轮次比较明显的问题,在整个Docker化过程中,还做了很多的Bugfix和功能增强,具体有以下几方面:

-

- Daemon升级或crash后,所有容器被自动销毁的问题;

-

- Cpuset、cpuacct和CPU子系统mount到一起时CGroup操作错误的bug;

-

- 支持基于目录的磁盘配额功能(依赖内核patch);

-

- 支持制定IP启动容器,支持通过DHCP获取IP;

-

- 支持启动容器前后执行特定脚本;

-

- 支持镜像下载接入各种链式分发和内部mirror的机制;

-

- 增加Docker Build时的各种参数优化效率和适应内部运维环境;

-

- 优化Engine和Registry的交互。

-

- 经历了这么多坎坷,我们终于完成了全部目标,实现双11时交易所有核心应用都AliDocker化,DB其中一个交易单元全部AliDocker化,生产环境共几十万的AliDocker。

-

-## 未来

-

- 容器化的好处是可以把很多对物理机型的强制要求虚拟化,可能也需要Docker在内核层面的改造,对于未来,我们已经做好了准备,希望:

-

- 所有软件AliDocker化;

-

- 和Docker公司紧密合作回馈社区;

-

- AliDocker生态体系逐渐输出到阿里云。

\ No newline at end of file

diff --git a/docker/docs/compose_v2v3.md b/docker/docs/compose_v2v3.md

deleted file mode 100644

index eae634443..000000000

--- a/docker/docs/compose_v2v3.md

+++ /dev/null

@@ -1,24 +0,0 @@

-# Compose文件v3和v2版本的区别

-

-Docker Compose `v3` 和 `v2` 模板文件都采用yaml格式,但是语法上存在一定差距

-

-首先,使用`version: "3"` 或 `version: "3.1"` (Docker 1.13.1) 作为版本声明

-

-其次,由于 Swarm mode 中网络的特殊性,Compose模板中一些声明比如 `expose` 和 `links` 会被忽略。注意:不能再使用 link 定义的网络别名来进行容器互联,可以使用服务名连接。

-

-另外, `volumes_from` 不再支持,只能使用命名数据卷来实现容器数据的持久化和共享;

-

-v3 中引入了 `deploy` 指令,可对Swarm mode中服务部署的进行细粒度控制,包括

-

-- `resources`:定义 `cpu_shares`, `cpu_quota`, `cpuset`, `mem_limit`, `memswap_limit` 等容器资源控制。(v1/v2中相应指令不再支持)

-- `mode`:支持 `global` 和 `replicated` (缺省) 模式的服务;

-- `replicas`:定义 `replicated` 模式的服务的复本数量

-- `placement`:定义服务容器的部署放置约束条件

-- `update_config`:定义服务的更新方式

-- `restart_policy`:定义服务的重启条件 (v1/v2中`restart`指令不再支持)

-- `service`:定义服务的标签

-

-

-虽然 Docker CLI 已经提供了对Docker Compose v3模板的支持。但是 Docker Compose 依然可以作为一个开发工具独立使用,并同时继续支持v1/v2/v2.1等版本已有编排模板。但是当利用 `docker-compose up` 或 `docker-compose run` 来部署v3模板时,模板中的 `deploy` 指令将被忽略

-

-Docker CLI只支持v3模板,但是不支持模板中的 `build` 指令,只允许构建好的镜像来启动服务的容器。

\ No newline at end of file

diff --git a/docker/docs/container_2016.md b/docker/docs/container_2016.md

deleted file mode 100644

index e2de46fbc..000000000

--- a/docker/docs/container_2016.md

+++ /dev/null

@@ -1,139 +0,0 @@

-# 容器技术2016年总结

-

-本文是从容器生态圈的角度来讲述容器技术2016年的发展与变革。

-

-*导读:容器技术已经成了很多公司基础架构一部分,架构师是否已经清楚了解 Docker, Swarm, K8S, Mesos,虚拟化等相关技术的未来走向?*

-

-原文作者:王渊命,技术极客,曾任新浪微博架构师、微米技术总监。2014 年作为联合创始人创立团队协作 IM 服务 Grouk,2016 年加入青云从事容器方面开发,本文仅代表个人观点。

-

-### Docker

-

-提到容器就不能不说 Docker。容器技术虽然存在了很长时间,却因 Docker 而火。很长时间里,很多人的概念里基本 Docker 就代表容器。一次一产品经理朋友问我做什么,我说做容器相关,她表示很不懂,但说是 Docker ,她就明白了,可见 Docker 之火。这一年里,Docker 发布了几个重要版本。我们先回顾下 Docker 本来是什么,再说它的变化。

-

-1. Docker 的镜像机制提供了一种更高级的通用的应用制品(artifact)包,也就是大家说的集装箱能力。原来各种操作系统或编程语言都有各自己的制品机制,Ubuntu 的 deb,RedHat 的 RPM,Java 的 JAR、WAR,各自的依赖管理,制品库都不相同。应用从源码打包,分发到制品库,再部署到服务器,很难抽象出一种通用的流程和机制。而有了 Docker 的镜像以及镜像仓库标准之后,这个流程终于可以标准化了。于是雨后春笋般冒出很多镜像管理仓库,这在以前的制品管理领域是很难想象的,以前貌似也就 Java 领域的 nexus 和 artifactory 略完备些。

-2. Docker 镜像机制以及制作工具,取代了一部分 ansible/puppet 的职能,至少主机上的各种软件栈以及依赖关系的定义和维护被容器替代,运维人员的不可变基础设施的梦想被 Docker 实现。

-3. Docker 对 cgroups/namespace 机制以及网络的封装,使其很容易在本地模拟出多节点运行环境,方便开发人员开发调试复杂的,分布式的软件系统。

-4. Docker 的 daemon 进程,取代了一部分 systemd/supervisor 这样的系统初始化进程管理器的作用,通过 Docker 运行的服务,可以不受 systemd 管理,由 docker daemon 维护其生命周期。

-

-前三点基本上都是容器相关或者延伸的,唯独第四点,深受其他容器编排调度厂商的诟病。任何分布式的管理系统,都会在每个主机上安装一个自己的 agent,由这个 agent 管理该节点上的应用进程。从这点功能上来说,和 Docker daemon 是冲突的,操作系统的 systemd,可以忽略不用就行,但要用 Docker 容器的话,离不开 Docker daemon 。设想一下,如果你老板让你管理一个团队,但任何管理指令都只能通过另外一个人来发出,你也会感觉不爽吧?所以 Docker 和其他容器编排调度系统的冲突从开始就种下了。感觉开始 Docker 团队也没思考这个问题,自己的 Swarm 也是用独立的 agent,但后来发现有点多余,把 Swarm 的 agent 以及调度器内置到 Docker daemon 不就行?何况 Docker daemon 本身已经支持了 remote API,并且这样设计还是一个无中心的对等节点集群模式,部署运维更方便。于是 Docker 的 1.12 内置了 Swarm(准确的说是 SwarmKit),几个命令就将多个单机版本的 Docker daemon 变成一个 cluster,还支持了 service 概念(多个容器实例副本的抽象),1.13 支持了 stack 的概念(多个 service 的组合) 和 Compose(编排定义文件),基本上一个略完备的编排调度系统已经成型。

-

-而这个变化,也表明了和其他容器编排调度系统的决裂。本来 Docker 作为容器的一种,大家都在上面基于容器搭建编排调度系统,还能和平共处。容器相当于轮子,编排调度系统是车,结果有一天造轮子的厂商说自己的几个轮子直接拼接起来就称为一辆车了,造车的厂商不急才怪,这相当于发起了『降维』攻击。

-

-有了编排调度系统,Docker 进而推出 Store 也是顺理成章。服务器端的应用大多不是单个节点或进程的应用,需要将多个服务组装,一直以来大家都在寻找一种方式实现服务器端应用的一键安装和部署。Docker 的应用打包了编排文件以及镜像定义,配合编排调度系统提供的标准环境,再用 Store 作为应用分发,意图已经非常明确。但感觉 Docker 这步走的略匆忙,当前编排调度系统尚未成熟,就着急推出更上一层的应用,可能会拖累后面的演进,不过这也应该是受商业化的压力所致吧。

-

-当然 Docker 出此决策,面临的挑战也是巨大的。容器生态圈的割裂,导致 Docker 得以一己之力重塑自己的生态圈。Docker 推出的容器网络标准(libnetwork)不被其他厂商接受,其他厂商也在降低对 Docker 的依赖程度(整个后面具体分析时会提到)。Swarm 成熟度还不够用在生产环境,它的网络当前只支持 overlay,尚不能支持自己的网络插件标准,编排文件的完备程度也不够。存储方面,去年 Docker 收购了 Infinit (很早就关注 Infinit,它一直宣称要开源,但迟迟没等到源码,就听到了它被 Docker 收购的消息)这家做分布式存储的公司。**如果 Docker 在2017年解决网络和存储两个分布式系统的痛点,Swarm 的前景还是可期。**

-

-作为一个开发者,我自己其实挺喜欢 Docker 的这种设计的,虽然它推出的有点晚。这种模式符合开发团队对容器的渐进式接纳。比如开始可以先将 Docker 当做一种制品包管理工具,网络用 host 模式,这种方式和在主机上维护部署多个应用的进程没有区别,只是接管了依赖以及安装包的维护。然后当开发流程的打包机制改造完毕,开发人员的习惯逐渐改变,这时候就可以引入 Docker 的网络解决方案,先改造应用直接通过容器的网络进行通信,但部署和调度都沿用原来的模式。等这些都改造完,运维也成熟了,然后开启 Swarm 模式,将应用的部署和调度交给 Swarm,基本上完成了应用的容器化改造。**这就像谈恋爱一样,先约约会,牵牵小手,然后(此处省略若干字),然后才是谈婚论嫁,考虑要不要做一辈子的承诺。**而其他编排系统呢,一上来就要用户回答:你准备把你的一切以及后半生交付给我了么?很多人就得犹豫了吧。

-

-总结一下,这一年,Docker 已经不是原来的 Docker,它代表一种容器方案,一个系统软件,也代表一个商标,一个公司,还代表一种容器编排调度系统。容器之战刚刚开始,三足鼎立,胜负未知。但无论最后结果如何,Docker 一初创公司,从开发者工具切入,仅仅三年,火遍全球技术圈,搅动整个服务器端技术栈,进而涉足企业应用市场,携用户以抗巨头,前所未有。传统的企业市场,决策权多在不懂技术的领导,所以解决方案中对开发者是否友好,不是一个关键点,但从 Docker 以及国外最近的一些公司的案例(比如 slack,twilio 等)来看,这一现象正在改变,这表明了开发者群体的成熟和话语权的增加,企业应用对开发者的友好程度将成为一个竞争的关键点。

-

-### Kubernetes

-

-我在 2015 年底分析 Kubernetes 架构的时候,当时 1.2 版本尚未发布。到现在已经发布了 1.6 beta 版本了。去年是 Kubernetes 爆发的一年,从社区文章以及 meetup 就可以看出来。有很多文章已经等不及开始宣布 Kubernetes 赢得了容器之战了。

-

-Kubernetes 的优势是很多概念抽象非常符合理想的分布式调度系统,即便是你自己重新设计这样一个系统,经过不断优化和抽象,最后也会发现,不可避免的慢慢向 Kubernetes 靠近。 比如 Pod,Service,Cluster IP,ReplicationController(新的叫 ReplicaSets ),Label,以及通过 Label 自由选择的 selector 机制,以及去年引入的 DaemonSets 和 StatefulSets。

-

-DaemonSets 用于定义需要每个主机都部署一个,并且不需要动态迁移的服务,比如监控的服务。Swarm 中尚未引入这种概念,不过这种也可能会用另外的实现方式,比如插件机制。通过 DaemonSet 定义的服务可以理解成分调度系统的 agent 扩展插件。

-

-StatefulSets(1.5 版本之前叫 PetSets)主要是为了解决有状态服务部署的问题,它保证 pod 的唯一的网络标志(主要是 pod 的 hostname,ip 是否能保持不变取决于网络实现)的稳定性,不随 pod 迁移重建而变化,另外支持了 PersistentVolume 规范,封装了已有的分布式存储以及 IaaS 云的存储接口。

-

-网络方面,Kubernetes 推出 CNI(Container Network Interface) 网络标准。这个标准比较简单,只是约定了调用命令的参数,如果想扩展自己的实现,只需要写个命令行工具放到系统 path 下,然后根据 CNI 调用的参数来给容器分配网络即可,可以用任何语言实现。它和 Kubernetes 基本没有任何耦合,所以也可以很容易被其他调度系统采用(比如 Mesos)。

-

-从 Kubernetes 的演进可以看出,谷歌对 Kubernetes 的期望在标准制定,最核心的点是描述能力。官方文档 [What is Kubernetes?](undefined) 中有这样一段描述:

-

-> Kubernetes is not a mere “orchestration system”; it eliminates the need for orchestration. The technical definition of “orchestration” is execution of a defined workflow: do A, then B, then C. In contrast, Kubernetes is comprised of a set of independent, composable control processes that continuously drive current state towards the provided desired state. It shouldn’t matter how you get from A to C: make it so.

-

-它的目标不仅仅是一个编排系统,而是提供一个规范,可以让你来描述集群的架构,定义服务的最终状态,它来帮助你的系统达到和维持在这个状态。这个其实和 Puppet/Ansible 等配置管理工具的目的是一致的,只是配置管理工具只能做达到某个状态,没法实现维持到这个状态(没有动态的伸缩以及故障迁移等调度能力),同时配置管理工具的抽象层次也比较低。它之所以选择容器只是因为容器比较容易降低主机和应用的耦合,如果有其他技术能达到这个目的,支持下也不影响它的定位。所以 Kubernetes 去年推出 CRI (Container Runtime Interface) 容器标准,将 Kubernetes 和具体的容器实现进一步解耦,一方面是对 Docker 内嵌 Swarm 的一种反制,另外一方面也是它的目标的必然演进结果。

-

-正因为这样,它让渡出了很大一部分功能给 IaaS 云(比如网络,存储),也不着急推出具体的解决方案,也不着急兼容已有的各种分布式应用,发布两年多还在专心在规范定义以及系统优化上。Kubernetes 系出名门,不担心商业化的问题,大家闺秀不愁嫁,无需迎合别人,自然有人来适应自己。

-

-当然理想是美好的,现实是当前已经有大量的分布式系统,重复实现了许多 Kubernetes 已经实现的功能,或者集群机制是当前的 Kubernetes 的抽象概念没有覆盖到的,当前将这些系统运行到 Kubernetes 还是一件很难的事情(比如 redis cluster,hadoop,etcd,zookeeper,支持主从自动切换的mysql集群等),因为任何抽象都是以损失个性化和特殊化为代价的。这里特别说下,以前分析 Kubernetes 的时候有人反驳我这个说法,我这里不是说 Kubernetes 上不能运行 zookeeper 这样的服务,而是很难实现一键部署并且自动伸缩以及配置自动变更,很多情况下还是需要手动操作接入,比如官方的这个 [zookeeper 例子](undefined)。

-

-CoreOS 为了解决这个问题,推出了 [operator](undefined) 的概念,给不容易通过 Kubernetes 当前的抽象描述的服务(有状态服务或者特殊的集群服务),专门提供一个 operator,operator 通过调用 Kubernetes 的 API 来实现伸缩,恢复,升级备份等功能。这样虽然和 Kubernetes 的声明式理念相冲突,也无法通过 kubectl 直接操作(kubectl 有支持插件机制的提案,未来这种需求可能通过插件实现),也但当前也是一个可行的办法。

-

-另外,Kubernetes 在大数据方面支和 Mesos 还有差距。去年 Kubernetes 支持了 job 概念,job 生成的 pod 执行完成后立刻退出,原来的 service 可以理解成一个死循环的 job。这样,Kubernetes 就具有了分发批量任务的能力,但还缺乏上层的应用接口。理论上,将 Hadoop 的 MapReduce 移植到 Kubernetes,用 Kubernetes 替代底层的 Yarn 的资源调度功能,也是可行的(只是开脑洞,没有具体分析)。有个打算整合 Yarn 和 Kubernetes 的项目已经很久没更新了,这两者的整合我不太看好,两个系统冲突严重,是互相替代的关系,不像 Mesos 和 Kubernetes 的整合(这个后面 Mesos 的段落会分析)。

-

-部署复杂是 Kubernetes 一直被大家诟病一点。2015 年我做测试的时候,部署一套 Kubernetes 是一项很复杂的工作。去年 Kubernetes 推出了 kubeadm,很大程度的降低了部署的复杂度。当前 Kubernetes 除了 kubelet 需要直接在主机上启动,其他的组件都可以通过 Kubernetes 自己托管,一定程度上实现了『自举』,但易用度上和 Swarm 还是有差距。

-

-随着 Kubernetes 的成熟,其他厂商开始制作自己的发行版,比如 CoreOS。CoreOS 原来的容器思路应该是通过自己定制的容器操作系统,以及 etcd ,将多个 CoreOS 主机合并成一个集群,然后通过改造过的 systemd 充当 agent,上面再增加一个调度器,就可以实现容器编排调度,也是一种可行的思路,既然单机的服务进程管理可以通过 systemd,将多个机器的 systemd 连接起来不就是一个分布式的服务进程管理?但后来改变了策略,估计是这种方案采纳成本太高(用户需要同时改变自己主机的操作系统以及应用的部署习惯),所以当前的容器策略变为了定制 Kubernetes,推出 tectonic,CoreOS 改名为 Container Linux(应该是为了避免产品和公司的名称重叠,另外也透露出的一个信息是产品重心的变更),专注于主机操作系统(这个后面的操作系统部分会分析到)。

-

-总结一下,Kubernetes 经过一年快速发展,基本已经非常完备。原来的 kube-proxy 的性能问题(1.2 版本之前),也已经解决。建议原来处于观望状态的用户可以入坑了。不过在应用的最终 package 定义上,Kubernetes 尚未推出自己的解决方案,不确定这个是打算官方来搞,还是让度给发行版厂商,不过可以预计2017年肯定会有相关方案推出。

-

-### Mesos

-

-如果说 Kubernetes 是为了标准而生,那 Mesos 则是为了资源而生。它的理念是:

-

-> define a minimal interface that enables efficient resource sharing across frameworks, and otherwise push control of task scheduling and execution to the frameworks

-

-定义一个最小化的接口来支持跨框架的资源共享,其他的调度以及执行工作都委托给框架自己来控制。

-

-也就是说它的视角是资源视角,目标是资源共享。这个和 Kubernetes 的目标其实是一体两面,一个从定义描述角度一个从资源角度。Mesos 其实是最早切入容器领域的,但它的容器封装的比较简单,只是用来做简单的资源隔离,用户一般没什么感知。有了 Docker 以后,也引入了 Docker,但正如前面我分析的原因,Mesos 上的 Docker 一直有点别扭,于是 Mesos(准确的说应该是 mesosphere DC/OS) 搞了一个 Universal container,改进了 Mesos 原来的容器,支持了 Docker 的镜像格式,这样用户可以在自己的开发环境中使用 Docker,但生产环境中就可以直接切换到 Mesos 自己的容器上,虽然可能有一些兼容性问题,但镜像格式这种变化不会太快,问题在可控范围内。

-

-这也从另外一方面表明了 Docker 的镜像格式基本上已经成了一个事实标准,一个容器解决方案能否切入整个生态圈的关键是是否支持 Docker 镜像格式。当然 Mesos 成员对这点其实也有点抵触,在一些分享里强调 Mesos 也支持部署其他类型的软件包格式,比如gzip等,尤其大规模服务器的场景,从 Docker 仓库拉取镜像有瓶颈。这点个人不太同意,大规模服务器场景,从任何中心节点拉取任何格式的安装包都会有问题,所以 twitter 才搞 p2p 安装包分发,但 Docker 镜像也可以搞成 p2p 分发的,只要有需求,肯定有人能搞出来。

-

-容器网络方面,原来 Mesos 的网络解决方案就是端口映射,应用需要适应 Mesos 做修改,对应用倾入性比较强,通用性较差,所以 Mesos 支持了 Kubernetes 发起的 CNI 网络标准,解决了这个问题。

-

-Mesos 通过 framework 的机制,接管了当前已经存在的分布式系统的一部分职能,让多个分布式系统共享同一个资源池变为可能,容器编排也只是 Mesos 之上的一种应用(Marathon)。这种方式的好处是让整合复杂的分布式系统变为可能,因为 framework 是编程接口,灵活度也比较高,很多不容易跑在 Kubernetes 上的复杂应用,都可以在 Mesos 之上,比如 Hadoop 等大数据相关的系列应用。

-

-正因为 Mesos 和 Kubernetes 的目标正好是一体两面,然后能力也可以互补,所以很早就有人想整合 Kubernetes 和 Mesos,将 Kubernetes 跑在 Mesos 之上,这样 Kubernetes 接管容器编排调度,替代 Marathon,Mesos 解决其他复杂的分布式应用,实现多种应用的资源共享。但 [kubernetes-mesos](undefined) 这个项目后来就不活跃了,一方面是 Kubernetes 变化太快,另外一方面估计是 mesosphere 发现和 Kubernetes 的竞争大于合作吧。后来 IBM 搞了个 [kube-mesos-framework](undefined) 放在 Kubernetes 孵化器里孵化,不过当前尚不能正式使用。个人感觉如果要真的很好整合,对 Kubernetes 和 Mesos 两方都需要做很大改造,但这个项目对生态圈来说是一个大变数,有可能打破三足鼎立的局势。

-

-Mesosphere 的 DC/OS 在 Mesos 基础上搞了一个分布式应用的 package 规范。以前的应用发布都只能发布面向单机操作系统的 package,Mesosphere 通过 Marthon,镜像以及配置文件,定义了一套分布式的 package 规范,用户可以通过一个命令从仓库(repo)上部署复杂的分布式应用到 Mesos。这个和 Docker 的 Store 思路类似。

-

-总结一下,Mesos 的优势是可定制性强,它诞生于 twitter 这样的互联网公司,也比较受互联网公司欢迎。互联网公司的基础设施以及系统大多是自己研发,可以通过规范来要求自己的应用适应调度系统,所以对标准化和抽象能力的的需求不如资源共享强烈。它的缺点是周边生态比较庞杂,接口以及规范设计上,没有 Kubernetes 那么『优雅』。

-

-### Rancher

-

-既然容器之上的编排系统已经三足鼎立了,各有所长了,还有其他机会么?Rancher 尝试了另外一个途径。它自己的定义是一种 IaaS,一种基于容器的 IaaS。首先,它通过容器降低了部署成本,每个只需节点运行一个命令就能部署一套 Rancher 系统,相对于 OpenStack 这种复杂的 IaaS 来说就太容易了。其次,它自己的定位是专门运行容器编排系统的 IaaS,可以在上面一键部署 Kubernetes,Docker Swarm,Mesos。容器编排系统,直接运行到物理机上还是需要一些改造,并且有升级和运维困难的问题,于是 Rancher 出来了,希望抽象出一层非常薄的 IaaS 来解决这个问题。

-

-它的思路是既然现在三家纷争,选哪一方都是一个艰难的决定,那不如选 Rancher 好了。Rancher 一方面可以让几种编排系统共存,另外一方面降低了以后的切换成本,这个艰难的决定可以以后再做。

-

-另外它也推出了自己的应用规范和应用仓库(App Catalogs),它的应用规范也兼容其他的容器编排系统的定义文件,相当于一个容器编排系统应用的一个超集。这样和基础设施相关的应用可以用 Rancher 自己的规范,和业务相关的,变化快需要动态伸缩的应用可以放到容器编排系统中,以后切换也不麻烦。

-

-不过 Rancher 的这个产品假设的问题是,假如以后容器编排调度系统是一家独大,那它的存在空间就会越来越小了。

-

-### 容器平台去向何方?CaaS,IaaS,PaaS,SaaS?

-

-有人把容器服务叫做 CaaS(Container as a Service),类似于当前 IaaS 平台上的数据库服务(RDB as a Service)等,是 IaaS 之上的一种新的应用服务。但个人认为 CaaS 其实是一个伪需求,用户需要的并不是容器,从来也没有人把 IaaS 叫做 VaaS(VM as a Service),容器服务提供的是一种运行环境,并不是具体的服务。

-

-容器编排调度平台首先是一个面向开发者的的工具平台,它上面调度的是应用,这是和当前 IaaS 最大的区别。当前的 IaaS 主要面向的是管理者,调度的是资源,所以 IaaS 的使用入口主要是控制台,虽然有 API,但指令式的 API 使用复杂度要远大于声明式的 API,并且 API 的使用者也多是运维工具,很少有融入业务系统的使用场景。这是由当前 IaaS 云的历史使命决定的。云的第一步是让用户把应用从自己的机房迁移到云上,只有提供可以完全模拟用户物理机房的环境(虚拟机模拟硬件支持全功能的OS,SDN网络,云硬盘存储),对应用无侵入,用户的迁移成本才更低。

-

-但当这一步完成时,用户就会发现,这样虽然省去了硬件的维护成本,但应用的开发维护成本并没有降低,认识到自己本质的需求并不是资源,而是应用的运行环境。这个需求有点像 PaaS,但原来的 PaaS 的问题是对应用的侵入性太强,并且和开发语言绑定,能直接部署的应用有限,用户需要的是一种更通用的 PaaS,可以叫(Generic Platform as a Service),这个词是我生造的,就是一种基本可以部署任何复杂应用的平台服务,正好容器平台可以承担起这样一种职责。

-

-容器平台虽然都有各自的历史背景和侧重点,解决方案也不一样,但最终指向的目标却是一致的,就是屏蔽分布式系统的资源管理细节,提供分布式应用的标准运行环境,同时定义一种分布式应用的 package,对开发者来说降低分布式系统的开发成本,对用户来说降低分布式应用的维护成本,对厂商来说降低分布式应用的分发成本。总结一下,其实就是 DataCenter OS 或 Distributed OS。DC/OS 这个词虽然已经被 Mesosphere 用在自己的产品上了,但个人认为它是所有容器平台的最终目标。当然,这次容器浪潮是否能真的实现这个目标还不好说,但至少现在看来是有希望的。

-

-于是, PaaS 会变成了 DCOS 之上的 devops 工具栈,当前很多 PaaS 平台正向这个方向演进。而 IaaS 就变成了给 DCOS 提供运行环境的服务,DCOS 接管了上层的应用以及基础服务。当然 IaaS 之上还有其他的 SaaS 模式的服务(由于 SaaS,PaaS 的外延并没有精确定义,很多场景下,把面向开发者的 SaaS 模式的中间件叫做 PaaS 组件,我的理解是通过软件实现多租户,完全按量计费的服务都应该属于 SaaS,比如对象存储。这个要细说,估计需要另外一篇文章,这里就不详细分析了),SaaS 模式资源利用率最高,对用户的成本最低,用户一般不会用独立部署的服务去替换。这样一来,格局就变成了用户在 IaaS 之上部署一套 DCOS,需要独立部署的服务以及自己开发的服务都运行在 DCOS 之中,其他的能抽象成标准 SaaS 服务的中间件则优先用 IaaS 提供的。相当于 IaaS 将独立部署的基础设施服务,以及用户自己的服务的部署和调度让渡给了 DCOS。当然,最后 IaaS 本身是否会直接变成一种多租户的 DCOS,由调度资源变成直接调度应用,也不是没可能,但这样调度层会面临非常大的压力,数据中心支撑的节点会受限,暂时看来两层调度的可行性更大些。

-

-这对整个 IaaS 影响很大,所以有人说对 AWS 造成威胁的可能不是 Google Cloud,而是 Kubernets(DCOS)。但即便是 DCOS 成熟,最后如何商业化还是有很大的变数。大家理想中的那个像 Apple 的 AppStore 的服务器端应用市场,最终会是由 DCOS,SaaS,还是 IaaS 服务商提供?DCOS 的优势是掌握了标准可以定义应用规范,SaaS 服务商的优势是直接面向最终用户,可能占据企业应用入口,IaaS 服务商的优势是它掌控了应用的运行环境,无论在计费模式还是反盗版上都有很大优势。但在私有云领域,IaaS 产品会面临 DCOS 更大的冲击。私有云领域如果多租户隔离的需求没那么强烈的情况下,部署一套 DCOS 是一种更简单高效的选择。

-

-### 容器与虚拟机之争

-

-从 Docker 技术成为热门开始,容器与虚拟机的争论就从来没有停止过。但去年一年,大家的注意力逐渐转移到上层,容器和虚拟机的争论算告一段落。这个主要是因为容器本身的外延在变化。

-

-容器,首先它不是一个技术词汇,它是一个抽象概念。顾名思义,就是装东西的器皿,装什么东西呢?应用。

-

-其实 J2EE 领域很早就使用了容器(Container)概念,J2EE 的服务器也叫做 web container 或者 application container,它的目标就是给 Java web 应用提供一种标准化的运行环境,方便开发,部署,分发,只不过这种容器是平台绑定的。

-

-而 Linux 容器自诞生之初,就是一组进程隔离的技术的统称。随着容器领域的竞争与演进,Kubernetes 的 OCI (Open Container Initiative)标准推出,Docker,Unikernels, CoreOS 的 Rocket,Mesos 的 Universal container,Hyper 的 [HyperContainer](undefined)(基于 VM 的容器解决方案) 等百花齐放,容器的概念逐渐清晰,我们这里可以下个定义:

-

-> 容器就是对应用进程的一种标准化封装,无论是采用 linux 的 cgroup namespace 技术,还是使用虚拟化 hypervisor 技术来做这种封装,都不是关键,关键是是目标,容器是为应用标准化而生。

-

-也就是说,最早,大家认为容器是和虚拟机一样的一种隔离技术,所以会拿容器和虚拟机做比较,比较二者的隔离成本,隔离安全性,但现在容器的外延变了,和传统虚拟机的本质差异不在于封装技术,而在于封装的目标,传统虚拟机封装的目标是操作系统,为操作系统提供虚拟化硬件环境,而容器封装的目标是应用进程,其中内嵌的操作系统只是应用的依赖而已。

-

-另外一方面,基于虚拟机的调度系统,比如 OpenStack,也可以将容器作为自己的调度系统的 compute_driver,也就是将容器当虚拟机使用,用来降低虚拟机的隔离成本。所以容器与虚拟机之争本质上是调度理念之争,而不是隔离技术之争。

-

-### 容器对操作系统的影响

-

-Docker 没出现之前,服务器端的操作系统基本是传统 Linux 大厂商的天下,Ubuntu 好不容易通过自己的桌面版的优势赢得一席之地,一个创业公司试图进入这个领域基本是没有机会的,但 Docker 的出现带来了一个契机。这个契机就是一个操作系统需要考虑自己的目标是管理硬件还是管理应用。如果是管理硬件,也就是运行在物理机上的操作系统,目标就是提供内核,管理好硬件(磁盘,网络等),而应用层的事情交给容器,这样硬件层的操作系统不需要考虑各种应用软件栈的兼容问题,降低了操作系统的维护成本。如果是管理应用,那就可以放弃对硬件层的管理,专心维护软件栈。所以这个领域能冒出几家创业公司的产品试水:

-

-1. CoreOS 的 Container Linux 以及 Rancher 的 RancherOS 这两个 OS 的主要目标都是接管硬件,将主机操作系统从复杂的软件栈中解放出来,专心管理硬件和支持容器。传统的 Linux 操作系统为维护上层软件栈的兼容性付出了巨大的成本,发行版的一个优势在于提供全面软件栈的兼容性测试。而当二者解耦后,这个优势不再,竞争的核心在于能否提供更好的支持容器以及系统和内核的升级。

-2. Alpine Linux 这个精简后的 Linux 发行版则是专注于维护软件栈,给容器内的应用提供运行环境。所以它可以做到非常小,默认只有几M大小,即便是包含 bash 进去,也只十多M。所以 Docker 官方默认以它作为镜像的基础系统。

-

-操作系统的演进和更替是一个长期的工程,基本上得伴随着硬件的淘汰,所以至少五到十年的演进,着急不得,但可以期待。

-

-### 关于技术类创业的思考

-

-技术类创业,要思考清楚自己的机会是在市场还是在技术生态圈里占领一席之地。当然前者要比后者容易,后者最终也得变为市场的应用才能盈利,而即便是在技术生态圈中取得地位也不一定能找到商业模式,不过后者的潜力要大于前者。国内的创业一般倾向与前者,而国外则多倾向与后者,所以国内同质化的竞争比较激烈,而在差异化的生态构建方面则缺少建树。主要是因为国内的技术积累以及普及度和国外还有差距,还属于追随者,只有追随并赶超之后才会有创新,这个和 2C 领域的类似,2C 领域最近越来越少 C2C(Copy To China) 模式成功的案例了,2B 领域肯定还需要些年,不过感觉应该也不远。

-

-个人认为,2017 年容器编排调度领域的竞争会上升到应用层面,DCOS 之上的多语言应用框架(比如 微服务框架,Actor 模型框架),各种已有应用和基础设施的容器化,标准化,让已有应用变为云原生(Cloud Native)应用,等等。

-

-当然,理想和现实之间是有鸿沟的。一波一波的技术变革,本质上其实都是在试图将开发和运维人员从琐碎的,重复的,无聊的任务中解放出来,专注于有创意的领域。但变革最难变革的是人的思维方式和做事习惯,以及应对来自组织的阻碍。你说云应该就是按需的,动态的,自服务的,但用户的运维部门就喜欢审批开发人员资源申请,于是云变成了一个虚拟机分配系统。你说资源应该动态调度,应用混合部署有利于提高资源利用率,但用户的安全部门要求应用的业务必须分层,每层必须需要部署到独立的服务器上,跨层调用的端口还需要申请。**所以技术变革最后要落地成商业模式,首先要通过技术理念的传播去改变用户的思维方式以及组织体系,当然这肯定不可能是一蹴而就的,是一个长期的,反复过程**,其次要等待业务需求的驱动,当业务增长导致软件复杂度到一定规模的时候,自然会寻求新技术来解决复杂性。

\ No newline at end of file

diff --git a/docker/docs/convoy.md b/docker/docs/convoy.md

deleted file mode 100644

index 2a7a9a65f..000000000

--- a/docker/docs/convoy.md

+++ /dev/null

@@ -1,18 +0,0 @@

-# Convoy

-

-Convoy是Rancher公司的产品,目前已开源[https://github.com/rancher/convoy](https://github.com/rancher/convoy)

-

-A Docker volume plugin, managing persistent container volumes.

-

-后端存储支持三种方案:

-

-Device Mapper

-Amazon Elastic Block Store

-Virtual File System/Network File System

-Device Mapper

-

-Amazon Elastic Block Store

-

-Virtual File System/Network File System

-

-**该项目Rancher官方已经不维护了。不建议使用,目前使用也有问题,创建的backup无法显示正确的URL地址。目前已知唯品会在使用convoy。**

\ No newline at end of file

diff --git a/docker/docs/cpu_resource_limit.md b/docker/docs/cpu_resource_limit.md

deleted file mode 100644

index c132bb159..000000000

--- a/docker/docs/cpu_resource_limit.md

+++ /dev/null

@@ -1,115 +0,0 @@

-# Docker CPU资源限制

-

-## 一、压测工具

-

-使用 stress 测试。

-

-## 二、CPU 测试

-

-- [Runtime constraints on resources](https://docs.docker.com/engine/reference/run/#runtime-constraints-on-resources)

-- 目前 Docker 支持 CPU 资源限制选项

- - `-c`, `--cpu-shares=0`CPU shares (relative weight)-c 选项将会废弃,推荐使用 `--cpu-shares`

- - `--cpu-period=0`Limit the CPU CFS (Completely Fair Scheduler) period

- - `--cpuset-cpus=""`CPUs in which to allow execution (0-3, 0,1)

- - `--cpuset-mems=""`Memory nodes (MEMs) in which to allow execution (0-3, 0,1). Only effective on NUMA systems.

- - `--cpu-quota=0`Limit the CPU CFS (Completely Fair Scheduler) quota

-

-```

-➜ ~ docker help run | grep cpu

- --cpu-shares CPU shares (relative weight)

- --cpu-period Limit CPU CFS (Completely Fair Scheduler) period

- --cpu-quota Limit CPU CFS (Completely Fair Scheduler) quota

- --cpuset-cpus CPUs in which to allow execution (0-3, 0,1)

- --cpuset-mems MEMs in which to allow execution (0-3, 0,1)

-

-```

-

-### 2.1 CPU share constraint: `-c` or `--cpu-shares`

-

-默认所有的容器对于 CPU 的利用占比都是一样的,`-c` 或者 `--cpu-shares` 可以设置 CPU 利用率权重,默认为 1024,可以设置权重为 2 或者更高(单个 CPU 为 1024,两个为 2048,以此类推)。如果设置选项为 0,则系统会忽略该选项并且使用默认值 1024。通过以上设置,只会在 CPU 密集(繁忙)型运行进程时体现出来。当一个 container 空闲时,其它容器都是可以占用 CPU 的。cpu-shares 值为一个相对值,实际 CPU 利用率则取决于系统上运行容器的数量。

-

-假如一个 1core 的主机运行 3 个 container,其中一个 cpu-shares 设置为 1024,而其它 cpu-shares 被设置成 512。当 3 个容器中的进程尝试使用 100% CPU 的时候「尝试使用 100% CPU 很重要,此时才可以体现设置值」,则设置 1024 的容器会占用 50% 的 CPU 时间。如果又添加一个 cpu-shares 为 1024 的 container,那么两个设置为 1024 的容器 CPU 利用占比为 33%,而另外两个则为 16.5%。简单的算法就是,所有设置的值相加,每个容器的占比就是 CPU 的利用率,如果只有一个容器,那么此时它无论设置 512 或者 1024,CPU 利用率都将是 100%。当然,如果主机是 3core,运行 3 个容器,两个 cpu-shares 设置为 512,一个设置为 1024,则此时每个 container 都能占用其中一个 CPU 为 100%。

-

-测试主机「4core」当只有 1 个 container 时,可以使用任意的 CPU:

-

-```

-➜ ~ docker run -it --rm --cpu-shares 512 ubuntu-stress:latest /bin/bash

-root@4eb961147ba6:/# stress -c 4

-stress: info: [17] dispatching hogs: 4 cpu, 0 io, 0 vm, 0 hdd

-➜ ~ docker stats 4eb961147ba6

-CONTAINER CPU % MEM USAGE / LIMIT MEM % NET I/O BLOCK I/O

-4eb961147ba6 398.05% 741.4 kB / 8.297 GB 0.01% 4.88 kB / 648 B 0 B / 0 B

-

-```

-

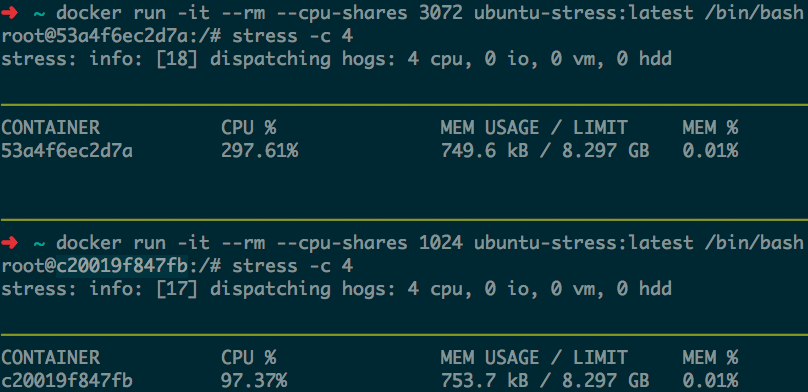

-测试两个 container,一个设置为 3072,一个设置 1024,CPU 占用如下:

-

-

-

-### 2.2 CPU period constraint: `--cpu-period` & `--cpu-quota`

-

-默认的 CPU CFS「Completely Fair Scheduler」period 是 100ms。我们可以通过 `--cpu-period` 值限制容器的 CPU 使用。一般 `--cpu-period` 配合 `--cpu-quota` 一起使用。

-

-设置 cpu-period 为 100ms,cpu-quota 为 200ms,表示最多可以使用 2 个 cpu,如下测试:

-

-```

-➜ ~ docker run -it --rm --cpu-period=100000 --cpu-quota=200000 ubuntu-stress:latest /bin/bash

-root@6b89f2bda5cd:/# stress -c 4 # stress 测试使用 4 个 cpu

-stress: info: [17] dispatching hogs: 4 cpu, 0 io, 0 vm, 0 hdd

-➜ ~ docker stats 6b89f2bda5cd # stats 显示当前容器 CPU 使用率不超过 200%

-CONTAINER CPU % MEM USAGE / LIMIT MEM % NET I/O BLOCK I/O

-6b89f2bda5cd 200.68% 745.5 kB / 8.297 GB 0.01% 4.771 kB / 648 B 0 B / 0 B

-

-```

-

-通过以上测试可以得知,`--cpu-period` 结合 `--cpu-quota` 配置是固定的,无论 CPU 是闲还是繁忙,如上配置,容器最多只能使用 2 个 CPU 到 100%。

-

-- [CFS documentation on bandwidth limiting](https://www.kernel.org/doc/Documentation/scheduler/sched-bwc.txt)

-

-### 2.3 Cpuset constraint: `--cpuset-cpus`、`--cpuset-mems`

-

-#### `--cpuset-cpus`

-

-通过 `--cpuset-cpus` 可以绑定指定容器使用指定 CPU:

-

-设置测试容器只能使用 cpu1 和 cpu3,即最多使用 2 个 固定的 CPU 上:

-

-```

-➜ ~ docker run -it --rm --cpuset-cpus="1,3" ubuntu-stress:latest /bin/bash

-root@9f1fc0e11b6f:/# stress -c 4

-stress: info: [17] dispatching hogs: 4 cpu, 0 io, 0 vm, 0 hdd

-➜ ~ docker stats 9f1fc0e11b6f

-CONTAINER CPU % MEM USAGE / LIMIT MEM % NET I/O BLOCK I/O

-9f1fc0e11b6f 199.16% 856.1 kB / 8.297 GB 0.01% 4.664 kB / 648 B 0 B / 0 B

-➜ ~ top # 宿主机 CPU 使用情况

-top - 12:43:55 up 3:18, 3 users, load average: 3.20, 2.54, 1.82

-Tasks: 211 total, 3 running, 207 sleeping, 1 stopped, 0 zombie

-%Cpu0 : 0.7 us, 0.3 sy, 0.0 ni, 99.0 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st

-%Cpu1 :100.0 us, 0.0 sy, 0.0 ni, 0.0 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st

-%Cpu2 : 0.7 us, 0.3 sy, 0.0 ni, 99.0 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st

-%Cpu3 :100.0 us, 0.0 sy, 0.0 ni, 0.0 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st

-... ...

-

-```

-

-以下表示容器可以利用 CPU1、CPU2 和 CPU3:

-

-```

-➜ ~ docker run -it --rm --cpuset-cpus="1-3" ubuntu-stress:latest /bin/bash

-

-```

-

-#### `--cpuset-mems`

-

-`--cpuset-mems` 只应用于 NUMA 架构的 CPU 生效,关于这个选项这里不过多介绍。关于 NUMA 架构可以参考这篇文章 [NUMA架构的CPU – 你真的用好了么?](http://cenalulu.github.io/linux/numa/)。

-

-## 三、源码解析

-

-- [github.com/opencontainers/runc/libcontainer/cgroups/fs](https://github.com/opencontainers/runc/tree/master/libcontainer/cgroups/fs)

- - cpu.go

- - cpuset.go

- - cpuacct.go

-

-libcontainer 只是根据设定值写 cgroup 文件,这部分没有什么逻辑性的解释。

-

-From:http://blog.opskumu.com/docker-cpu-limit.html

\ No newline at end of file

diff --git a/docker/docs/crane_usage.md b/docker/docs/crane_usage.md

deleted file mode 100644

index 77b373c87..000000000

--- a/docker/docs/crane_usage.md

+++ /dev/null

@@ -1,112 +0,0 @@

-# Crane的部署和使用

-

-Crane是数人云开源的一款基于swarmkit的容器管理平台。

-

-开源地址:https://github.com/Dataman-Cloud/crane

-

-## 功能##

-

-### 主机管理###

-

-- 节点概览:`id`、`主机名`、`角色`、`可用性`、`状态`、`标签`、`添加时间`等信息

- - id: 集群内的节点id

- - 主机名: 集群内节点主机名

- - 角色: 分为管理节点和工作节点,只有管理节点能调度server及节点角色。目前使用单管理节点。

- - 可用性: 调度开关状态、可用通过`操作`菜单维护。`停止调度`: 节点资源不可用,已经发布的任务会调度到其他可用资源。`暂停调度`: 该节点资源暂时不接受新任务调度,已经发布的任务不受影响。`正常调度`: 节点资源完全放开。

- - 状态:分为`就绪`和`下线`;`就绪`状态指节点状态正常,`下线`状态指节点已经离开群集、资源不可用。

- - 标签:节点的label信息、配合服务发布时的资源调度时使用。

- - 添加时间: 记录节点加入集群时间

-- 节点操作:

- - 连接主机:填写主机ip;点击连接,提示更新主机成功后,点击主机id,即可查询到主机详情。

- - 基本信息:Docker相关信息和主机的基本信息

- - 容器信息:主机上已有的容器统计信息

- - 网络: 主机上现有网络信息

- - 储存卷:主机上Docker的存储卷信息

- - 镜像:节点上已有的Docker镜像

- - 编辑标签:为主机编辑标签,便于服务发布时的策略调度使用。以`key``value`形式创建。

- - 停止调度:节点资源不可用,已经发布的任务会调度到其他可用资源。

- - 暂停调度: 该节点资源暂时不接受新任务调度,已经发布的任务不受影响。

- - 恢复调度: 节点资源恢复使用完全放开。

- - 删除主机:将主机从集群中删除,需要状态为下线状态。

-

-### 应用管理###

-

-目前所有发布的应用都会在应用首页展示,支持对应用的更新、删除、扩展、监控、日志查询、详情查询、连接容器终端等操作。

-

-**应用更新**: 在应用面板处选择待更新的应用,点击应用名称进入`应用详情`--`操作`--`更新`,跳转到`服务更新`界面,修改所需改动的信息,点击`更新`即可完成更新操作。

-

-*注:* 服务的网络模式以及服务模式不可更改,更新时会按照之前设置的更新策略执行,也可以更新`更新策略`。`更新策略`和`容错策略`的变更不会触发容器重启。

-

-**应用扩展**: 在应用面板处选择待更新的应用,点击应用名称进入`应用详情`--`操作`--`修改任务数`,修改的任务数会立即生效。不受更新策略影响。

-

-**应用删除**:

-

-在应用面板处选择待删除的应用,点击应用名称进入`应用详情`,点击`删除应用`,应用会立即被删除,且不能恢复,删除需谨慎 *注:* 若应用内多个服务,不能删除单个服务。

-

-**服务详情**

-

-在应用面板选择应用名称下的服务名称,会跳转到`服务详情`界面。

-

-- 任务列表:展示服务运行到所有任务数,点击每个任务最右侧的`+`,可以展示该任务的历史状态,即使修改过任务数,改处仍然可以找到任务的历史纪录,以及异常原因。

-

- - 容器详情:点击容器的id,可以跳转到`容器详情`界面:

- - 详情界面:展示了容器的`基础信息`、`环境变量`、`端口映射`、`网络配置`、`容器标签`、`存储卷`、`启动命令`等

- - 日志:该容器的实时日志信息。

- - 实时监控:获取容器实时的cpu、内存、网络io的使用情况。

- - 变更:记录容器的层结构变化。

- - 终端webssh:点击该按钮,可用直接连接到该容器内部,无需登录远程主机,无需主机口令,一键进入。

-

- *注:* 监控信息及日志信息实时展示,暂不支持导出。

-

-- 日志:该服务所有容器的实时日志信息的聚合,另外,日志中的关键词如 Error, Warning 会高亮显示。

-

-- 实时监控;服务的监控信息概览,同时显示不同任务的资源使用情况。

-

-- 详情:发布应用时设置的服务信息。

-

-- 入口列表:提供服务的外部访问地址。同时提供nginx的配置信息和haproxy的配置信息,便于用户管理。

-

-- 持续部署:如果该服务需要更新镜像,可以通过该命令直接更新,可用对接内部运维流程;需要保证:镜像地址确定可用。运行命令的主机可用连通服务端。

-

-### 网络管理###

-

-内置 overlay 网络实现应用网络隔离和独立的网络规划能力, 在创建应用时可以为服务指定相应的网络。

-

-### 创建网络

-

-docker1.12默认带有两种overlay网络,`ingress` 和`docker_gwbridge`;

-

-**ingress**

-

-Swarm manager使用`ingress`负载均衡,创建服务时做的端口映射作为service的默认VIP,virtual IP地址作为服务请求的入口。基于virtual IP进行负载均衡.集群内的ingress网络是基于节点端口模式的,集群内的每个监听这个端口的节点,都可以为那个服务路由流量。

-

-需要注意的是,即使指定了自定义网络,做了端口映射的服务也会自动添加ingress网络。

-

-**docker_gwbridge**

-

-`default_gwbridge` 网络只能用在非内部的网络环境下,连接到多主机网络的容器会自动连接到docker_gwbridge网络。这种网络模式让容器可以和集群外产生外部连接,并且在每个worker节点上创建。

-

-**your_own_overlay**

-

-如果有规划网络的需要,容器间做网络隔离,可用通过自定义网络实现。

-

-点击`创建网络`按钮,填写网络信息后`创建`即可。

-

-- 网络名称: 必须为数字或英文

-- 子网:示例:172.20.0.0/16

-- 网关:示例:172.20.10.1

-- ip范围:示例 172.20.10.0/24;可用ip从172.20.10.1~172.20.10.254。

-- 内部网络:如果为是,该网络不提供与集群外的通讯。

-- 标签:设置标签后,在发布新服务时可用通过标签选择网络。

-

-网络管理:

-

-除了`ingress`网络,均可在界面点击`删除`按钮操作。 如果想对已经创建的网络做更新操作,需要删除后重新创建。

-

-## 部署##

-

-1. 请确保 docker 安装版本 >=1.12 并正常运行, 我们可以通过命令 `docker version` 或者 `docker info`来确认 docker 的运行状态(如何安装和配置 docker 请参考 [https://docs.docker.com/engine/installation/)。](https://docs.docker.com/engine/installation/)%E3%80%82)

-2. 请确保 docker-compose 已经正确安装(如何安装 docker-compose 请参考 [https://docs.docker.com/compose/install/)。](https://docs.docker.com/compose/install/)%E3%80%82)

-3. docker,swarm 本身对操作系统还有一些设置需求,譬如主机时钟同步,selinux,docker daemon tcp 服务开启等。这些会在程序安装时自动进行检查, 请在安装时按提醒进行相应设置。

-4. 执行内测邮件中的安装命令,在安装过程中会提醒你输入当前主机的 IP 。

-5. 安装成功后通过浏览器访问 [http://$IP](http://%24ip/) 即可,默认用户名:admin@admin.com 密码:adminadmin

\ No newline at end of file

diff --git a/docker/docs/create_network.md b/docker/docs/create_network.md

deleted file mode 100644

index ed21ac0ff..000000000

--- a/docker/docs/create_network.md

+++ /dev/null

@@ -1,120 +0,0 @@

-# 如何创建docker network?

-

-容器的跨主机网络访问是docker容器集群的基础,我们之前使用的[Shrike](github.com/talkingdata/shrike)实现二层网络,能够使不同主机中的容器和主机的网络互联互通,使容器看上去就像是虚拟机一样,这样做的好处是可以不变动已有的服务,将原有的应用直接封装成一个image启动即可,但这也无法利用上docker1.12+后的service、stack等服务编排、负载均衡、服务发现等功能。我们在此讨论容器的网络模式,暂且忽略自定义网络,会在后面单独谈论它。

-

-## Swarm中已有的network##

-

-安装好docker并启动swarm集群后,会在集群的每个node中找到如下network:

-

-| NETWORK ID | NAME | DRIVER | SCOPE |

-| ------------------ | --------------- | ------------ | ----------- |

-| b1d5859a9439 | bridge | bridge | local |

-| 262ec8634832 | docker_gwbridge | bridge | local |

-| 19c11140a610 | host | host | local |

-| tx49ev228p5l | ingress | overlay | swarm |

-| ~~*c7d82cbc5a33*~~ | ~~*mynet*~~ | ~~*bridge*~~ | ~~*local*~~ |

-| e1a59cb1dc34 | none | null | local |

-

-**(注)**mynet是我们自定义的本地网络,我们暂时不用它,因为我们是以swarm集群模式使用docker,暂时不考虑本地网络;docker_gwbridge作为docker gateway网络,功能比较特殊,负责service的负载均衡和服务发现。

-

-**有两种方式来创建docker network:**

-

-- 使用docker network create命令来创建,只能创建docker内建的网络模式

-- 使用docker plugin,创建自定义网络

-

-## 使用docker命令创建网络##

-

-**Docker中内置的网络模式包括如下几种:**

-

-- bridge 我们基于该网络模式创建了mynet网络

-- host 本地网络模式

-- macvlan 这个模式貌似是最新加的

-- null 无网络

-- overlay 用于swarm集群中容器的跨主机网络访问

-

-**docker create network命令包含以下参数:**

-

-```

-Flag shorthand -h has been deprecated, please use --help

-

-Usage: docker network create [OPTIONS] NETWORK

-

-Create a network

-

-Options:

- --attachable Enable manual container attachment

- --aux-address map Auxiliary IPv4 or IPv6 addresses used by Network driver (default map[])

- -d, --driver string Driver to manage the Network (default "bridge")

- --gateway stringSlice IPv4 or IPv6 Gateway for the master subnet

- --help Print usage

- --internal Restrict external access to the network

- --ip-range stringSlice Allocate container ip from a sub-range

- --ipam-driver string IP Address Management Driver (default "default")

- --ipam-opt map Set IPAM driver specific options (default map[])

- --ipv6 Enable IPv6 networking

- --label list Set metadata on a network (default [])

- -o, --opt map Set driver specific options (default map[])

- --subnet stringSlice Subnet in CIDR format that represents a network segment

-```

-

-创建overlay模式的全局网络,我们可以看到新创建的mynet1的scope是swarm,即集群范围可见的。

-

-```shell

-172.18.0.1:root@sz-pg-oam-docker-test-001:/root]# docker network create -d overlay mynet1

-x81fu4ohqot2ufbpoa2u8vyx3

-172.18.0.1:root@sz-pg-oam-docker-test-001:/root]# docker network ls

-NETWORK ID NAME DRIVER SCOPE

-ad3023f6d324 bridge bridge local

-346c0fe30055 crane_default bridge local

-4da289d8e48a docker_gwbridge bridge local

-3d636dff00da host host local

-tx49ev228p5l ingress overlay swarm

-x81fu4ohqot2 mynet1 overlay swarm

-cc14ee093707 none null local

-172.18.0.1:root@sz-pg-oam-docker-test-001:/root]# docker network inspect mynet1

-[

- {

- "Name": "mynet1",

- "Id": "x81fu4ohqot2ufbpoa2u8vyx3",

- "Created": "0001-01-01T00:00:00Z",

- "Scope": "swarm",

- "Driver": "overlay",

- "EnableIPv6": false,

- "IPAM": {

- "Driver": "default",

- "Options": null,

- "Config": []

- },

- "Internal": false,

- "Attachable": false,

- "Containers": null,

- "Options": {

- "com.docker.network.driver.overlay.vxlanid_list": "4097"

- },

- "Labels": null

- }

-]

-

-```

-

-注意,overlay模式的网络只能在swarm的manager节点上创建,如果在work节点上创建overlay网络会报错:

-

-```shell

-172.18.0.1:root@sz-pg-oam-docker-test-002:/root]# docker network create -d overlay mynet1

-Error response from daemon: Cannot create a multi-host network from a worker node. Please create the network from a manager node.

-```

-

-如果不使用-d指定driver将默认创建本地bridge网络。

-

-## 自定义网络##

-

-创建自定义网络需要设置网络的driver和ipam。

-

-TDB

-

-创建网络需要满足的需求

-

-写一个创建自定义网络的例子

-

-[一步步教你创建一个自定义网络](create_network_step_by_step.md)

-

diff --git a/docker/docs/create_swarm_app.md b/docker/docs/create_swarm_app.md

deleted file mode 100644

index b8f30fbb7..000000000

--- a/docker/docs/create_swarm_app.md

+++ /dev/null

@@ -1,225 +0,0 @@

-# 创建docker swarm应用

-

-下面以docker官网上的创建[vote投票](https://docs.docker.com/engine/getstarted-voting-app/)示例来说明如何创建一个docker swarm的应用。

-

-在进行如下步骤时,你需要保证已经部署并正常运行着一个docker swarm集群。

-

-在这个应用中你将学到

-

-- 通过创建``docker-stack.yml``和使用``docker stack deploy``命令来部署应用

-- 使用``visualizer``来查看应用的运行时

-- 更新``docker-stack.yml``和``vote``镜像重新部署和发布**vote** 应用

-- 使用Compose Version 3

-

-

-

-## 需要使用到的images

-

-| Service | 描述 | Base image |

-| --------- | ---------------------------------------- | ---------------------------------------- |

-| vote | Presents the voting interface via port `5000`. Viewable at `:5000` | Based on a Python image, `dockersamples/examplevotingapp_vote` |

-| result | Displays the voting results via port 5001. Viewable at `:5001` | Based on a Node.js image, `dockersamples/examplevotingapp_result` |

-| visulizer | A web app that shows a map of the deployment of the various services across the available nodes via port `8080`. Viewable at `:8080` | Based on a Node.js image, `dockersamples/visualizer` |

-| redis | Collects raw voting data and stores it in a key/value queue | Based on a `redis` image, `redis:alpine` |

-| db | A PostgreSQL service which provides permanent storage on a host volume | Based on a `postgres` image, `postgres:9.4` |

-| worker | A background service that transfers votes from the queue to permanent storage | Based on a .NET image, `dockersamples/examplevotingapp_worker` |

-

-**用到的镜像有:**

-

-- dockersamples/examplevotingapp_vote:before

-- dockersamples/examplevotingapp_worker

-- dockersamples/examplevotingapp_result:before

-- dockersamples/visualizer:stable

-- postgres:9.4

-- redis:alpine

-

-我们将这些images同步到我们的私有镜像仓库sz-pg-oam-docker-hub-001.tendcloud.com中。

-

-镜像名称分别为:

-

-- sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_vote:before

-- sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_worker

-- sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_result:before

-- sz-pg-oam-docker-hub-001.tendcloud.com/library/visualizer:stable

-- sz-pg-oam-docker-hub-001.tendcloud.com/library/postgres:9.4

-- sz-pg-oam-docker-hub-001.tendcloud.com/library/redis:alpine

-

-## 使用V3版本的compose文件##

-

-[v3版本的compose与v2版本的区别](compose_v2v3.md)

-

-docker-stack.yml配置

-

-```Yaml

-version: "3"

-services:

-

- redis:

- image: sz-pg-oam-docker-hub-001.tendcloud.com/library/redis:alpine

- ports:

- - "6379"

- networks:

- - frontend

- deploy:

- replicas: 2

- update_config:

- parallelism: 2

- delay: 10s

- restart_policy:

- condition: on-failure

- db:

- image: sz-pg-oam-docker-hub-001.tendcloud.com/library/postgres:9.4

- volumes:

- - db-data:/var/lib/postgresql/data

- networks:

- - backend

- deploy:

- placement:

- constraints: [node.role == manager]

- vote:

- image: sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_vote:before

- ports:

- - 5000:80

- networks:

- - frontend

- depends_on:

- - redis

- deploy:

- replicas: 2

- update_config:

- parallelism: 2

- restart_policy:

- condition: on-failure

- result:

- image: sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_result:before

- ports:

- - 5001:80

- networks:

- - backend

- depends_on:

- - db

- deploy:

- replicas: 2

- update_config:

- parallelism: 2

- delay: 10s

- restart_policy:

- condition: on-failure

-

- worker:

- image: sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_worker

- networks:

- - frontend

- - backend

- deploy:

- mode: replicated

- replicas: 1

- labels: [APP=VOTING]

- restart_policy:

- condition: on-failure

- delay: 10s

- max_attempts: 3

- window: 120s

-

- visualizer:

- image: sz-pg-oam-docker-hub-001.tendcloud.com/library/visualizer:stable

- ports:

- - "8080:8080"

- stop_grace_period: 1m30s

- volumes:

- - "/var/run/docker.sock:/var/run/docker.sock"

- deploy:

- placement:

- constraints: [node.role == manager]

-

-networks:

- frontend:

- backend:

-

-volumes:

- db-data:

-```

-

-## 部署##

-

-使用docker stack deploy命令部署vote应用。

-

-```

-$docker stack deploy -c docker-stack.yml vote

-Creating network vote_backend

-Creating network vote_frontend

-Creating network vote_default

-Creating service vote_db

-Creating service vote_vote

-Creating service vote_result

-Creating service vote_worker

-Creating service vote_visualizer

-Creating service vote_redis

-```

-

-使用``docker stack deploy``部署的应用中的images必须是已经在镜像仓库中存在的,而不能像之前的docker-compose up一样,可以通过本地构建镜像后启动。

-

-使用``docker stack service vote``查看应用状态

-

-```

-$docker stack services vote

-ID NAME MODE REPLICAS IMAGE

-5bte3o8e0ta9 vote_result replicated 2/2 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_result:before

-h65a6zakqgq3 vote_worker replicated 1/1 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_worker:latest

-k7xzd0adhh52 vote_db replicated 1/1 sz-pg-oam-docker-hub-001.tendcloud.com/library/postgres:9.4

-pvvi5qqcsnag vote_vote replicated 2/2 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_vote:before

-z4q2gnvoxtpj vote_redis replicated 2/2 sz-pg-oam-docker-hub-001.tendcloud.com/library/redis:alpine

-zgiuxazk4ssc vote_visualizer replicated 1/1 sz-pg-oam-docker-hub-001.tendcloud.com/library/visualizer:stable

-```

-

-使用``docker stack ls``和``docker stack ps vote``查看stack的状态

-

-```

-$docker stack ls

-NAME SERVICES

-vote 6

-$docker stack ps vote

-ID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTS

-tcyy62bs26sp vote_worker.1 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_worker:latest sz-pg-oam-docker-test-003.tendcloud.com Running Running 4 minutes ago

-tfa84y1yz00j vote_redis.1 sz-pg-oam-docker-hub-001.tendcloud.com/library/redis:alpine sz-pg-oam-docker-test-002.tendcloud.com Running Running 5 minutes ago

-4yrp8e2pucnu vote_visualizer.1 sz-pg-oam-docker-hub-001.tendcloud.com/library/visualizer:stable sz-pg-oam-docker-test-001.tendcloud.com Running Running 5 minutes ago

-zv4dan0n9zo3 vote_worker.1 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_worker:latest sz-pg-oam-docker-test-003.tendcloud.com Shutdown Failed 4 minutes ago "task: non-zero exit (1)"

-mhbf683hiugr vote_result.1 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_result:before sz-pg-oam-docker-test-001.tendcloud.com Running Running 5 minutes ago

-slf6je49r4v1 vote_vote.1 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_vote:before sz-pg-oam-docker-test-002.tendcloud.com Running Running 5 minutes ago

-mqypecrgriyq vote_db.1 sz-pg-oam-docker-hub-001.tendcloud.com/library/postgres:9.4 sz-pg-oam-docker-test-001.tendcloud.com Running Running 4 minutes ago

-6n7856nsvavn vote_redis.2 sz-pg-oam-docker-hub-001.tendcloud.com/library/redis:alpine sz-pg-oam-docker-test-003.tendcloud.com Running Running 5 minutes ago

-pcrfnm20jf0r vote_result.2 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_result:before sz-pg-oam-docker-test-002.tendcloud.com Running Running 4 minutes ago

-ydxurw1jnft6 vote_vote.2 sz-pg-oam-docker-hub-001.tendcloud.com/library/examplevotingapp_vote:before sz-pg-oam-docker-test-003.tendcloud.com Running Running 5 minutes ago

-```

-

-## 检查##

-

-当vote应用成功部署后,在浏览器中访问visualizer所部属到的主机的8080端口http://sz-pg-oam-docker-hub-001.tendcloud.com:8080可以看到如下画面:

-

-

-

-Visualizer用于显示服务和主机的状态。

-

-**投票界面**

-

-在浏览器中访问``examplevotingapp_vote``所部属到的主机的5000端口http://sz-pg-oam-docker-hub-001.tendcloud.com:5000可以看到如下画面:

-

-

-

-给猫投一票。

-

-**结果界面**

-

-在浏览器中访问``examplevotingapp_result``所部属到的主机的5001端口http://sz-pg-oam-docker-hub-001.tendcloud.com:5001可以看到如下画面.

-

-

-

-

-

-##总结##

-

-至此整个应用已经完整的部署在docker上了,并验证正常运行。

-

-怎么样,是用docker来部署一个应用是不是很简单?

-

-其实后期的维护、升级、扩展都很简单,后面会详细的说明。

\ No newline at end of file

diff --git a/docker/docs/docker_compile.md b/docker/docs/docker_compile.md

deleted file mode 100644

index cf3c327df..000000000

--- a/docker/docs/docker_compile.md

+++ /dev/null

@@ -1,156 +0,0 @@

-# Docker源码编译和开发环境搭建

-

-官方指导文档:https://docs.docker.com/opensource/code/

-

-设置docker开发环境:https://docs.docker.com/opensource/project/set-up-dev-env/

-

-docker的编译实质上是在docker容器中运行docker。

-

-因此在本地编译docker的前提是需要安装了docker,还需要用git把代码pull下来。

-

-### 创建分支

-

-为了方便以后给docker提交更改,我们从docker官方fork一个分支。

-

-```shell

-git clone https://github.com/rootsongjc/docker.git

-git config --local user.name "Jimmy Song"

-git config --local user.email "rootsongjc@gmail.com"

-git remote add upstream https://github.com/docker/docker.git

-git config --local -l

-git remote -v

-git checkout -b dry-run-test

-touch TEST.md

-vim TEST.md

-git status

-git add TEST.md

-git commit -am "Making a dry run test."

-git push --set-upstream origin dry-run-test

-```

-

-然后就可以在``dry-run-test``这个分支下工作了。

-

-### 配置docker开发环境

-

-[官网](https://docs.docker.com/opensource/project/set-up-dev-env/)上说需要先清空自己电脑上已有的容器和镜像。

-

-docker开发环境本质上是创建一个docker镜像,镜像里包含了docker的所有开发运行环境,本地代码通过挂载的方式放到容器中运行,下面这条命令会自动创建这样一个镜像。

-

-在``dry-run-test``分支下执行

-

-```Shell

-make BIND_DIR=. shell

-```

-

-该命令会自动编译一个docker镜像,From debian:jessie。这一步会上网下载很多依赖包,速度比较慢。如果翻不了墙的话肯定都会失败。因为需要下载的软件和安装包都是在国外服务器上,不翻墙根本就下载不下来,为了不用这么麻烦,推荐直接使用docker官方的dockercore/docker镜像,也不用以前的docker-dev镜像,那个造就废弃了。这个镜像大小有2.31G。

-

-```

-docker pull dockercore/docker

-```

-

-使用方法见这里:https://hub.docker.com/r/dockercore/docker/

-

-然后就可以进入到容器里

-

-```Shell

-docker run --rm -i --privileged -e BUILDFLAGS -e KEEPBUNDLE -e DOCKER_BUILD_GOGC -e DOCKER_BUILD_PKGS -e DOCKER_CLIENTONLY -e DOCKER_DEBUG -e DOCKER_EXPERIMENTAL -e DOCKER_GITCOMMIT -e DOCKER_GRAPHDRIVER=devicemapper -e DOCKER_INCREMENTAL_BINARY -e DOCKER_REMAP_ROOT -e DOCKER_STORAGE_OPTS -e DOCKER_USERLANDPROXY -e TESTDIRS -e TESTFLAGS -e TIMEOUT -v "/Users/jimmy/Workspace/github/rootsongjc/docker/bundles:/go/src/github.com/docker/docker/bundles" -t "dockercore/docker:latest" bash

-```

-

-按照官网的说明make会报错

-

-```

-root@f2753f78bb6d:/go/src/github.com/docker/docker# ./hack/make.sh binary

-

-error: .git directory missing and DOCKER_GITCOMMIT not specified

- Please either build with the .git directory accessible, or specify the

- exact (--short) commit hash you are building using DOCKER_GITCOMMIT for

- future accountability in diagnosing build issues. Thanks!

-```

-

-这是一个[issue-27581](https://github.com/docker/docker/issues/27581),解决方式就是在make的时候手动指定``DOCKER_GITCOMMIT``。

-

-```

-root@f2753f78bb6d:/go/src/github.com/docker/docker# DOCKER_GITCOMMIT=3385658 ./hack/make.sh binary

-

----> Making bundle: binary (in bundles/17.04.0-dev/binary)

-Building: bundles/17.04.0-dev/binary-client/docker-17.04.0-dev

-Created binary: bundles/17.04.0-dev/binary-client/docker-17.04.0-dev

-Building: bundles/17.04.0-dev/binary-daemon/dockerd-17.04.0-dev

-Created binary: bundles/17.04.0-dev/binary-daemon/dockerd-17.04.0-dev

-Copying nested executables into bundles/17.04.0-dev/binary-daemon

-

-```

-

-bundles目录下会生成如下文件结构

-

-```

-.

-├── 17.04.0-dev

-│ ├── binary-client

-│ │ ├── docker -> docker-17.04.0-dev

-│ │ ├── docker-17.04.0-dev

-│ │ ├── docker-17.04.0-dev.md5

-│ │ └── docker-17.04.0-dev.sha256

-│ └── binary-daemon

-│ ├── docker-containerd

-│ ├── docker-containerd-ctr

-│ ├── docker-containerd-ctr.md5

-│ ├── docker-containerd-ctr.sha256

-│ ├── docker-containerd-shim

-│ ├── docker-containerd-shim.md5

-│ ├── docker-containerd-shim.sha256

-│ ├── docker-containerd.md5

-│ ├── docker-containerd.sha256

-│ ├── docker-init

-│ ├── docker-init.md5

-│ ├── docker-init.sha256

-│ ├── docker-proxy

-│ ├── docker-proxy.md5

-│ ├── docker-proxy.sha256

-│ ├── docker-runc

-│ ├── docker-runc.md5

-│ ├── docker-runc.sha256

-│ ├── dockerd -> dockerd-17.04.0-dev

-│ ├── dockerd-17.04.0-dev

-│ ├── dockerd-17.04.0-dev.md5

-│ └── dockerd-17.04.0-dev.sha256

-└── latest -> 17.04.0-dev

-

-4 directories, 26 files

-```

-

-现在可以将docker-daemon和docker-client目录下的docker可以执行文件复制到容器的/usr/bin/目录下了。

-

-启动docker deamon

-

-```Shell

-docker daemon -D&

-```

-

-检查下docker是否可用

-

-```

-root@f2753f78bb6d:/go/src/github.com/docker/docker/bundles/17.04.0-dev# docker version

-DEBU[0048] Calling GET /_ping

-DEBU[0048] Calling GET /v1.27/version

-Client:

- Version: 17.04.0-dev

- API version: 1.27

- Go version: go1.7.5

- Git commit: 3385658

- Built: Mon Mar 6 08:39:06 2017

- OS/Arch: linux/amd64

-

-Server:

- Version: 17.04.0-dev

- API version: 1.27 (minimum version 1.12)

- Go version: go1.7.5

- Git commit: 3385658

- Built: Mon Mar 6 08:39:06 2017

- OS/Arch: linux/amd64

- Experimental: false

-```

-

-到此docker源码编译和开发环境都已经搭建好了。

-

-如果想要修改docker源码,只要在你的IDE、容器里或者你本机上修改docker代码后,再执行上面的hack/make.sh binary命令就可以生成新的docker二进制文件,再替换原来的/usr/bin/目录下的docker二进制文件即可。

\ No newline at end of file

diff --git a/docker/docs/docker_compose.md b/docker/docs/docker_compose.md

deleted file mode 100644

index d6793e8b1..000000000

--- a/docker/docs/docker_compose.md

+++ /dev/null

@@ -1,129 +0,0 @@

-# Docker-compose

-

-docker-compose是一个使用python编写的命令行工具,用于docker应用之间的编排,可以在单主机下使用,也可以使用在docker swarm集群或docker1.12+的swarm mode下。

-

-docker1.13以前docker-compose是一个独立的安装的命令行工具,文档如下https://docs.docker.com/compose/overview/,下面要讲的是compose file,已经在docker1.13种集成了docker的应用编排功能,可以在提供了docker-compose.yml文件的情况下使用docker stack deploy -f docker-compose.yml直接部署应用。

-

-## Compose file

-

-Docker compose file到目前共有3个版本,docker1.13使用的compose file v3版本。官方文档:https://docs.docker.com/compose/compose-file/

-

-Compose file使用[yaml](yaml.org)格式定义,默认名称为docker-compose.yml。

-

-Dockerfile中的``CMD``,``EXPOSE``,``VOLUME``,``ENV``命令可以不必在docker-compose.yml中再定义。

-

-### build

-

-build命令在docker swarm mode下使用docker stack deploy命令时是无效的,只有在本地使用docker-compose命令时才会创建image。

-

-### ARGS

-

-假如Dockerfile中有如下两个变量``$buildno``和``$password``

-

-```dockerfile

-ARG buildno

-ARG password

-

-RUN echo "Build number: $buildno"

-RUN script-requiring-password.sh "$password"

-```

-

-docker-compose.yml中可以使用args来定义这两个变量的值。

-

-```Yaml

-build:

- context: .

- args:

- buildno: 1

- password: secret

-

-build:

- context: .

- args:

- - buildno=1

- - password=secret

-```

-

-使用docker-compose build的时候就会替换这两个变量的值。

-

-也可以忽略这两个变量。

-

-```

-args:

- - buildno

- - password

-```

-

-### command

-

-```

-command: bundle exec thin -p 3000

-```

-

-替换Dockerfile中默认的CMD。

-

-### deploy

-

-Compose file v3才支持的功能,也是重点功能。

-

-```Yaml

-deploy:

- replicas: 6

- update_config:

- parallelism: 2

- delay: 10s

- restart_policy:

- condition: on-failure

-```

-

-**deploy**有如下几个子选项

-

-- **Mode**:可以为global或replicated,global能够规定服务在每台主机一个容器。replicated可以自定义service的容器个数。

-- **replicas**:使用``replicas``定义service的容器个数,只有在replicated mode下可用。

-- **placement**:用来限定容器部署在哪些主机上。使用``constraints``约束。

-- **Update_config**:定义service升级策略。

- - Parrallism:一次性同时升级的容器数

- - delay:两次升级之间的间隔

- - failure_action:升级失败后可以pause或continue,默认pause

- - monitor:升级后监控failure的间隔,格式(ns|us|ms|s|m|h),默认0s

- - max_failure_ratio:可容忍的失败率

-- **resources**:service的资源数量限定,包括如下几个值`cpu_shares`, `cpu_quota`,`cpuset`, `mem_limit`, `memswap_limit`, `mem_swappiness`。

- - **restart_policy**:``condition``:one、on-failure、any默认any,``delay``,``max_attempts``,``window``

- - **labels**:为service打标签

-

-

-### docker-compose.yml还支持的配置有

-

-- **devices**:devices mapping

-- **depends_on**:定义service依赖关系,影响启动顺序

-- **dns**:自定义DNS,可以是单条也可以为列表

-- **dns_search**:自定义DNS搜索域

-- **tmpfs**:挂载临时文件系统

-- **entrypoint**:覆盖dockerfile中国年的entrypoint

-- **env_file**:定义env的文件,可以为一个列表

-- **environment**:定义环境变量

-- **expose**

-- **external_links**:链接外部docker-compose.yml外部启动的容器

-- **extra_hosts**:添加外部hosts

-- **group_add**

-- **healthcheck**:检查service的健康状况

-- **Image**

-- **Isolation**:linux只支持default,windows还有其他选项

-- **labels**:给容器打标签,建议用DNS的反向字符串定义

-- **links**:链接其他service

-- **logging**:日志配置,可以配置日志的driver、地址等

-- **network_mode**

-- **networks**:可以连接的定义网络名称,分配IP地址,设置网络别名,``LINK_LOCAL_IPS``选项可以连接外部非docker管理的IP。还可以定义的选项有driver、driver_opts、enable_ipv6、ipam、internal、labels、external等

-- **pid**

-- **ports**:对外暴露的端口

-- **secret**:定义service可以访问的secret文件

-- **security_opts**

-- **stop_grace_period**

-- **stop_signal**

-- **sysctls**

-- **ulimits**

-- **userns_mode**

-- **volumes**:可以定义driver、driver_opts、external、labels等

-

-

-networks和volumes的子选项比较多,定义的时候请参照详细文档。

\ No newline at end of file

diff --git a/docker/docs/docker_env.md b/docker/docs/docker_env.md

deleted file mode 100644

index d4a207777..000000000

--- a/docker/docs/docker_env.md

+++ /dev/null

@@ -1,42 +0,0 @@

-# Docker环境配置

-

-**软件环境**

-

-- Docker1.13.1

-- docker-compose 1.11.1

-- centos 7.3.1611

-

-如果在Mac上安装后docker后需要从docker hub上下载镜像,建议设置国内的mirror,能够显著增加下载成功率,提高下载速度,~~推荐[daocloud的mirror](https://www.daocloud.io/mirror#accelerator-doc)~~推荐使用阿里云的mirror,速度比较快一些。

-

-设置方式很简单,只需要在Mac版本的docker - preferences - daemon - registry mirrors中增加一条阿里云的加速器地址即可。

-

-**硬件环境**

-

-| Hostname | IP | Role |

-| --------------------------------------- | ------------ | ------------------- |

-| sz-pg-oam-docker-test-001.tendcloud.com | 172.20.0.113 | Swarm leader/worker |

-| sz-pg-oam-docker-test-002.tendcloud.com | 172.20.0.114 | Worker |

-| sz-pg-oam-docker-test-003.tendcloud.com | 172.20.0.115 | Worker |

-

-**网络环境**

-

-- Swarm内置的overlay网络,不需要单独安装

-- *mynet自定义网络(TBD),目前没有在docker中使用*

-

-**Docker配置文件修改**

-

-修改docke让配置文件``/usr/lib/systemd/system/docker.service``

-

-```

-ExecStart=/usr/bin/dockerd --insecure-registry=sz-pg-oam-docker-hub-001.tendcloud.com -H tcp://0.0.0.0:2375 -H unix:///var/run/docker.sock

-```

-

-修改好后

-

-```

-systemctl daemon-reload

-systemctl restart docker

-```

-

-

-

diff --git a/docker/docs/docker_storage_plugin.md b/docker/docs/docker_storage_plugin.md

deleted file mode 100644

index 58ab575a3..000000000

--- a/docker/docs/docker_storage_plugin.md

+++ /dev/null

@@ -1,27 +0,0 @@

-# Docker存储插件

-

-容器存储的几种形态:

-

-[http://mp.weixin.qq.com/s/cTFkQooDVK8IO7cSJUYiVg](http://mp.weixin.qq.com/s/cTFkQooDVK8IO7cSJUYiVg)

-

-[https://clusterhq.com/2015/12/09/difference-docker-volumes-flocker-volumes/](https://clusterhq.com/2015/12/09/difference-docker-volumes-flocker-volumes/)

-

-目前流行的Docker有状态服务的持久化存储方案有以下几种

-

-- Infinit:[https://infinit.sh](https://infinit.sh/) 2016年11月被Docker公司收购

-- ~~Torus:CoreOS开源的容器分布式存储 [https://github.com/coreos/torus](https://github.com/coreos/torus)~~ **已停止开发**

-- Flocker:Container data volume manager for your Dockerized application [https://clusterhq.com](https://clusterhq.com/)

-- Convoy:Rancher开源的Docker volume plugin [https://github.com/rancher/convoy](https://github.com/rancher/convoy)

-- REX-Ray:运营商无关的存储引擎。[https://github.com/codedellemc/rexray](https://github.com/codedellemc/rexray),只能使用商业存储

-

-对比

-

-| 名称 | 主导公司 | 开源时间 | 是否自建存储 | 是否开源 | 开发语言 | 存储格式 | 环境依赖 |

-| --------- | ---------- | ------------ | ------ | ----- | ------ | ---------------------------------------- | -------- |

-| Infinit | Docker | 2017年开源 | 是 | 否 | C++ | local、Amazon S3、Google Cloud Storage | fuse |

-| ~~Torus~~ | ~~CoreOS~~ | ~~2015年11月~~ | ~~是~~ | ~~是~~ | ~~Go~~ | ~~local~~ | ~~etcd~~ |

-| Convoy | Rancher | 2015年5月 | 否 | 是 | Go | NFS、Amazon EBS、VFS 、Device Mapper | |

-| Flocker | ClusterHQ | 2015年8月 | 否 | 是 | Python | Amazon EBS、OpenStack Cinder、GCE PD、VMware vSphere、Ceph... | |

-| REX-Ray | EMC | 2015年12月 | 否 | 是 | Go | GCE、Amazon EC2、OpenStack | |

-

-Infinit和Torus是一个类型的,都是通过分布式存储来实现容器中数据的持久化,而Convoy和Flocker是通过docker volume plugin实现volume的备份与迁移,需要很多手动操作。

\ No newline at end of file

diff --git a/docker/docs/flocker.md b/docker/docs/flocker.md

deleted file mode 100644

index ffe738f81..000000000

--- a/docker/docs/flocker.md

+++ /dev/null

@@ -1,162 +0,0 @@

-# Flocker

-

-docker Flocker

-

-https://github.com/ClusterHQ/flocker/

-

-文档:

-

-https://docs.clusterhq.com/en/latest/docker-integration/

-

-docker swarm 部署 Flocker

-

-https://docs.clusterhq.com/en/latest/docker-integration/manual-install.html

-

-CentOS 7 安装 flocker-cli

-

-需要 python 2.7

-

-yum install gcc libffi-devel git

-

-[root@swarm-master ~]# git clone https://github.com/ClusterHQ/flocker

-

-[root@swarm-master ~]# cd flocker

-

-[root@swarm-master flocker]# pip install -r requirements/all.txt

-

-[root@swarm-master flocker]# python setup.py install

-

-[root@swarm-master flocker]# flocker-ca --version

-1.14.0+1.g40433b3

-

-

-

-CentOS 7 安装 flocker node 在每个节点中

-

-[root@swarm-node-1 ~]# yum list installed clusterhq-release || yum install -y https://clusterhq-archive.s3.amazonaws.com/centos/clusterhq-release$(rpm -E %dist).noarch.rpm

-[root@swarm-node-1 ~]# yum install -y clusterhq-flocker-node

-[root@swarm-node-1 ~]# yum install -y clusterhq-flocker-docker-plugin

-

-在 管理节点 与 node 节点 创建 flocker 配置目录

-

-mkdir /etc/flocker

-

-[root@swarm-master ~]# cd /etc/flocker

-

-一、生成 flocker 管理服务器 证书

-[root@swarm-master flocker]# flocker-ca initialize cnflocker

-Created cluster.key and cluster.crt. Please keep cluster.key secret, as anyone who can access it will be able to control your cluster.

-

-二、生成 flocker 控制节点 证书

-

-官方 建议使用 hostname, 而不使用IP, 我这里暂时使用 IP

-

-[root@swarm-master flocker]# flocker-ca create-control-certificate 172.16.1.25

-

-

-

-拷贝 control-172.16.1.25.crt control-172.16.1.25.key cluster.crt 三个文件到 控制节点 中

-

-注意:cluster.key 文件为 key 文件,只保存在本机,或者管理服务器 (我这里 管理服务器 与 控制节点 为同一台服务器)

-

-[root@swarm-master flocker]# scp control-172.16.1.25.crt 172.16.1.25:/etc/flocker

-

-[root@swarm-master flocker]# scp control-172.16.1.25.key 172.16.1.25:/etc/flocker

-

-[root@swarm-master flocker]# scp cluster.crt 172.16.1.25:/etc/flocker

-

-重命名 刚复制过来的 control-172.16.1.25.key control-172.16.1.25.crt

-

-[root@swarm-master flocker]# mv control-172.16.1.25.crt control-service.crt

-[root@swarm-master flocker]# mv control-172.16.1.25.key control-service.key

-

-设置 权限

-

-[root@swarm-master flocker]# chmod 0700 /etc/flocker

-[root@swarm-master flocker]# chmod 0600 /etc/flocker/control-service.key

-

-

-

-三、生成 flocker node节点 证书 , 每个节点都必须生成一个不一样的证书

-

-[root@swarm-master flocker]# flocker-ca create-node-certificate

-Created 6cc5713a-4976-4545-bf61-3686f182ae50.crt. Copy it over to /etc/flocker/node.crt on your node machine and make sure to chmod 0600 it.

-

-复制 6cc5713a-4976-4545-bf61-3686f182ae50.crt 6cc5713a-4976-4545-bf61-3686f182ae50.key cluster.crt 到 flocker node 节点 /etc/flocker 目录中

-

-[root@swarm-master flocker]# scp 6cc5713a-4976-4545-bf61-3686f182ae50.crt 172.16.1.28:/etc/flocker

-[root@swarm-master flocker]# scp 6cc5713a-4976-4545-bf61-3686f182ae50.key 172.16.1.28:/etc/flocker

-[root@swarm-master flocker]# scp cluster.crt 172.16.1.28:/etc/flocker

-

-登陆 node 节点 重命名 crt 与 key 文件 为 node.crt node.key

-

-[root@swarm-node-1 flocker]# mv 6cc5713a-4976-4545-bf61-3686f182ae50.crt node.crt

-[root@swarm-node-1 flocker]# mv 6cc5713a-4976-4545-bf61-3686f182ae50.key node.key

-

-[root@swarm-node-1 flocker]# chmod 0700 /etc/flocker

-[root@swarm-node-1 flocker]# chmod 0600 /etc/flocker/node.key

-

-四、生成 Flocker Plugin for Docker 客户端 API

-

-[root@swarm-master flocker]# flocker-ca create-api-certificate plugin

-Created plugin.crt. You can now give it to your API enduser so they can access the control service API.

-

-复制 plugin.crt plugin.key 到 flocker node 节点 /etc/flocker 目录中。

-[root@swarm-master flocker]# scp plugin.crt 172.16.1.28:/etc/flocker/

-[root@swarm-master flocker]# scp plugin.key 172.16.1.28:/etc/flocker/

-

-

-

-五、 控制节点 运行 flocker Service

-

-[root@swarm-master flocker]# systemctl enable flocker-control

-[root@swarm-master flocker]# systemctl start flocker-control

-

-六、 配置 node 节点 以及 后端存储

-

-在每个节点 新增 配置文件

-

-[root@swarm-node-1 flocker]# vi /etc/flocker/agent.yml

-

-\---------------------------------------------------------------------------------------------------

-

-"version": 1

-"control-service":

-"hostname": "172.16.1.25"

-"port": 4524

-

-\# The dataset key below selects and configures a dataset backend (see below: aws/openstack/etc).

-\# # All nodes will be configured to use only one backend

-

-dataset:

-backend: "aws"

-region: ""

-zone: ""

-access_key_id: ""

-secret_access_key: ""

-\---------------------------------------------------------------------------------------------------

-

-

-

-dataset 为后端存储的设置选项。

-

-后端存储支持列表: https://docs.clusterhq.com/en/latest/flocker-features/storage-backends.html#supported-backends

-

-

-

-七、 node 节点 运行 flocker-agent 与 flocker-docker-plugin

-

-[root@swarm-node-1 flocker]# systemctl enable flocker-dataset-agent

-[root@swarm-node-1 flocker]# systemctl start flocker-dataset-agent

-[root@swarm-node-1 flocker]# systemctl enable flocker-container-agent

-[root@swarm-node-1 flocker]# systemctl start flocker-container-agent

-

-[root@swarm-node-1 flocker]# systemctl enable flocker-docker-plugin

-[root@swarm-node-1 flocker]# systemctl restart flocker-docker-plugin

-

-八、 docker volume-driver 测试

-

-[root@swarm-master]# docker run -v apples:/data --volume-driver flocker busybox sh -c "echo hello > /data/file.txt"

-

-[root@swarm-master]# docker run -v apples:/data --volume-driver flocker busybox sh -c "cat /data/file.txt"

-

diff --git a/docker/docs/infinit.md b/docker/docs/infinit.md

deleted file mode 100644

index 78f64d30c..000000000

--- a/docker/docs/infinit.md

+++ /dev/null

@@ -1,114 +0,0 @@

-# Infinit

-

-安装文档[https://infinit.sh/get-started/linux#linux-tarball-install](https://infinit.sh/get-started/linux#linux-tarball-install)

-

-下载压缩包[https://storage.googleapis.com/sh_infinit_releases/linux64/Infinit-x86_64-linux_debian_oldstable-gcc4-0.7.2.tbz](https://storage.googleapis.com/sh_infinit_releases/linux64/Infinit-x86_64-linux_debian_oldstable-gcc4-0.7.2.tbz)

-

-**Infinit还有发布1.0版本,跟他们团队沟通过,好不容易实现了分布式存储,infinit的概念非常好,被docker看中也是有原因的,但是目前使用很不便,严重依赖手敲命令行,user、volume、network的security实在是麻烦,昨天使用的时候在最后一步挂载到docker volume的时候居然还需要联网。给他们提了两个bug,团队去过圣诞假期了,明年1月底才可能发新版本,被docker收购后,发展前景不明.**

-

-**2017-01-04**

-

-**infinit daemon启动的时候--as指定用户后,在挂载docker volume plugin的时候还是需要到Hub上查找用户,这个问题会在下个版本解决。**

-

-依赖fuse,使用yum install -y fuse*安装

-

-解压到/usr/local目录下,

-

-ln -s Infinit-x86_64-linux_debian_oldstable-gcc4-0.7.2 /usr/local/infinit

-

-**172.20.0.113****:root****@****sz-pg-oam-docker-test-001**:/usr/local/infinit]# INFINIT_DATA_HOME=$PWD/share/infinit/filesystem/test/home/ INFINIT_STATE_HOME=/tmp/infinit-demo/ bin/infinit-volume --mount --as demo --name infinit/demo --mountpoint ~/mnt-demo --publish --cache

-

-bin/infinit-volume: /lib64/libc.so.6: version `**GLIBC_2.18**' not found (required by /usr/local/Infinit-x86_64-linux_debian_oldstable-gcc4-0.7.2/bin/../lib/libstdc++.so.6)

-

-CentOS7.2.1511的使用源码安装的时候glibc版本太低,无法使用。

-

-官网上使用的是ubuntu安装,ubuntu的glibc版本比较新,而CentOS比较旧,启动报错。

-

-在Slack上跟人要了个rpm,下载地址:[https://infinit.io/_/37aDi9h#](https://infinit.io/_/37aDi9h#)

-

-Docker镜像地址:[https://hub.docker.com/r/mefyl/infinit](https://hub.docker.com/r/mefyl/infinit)

-

-使用RPM包安装即可,默认安装目录在/opt/infinit下

-

-quick-start文档:[https://infinit.sh/get-started](https://infinit.sh/get-started)

-

-详细参考文档:[https://infinit.sh/documentation/reference](https://infinit.sh/documentation/reference)

-

-slack地址:infinit-sh.slack.com

-

-设置环境变量

-

-**export** LC_ALL=en_US.UTF-8

-

-**创建用户**

-

-虽然可以安装不过需要注册用户才能使用,infinit使用的时候会连接到Internet。

-

-设置环境变量INFINIT_CRASH_REPORTER=0就不会再连接Hub。

-

-create的用户信息会保存在

-

-/opt/infinit/.local

-

-infinit-user --create --name "alice"

-

-**创建网络**

-

-infinit-network --create --as alice --storage local --name my-network

-

-查看网络

-

-infinit-network --list --as alice

-

-启动网络

-

-**infinit**-network --run --daemon --as alice --name my-network --port 11928

-

-必须制定用户,否则会查看root用户的网络,-~~as alice必须放在~~-list动作后面

-

-不要加上--push,否则会push到hub上,又需要连接到网络

-

-创建volume

-

-infinit-volume --create --as alice --network my-network --name my-volume

-

-挂载volume

-

-infinit-volume --mount --as alice --name my-volume --mountpoint ~/mnt-alice-volume --allow-root-creation --async --cache --port 11928

-

-我随意指定的一个端口

-

-不要使用--publish,否则会向Hub注册endpoint

-

-导出user、network、volume

-

-infinit-user --export --as alice --full>alice

-

-infinit-network --export --name my-network --as alice --output my-network

-

-infinit-volume --export --name my-volume --as alice --output my-volume

-

-Device B

-

-导入user、network、volume

-

-infinit-user --import -i alice

-

-infinit-network --import -i my-network

-

-infinit-volume --import -i my-volume

-

-link网络

-

-infinit-network --link --name my-network --as alice

-

-查看网络信息

-

-infinit-journal --stat --network alice/my-network --as alice

-

-挂载volume

-

-infinit-volume --mount --as alice --name my-volume --mountpoint ~/mnt-alice-volume --allow-root-creation --async --cache --peer server_ip:11928

-

-目前状况:B节点无法连接到A

-

diff --git a/docker/docs/io_resource_limit.md b/docker/docs/io_resource_limit.md

deleted file mode 100644

index 3a2421e34..000000000

--- a/docker/docs/io_resource_limit.md

+++ /dev/null

@@ -1,169 +0,0 @@

-# Docker IO资源限制

-

-## 一、压测工具

-

-通过 Linux `dd` 命令测试

-

-## 二、IO 测试

-

-- [Runtime constraints on resources](https://docs.docker.com/engine/reference/run/#runtime-constraints-on-resources)

-- 关于 IO 的限制

- - `--blkio-weight=0`Block IO weight (relative weight) accepts a weight value between 10 and 1000.

- - `--blkio-weight-device=""`Block IO weight (relative device weight, format: `DEVICE_NAME:WEIGHT`)针对特定设备的权重比

- - `--device-read-bps=""`Limit read rate from a device (format: `:[]`). Number is a positive integer. Unit can be one of `kb`, `mb`, or `gb`.按每秒读取块设备的数据量设定上限

- - `--device-write-bps=""`Limit write rate from a device (format: `:[]`). Number is a positive integer. Unit can be one of `kb`, `mb`, or `gb`.按每秒写入块设备的数据量设定上限

- - `--device-read-iops=""`Limit read rate (IO per second) from a device (format: `:`). Number is a positive integer.按照每秒读操作次数设定上限

- - `--device-write-iops=""`Limit write rate (IO per second) from a device (format: `:`). Number is a positive integer.按照每秒写操作次数设定上限

-

-```

-➜ ~ docker help run | grep -E 'bps|IO'

-Usage: docker run [OPTIONS] IMAGE [COMMAND] [ARG...]

- --blkio-weight Block IO (relative weight), between 10 and 1000

- --blkio-weight-device=[] Block IO weight (relative device weight)

- --device-read-bps=[] Limit read rate (bytes per second) from a device

- --device-read-iops=[] Limit read rate (IO per second) from a device

- --device-write-bps=[] Limit write rate (bytes per second) to a device

- --device-write-iops=[] Limit write rate (IO per second) to a device

-➜ ~

-

-```

-

-### 2.1 `--blkio-weight`、`--blkio-weight-device`

-

-- `--blkio-weight`

-

-默认,所有的容器对于 IO 操作「block IO bandwidth – blkio」都拥有相同优先级。可以通过 `--blkio-weight` 修改容器 blkio 权重。`--blkio-weight` 权重值在 10 ~ 1000 之间。

-

-> Note: The blkio weight setting is only available for direct IO. Buffered IO is not currently supported.

-

-使用 blkio weight 还需要注意 IO 的调度必须为 CFQ:

-

-```

-➜ ~ cat /sys/block/sda/queue/scheduler

-noop [deadline] cfq

-➜ ~ sudo sh -c "echo cfq > /sys/block/sda/queue/scheduler"

-➜ ~ cat /sys/block/sda/queue/scheduler

-noop deadline [cfq]

-

-```

-

-按照 Docker 官方文档的介绍测试:

-

-```

-➜ ~ docker run -it --rm --blkio-weight 100 ubuntu-stress:latest /bin/bash

-root@0b6770ee80e0:/#

-➜ ~ docker run -it --rm --blkio-weight 1000 ubuntu-stress:latest /bin/bash

-root@6778b6b39686:/#

-

-```

-

-在运行的容器上同时执行如下命令,统计测试时间:

-

-```

-root@0b6770ee80e0:/# time dd if=/dev/zero of=test.out bs=1M count=1024 oflag=direct

-1024+0 records in

-1024+0 records out

-1073741824 bytes (1.1 GB) copied, 122.442 s, 8.8 MB/s

-

-real 2m2.524s

-user 0m0.008s

-sys 0m0.492s

-root@6778b6b39686:/# time dd if=/dev/zero of=test.out bs=1M count=1024 oflag=direct

-1024+0 records in

-1024+0 records out

-1073741824 bytes (1.1 GB) copied, 122.493 s, 8.8 MB/s

-

-real 2m2.574s

-user 0m0.020s

-sys 0m0.480s

-root@6778b6b39686:/#

-

-```

-

-测试下来,效果不是很理想,没有获得官档的效果,类似的问题可以在相关的 issue 上找到,如 [–blkio-weight doesn’t take effect in docker Docker version 1.8.1 #16173](https://github.com/docker/docker/issues/16173)

-

-官方的测试说明是:

-

-> You’ll find that the proportion of time is the same as the proportion of blkio weights of the two containers.

-

-- `--blkio-weight-device="DEVICE_NAME:WEIGHT"`

-

-`--blkio-weight-device` 可以指定某个设备的权重大小,如果同时指定 `--blkio-weight` 则以 `--blkio-weight` 为全局默认配置,针对指定设备以 `--blkio-weight-device` 指定设备值为主。

-

-```

-➜ ~ docker run -it --rm --blkio-weight-device "/dev/sda:100" ubuntu-stress:latest /bin/bash

-

-```

-

-### 2.2 `--device-read-bps`、`--device-write-bps`

-

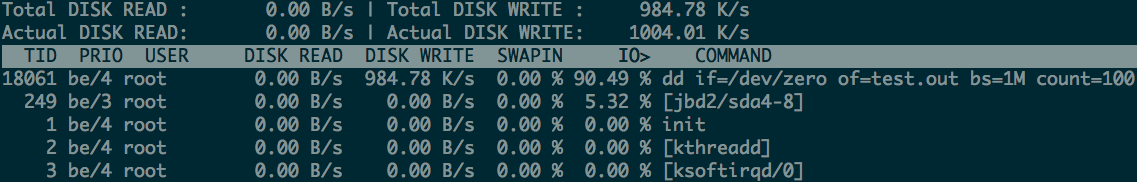

-限制容器的写入速度是 1mb「`:[unit]`,单位可以是 kb、mb、gb 正整数」:

-

-```

-➜ ~ docker run -it --rm --device-write-bps /dev/sda:1mb ubuntu-stress:latest /bin/bash

-root@ffa51b81987c:/# dd if=/dev/zero of=test.out bs=1M count=100 oflag=direct

-100+0 records in

-100+0 records out

-104857600 bytes (105 MB) copied, 100.064 s, 1.0 MB/s # 可以得知写入的平均速度是 1.0 MB/s

-

-```

-

-通过 iotop 获取测试过程中的 bps 也是 1.0 MB 为上限:

-

-

-

-读 bps 限制使用方式同写 bps 限制:

-

-```

-➜ ~ docker run -it --rm --device-read-bps /dev/sda:1mb ubuntu-stress:latest /bin/bash

-

-```

-

-### 2.3 `--device-read-iops`、`--device-write-iops`

-

-限制容器 write iops 为 5「`:`,必须为正整数」:

-

-```

-➜ ~ docker run -it --rm --device-write-iops /dev/sda:5 ubuntu-stress:latest /bin/bash

-root@c2a2fa232594:/# dd if=/dev/zero of=test.out bs=1M count=100 oflag=direct

-100+0 records in

-100+0 records out

-104857600 bytes (105 MB) copied, 42.6987 s, 2.5 MB/s

-

-```

-

-通过 `iostat` 监控 tps「此处即为 iops」 基本上持续在 10 左右「会有些偏差」:

-

-```

-➜ ~ iostat 1

-... ...

-avg-cpu: %user %nice %system %iowait %steal %idle

- 1.13 0.00 0.13 23.46 0.00 75.28

-

-Device: tps kB_read/s kB_wrtn/s kB_read kB_wrtn

-sda 10.00 0.00 2610.00 0 5220

-... ...

-

-```

-

-读 iops 限制使用方式同写 iops 限制:

-

-```

-➜ ~ docker run -it --rm --device-read-iops /dev/sda:5 ubuntu-stress:latest /bin/bash

-

-```

-

-**注:** 在容器中通过 `dd` 测试读速度并没有看到很好的效果,经查没有找到磁盘读操作的好工具,所以文中没有介绍读测试。

-

-## 三、源码解析

-

-- [github.com/opencontainers/runc/libcontainer/cgroups/fs](https://github.com/opencontainers/runc/tree/master/libcontainer/cgroups/fs)blkio.go

-

-libcontainer 主要操作是对 cgroup 下相关文件根据选项写操作,具体更进一步的资源限制操作可以看 cgroup 的实现方式。

-

-## 四、拓展

-

-- [Docker背后的内核知识——cgroups资源限制](http://www.infoq.com/cn/articles/docker-kernel-knowledge-cgroups-resource-isolation)

-- [cgroup 内存、IO、CPU、网络资源管理](http://pan.baidu.com/share/home?uk=1429463486&view=share#category/type=0)

-

-From:http://blog.opskumu.com/docker-io-limit.html

\ No newline at end of file

diff --git a/docker/docs/jd_transform_to_kubernetes.md b/docker/docs/jd_transform_to_kubernetes.md

deleted file mode 100644

index 91cdf48b1..000000000

--- a/docker/docs/jd_transform_to_kubernetes.md

+++ /dev/null

@@ -1,115 +0,0 @@

-# 京东从OpenStack切换到Kubernetes的经验之谈

-

-***京东从2016年底启动从OpenStack切换到Kubernetes的工作,截止目前(2017年2月)已迁移完成20%,预计Q2可以完成全部切换工作。Kubernetes方案与OpenStack方案相比,架构更为简洁。在这个过程中,有这些经验可供业界借鉴。***

-

-## 背景介绍

-

-2016年底,京东新一代容器引擎平台JDOS2.0上线,京东从OpenStack切换到Kubernetes。到目前为止,JDOS2.0集群2w+Pod稳定运行,业务按IDC分布分批迁移到新平台,目前已迁移20%,计划Q2全部切换到Kubernetes上,业务研发人员逐渐适应从基于自动部署上线切换到以镜像为中心的上线方式。JDOS2.0统一提供京东业务,大数据实时离线,机器学习(GPU)计算集群。从OpenStack切换到Kubernetes,这中间又有哪些经验值得借鉴呢?

-

-本文将为读者介绍京东商城研发基础平台部如何从0到JDOS1.0再到JDOS2.0的发展历程和经验总结,主要包括:

-

-- 如何找准痛点作为基础平台系统业务切入点;

-- 如何一边实践一边保持技术视野;

-- 如何运维大规模容器平台;

-- 如何把容器技术与软件定义数据中心结合。

-

-## 集群建设历史

-

-### 物理机时代(2004-2014)

-

-在2014年之前,公司的应用直接部署在物理机上。在物理机时代,应用上线从申请资源到最终分配物理机时间平均为一周。应用混合部署在一起,没有隔离的应用混部难免互相影响。为减少负面影响,在混部的比例平均每台物理机低于9个不同应用的Tomcat实例,因此造成了物理机资源浪费严重,而且调度极不灵活。物理机失效导致的应用实例迁移时间以小时计,自动化的弹性伸缩也难于实现。为提升应用部署效率,公司开发了诸如编译打包、自动部署、日志收集、资源监控等多个配套工具系统。

-

-### 容器化时代(2014-2016)

-

-2014年第三季度,公司首席架构师刘海锋带领基础平台团队对于集群建设进行重新设计规划,Docker容器是主要的选型方案。当时Docker虽然已经逐渐兴起,但是功能略显单薄,而且缺乏生产环境,特别是大规模生产环境的实践。团队对于Docker进行了反复测试,特别是进行了大规模长时间的压力和稳定性测试。根据测试结果,对于Docker进行了定制开发,修复了Device Mapper导致crash、Linux内核等问题,并增加了外挂盘限速、容量管理、镜像构建层级合并等功能。

-

-对于容器的集群管理,团队选择了**OpenStack+nova-docker**的架构,**用管理虚拟机的方式管理容器**,并定义为京东第一代容器引擎平台JDOS1.0(JD DataCenter OS)。JDOS1.0的主要工作是实现了基础设施容器化,应用上线统一使用容器代替原来的物理机。

-

-在应用的运维方面,兼用了之前的配套工具系统。研发上线申请计算资源由之前的一周缩短到分钟级,不管是1台容器还是1千台容器,在经过计算资源池化后可实现秒级供应。同时,应用容器之间的资源使用也得到了有效的隔离,平均部署应用密度提升3倍,物理机使用率提升3倍,带来极大的经济收益。

-

-我们采用多IDC部署方式,使用统一的全局API开放对接到上线系统,支撑业务跨IDC部署。单个OpenStack集群最大是1万台物理计算节点,最小是4K台计算节点,第一代容器引擎平台成功地支撑了2015和2016年的618和双十一的促销活动。至2016年11月,已经有15W+的容器在稳定运行。

-

-在完成的第一代容器引擎落地实践中,团队推动了业务从物理机上迁移到容器中来。在JDOS1.0中,我们使用的IaaS的方式,即使用管理虚拟机的方式来管理容器,因此应用的部署仍然严重依赖于物理机时代的编译打包、自动部署等工具系统。但是JDOS1.0的实践是非常有意义的,其意义在于完成了业务应用的容器化,将容器的网络、存储都逐渐磨合成熟,而这些都为我们后面基于1.0的经验,开发一个全新的应用容器引擎打下了坚实的基础。

-

-## 新一代应用容器引擎(JDOS 2.0)

-

-### 1.0的痛点

-

-JDOS1.0解决了应用容器化的问题,但是依然存在很多不足。

-

-首先是编译打包、自动部署等工具脱胎于物理机时代,与容器的开箱即用理念格格不入,容器启动之后仍然需要配套工具系统为其分发配置、部署应用等等,应用启动的速度受到了制约。

-

-其次,线上线下环境仍然存在不一致的情况,应用运行的操作环境,依赖的软件栈在线下自测时仍然需要进行单独搭建。线上线下环境不一致也造成了一些线上问题难于在线下复现,更无法达到镜像的“一次构建,随处运行”的理想状态。

-

-再次,容器的体量太重,应用需要依赖工具系统进行部署,导致业务的迁移仍然需要工具系统人工运维去实现,难以在通用的平台层实现灵活的扩容缩容与高可用。

-

-另外,容器的调度方式较为单一,只能简单根据物理机剩余资源是否满足要求来进行筛选调度,在提升应用的性能和平台的使用率方面存在天花板,无法做更进一步提升。

-

-### 平台架构

-

-鉴于以上不足,在当JDOS1.0从一千、两千的容器规模,逐渐增长到六万、十万的规模时,我们就已经启动了新一代容器引擎平台(JDOS 2.0)研发。JDOS 2.0的目标不仅仅是一个基础设施的管理平台,更是一个直面应用的容器引擎。JDOS 2.0在原1.0的基础上,围绕Kubernetes,整合了JDOS 1.0的存储、网络,打通了从源码到镜像,再到上线部署的CI/CD全流程,提供从日志、监控、排障、终端、编排等一站式的功能。JDOS 2.0的平台架构如下图所示。

-

-

-

-

-

-在JDOS 2.0中,我们定义了系统与应用两个级别。一个系统包含若干个应用,一个应用包含若干个提供相同服务的容器实例。一般来说,一个大的部门可以申请一个或者多个系统,系统级别直接对应于Kubernetes中的namespace,同一个系统下的所有容器实例会在同一个Kubernetes的namespace中。应用不仅仅提供了容器实例数量的管理,还包括版本管理、域名解析、负载均衡、配置文件等服务。

-

-不仅仅是公司各个业务的应用,大部分的JDOS 2.0组件(Gitlab/Jenkins/Harbor/Logstash/Elastic Search/Prometheus)也实现了容器化,在Kubernetes平台上进行部署。

-

-### 开发者一站式解决方案

-

-JDOS 2.0实现了以镜像为核心的持续集成和持续部署。

-

-

-

-1. 开发者提交代码到源码管理库

-2. 触发Jenkins Master生成构建任务

-3. Jenkins Master使用Kubernetes生成Jenkins Slave Pod

-4. Jenkins Slave拉取源码进行编译打包

-5. 将打包好的文件和Dockerfile发送到构建节点

-6. 在构建节点中构建生成镜像