mirror of https://github.com/dunwu/db-tutorial.git

📚 更新 ES 文档

parent

fa44ac5ab0

commit

0e9ded6812

12

README.md

12

README.md

|

|

@ -71,12 +71,20 @@

|

|||

|

||||

#### [Elasticsearch](docs/nosql/elasticsearch) 📚

|

||||

|

||||

> Elasticsearch 是一个基于 Lucene 的搜索和数据分析工具,它提供了一个分布式服务。Elasticsearch 是遵从 Apache 开源条款的一款开源产品,是当前主流的企业级搜索引擎。

|

||||

|

||||

- [Elasticsearch 面试总结](docs/nosql/elasticsearch/elasticsearch-interview.md) 💯

|

||||

- [Elasticsearch 简介](docs/nosql/elasticsearch/Elasticsearch简介.md)

|

||||

- [Elasticsearch 快速入门](docs/nosql/elasticsearch/Elasticsearch快速入门.md)

|

||||

- [Elasticsearch 基本概念](docs/nosql/elasticsearch/Elasticsearch基本概念.md)

|

||||

- [Elasticsearch 简介](docs/nosql/elasticsearch/Elasticsearch简介.md)

|

||||

- [Elasticsearch Rest API](docs/nosql/elasticsearch/ElasticsearchRestApi.md)

|

||||

- [Elasticsearch 索引管理](docs/nosql/elasticsearch/Elasticsearch索引管理.md)

|

||||

- [Elasticsearch 查询](docs/nosql/elasticsearch/Elasticsearch查询.md)

|

||||

- [Elasticsearch 高亮](docs/nosql/elasticsearch/Elasticsearch高亮.md)

|

||||

- [Elasticsearch 排序](docs/nosql/elasticsearch/Elasticsearch排序.md)

|

||||

- [Elasticsearch 聚合](docs/nosql/elasticsearch/Elasticsearch聚合.md)

|

||||

- [Elasticsearch 分析器](docs/nosql/elasticsearch/Elasticsearch分析器.md)

|

||||

- [Elasticsearch 运维](docs/nosql/elasticsearch/Elasticsearch运维.md)

|

||||

- [Elasticsearch 性能优化](docs/nosql/elasticsearch/Elasticsearch性能优化.md)

|

||||

|

||||

#### HBase

|

||||

|

||||

|

|

|

|||

Binary file not shown.

|

|

@ -70,12 +70,20 @@ footer: CC-BY-SA-4.0 Licensed | Copyright © 2018-Now Dunwu

|

|||

|

||||

#### [Elasticsearch](nosql/elasticsearch) 📚

|

||||

|

||||

> Elasticsearch 是一个基于 Lucene 的搜索和数据分析工具,它提供了一个分布式服务。Elasticsearch 是遵从 Apache 开源条款的一款开源产品,是当前主流的企业级搜索引擎。

|

||||

|

||||

- [Elasticsearch 面试总结](nosql/elasticsearch/elasticsearch-interview.md) 💯

|

||||

- [Elasticsearch 简介](nosql/elasticsearch/Elasticsearch简介.md)

|

||||

- [Elasticsearch 快速入门](nosql/elasticsearch/Elasticsearch快速入门.md)

|

||||

- [Elasticsearch 基本概念](nosql/elasticsearch/Elasticsearch基本概念.md)

|

||||

- [Elasticsearch 简介](nosql/elasticsearch/Elasticsearch简介.md)

|

||||

- [Elasticsearch Rest API](nosql/elasticsearch/ElasticsearchRestApi.md)

|

||||

- [Elasticsearch 索引管理](nosql/elasticsearch/Elasticsearch索引管理.md)

|

||||

- [Elasticsearch 查询](nosql/elasticsearch/Elasticsearch查询.md)

|

||||

- [Elasticsearch 高亮](nosql/elasticsearch/Elasticsearch高亮.md)

|

||||

- [Elasticsearch 排序](nosql/elasticsearch/Elasticsearch排序.md)

|

||||

- [Elasticsearch 聚合](nosql/elasticsearch/Elasticsearch聚合.md)

|

||||

- [Elasticsearch 分析器](nosql/elasticsearch/Elasticsearch分析器.md)

|

||||

- [Elasticsearch 运维](nosql/elasticsearch/Elasticsearch运维.md)

|

||||

- [Elasticsearch 性能优化](nosql/elasticsearch/Elasticsearch性能优化.md)

|

||||

|

||||

#### HBase

|

||||

|

||||

|

|

@ -86,9 +94,13 @@ footer: CC-BY-SA-4.0 Licensed | Copyright © 2018-Now Dunwu

|

|||

- [HBase 应用](https://github.com/dunwu/bigdata-tutorial/blob/master/docs/hbase/HBase应用.md)

|

||||

- [HBase 运维](https://github.com/dunwu/bigdata-tutorial/blob/master/docs/hbase/HBase运维.md)

|

||||

|

||||

#### MongoDB

|

||||

#### [MongoDB](nosql/mongodb) 📚

|

||||

|

||||

> [MongoDB](nosql/mongodb) 📚

|

||||

> MongoDB 是一个基于文档的分布式数据库,由 C++ 语言编写。旨在为 WEB 应用提供可扩展的高性能数据存储解决方案。

|

||||

>

|

||||

> MongoDB 是一个介于关系型数据库和非关系型数据库之间的产品。它是非关系数据库当中功能最丰富,最像关系数据库的。它支持的数据结构非常松散,是类似 json 的 bson 格式,因此可以存储比较复杂的数据类型。

|

||||

>

|

||||

> MongoDB 最大的特点是它支持的查询语言非常强大,其语法有点类似于面向对象的查询语言,几乎可以实现类似关系数据库单表查询的绝大部分功能,而且还支持对数据建立索引。

|

||||

|

||||

- [MongoDB 应用指南](nosql/mongodb/mongodb-quickstart.md)

|

||||

- [MongoDB 聚合操作](nosql/mongodb/mongodb-aggregation.md)

|

||||

|

|

@ -106,39 +118,56 @@ footer: CC-BY-SA-4.0 Licensed | Copyright © 2018-Now Dunwu

|

|||

|

||||

## 📚 资料

|

||||

|

||||

- **Mysql**

|

||||

- **官方**

|

||||

### Mysql 资料

|

||||

|

||||

- **官方**

|

||||

- [Mysql 官网](https://www.mysql.com/)

|

||||

- [Mysql 官方文档](https://dev.mysql.com/doc/refman/8.0/en/)

|

||||

- [Mysql 官方文档之命令行客户端](https://dev.mysql.com/doc/refman/8.0/en/mysql.html)

|

||||

- **书籍**

|

||||

- **书籍**

|

||||

- [《高性能 MySQL》](https://book.douban.com/subject/23008813/) - 经典,适合 DBA 或作为开发者的参考手册

|

||||

- [《MySQL 必知必会》](https://book.douban.com/subject/3354490/) - 适合入门者

|

||||

- **教程**

|

||||

- **教程**

|

||||

- [runoob.com MySQL 教程](http://www.runoob.com/mysql/mysql-tutorial.html) - 入门级 SQL 教程

|

||||

- [mysql-tutorial](https://github.com/jaywcjlove/mysql-tutorial)

|

||||

- **更多资源**

|

||||

- **更多资源**

|

||||

- [awesome-mysql](https://github.com/jobbole/awesome-mysql-cn)

|

||||

- **Redis**

|

||||

- **官网**

|

||||

|

||||

### Redis 资料

|

||||

|

||||

- **官网**

|

||||

- [Redis 官网](https://redis.io/)

|

||||

- [Redis github](https://github.com/antirez/redis)

|

||||

- [Redis 官方文档中文版](http://redis.cn/)

|

||||

- [Redis 命令参考](http://redisdoc.com/)

|

||||

- **书籍**

|

||||

- **书籍**

|

||||

- [《Redis 实战》](https://item.jd.com/11791607.html)

|

||||

- [《Redis 设计与实现》](https://item.jd.com/11486101.html)

|

||||

- **源码**

|

||||

- **源码**

|

||||

- [《Redis 实战》配套 Python 源码](https://github.com/josiahcarlson/redis-in-action)

|

||||

- **资源汇总**

|

||||

- **资源汇总**

|

||||

- [awesome-redis](https://github.com/JamzyWang/awesome-redis)

|

||||

- **Redis Client**

|

||||

- **Redis Client**

|

||||

- [spring-data-redis 官方文档](https://docs.spring.io/spring-data/redis/docs/1.8.13.RELEASE/reference/html/)

|

||||

- [redisson 官方文档(中文,略有滞后)](https://github.com/redisson/redisson/wiki/%E7%9B%AE%E5%BD%95)

|

||||

- [redisson 官方文档(英文)](https://github.com/redisson/redisson/wiki/Table-of-Content)

|

||||

- [CRUG | Redisson PRO vs. Jedis: Which Is Faster? 翻译](https://www.jianshu.com/p/82f0d5abb002)

|

||||

- [redis 分布锁 Redisson 性能测试](https://blog.csdn.net/everlasting_188/article/details/51073505)

|

||||

|

||||

### MongoDB 资料

|

||||

|

||||

- **官方**

|

||||

- [MongoDB 官网](https://www.mongodb.com/)

|

||||

- [MongoDB Github](https://github.com/mongodb/mongo)

|

||||

- [MongoDB 官方免费教程](https://university.mongodb.com/)

|

||||

- **教程**

|

||||

- [MongoDB 教程](https://www.runoob.com/mongodb/mongodb-tutorial.html)

|

||||

- [MongoDB 高手课](https://time.geekbang.org/course/intro/100040001)

|

||||

- **数据**

|

||||

- [mongodb-json-files](https://github.com/ozlerhakan/mongodb-json-files)

|

||||

- **文章**

|

||||

- [Introduction to MongoDB](https://www.slideshare.net/mdirolf/introduction-to-mongodb)

|

||||

|

||||

## 🚪 传送

|

||||

|

||||

◾ 🏠 [DB-TUTORIAL 首页](https://github.com/dunwu/db-tutorial) ◾ 🎯 [我的博客](https://github.com/dunwu/blog) ◾

|

||||

|

|

|

|||

|

|

@ -22,7 +22,7 @@

|

|||

- [Elasticsearch 面试总结](elasticsearch/elasticsearch-interview.md) 💯

|

||||

- [Elasticsearch 简介](elasticsearch/Elasticsearch简介.md)

|

||||

- [Elasticsearch 快速入门](elasticsearch/Elasticsearch快速入门.md)

|

||||

- [Elasticsearch 基本概念](elasticsearch/Elasticsearch基本概念.md)

|

||||

- [Elasticsearch 基本概念](elasticsearch/Elasticsearch索引管理.md)

|

||||

- [Elasticsearch Rest API](elasticsearch/ElasticsearchRestApi.md)

|

||||

- [Elasticsearch 运维](elasticsearch/Elasticsearch运维.md)

|

||||

|

||||

|

|

|

|||

|

|

@ -5,35 +5,68 @@

|

|||

> [Elasticsearch](https://github.com/elastic/elasticsearch) 基于搜索库 [Lucene](https://github.com/apache/lucene-solr) 开发。ElasticSearch 隐藏了 Lucene 的复杂性,提供了简单易用的 REST API / Java API 接口(另外还有其他语言的 API 接口)。

|

||||

>

|

||||

> _以下简称 ES_。

|

||||

|

||||

>

|

||||

> REST API 最详尽的文档应该参考:[ES 官方 REST API](https://www.elastic.co/guide/en/elasticsearch/reference/current/rest-apis.html)

|

||||

|

||||

## 索引 API

|

||||

<!-- TOC depthFrom:2 depthTo:3 -->

|

||||

|

||||

- [1. ElasticSearch Rest API 语法格式](#1-elasticsearch-rest-api-语法格式)

|

||||

- [2. 索引 API](#2-索引-api)

|

||||

- [2.1. 创建索引](#21-创建索引)

|

||||

- [2.2. 删除索引](#22-删除索引)

|

||||

- [2.3. 查看索引](#23-查看索引)

|

||||

- [2.4. 索引别名](#24-索引别名)

|

||||

- [2.5. 打开/关闭索引](#25-打开关闭索引)

|

||||

- [3. 文档](#3-文档)

|

||||

- [3.1. 创建文档](#31-创建文档)

|

||||

- [3.2. 删除文档](#32-删除文档)

|

||||

- [3.3. 更新文档](#33-更新文档)

|

||||

- [3.4. 查询文档](#34-查询文档)

|

||||

- [3.5. 全文搜索](#35-全文搜索)

|

||||

- [3.6. 逻辑运算](#36-逻辑运算)

|

||||

- [3.7. 批量执行](#37-批量执行)

|

||||

- [3.8. 批量读取](#38-批量读取)

|

||||

- [3.9. 批量查询](#39-批量查询)

|

||||

- [3.10. URI Search 查询语义](#310-uri-search-查询语义)

|

||||

- [3.11. Request Body & DSL](#311-request-body--dsl)

|

||||

- [4. 集群 API](#4-集群-api)

|

||||

- [4.1. 集群健康 API](#41-集群健康-api)

|

||||

- [4.2. 集群状态 API](#42-集群状态-api)

|

||||

- [5. 节点 API](#5-节点-api)

|

||||

- [6. 分片 API](#6-分片-api)

|

||||

- [7. 监控 API](#7-监控-api)

|

||||

- [8. 参考资料](#8-参考资料)

|

||||

|

||||

<!-- /TOC -->

|

||||

|

||||

## 1. ElasticSearch Rest API 语法格式

|

||||

|

||||

向 Elasticsearch 发出的请求的组成部分与其它普通的 HTTP 请求是一样的:

|

||||

|

||||

```bash

|

||||

curl -X<VERB> '<PROTOCOL>://<HOST>:<PORT>/<PATH>?<QUERY_STRING>' -d '<BODY>'

|

||||

```

|

||||

|

||||

- `VERB`:HTTP 方法,支持:`GET`, `POST`, `PUT`, `HEAD`, `DELETE`

|

||||

- `PROTOCOL`:http 或者 https 协议(只有在 Elasticsearch 前面有 https 代理的时候可用)

|

||||

- `HOST`:Elasticsearch 集群中的任何一个节点的主机名,如果是在本地的节点,那么就叫 localhost

|

||||

- `PORT`:Elasticsearch HTTP 服务所在的端口,默认为 9200 PATH API 路径(例如\_count 将返回集群中文档的数量),

|

||||

- `PATH`:可以包含多个组件,例如 `_cluster/stats` 或者 `_nodes/stats/jvm`

|

||||

- `QUERY_STRING`:一些可选的查询请求参数,例如?pretty 参数将使请求返回更加美观易读的 JSON 数据

|

||||

- `BODY`:一个 JSON 格式的请求主体(如果请求需要的话)

|

||||

|

||||

## 2. 索引 API

|

||||

|

||||

> 参考资料:[Elasticsearch 官方之 cat 索引 API](https://www.elastic.co/guide/en/elasticsearch/reference/current/cat-indices.html)

|

||||

|

||||

### 创建索引

|

||||

### 2.1. 创建索引

|

||||

|

||||

新建 Index,可以直接向 ES 服务器发出 `PUT` 请求。

|

||||

|

||||

(1)直接创建索引

|

||||

|

||||

```bash

|

||||

curl -X POST 'localhost:9200/user'

|

||||

```

|

||||

|

||||

服务器返回一个 JSON 对象,里面的 `acknowledged` 字段表示操作成功。

|

||||

|

||||

```javascript

|

||||

{"acknowledged":true,"shards_acknowledged":true,"index":"user"}

|

||||

```

|

||||

|

||||

(2)创建索引时指定配置

|

||||

|

||||

语法格式:

|

||||

|

||||

```bash

|

||||

$ curl -X PUT /my_index

|

||||

PUT /my_index

|

||||

{

|

||||

"settings": { ... any settings ... },

|

||||

"mappings": {

|

||||

|

|

@ -47,15 +80,21 @@ $ curl -X PUT /my_index

|

|||

示例:

|

||||

|

||||

```bash

|

||||

$ curl -X PUT -H 'Content-Type: application/json' 'localhost:9200/user' -d '

|

||||

PUT /user

|

||||

{

|

||||

"settings" : {

|

||||

"index" : {

|

||||

"number_of_shards" : 3,

|

||||

"number_of_replicas" : 2

|

||||

"settings": {

|

||||

"index": {

|

||||

"number_of_shards": 3,

|

||||

"number_of_replicas": 2

|

||||

}

|

||||

}

|

||||

}'

|

||||

}

|

||||

```

|

||||

|

||||

服务器返回一个 JSON 对象,里面的 `acknowledged` 字段表示操作成功。

|

||||

|

||||

```javascript

|

||||

{"acknowledged":true,"shards_acknowledged":true,"index":"user"}

|

||||

```

|

||||

|

||||

如果你想禁止自动创建索引,可以通过在 `config/elasticsearch.yml` 的每个节点下添加下面的配置:

|

||||

|

|

@ -64,12 +103,12 @@ $ curl -X PUT -H 'Content-Type: application/json' 'localhost:9200/user' -d '

|

|||

action.auto_create_index: false

|

||||

```

|

||||

|

||||

### 删除索引

|

||||

### 2.2. 删除索引

|

||||

|

||||

然后,我们可以通过发送 `DELETE` 请求,删除这个 Index。

|

||||

|

||||

```bash

|

||||

curl -X DELETE 'localhost:9200/user'

|

||||

DELETE /user

|

||||

```

|

||||

|

||||

删除多个索引

|

||||

|

|

@ -79,7 +118,7 @@ DELETE /index_one,index_two

|

|||

DELETE /index_*

|

||||

```

|

||||

|

||||

### 查看索引

|

||||

### 2.3. 查看索引

|

||||

|

||||

可以通过 GET 请求查看索引信息

|

||||

|

||||

|

|

@ -110,7 +149,45 @@ GET /_cat/indices/kibana*?pri&v&h=health,index,pri,rep,docs.count,mt

|

|||

GET /_cat/indices?v&h=i,tm&s=tm:desc

|

||||

```

|

||||

|

||||

### 打开/关闭索引

|

||||

### 2.4. 索引别名

|

||||

|

||||

ES 的索引别名就是给一个索引或者多个索引起的另一个名字,典型的应用场景是针对索引使用的平滑切换。

|

||||

|

||||

首先,创建索引 my_index,然后将别名 my_alias 指向它,示例如下:

|

||||

|

||||

```bash

|

||||

PUT /my_index

|

||||

PUT /my_index/_alias/my_alias

|

||||

```

|

||||

|

||||

也可以通过如下形式:

|

||||

|

||||

```bash

|

||||

POST /_aliases

|

||||

{

|

||||

"actions": [

|

||||

{ "add": { "index": "my_index", "alias": "my_alias" }}

|

||||

]

|

||||

}

|

||||

```

|

||||

|

||||

也可以在一次请求中增加别名和移除别名混合使用:

|

||||

|

||||

```bash

|

||||

POST /_aliases

|

||||

{

|

||||

"actions": [

|

||||

{ "remove": { "index": "my_index", "alias": "my_alias" }}

|

||||

{ "add": { "index": "my_index_v2", "alias": "my_alias" }}

|

||||

]

|

||||

}

|

||||

```

|

||||

|

||||

> 需要注意的是,如果别名与索引是一对一的,使用别名索引文档或者查询文档是可以的,但是如果别名和索引是一对多的,使用别名会发生错误,因为 ES 不知道把文档写入哪个索引中去或者从哪个索引中读取文档。

|

||||

|

||||

ES 索引别名有个典型的应用场景是平滑切换,更多细节可以查看 [Elasticsearch(ES)索引零停机(无需重启)无缝平滑切换的方法](https://www.knowledgedict.com/tutorial/elasticsearch-index-smooth-shift.html)。

|

||||

|

||||

### 2.5. 打开/关闭索引

|

||||

|

||||

通过在 `POST` 中添加 `_close` 或 `_open` 可以打开、关闭索引。

|

||||

|

||||

|

|

@ -123,9 +200,9 @@ POST kibana_sample_data_ecommerce/_open

|

|||

POST kibana_sample_data_ecommerce/_close

|

||||

```

|

||||

|

||||

## 文档

|

||||

## 3. 文档

|

||||

|

||||

```

|

||||

```bash

|

||||

############Create Document############

|

||||

#create document. 自动生成 _id

|

||||

POST users/_doc

|

||||

|

|

@ -279,7 +356,7 @@ DELETE test

|

|||

DELETE test2

|

||||

```

|

||||

|

||||

### 创建文档

|

||||

### 3.1. 创建文档

|

||||

|

||||

#### 指定 ID

|

||||

|

||||

|

|

@ -323,7 +400,7 @@ POST /user/_doc

|

|||

}

|

||||

```

|

||||

|

||||

### 删除文档

|

||||

### 3.2. 删除文档

|

||||

|

||||

语法格式:

|

||||

|

||||

|

|

@ -337,7 +414,7 @@ DELETE /_index/_doc/_id

|

|||

DELETE /user/_doc/1

|

||||

```

|

||||

|

||||

### 更新文档

|

||||

### 3.3. 更新文档

|

||||

|

||||

#### 先删除,再写入

|

||||

|

||||

|

|

@ -377,7 +454,7 @@ POST /user/_update/1

|

|||

}

|

||||

```

|

||||

|

||||

### 查询文档

|

||||

### 3.4. 查询文档

|

||||

|

||||

#### 指定 ID 查询

|

||||

|

||||

|

|

@ -470,7 +547,7 @@ $ curl 'localhost:9200/user/admin/_search?pretty'

|

|||

|

||||

返回的记录中,每条记录都有一个`_score`字段,表示匹配的程序,默认是按照这个字段降序排列。

|

||||

|

||||

### 全文搜索

|

||||

### 3.5. 全文搜索

|

||||

|

||||

ES 的查询非常特别,使用自己的[查询语法](https://www.elastic.co/guide/en/elasticsearch/reference/5.5/query-dsl.html),要求 GET 请求带有数据体。

|

||||

|

||||

|

|

@ -537,7 +614,7 @@ $ curl 'localhost:9200/user/admin/_search' -d '

|

|||

|

||||

上面代码指定,从位置 1 开始(默认是从位置 0 开始),只返回一条结果。

|

||||

|

||||

### 逻辑运算

|

||||

### 3.6. 逻辑运算

|

||||

|

||||

如果有多个搜索关键字, Elastic 认为它们是`or`关系。

|

||||

|

||||

|

|

@ -566,7 +643,7 @@ $ curl -H 'Content-Type: application/json' 'localhost:9200/user/admin/_search?pr

|

|||

}'

|

||||

```

|

||||

|

||||

### 批量执行

|

||||

### 3.7. 批量执行

|

||||

|

||||

支持在一次 API 调用中,对不同的索引进行操作

|

||||

|

||||

|

|

@ -594,7 +671,7 @@ POST _bulk

|

|||

|

||||

> 说明:上面的示例如果执行多次,执行结果都不一样。

|

||||

|

||||

### 批量读取

|

||||

### 3.8. 批量读取

|

||||

|

||||

读多个索引

|

||||

|

||||

|

|

@ -656,7 +733,7 @@ GET /_mget

|

|||

}

|

||||

```

|

||||

|

||||

### 批量查询

|

||||

### 3.9. 批量查询

|

||||

|

||||

```bash

|

||||

POST kibana_sample_data_ecommerce/_msearch

|

||||

|

|

@ -666,7 +743,7 @@ POST kibana_sample_data_ecommerce/_msearch

|

|||

{"query" : {"match_all" : {}},"size":2}

|

||||

```

|

||||

|

||||

### URI Search 查询语义

|

||||

### 3.10. URI Search 查询语义

|

||||

|

||||

Elasticsearch URI Search 遵循 QueryString 查询语义,其形式如下:

|

||||

|

||||

|

|

@ -815,7 +892,7 @@ GET /movies/_search?q=title:"Lord Rings"~2

|

|||

}

|

||||

```

|

||||

|

||||

### Request Body & DSL

|

||||

### 3.11. Request Body & DSL

|

||||

|

||||

Elasticsearch 除了 URI Search 查询方式,还支持将查询语句通过 Http Request Body 发起查询。

|

||||

|

||||

|

|

@ -955,7 +1032,7 @@ POST movies/_search

|

|||

}

|

||||

```

|

||||

|

||||

## 集群 API

|

||||

## 4. 集群 API

|

||||

|

||||

> [Elasticsearch 官方之 Cluster API](https://www.elastic.co/guide/en/elasticsearch/reference/current/cluster.html)

|

||||

|

||||

|

|

@ -999,7 +1076,7 @@ GET /_nodes/ra*:2

|

|||

GET /_nodes/ra*:2*

|

||||

```

|

||||

|

||||

### 集群健康 API

|

||||

### 4.1. 集群健康 API

|

||||

|

||||

```bash

|

||||

GET /_cluster/health

|

||||

|

|

@ -1008,7 +1085,7 @@ GET /_cluster/health/kibana_sample_data_ecommerce,kibana_sample_data_flights

|

|||

GET /_cluster/health/kibana_sample_data_flights?level=shards

|

||||

```

|

||||

|

||||

### 集群状态 API

|

||||

### 4.2. 集群状态 API

|

||||

|

||||

集群状态 API 返回表示整个集群状态的元数据。

|

||||

|

||||

|

|

@ -1016,7 +1093,7 @@ GET /_cluster/health/kibana_sample_data_flights?level=shards

|

|||

GET /_cluster/state

|

||||

```

|

||||

|

||||

## 节点 API

|

||||

## 5. 节点 API

|

||||

|

||||

> [Elasticsearch 官方之 cat Nodes API](https://www.elastic.co/guide/en/elasticsearch/reference/current/cat-nodes.html)——返回有关集群节点的信息。

|

||||

|

||||

|

|

@ -1027,7 +1104,7 @@ GET /_cat/nodes?v=true

|

|||

GET /_cat/nodes?v=true&h=id,ip,port,v,m

|

||||

```

|

||||

|

||||

## 分片 API

|

||||

## 6. 分片 API

|

||||

|

||||

> [Elasticsearch 官方之 cat Shards API](https://www.elastic.co/guide/en/elasticsearch/reference/current/cat-shards.html)——shards 命令是哪些节点包含哪些分片的详细视图。它会告诉你它是主还是副本、文档数量、它在磁盘上占用的字节数以及它所在的节点。

|

||||

|

||||

|

|

@ -1040,7 +1117,46 @@ GET /_cat/shards/my-index-*

|

|||

GET /_cat/shards?h=index,shard,prirep,state,unassigned.reason

|

||||

```

|

||||

|

||||

## 参考资料

|

||||

## 7. 监控 API

|

||||

|

||||

Elasticsearch 中集群相关的健康、统计等相关的信息都是围绕着 `cat` API 进行的。

|

||||

|

||||

通过 GET 请求发送 cat,下面列出了所有可用的 API:

|

||||

|

||||

```bash

|

||||

GET /_cat

|

||||

|

||||

=^.^=

|

||||

/_cat/allocation

|

||||

/_cat/shards

|

||||

/_cat/shards/{index}

|

||||

/_cat/master

|

||||

/_cat/nodes

|

||||

/_cat/tasks

|

||||

/_cat/indices

|

||||

/_cat/indices/{index}

|

||||

/_cat/segments

|

||||

/_cat/segments/{index}

|

||||

/_cat/count

|

||||

/_cat/count/{index}

|

||||

/_cat/recovery

|

||||

/_cat/recovery/{index}

|

||||

/_cat/health

|

||||

/_cat/pending_tasks

|

||||

/_cat/aliases

|

||||

/_cat/aliases/{alias}

|

||||

/_cat/thread_pool

|

||||

/_cat/thread_pool/{thread_pools}

|

||||

/_cat/plugins

|

||||

/_cat/fielddata

|

||||

/_cat/fielddata/{fields}

|

||||

/_cat/nodeattrs

|

||||

/_cat/repositories

|

||||

/_cat/snapshots/{repository}

|

||||

/_cat/templates

|

||||

```

|

||||

|

||||

## 8. 参考资料

|

||||

|

||||

- **官方**

|

||||

- [Elasticsearch 官网](https://www.elastic.co/cn/products/elasticsearch)

|

||||

|

|

|

|||

|

|

@ -0,0 +1,407 @@

|

|||

# Elasticsearch 分析器

|

||||

|

||||

在 ES 中,不管是索引任务还是搜索工作,都需要使用 analyzer(分析器)。分析器,分为**内置分析器**和**自定义的分析器**。

|

||||

|

||||

分析器进一步由**字符过滤器**(**Character Filters**)、**分词器**(**Tokenizer**)和**词元过滤器**(**Token Filters**)三部分组成。它的执行顺序如下:

|

||||

|

||||

**_character filters_** -> **_tokenizer_** -> **_token filters_**

|

||||

|

||||

<!-- TOC depthFrom:2 depthTo:3 -->

|

||||

|

||||

- [1. 字符过滤器(Character Filters)](#1-字符过滤器character-filters)

|

||||

- [1.1. HTML strip character filter](#11-html-strip-character-filter)

|

||||

- [1.2. Mapping character filter](#12-mapping-character-filter)

|

||||

- [1.3. Pattern Replace character filter](#13-pattern-replace-character-filter)

|

||||

- [2. 分词器(Tokenizer)](#2-分词器tokenizer)

|

||||

- [2.1. elasticsearch-plugin 使用](#21-elasticsearch-plugin-使用)

|

||||

- [2.2. elasticsearch-analysis-ik 安装](#22-elasticsearch-analysis-ik-安装)

|

||||

- [2.3. elasticsearch-analysis-ik 使用](#23-elasticsearch-analysis-ik-使用)

|

||||

- [3. 词元过滤器(Token Filters)](#3-词元过滤器token-filters)

|

||||

- [3.1. 同义词](#31-同义词)

|

||||

- [4. 参考资料](#4-参考资料)

|

||||

|

||||

<!-- /TOC -->

|

||||

|

||||

## 1. 字符过滤器(Character Filters)

|

||||

|

||||

character filter 的输入是原始的文本 text,如果配置了多个,它会按照配置的顺序执行,目前 ES 自带的 character filter 主要由如下 3 类:

|

||||

|

||||

1. html strip character filter:从文本中剥离 HTML 元素,并用其解码值替换 HTML 实体(如,将 **_`&amp;`_** 替换为 **_`&`_**)。

|

||||

2. mapping character filter:自定义一个 map 映射,可以进行一些自定义的替换,如常用的大写变小写也可以在该环节设置。

|

||||

3. pattern replace character filter:使用 java 正则表达式来匹配应替换为指定替换字符串的字符,此外,替换字符串可以引用正则表达式中的捕获组。

|

||||

|

||||

### 1.1. HTML strip character filter

|

||||

|

||||

HTML strip 如下示例:

|

||||

|

||||

```bash

|

||||

GET /_analyze

|

||||

{

|

||||

"tokenizer": "keyword",

|

||||

"char_filter": [

|

||||

"html_strip"

|

||||

],

|

||||

"text": "<p>I'm so <b>happy</b>!</p>"

|

||||

}

|

||||

```

|

||||

|

||||

经过 **_`html_strip`_** 字符过滤器处理后,输出如下:

|

||||

|

||||

```

|

||||

[ \nI'm so happy!\n ]

|

||||

```

|

||||

|

||||

### 1.2. Mapping character filter

|

||||

|

||||

Mapping character filter 接收键和值映射(key => value)作为配置参数,每当在预处理过程中遇到与键值映射中的键相同的字符串时,就会使用该键对应的值去替换它。

|

||||

|

||||

原始文本中的字符串和键值映射中的键的匹配是贪心的,在对给定的文本进行预处理过程中如果配置的键值映射存在包含关系,会优先**匹配最长键**。同样也可以用空字符串进行替换。

|

||||

|

||||

mapping char_filter 不像 html_strip 那样拆箱即可用,必须先进行配置才能使用,它有两个属性可以配置:

|

||||

|

||||

| 参数名称 | 参数说明 |

|

||||

| :-------------------- | :--------------------------------------------------------------------------------------------- |

|

||||

| **_`mappings`_** | 一组映射,每个元素的格式为 _key => value_。 |

|

||||

| **_`mappings_path`_** | 一个相对或者绝对的文件路径,指向一个每行包含一个 _key =>value_ 映射的 UTF-8 编码文本映射文件。 |

|

||||

|

||||

mapping char_filter 示例如下:

|

||||

|

||||

```bash

|

||||

GET /_analyze

|

||||

{

|

||||

"tokenizer": "keyword",

|

||||

"char_filter": [

|

||||

{

|

||||

"type": "mapping",

|

||||

"mappings": [

|

||||

"٠ => 0",

|

||||

"١ => 1",

|

||||

"٢ => 2",

|

||||

"٣ => 3",

|

||||

"٤ => 4",

|

||||

"٥ => 5",

|

||||

"٦ => 6",

|

||||

"٧ => 7",

|

||||

"٨ => 8",

|

||||

"٩ => 9"

|

||||

]

|

||||

}

|

||||

],

|

||||

"text": "My license plate is ٢٥٠١٥"

|

||||

}

|

||||

```

|

||||

|

||||

分析结果如下:

|

||||

|

||||

```

|

||||

[ My license plate is 25015 ]

|

||||

```

|

||||

|

||||

### 1.3. Pattern Replace character filter

|

||||

|

||||

Pattern Replace character filter 支持如下三个参数:

|

||||

|

||||

| 参数名称 | 参数说明 |

|

||||

| :------------------ | :----------------------------------------------------------------------------- |

|

||||

| **_`pattern`_** | 必填参数,一个 java 的正则表达式。 |

|

||||

| **_`replacement`_** | 替换字符串,可以使用 **_`$1 ... $9`_** 语法来引用捕获组。 |

|

||||

| **_`flags`_** | Java 正则表达式的标志,具体参考 java 的 java.util.regex.Pattern 类的标志属性。 |

|

||||

|

||||

如将输入的 text 中大于一个的空格都转变为一个空格,在 settings 时,配置示例如下:

|

||||

|

||||

```bash

|

||||

"char_filter": {

|

||||

"multi_space_2_one": {

|

||||

"pattern": "[ ]+",

|

||||

"type": "pattern_replace",

|

||||

"replacement": " "

|

||||

},

|

||||

...

|

||||

}

|

||||

```

|

||||

|

||||

## 2. 分词器(Tokenizer)

|

||||

|

||||

tokenizer 即分词器,也是 analyzer 最重要的组件,它对文本进行分词;**一个 analyzer 必需且只可包含一个 tokenizer**。

|

||||

|

||||

ES 自带默认的分词器是 standard tokenizer,标准分词器提供基于语法的分词(基于 Unicode 文本分割算法),并且适用于大多数语言。

|

||||

|

||||

此外有很多第三方的分词插件,如中文分词界最经典的 ik 分词器,它对应的 tokenizer 分为 ik_smart 和 ik_max_word,一个是智能分词(针对搜索侧),一个是全切分词(针对索引侧)。

|

||||

|

||||

ES 默认提供的分词器 standard 对中文分词不优化,效果差,一般会安装第三方中文分词插件,通常首先 [elasticsearch-analysis-ik](https://github.com/medcl/elasticsearch-analysis-ik) 插件,它其实是 ik 针对的 ES 的定制版。

|

||||

|

||||

### 2.1. elasticsearch-plugin 使用

|

||||

|

||||

在安装 elasticsearch-analysis-ik 第三方之前,我们首先要了解 es 的插件管理工具 **_`elasticsearch-plugin`_** 的使用。

|

||||

|

||||

现在的 elasticsearch 安装完后,在安装目录的 bin 目录下会存在 elasticsearch-plugin 命令工具,用它来对 es 插件进行管理。

|

||||

|

||||

```

|

||||

bin/elasticsearch-plugin

|

||||

```

|

||||

|

||||

其实该命令的是软连接,原始路径是:

|

||||

|

||||

```

|

||||

libexec/bin/elasticsearch-plugin

|

||||

```

|

||||

|

||||

再进一步看脚本代码,你会发现,它是通过 **_`elasticsearch-cli`_** 执行 `libexec/lib/tools/plugin-cli/elasticsearch-plugin-cli-x.x.x.jar`。

|

||||

|

||||

但一般使用者了解 elasticsearch-plugin 命令使用就可:

|

||||

|

||||

```bash

|

||||

# 安装指定的插件到当前 ES 节点中

|

||||

elasticsearch-plugin install {plugin_url}

|

||||

|

||||

# 显示当前 ES 节点已经安装的插件列表

|

||||

elasticsearch-plugin list

|

||||

|

||||

# 删除已安装的插件

|

||||

elasticsearch-plugin remove {plugin_name}

|

||||

```

|

||||

|

||||

> 在安装插件时,要保证安装的插件与 ES 版本一致。

|

||||

|

||||

### 2.2. elasticsearch-analysis-ik 安装

|

||||

|

||||

在确定要安装的 ik 版本之后,执行如下命令:

|

||||

|

||||

```bash

|

||||

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v{X.X.X}/elasticsearch-analysis-ik-{X.X.X}.zip

|

||||

```

|

||||

|

||||

执行完安装命令后,我们会发现在 plugins 中多了 analysis-ik 目录,这里面主要存放的是源码 jar 包,此外,在 config 文件里也多了 analysis-ik 目录,里面主要是 ik 相关的配置,如 IKAnalyzer.cfg.xml 配置、词典文件等。

|

||||

|

||||

```bash

|

||||

# 两个新增目录路径

|

||||

libexec/plugins/analysis-ik/

|

||||

libexec/config/analysis-ik/

|

||||

```

|

||||

|

||||

### 2.3. elasticsearch-analysis-ik 使用

|

||||

|

||||

ES 5.X 版本开始安装完的 elasticsearch-analysis-ik 提供了两个分词器,分别对应名称是 **_ik_max_word_** 和 **_ik_smart_**,ik_max_word 是索引侧的分词器,走全切模式,ik_smart 是搜索侧的分词器,走智能分词,属于搜索模式。

|

||||

|

||||

#### 索引 mapping 设置

|

||||

|

||||

安装完 elasticsearch-analysis-ik 后,我们可以指定索引及指定字段设置可用的分析器(analyzer),示例如下:

|

||||

|

||||

```json

|

||||

{

|

||||

"qa": {

|

||||

"mappings": {

|

||||

"qa": {

|

||||

"_all": {

|

||||

"enabled": false

|

||||

},

|

||||

"properties": {

|

||||

"question": {

|

||||

"type": "text",

|

||||

"store": true,

|

||||

"similarity": "BM25",

|

||||

"analyzer": "ik_max_word",

|

||||

"search_analyzer": "ik_smart"

|

||||

},

|

||||

"answer": {

|

||||

"type": "text",

|

||||

"store": false,

|

||||

"similarity": "BM25",

|

||||

"analyzer": "ik_max_word",

|

||||

"search_analyzer": "ik_smart"

|

||||

},

|

||||

...

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

如上示例中,analyzer 指定 ik_max_word,即索引侧使用 ik 全切模式,search_analyzer 设置 ik_smart,即搜索侧使用 ik 智能分词模式。

|

||||

|

||||

#### 查看 ik 分词结果

|

||||

|

||||

es 提供了查看分词结果的 api **`analyze`**,具体示例如下:

|

||||

|

||||

```bash

|

||||

GET {index}/_analyze

|

||||

{

|

||||

"analyzer" : "ik_smart",

|

||||

"text" : "es 中文分词器安装"

|

||||

}

|

||||

```

|

||||

|

||||

输出如下:

|

||||

|

||||

```json

|

||||

{

|

||||

"tokens": [

|

||||

{

|

||||

"token": "es",

|

||||

"start_offset": 0,

|

||||

"end_offset": 2,

|

||||

"type": "CN_WORD",

|

||||

"position": 0

|

||||

},

|

||||

{

|

||||

"token": "中文",

|

||||

"start_offset": 3,

|

||||

"end_offset": 5,

|

||||

"type": "CN_WORD",

|

||||

"position": 1

|

||||

},

|

||||

{

|

||||

"token": "分词器",

|

||||

"start_offset": 5,

|

||||

"end_offset": 8,

|

||||

"type": "CN_WORD",

|

||||

"position": 2

|

||||

},

|

||||

{

|

||||

"token": "安装",

|

||||

"start_offset": 8,

|

||||

"end_offset": 10,

|

||||

"type": "CN_WORD",

|

||||

"position": 3

|

||||

}

|

||||

]

|

||||

}

|

||||

```

|

||||

|

||||

#### elasticsearch-analysis-ik 自定义词典

|

||||

|

||||

elasticsearch-analysis-ik 本质是 ik 分词器,使用者根据实际需求可以扩展自定义的词典,具体主要分为如下 2 大类,每类又分为本地配置和远程配置 2 种:

|

||||

|

||||

1. 自定义扩展词典;

|

||||

2. 自定义扩展停用词典;

|

||||

|

||||

elasticsearch-analysis-ik 配置文件为 `IKAnalyzer.cfg.xml`,它位于 `libexec/config/analysis-ik` 目录下,具体配置结构如下:

|

||||

|

||||

```xml

|

||||

<?xml version="1.0" encoding="UTF-8"?>

|

||||

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

|

||||

<properties>

|

||||

<comment>IK Analyzer 扩展配置</comment>

|

||||

<!--用户可以在这里配置自己的扩展字典 -->

|

||||

<entry key="ext_dict"></entry>

|

||||

<!--用户可以在这里配置自己的扩展停止词字典-->

|

||||

<entry key="ext_stopwords"></entry>

|

||||

<!--用户可以在这里配置远程扩展字典 -->

|

||||

<!-- <entry key="remote_ext_dict">words_location</entry> -->

|

||||

<!--用户可以在这里配置远程扩展停止词字典-->

|

||||

<!-- <entry key="remote_ext_stopwords">words_location</entry> -->

|

||||

</properties>

|

||||

```

|

||||

|

||||

> 当然,如果开发者认为 ik 默认的词表有问题,也可以进行调整,文件都在 `libexec/config/analysis-ik` 下,如 main.dic 为主词典,stopword.dic 为停用词表。

|

||||

|

||||

## 3. 词元过滤器(Token Filters)

|

||||

|

||||

token filters 叫词元过滤器,或词项过滤器,对 tokenizer 分出的词进行过滤处理。常用的有转小写、停用词处理、同义词处理等等。**一个 analyzer 可包含 0 个或多个词项过滤器,按配置顺序进行过滤**。

|

||||

|

||||

以同义词过滤器的使用示例,具体如下:

|

||||

|

||||

```bash

|

||||

PUT /test_index

|

||||

{

|

||||

"settings": {

|

||||

"index": {

|

||||

"analysis": {

|

||||

"analyzer": {

|

||||

"synonym": {

|

||||

"tokenizer": "standard",

|

||||

"filter": [ "my_stop", "synonym" ]

|

||||

}

|

||||

},

|

||||

"filter": {

|

||||

"my_stop": {

|

||||

"type": "stop",

|

||||

"stopwords": [ "bar" ]

|

||||

},

|

||||

"synonym": {

|

||||

"type": "synonym",

|

||||

"lenient": true,

|

||||

"synonyms": [ "foo, bar => baz" ]

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

### 3.1. 同义词

|

||||

|

||||

Elasticsearch 同义词通过专有的同义词过滤器(synonym token filter)来进行工作,它允许在分析(analysis)过程中方便地处理同义词,一般是通过配置文件配置同义词。此外,同义词可以再建索引时(index-time synonyms)或者检索时(search-time synonyms)使用。

|

||||

|

||||

#### 同义词(synonym)配置语法

|

||||

|

||||

如上例子所示,es 同义词配置的 filter 语法具体如下选项:

|

||||

|

||||

- **_`type`_**:指定 synonym,表示同义词 filter;

|

||||

|

||||

- **_`synonyms_path`_**:指定同义词配置文件路径;

|

||||

|

||||

- **`expand`**:该参数决定映射行为的模式,默认为 true,表示扩展模式,具体示例如下:

|

||||

|

||||

- 当 **`expand == true`** 时,

|

||||

|

||||

```

|

||||

ipod, i-pod, i pod

|

||||

```

|

||||

|

||||

等价于:

|

||||

|

||||

```

|

||||

ipod, i-pod, i pod => ipod, i-pod, i pod

|

||||

```

|

||||

|

||||

当 **_`expand == false`_** 时,

|

||||

|

||||

```

|

||||

ipod, i-pod, i pod

|

||||

```

|

||||

|

||||

仅映射第一个单词,等价于:

|

||||

|

||||

```

|

||||

ipod, i-pod, i pod => ipod

|

||||

```

|

||||

|

||||

- **_`lenient`_**:如果值为 true 时,遇到那些无法解析的同义词规则时,忽略异常。默认为 false。

|

||||

|

||||

#### 同义词文档格式

|

||||

|

||||

elasticsearch 的同义词有如下两种形式:

|

||||

|

||||

- 单向同义词:

|

||||

|

||||

```

|

||||

ipod, i-pod, i pod => ipod

|

||||

```

|

||||

|

||||

- 双向同义词:

|

||||

|

||||

```

|

||||

马铃薯, 土豆, potato

|

||||

```

|

||||

|

||||

单向同义词不管索引还是检索时,箭头左侧的词都会映射成箭头右侧的词;

|

||||

|

||||

双向同义词是索引时,都建立同义词的倒排索引,检索时,同义词之间都会进行倒排索引的匹配。

|

||||

|

||||

> 同义词的文档化时,需要注意的是,同一个词在不同的同义词关系中出现时,其它同义词之间不具有传递性,这点需要注意。

|

||||

|

||||

假设如上示例中,如果“马铃薯”和其它两个同义词分成两行写:

|

||||

|

||||

```

|

||||

马铃薯,土豆

|

||||

马铃薯,potato

|

||||

```

|

||||

|

||||

此时,elasticsearch 中不会将“土豆”和“potato”视为同义词关系,所以多个同义词要写在一起,这往往是开发中经常容易疏忽的点。

|

||||

|

||||

## 4. 参考资料

|

||||

|

||||

- [Elasticsearch 教程](https://www.knowledgedict.com/tutorial/elasticsearch-intro.html)

|

||||

|

|

@ -1,521 +0,0 @@

|

|||

# Elasticsearch 基本概念

|

||||

|

||||

## 文档

|

||||

|

||||

Elasticsearch 是面向文档的,文档是所有可搜索数据的最小单位。

|

||||

|

||||

Elasticsearch 使用 [_JSON_](http://en.wikipedia.org/wiki/Json) 作为文档的序列化格式。

|

||||

|

||||

每个文档都有一个 Unique ID

|

||||

|

||||

- 用户可以自己指定

|

||||

- 或通过 Elasticsearch 自动生成

|

||||

|

||||

### 文档的元数据

|

||||

|

||||

一个文档不仅仅包含它的数据 ,也包含**元数据** —— 有关文档的信息。

|

||||

|

||||

- `_index`:文档在哪存放

|

||||

- `_type`:文档表示的对象类别

|

||||

- `_id`:文档唯一标识

|

||||

- `_source`:文档的原始 Json 数据

|

||||

- `_all`:整合所有字段内容到该字段,已被废除

|

||||

- `_version`:文档的版本信息

|

||||

- `_score`:相关性打分

|

||||

|

||||

示例:

|

||||

|

||||

```json

|

||||

{

|

||||

"_index": "megacorp",

|

||||

"_type": "employee",

|

||||

"_id": "1",

|

||||

"_version": 1,

|

||||

"found": true,

|

||||

"_source": {

|

||||

"first_name": "John",

|

||||

"last_name": "Smith",

|

||||

"age": 25,

|

||||

"about": "I love to go rock climbing",

|

||||

"interests": ["sports", "music"]

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

## 索引

|

||||

|

||||

索引在不同语境,有着不同的含义

|

||||

|

||||

- 索引(名词):一个 **索引** 类似于传统关系数据库中的一个 **数据库** ,是一个存储关系型文档的容器。 索引 (_index_) 的复数词为 indices 或 indexes 。索引实际上是指向一个或者多个**物理分片**的**逻辑命名空间** 。

|

||||

- 索引(动词):索引一个文档 就是存储一个文档到一个 _索引_ (名词)中以便被检索和查询。这非常类似于 SQL 语句中的 `INSERT` 关键词,除了文档已存在时,新文档会替换旧文档情况之外。

|

||||

- 倒排索引:关系型数据库通过增加一个索引比如一个 B 树索引到指定的列上,以便提升数据检索速度。Elasticsearch 和 Lucene 使用了一个叫做 **倒排索引** 的结构来达到相同的目的。

|

||||

|

||||

索引的 Mapping 和 Setting

|

||||

|

||||

- **`Mapping`** 定义文档字段的类型

|

||||

- **`Setting`** 定义不同的数据分布

|

||||

|

||||

示例:

|

||||

|

||||

```json

|

||||

{

|

||||

"settings": { ... any settings ... },

|

||||

"mappings": {

|

||||

"type_one": { ... any mappings ... },

|

||||

"type_two": { ... any mappings ... },

|

||||

...

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

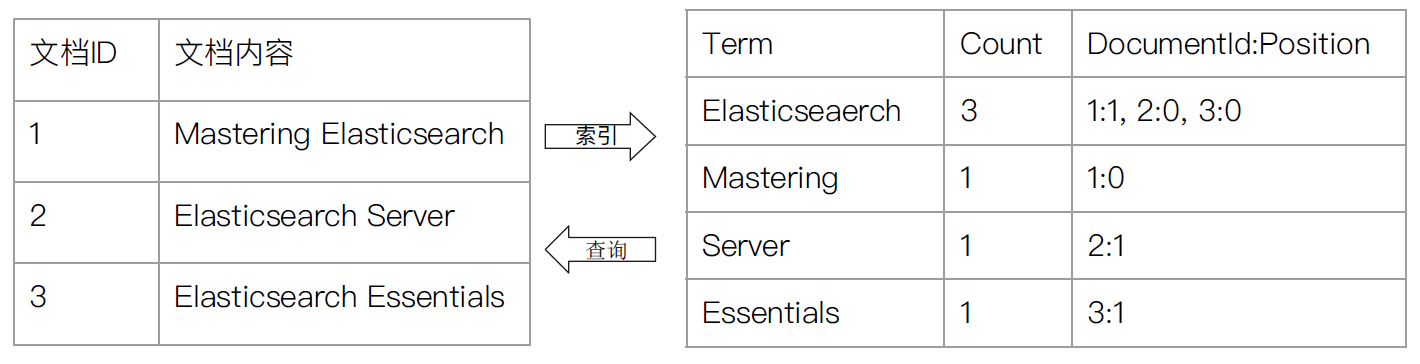

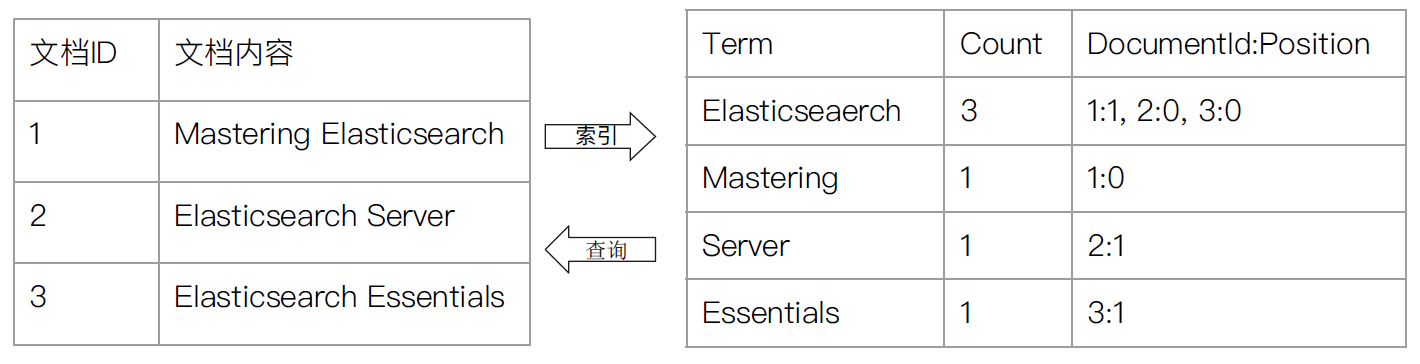

### 倒排索引

|

||||

|

||||

|

||||

|

||||

### index template

|

||||

|

||||

**`index template`**(索引模板)帮助用户设定 Mapping 和 Setting,并按照一定的规则,自动匹配到新创建的索引之上。

|

||||

|

||||

- 模板仅在一个索引被创建时,才会产生作用。修改模板不会影响已创建的索引。

|

||||

- 你可以设定多个索引模板,这些设置会被 merge 在一起。

|

||||

- 你可以指定 order 的数值,控制 merge 的过程。

|

||||

|

||||

当新建一个索引时

|

||||

|

||||

- 应用 ES 默认的 Mapping 和 Setting

|

||||

- 应用 order 数值低的 index template 中的设定

|

||||

- 应用 order 数值高的 index template 中的设定,之前的设定会被覆盖

|

||||

- 应用创建索引是,用户所指定的 Mapping 和 Setting,并覆盖之前模板中的设定。

|

||||

|

||||

示例:创建默认索引模板

|

||||

|

||||

```bash

|

||||

PUT _template/template_default

|

||||

{

|

||||

"index_patterns": ["*"],

|

||||

"order": 0,

|

||||

"version": 1,

|

||||

"settings": {

|

||||

"number_of_shards": 1,

|

||||

"number_of_replicas": 1

|

||||

}

|

||||

}

|

||||

|

||||

PUT /_template/template_test

|

||||

{

|

||||

"index_patterns": ["test*"],

|

||||

"order": 1,

|

||||

"settings": {

|

||||

"number_of_shards": 1,

|

||||

"number_of_replicas": 2

|

||||

},

|

||||

"mappings": {

|

||||

"date_detection": false,

|

||||

"numeric_detection": true

|

||||

}

|

||||

}

|

||||

|

||||

# 查看索引模板

|

||||

GET /_template/template_default

|

||||

GET /_template/temp*

|

||||

|

||||

#写入新的数据,index以test开头

|

||||

PUT testtemplate/_doc/1

|

||||

{

|

||||

"someNumber": "1",

|

||||

"someDate": "2019/01/01"

|

||||

}

|

||||

GET testtemplate/_mapping

|

||||

GET testtemplate/_settings

|

||||

|

||||

PUT testmy

|

||||

{

|

||||

"settings":{

|

||||

"number_of_replicas":5

|

||||

}

|

||||

}

|

||||

|

||||

PUT testmy/_doc/1

|

||||

{

|

||||

"key": "value"

|

||||

}

|

||||

|

||||

GET testmy/_settings

|

||||

DELETE testmy

|

||||

DELETE /_template/template_default

|

||||

DELETE /_template/template_test

|

||||

```

|

||||

|

||||

### dynamic template

|

||||

|

||||

- 根据 ES 识别的数据类型,结合字段名称,来动态设定字段类型

|

||||

- 所有的字符串类型都设定成 Keyword,或者关闭 keyword 字段。

|

||||

- is 开头的字段都设置成 boolean

|

||||

- long_ 开头的都设置成 long 类型

|

||||

- dynamic template 是定义在某个索引的 Mapping 中

|

||||

- template 有一个名称

|

||||

- 匹配规则是一个数组

|

||||

- 为匹配到字段设置 Mapping

|

||||

|

||||

示例:

|

||||

|

||||

```bash

|

||||

#Dynaminc Mapping 根据类型和字段名

|

||||

DELETE my_index

|

||||

|

||||

PUT my_index/_doc/1

|

||||

{

|

||||

"firstName": "Ruan",

|

||||

"isVIP": "true"

|

||||

}

|

||||

|

||||

GET my_index/_mapping

|

||||

|

||||

DELETE my_index

|

||||

PUT my_index

|

||||

{

|

||||

"mappings": {

|

||||

"dynamic_templates": [

|

||||

{

|

||||

"strings_as_boolean": {

|

||||

"match_mapping_type": "string",

|

||||

"match": "is*",

|

||||

"mapping": {

|

||||

"type": "boolean"

|

||||

}

|

||||

}

|

||||

},

|

||||

{

|

||||

"strings_as_keywords": {

|

||||

"match_mapping_type": "string",

|

||||

"mapping": {

|

||||

"type": "keyword"

|

||||

}

|

||||

}

|

||||

}

|

||||

]

|

||||

}

|

||||

}

|

||||

GET my_index/_mapping

|

||||

|

||||

DELETE my_index

|

||||

#结合路径

|

||||

PUT my_index

|

||||

{

|

||||

"mappings": {

|

||||

"dynamic_templates": [

|

||||

{

|

||||

"full_name": {

|

||||

"path_match": "name.*",

|

||||

"path_unmatch": "*.middle",

|

||||

"mapping": {

|

||||

"type": "text",

|

||||

"copy_to": "full_name"

|

||||

}

|

||||

}

|

||||

}

|

||||

]

|

||||

}

|

||||

}

|

||||

GET my_index/_mapping

|

||||

|

||||

|

||||

PUT my_index/_doc/1

|

||||

{

|

||||

"name": {

|

||||

"first": "John",

|

||||

"middle": "Winston",

|

||||

"last": "Lennon"

|

||||

}

|

||||

}

|

||||

|

||||

GET my_index/_search?q=full_name:John

|

||||

DELETE my_index

|

||||

```

|

||||

|

||||

## Mapping

|

||||

|

||||

在 Elasticsearch 中,**`Mapping`**(映射),用来定义一个文档以及其所包含的字段如何被存储和索引,可以在映射中事先定义字段的数据类型、字段的权重、分词器等属性,就如同在关系型数据库中创建数据表时会设置字段的类型。

|

||||

|

||||

Mapping 会把 json 文档映射成 Lucene 所需要的扁平格式

|

||||

|

||||

一个 Mapping 属于一个索引的 Type

|

||||

|

||||

- 每个文档都属于一个 Type

|

||||

- 一个 Type 有一个 Mapping 定义

|

||||

- 7.0 开始,不需要在 Mapping 定义中指定 type 信息

|

||||

|

||||

### 映射分类

|

||||

|

||||

在 Elasticsearch 中,映射可分为静态映射和动态映射。

|

||||

|

||||

#### 静态映射

|

||||

|

||||

**静态映射**是在创建索引时手工指定索引映射。静态映射和 SQL 中在建表语句中指定字段属性类似。相比动态映射,通过静态映射可以添加更详细、更精准的配置信息。

|

||||

|

||||

如何定义一个 Mapping

|

||||

|

||||

```bash

|

||||

PUT /books

|

||||

{

|

||||

"mappings": {

|

||||

"type_one": { ... any mappings ... },

|

||||

"type_two": { ... any mappings ... },

|

||||

...

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

#### 动态映射

|

||||

|

||||

**动态映射**是一种偷懒的方式,可直接创建索引并写入文档,文档中字段的类型是 Elasticsearch **自动识别**的,不需要在创建索引的时候设置字段的类型。在实际项目中,如果遇到的业务在导入数据之前不确定有哪些字段,也不清楚字段的类型是什么,使用动态映射非常合适。当 Elasticsearch 在文档中碰到一个以前没见过的字段时,它会利用动态映射来决定该字段的类型,并自动把该字段添加到映射中,根据字段的取值自动推测字段类型的规则见下表:

|

||||

|

||||

| JSON 格式的数据 | 自动推测的字段类型 |

|

||||

| :-------------- | :--------------------------------------------------------------------------------- |

|

||||

| null | 没有字段被添加 |

|

||||

| true or false | boolean 类型 |

|

||||

| 浮点类型数字 | float 类型 |

|

||||

| 数字 | long 类型 |

|

||||

| JSON 对象 | object 类型 |

|

||||

| 数组 | 由数组中第一个非空值决定 |

|

||||

| string | 有可能是 date 类型(若开启日期检测)、double 或 long 类型、text 类型、keyword 类型 |

|

||||

|

||||

下面举一个例子认识动态 mapping,在 Elasticsearch 中创建一个新的索引并查看它的 mapping,命令如下:

|

||||

|

||||

```bash

|

||||

PUT books

|

||||

GET books/_mapping

|

||||

```

|

||||

|

||||

此时 books 索引的 mapping 是空的,返回结果如下:

|

||||

|

||||

```json

|

||||

{

|

||||

"books": {

|

||||

"mappings": {}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

再往 books 索引中写入一条文档,命令如下:

|

||||

|

||||

```bash

|

||||

PUT books/it/1

|

||||

{

|

||||

"id": 1,

|

||||

"publish_date": "2019-11-10",

|

||||

"name": "master Elasticsearch"

|

||||

}

|

||||

```

|

||||

|

||||

文档写入完成之后,再次查看 mapping,返回结果如下:

|

||||

|

||||

```json

|

||||

{

|

||||

"books": {

|

||||

"mappings": {

|

||||

"properties": {

|

||||

"id": {

|

||||

"type": "long"

|

||||

},

|

||||

"name": {

|

||||

"type": "text",

|

||||

"fields": {

|

||||

"keyword": {

|

||||

"type": "keyword",

|

||||

"ignore_above": 256

|

||||

}

|

||||

}

|

||||

},

|

||||

"publish_date": {

|

||||

"type": "date"

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

使用动态 mapping 要结合实际业务需求来综合考虑,如果将 Elasticsearch 当作主要的数据存储使用,并且希望出现未知字段时抛出异常来提醒你注意这一问题,那么开启动态 mapping 并不适用。在 mapping 中可以通过 `dynamic` 设置来控制是否自动新增字段,接受以下参数:

|

||||

|

||||

- **`true`**:默认值为 true,自动添加字段。

|

||||

- **`false`**:忽略新的字段。

|

||||

- **`strict`**:严格模式,发现新的字段抛出异常。

|

||||

|

||||

### 基础类型

|

||||

|

||||

| 类型 | 关键字 |

|

||||

| :--------- | :------------------------------------------------------------------ |

|

||||

| 字符串类型 | string、text、keyword |

|

||||

| 数字类型 | long、integer、short、byte、double、float、half_float、scaled_float |

|

||||

| 日期类型 | date |

|

||||

| 布尔类型 | boolean |

|

||||

| 二进制类型 | binary |

|

||||

| 范围类型 | range |

|

||||

|

||||

### 复杂类型

|

||||

|

||||

| 类型 | 关键字 |

|

||||

| :------- | :----- |

|

||||

| 数组类型 | array |

|

||||

| 对象类型 | object |

|

||||

| 嵌套类型 | nested |

|

||||

|

||||

### 特殊类型

|

||||

|

||||

| 类型 | 关键字 |

|

||||

| :----------- | :---------- |

|

||||

| 地理类型 | geo_point |

|

||||

| 地理图形类型 | geo_shape |

|

||||

| IP 类型 | ip |

|

||||

| 范围类型 | completion |

|

||||

| 令牌计数类型 | token_count |

|

||||

| 附件类型 | attachment |

|

||||

| 抽取类型 | percolator |

|

||||

|

||||

### Mapping 属性

|

||||

|

||||

Elasticsearch 的 mapping 中的字段属性非常多,具体如下表格:

|

||||

|

||||

| 属性名 | 描述 |

|

||||

| :---------------------- | :------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- | ------------------------------------------------------------------------------------------------------------------------------------------------ |

|

||||

| **_`type`_** | 字段类型,常用的有 text、integer 等等。 |

|

||||

| **_`index`_** | 当前字段是否被作为索引。可选值为 **_`true`_**,默认为 true。 |

|

||||

| **_`store`_** | 是否存储指定字段,可选值为 **_`true`_** | **_`false`_**,设置 true 意味着需要开辟单独的存储空间为这个字段做存储,而且这个存储是独立于 **_`_source`_** 的存储的。 |

|

||||

| **_`norms`_** | 是否使用归一化因子,可选值为 **_`true`_** | **_`false`_**,不需要对某字段进行打分排序时,可禁用它,节省空间;_type_ 为 _text_ 时,默认为 _true_;而 _type_ 为 _keyword_ 时,默认为 _false_。 |

|

||||

| **_`index_options`_** | 索引选项控制添加到倒排索引(Inverted Index)的信息,这些信息用于搜索(Search)和高亮显示:**_`docs`_**:只索引文档编号(Doc Number);**_`freqs`_**:索引文档编号和词频率(term frequency);**_`positions`_**:索引文档编号,词频率和词位置(序号);**_`offsets`_**:索引文档编号,词频率,词偏移量(开始和结束位置)和词位置(序号)。默认情况下,被分析的字符串(analyzed string)字段使用 _positions_,其他字段默认使用 _docs_。此外,需要注意的是 _index_option_ 是 elasticsearch 特有的设置属性;临近搜索和短语查询时,_index_option_ 必须设置为 _offsets_,同时高亮也可使用 postings highlighter。 |

|

||||

| **_`term_vector`_** | 索引选项控制词向量相关信息:**_`no`_**:默认值,表示不存储词向量相关信息;**_`yes`_**:只存储词向量信息;**_`with_positions`_**:存储词项和词项位置;**_`with_offsets`_**:存储词项和字符偏移位置;**_`with_positions_offsets`_**:存储词项、词项位置、字符偏移位置。_term_vector_ 是 lucene 层面的索引设置。 |

|

||||

| **_`similarity`_** | 指定文档相似度算法(也可以叫评分模型):**_`BM25`_**:es 5 之后的默认设置。 |

|

||||

| **_`copy_to`_** | 复制到自定义 \_all 字段,值是数组形式,即表明可以指定多个自定义的字段。 |

|

||||

| **_`analyzer`_** | 指定索引和搜索时的分析器,如果同时指定 _search_analyzer_ 则搜索时会优先使用 _search_analyzer_。 |

|

||||

| **_`search_analyzer`_** | 指定搜索时的分析器,搜索时的优先级最高。 |

|

||||

| **_`null_value`_** | 用于需要对 Null 值实现搜索的场景,只有 Keyword 类型支持此配置。 |

|

||||

|

||||

## 分词

|

||||

|

||||

## 节点

|

||||

|

||||

### 节点简介

|

||||

|

||||

一个运行中的 Elasticsearch 实例称为一个**节点**。

|

||||

|

||||

Elasticsearch 实例本质上是一个 Java 进程。一台机器上可以运行多个 Elasticsearch 进程,但是生产环境建议一台机器上只运行一个 Elasticsearch 进程

|

||||

|

||||

每个节点都有名字,通过配置文件配置,或启动时通过 `-E node.name=node1` 指定。

|

||||

|

||||

每个节点在启动后,会分配一个 UID,保存在 data 目录下。

|

||||

|

||||

### 节点类型

|

||||

|

||||

- **主节点(master node)**:每个节点都保存了集群的状态,只有 master 节点才能修改集群的状态信息(保证数据一致性)。**集群状态**,维护了以下信息:

|

||||

- 所有的节点信息

|

||||

- 所有的索引和其相关的 mapping 和 setting 信息

|

||||

- 分片的路由信息

|

||||

- **候选节点(master eligible node)**:master eligible 节点可以参加选主流程。第一个启动的节点,会将自己选举为 mater 节点。

|

||||

- 每个节点启动后,默认为 master eligible 节点,可以通过配置 `node.master: false` 禁止

|

||||

- **数据节点(data node)**:负责保存分片数据。

|

||||

- **协调节点(coordinating node)**:负责接收客户端的请求,将请求分发到合适的接地那,最终把结果汇集到一起。每个 Elasticsearch 节点默认都是协调节点(coordinating node)。

|

||||

- **冷/热节点(warm/hot node)**:针对不同硬件配置的数据节点(data node),用来实现 Hot & Warm 架构,降低集群部署的成本。

|

||||

- **机器学习节点(machine learning node)**:负责执行机器学习的 Job,用来做异常检测。

|

||||

|

||||

### 节点配置

|

||||

|

||||

| 配置参数 | 默认值 | 说明 |

|

||||

| ----------- | ------ | ------------------------------------- |

|

||||

| node.master | true | 是否为主节点 |

|

||||

| node.data | true | 是否为数据节点 |

|

||||

| node.ingest | true | |

|

||||

| node.ml | true | 是否为机器学习节点(需要开启 x-pack) |

|

||||

|

||||

> **建议**

|

||||

>

|

||||

> 开发环境中一个节点可以承担多种角色。但是,在生产环境中,节点应该设置为单一角色。

|

||||

|

||||

## 集群

|

||||

|

||||

### 集群简介

|

||||

|

||||

拥有相同 `cluster.name` 配置的 Elasticsearch 节点组成一个**集群**。 `cluster.name` 默认名为 `elasticsearch`,可以通过配置文件修改,或启动时通过 `-E cluster.name=xxx` 指定。

|

||||

|

||||

当有节点加入集群中或者从集群中移除节点时,集群将会重新平均分布所有的数据。

|

||||

|

||||

当一个节点被选举成为主节点时,它将负责管理集群范围内的所有变更,例如增加、删除索引,或者增加、删除节点等。 而主节点并不需要涉及到文档级别的变更和搜索等操作,所以当集群只拥有一个主节点的情况下,即使流量增加,它也不会成为瓶颈。 任何节点都可以成为主节点。

|

||||

|

||||

作为用户,我们可以将请求发送到集群中的任何节点 ,包括主节点。 每个节点都知道任意文档所处的位置,并且能够将我们的请求直接转发到存储我们所需文档的节点。 无论我们将请求发送到哪个节点,它都能负责从各个包含我们所需文档的节点收集回数据,并将最终结果返回給客户端。 Elasticsearch 对这一切的管理都是透明的。

|

||||

|

||||

### 集群健康

|

||||

|

||||

Elasticsearch 的集群监控信息中包含了许多的统计数据,其中最为重要的一项就是 _集群健康_ , 它在 `status` 字段中展示为 `green` 、 `yellow` 或者 `red` 。

|

||||

|

||||

在一个不包含任何索引的空集群中,它将会有一个类似于如下所示的返回内容:

|

||||

|

||||

```js

|

||||

{

|

||||

"cluster_name" : "elasticsearch",

|

||||

"status" : "green",

|

||||

"timed_out" : false,

|

||||

"number_of_nodes" : 1,

|

||||

"number_of_data_nodes" : 1,

|

||||

"active_primary_shards" : 5,

|

||||

"active_shards" : 5,

|

||||

"relocating_shards" : 0,

|

||||

"initializing_shards" : 0,

|

||||

"unassigned_shards" : 0,

|

||||

"delayed_unassigned_shards" : 0,

|

||||

"number_of_pending_tasks" : 0,

|

||||

"number_of_in_flight_fetch" : 0,

|

||||

"task_max_waiting_in_queue_millis" : 0,

|

||||

"active_shards_percent_as_number" : 100.0

|

||||

}

|

||||

```

|

||||

|

||||

`status` 字段指示着当前集群在总体上是否工作正常。它的三种颜色含义如下:

|

||||

|

||||

- **`green`**:所有的主分片和副本分片都正常运行。

|

||||

- **`yellow`**:所有的主分片都正常运行,但不是所有的副本分片都正常运行。

|

||||

- **`red`**:有主分片没能正常运行。

|

||||

|

||||

## 分片

|

||||

|

||||

### 分片简介

|

||||

|

||||

索引实际上是指向一个或者多个**物理分片**的**逻辑命名空间** 。

|

||||

|

||||

一个分片是一个底层的工作单元 ,它仅保存了全部数据中的一部分。一个分片可以视为一个 Lucene 的实例,并且它本身就是一个完整的搜索引擎。 我们的文档被存储和索引到分片内,但是应用程序是直接与索引而不是与分片进行交互。

|

||||

|

||||

Elasticsearch 是利用分片将数据分发到集群内各处的。分片是数据的容器,文档保存在分片内,分片又被分配到集群内的各个节点里。 当你的集群规模扩大或者缩小时, Elasticsearch 会自动的在各节点中迁移分片,使得数据仍然均匀分布在集群里。

|

||||

|

||||

### 主分片和副分片

|

||||

|

||||

分片分为主分片(Primary Shard)和副分片(Replica Shard)。

|

||||

|

||||

主分片:用于解决数据水平扩展的问题。通过主分片,可以将数据分布到集群内不同节点上。

|

||||

|

||||

- 索引内任意一个文档都归属于一个主分片。

|

||||

- 主分片数在索引创建时指定,后序不允许修改,除非 Reindex

|

||||

|

||||

副分片(Replica Shard):用于解决数据高可用的问题。副分片是主分片的拷贝。副本分片作为硬件故障时保护数据不丢失的冗余备份,并为搜索和返回文档等读操作提供服务。

|

||||

|

||||

- 副分片数可以动态调整

|

||||

- 增加副本数,还可以在一定程度上提高服务的可用性(读取的吞吐)

|

||||

|

||||

对于生产环境中分片的设定,需要提前做好容量规划

|

||||

|

||||

分片数过小

|

||||

|

||||

- 无法水平扩展

|

||||

- 单个分片的数量太大,导致数据重新分配耗时

|

||||

|

||||

分片数过大

|

||||

|

||||

- 影响搜索结果的相关性打分,影响统计结果的准确性

|

||||

- 单节点上过多的分片,会导致资源浪费,同时也会影响性能

|

||||

|

||||

### 故障转移

|

||||

|

||||

当集群中只有一个节点运行时,意味着存在单点故障问题——没有冗余。

|

||||

|

||||

## 参考资料

|

||||

|

||||

- [Elasticsearch 官网](https://www.elastic.co/)

|

||||

- [Elasticsearch 索引映射类型及 mapping 属性详解](https://www.knowledgedict.com/tutorial/elasticsearch-index-mapping.html)

|

||||

|

|

@ -2,11 +2,44 @@

|

|||

|

||||

Elasticsearch 是当前流行的企业级搜索引擎,设计用于云计算中,能够达到实时搜索,稳定,可靠,快速,安装使用方便。作为一个开箱即用的产品,在生产环境上线之后,我们其实不一定能确保其的性能和稳定性。如何根据实际情况提高服务的性能,其实有很多技巧。这章我们分享从实战经验中总结出来的 elasticsearch 性能优化,主要从硬件配置优化、索引优化设置、查询方面优化、数据结构优化、集群架构优化等方面讲解。

|

||||

|

||||

## 硬件配置优化

|

||||

<!-- TOC depthFrom:2 depthTo:3 -->

|

||||

|

||||

- [1. 硬件配置优化](#1-硬件配置优化)

|

||||

- [1.1. CPU 配置](#11-cpu-配置)

|

||||

- [1.2. 内存配置](#12-内存配置)

|

||||

- [1.3. 磁盘](#13-磁盘)

|

||||

- [2. 索引优化设置](#2-索引优化设置)

|

||||

- [2.1. 批量提交](#21-批量提交)

|

||||

- [2.2. 增加 Refresh 时间间隔](#22-增加-refresh-时间间隔)

|

||||

- [2.3. 修改 index_buffer_size 的设置](#23-修改-index_buffer_size-的设置)

|

||||

- [2.4. 修改 translog 相关的设置](#24-修改-translog-相关的设置)

|

||||

- [2.5. 注意 \_id 字段的使用](#25-注意-_id-字段的使用)

|

||||

- [2.6. 注意 \_all 字段及 \_source 字段的使用](#26-注意-_all-字段及-_source-字段的使用)

|

||||

- [2.7. 合理的配置使用 index 属性](#27-合理的配置使用-index-属性)

|

||||

- [2.8. 减少副本数量](#28-减少副本数量)

|

||||

- [3. 查询方面优化](#3-查询方面优化)

|

||||

- [3.1. 路由优化](#31-路由优化)

|

||||

- [3.2. Filter VS Query](#32-filter-vs-query)

|

||||

- [3.3. 深度翻页](#33-深度翻页)

|

||||

- [3.4. 脚本(script)合理使用](#34-脚本script合理使用)

|

||||

- [4. 数据结构优化](#4-数据结构优化)

|

||||

- [4.1. 尽量减少不需要的字段](#41-尽量减少不需要的字段)

|

||||

- [4.2. Nested Object vs Parent/Child](#42-nested-object-vs-parentchild)

|

||||

- [4.3. 选择静态映射,非必需时,禁止动态映射](#43-选择静态映射非必需时禁止动态映射)

|

||||

- [5. 集群架构设计](#5-集群架构设计)

|

||||

- [5.1. 主节点、数据节点和协调节点分离](#51-主节点数据节点和协调节点分离)

|

||||

- [5.2. 关闭 data 节点服务器中的 http 功能](#52-关闭-data-节点服务器中的-http-功能)

|

||||

- [5.3. 一台服务器上最好只部署一个 node](#53-一台服务器上最好只部署一个-node)

|

||||

- [5.4. 集群分片设置](#54-集群分片设置)

|

||||

- [6. 参考资料](#6-参考资料)

|

||||

|

||||

<!-- /TOC -->

|

||||

|

||||

## 1. 硬件配置优化

|

||||

|

||||

升级硬件设备配置一直都是提高服务能力最快速有效的手段,在系统层面能够影响应用性能的一般包括三个因素:CPU、内存和 IO,可以从这三方面进行 ES 的性能优化工作。

|

||||

|

||||

### CPU 配置

|

||||

### 1.1. CPU 配置

|

||||

|

||||

一般说来,CPU 繁忙的原因有以下几个:

|

||||

|

||||

|

|

@ -16,7 +49,7 @@ Elasticsearch 是当前流行的企业级搜索引擎,设计用于云计算中

|

|||

|

||||

大多数 Elasticsearch 部署往往对 CPU 要求不高。因此,相对其它资源,具体配置多少个(CPU)不是那么关键。你应该选择具有多个内核的现代处理器,常见的集群使用 2 到 8 个核的机器。**如果你要在更快的 CPUs 和更多的核数之间选择,选择更多的核数更好**。多个内核提供的额外并发远胜过稍微快一点点的时钟频率。

|

||||

|

||||

### 内存配置

|

||||

### 1.2. 内存配置

|

||||

|

||||

如果有一种资源是最先被耗尽的,它可能是内存。排序和聚合都很耗内存,所以有足够的堆空间来应付它们是很重要的。即使堆空间是比较小的时候,也能为操作系统文件缓存提供额外的内存。因为 Lucene 使用的许多数据结构是基于磁盘的格式,Elasticsearch 利用操作系统缓存能产生很大效果。

|

||||

|

||||

|

|

@ -44,7 +77,7 @@ Elasticsearch 是当前流行的企业级搜索引擎,设计用于云计算中

|

|||

|

||||

保持线程池的现有设置,目前 ES 的线程池较 1.X 有了较多优化设置,保持现状即可;默认线程池大小等于 CPU 核心数。如果一定要改,按公式 ( ( CPU 核心数 \* 3 ) / 2 ) + 1 设置;不能超过 CPU 核心数的 2 倍;但是不建议修改默认配置,否则会对 CPU 造成硬伤。

|

||||

|

||||

### 磁盘

|

||||

### 1.3. 磁盘

|

||||

|

||||

硬盘对所有的集群都很重要,对大量写入的集群更是加倍重要(例如那些存储日志数据的)。硬盘是服务器上最慢的子系统,这意味着那些写入量很大的集群很容易让硬盘饱和,使得它成为集群的瓶颈。

|

||||

|

||||

|

|

@ -64,11 +97,11 @@ Elasticsearch 是当前流行的企业级搜索引擎,设计用于云计算中

|

|||

|

||||

**最后,避免使用网络附加存储(NAS)**。人们常声称他们的 NAS 解决方案比本地驱动器更快更可靠。除却这些声称,我们从没看到 NAS 能配得上它的大肆宣传。NAS 常常很慢,显露出更大的延时和更宽的平均延时方差,而且它是单点故障的。

|

||||

|

||||

## 索引优化设置

|

||||

## 2. 索引优化设置

|

||||

|

||||

索引优化主要是在 Elasticsearch 的插入层面优化,Elasticsearch 本身索引速度其实还是蛮快的,具体数据,我们可以参考官方的 benchmark 数据。我们可以根据不同的需求,针对索引优化。

|

||||

|

||||

### 批量提交

|

||||

### 2.1. 批量提交

|

||||

|

||||

当有大量数据提交的时候,建议采用批量提交(Bulk 操作);此外使用 bulk 请求时,每个请求不超过几十 M,因为太大会导致内存使用过大。

|

||||

|

||||

|

|

@ -78,7 +111,7 @@ Elasticsearch 是当前流行的企业级搜索引擎,设计用于云计算中

|

|||

|

||||

如果在提交过程中,遇到 EsRejectedExecutionException 异常的话,则说明集群的索引性能已经达到极限了。这种情况,要么提高服务器集群的资源,要么根据业务规则,减少数据收集速度,比如只收集 Warn、Error 级别以上的日志。

|

||||

|

||||

### 增加 Refresh 时间间隔

|

||||

### 2.2. 增加 Refresh 时间间隔

|

||||

|

||||

为了提高索引性能,Elasticsearch 在写入数据的时候,采用延迟写入的策略,即数据先写到内存中,当超过默认 1 秒(index.refresh_interval)会进行一次写入操作,就是将内存中 segment 数据刷新到磁盘中,此时我们才能将数据搜索出来,所以这就是为什么 Elasticsearch 提供的是近实时搜索功能,而不是实时搜索功能。

|

||||

|

||||

|

|

@ -86,7 +119,7 @@ Elasticsearch 是当前流行的企业级搜索引擎,设计用于云计算中

|

|||

|

||||

> 在加载大量数据时候可以暂时不用 refresh 和 repliccas,index.refresh_interval 设置为-1,index.number_of_replicas 设置为 0。

|

||||

|

||||

### 修改 index_buffer_size 的设置

|

||||

### 2.3. 修改 index_buffer_size 的设置

|

||||

|

||||

索引缓冲的设置可以控制多少内存分配给索引进程。这是一个全局配置,会应用于一个节点上所有不同的分片上。

|

||||

|

||||

|

|

@ -97,7 +130,7 @@ indices.memory.min_index_buffer_size: 48mb

|

|||

|

||||

`indices.memory.index_buffer_size` 接受一个百分比或者一个表示字节大小的值。默认是 10%,意味着分配给节点的总内存的 10%用来做索引缓冲的大小。这个数值被分到不同的分片(shards)上。如果设置的是百分比,还可以设置 `min_index_buffer_size` (默认 48mb)和 `max_index_buffer_size`(默认没有上限)。

|

||||

|

||||

### 修改 translog 相关的设置

|

||||

### 2.4. 修改 translog 相关的设置

|

||||

|

||||

一是控制数据从内存到硬盘的操作频率,以减少硬盘 IO。可将 sync_interval 的时间设置大一些。默认为 5s。

|

||||

|

||||

|

|

@ -111,29 +144,29 @@ index.translog.sync_interval: 5s

|

|||

index.translog.flush_threshold_size: 512mb

|

||||

```

|

||||

|

||||

### 注意 \_id 字段的使用

|

||||

### 2.5. 注意 \_id 字段的使用

|

||||

|

||||

\_id 字段的使用,应尽可能避免自定义 \_id,以避免针对 ID 的版本管理;建议使用 ES 的默认 ID 生成策略或使用数字类型 ID 做为主键。

|

||||

|

||||

### 注意 \_all 字段及 \_source 字段的使用

|

||||

### 2.6. 注意 \_all 字段及 \_source 字段的使用

|

||||

|

||||

**\_**all 字段及 \_source 字段的使用,应该注意场景和需要,\_all 字段包含了所有的索引字段,方便做全文检索,如果无此需求,可以禁用;\_source 存储了原始的 document 内容,如果没有获取原始文档数据的需求,可通过设置 includes、excludes 属性来定义放入 \_source 的字段。

|

||||

|

||||

### 合理的配置使用 index 属性

|

||||

### 2.7. 合理的配置使用 index 属性

|

||||

|

||||

合理的配置使用 index 属性,analyzed 和 not_analyzed,根据业务需求来控制字段是否分词或不分词。只有 groupby 需求的字段,配置时就设置成 not_analyzed,以提高查询或聚类的效率。

|

||||

|

||||

### 减少副本数量

|

||||

### 2.8. 减少副本数量

|

||||

|

||||

Elasticsearch 默认副本数量为 3 个,虽然这样会提高集群的可用性,增加搜索的并发数,但是同时也会影响写入索引的效率。

|

||||

|

||||

在索引过程中,需要把更新的文档发到副本节点上,等副本节点生效后在进行返回结束。使用 Elasticsearch 做业务搜索的时候,建议副本数目还是设置为 3 个,但是像内部 ELK 日志系统、分布式跟踪系统中,完全可以将副本数目设置为 1 个。

|

||||

|

||||

## 查询方面优化

|

||||

## 3. 查询方面优化

|

||||

|

||||

Elasticsearch 作为业务搜索的近实时查询时,查询效率的优化显得尤为重要。

|

||||

|

||||

### 路由优化

|

||||

### 3.1. 路由优化

|

||||

|

||||

当我们查询文档的时候,Elasticsearch 如何知道一个文档应该存放到哪个分片中呢?它其实是通过下面这个公式来计算出来的。

|

||||

|

||||

|

|

@ -156,7 +189,7 @@ routing 默认值是文档的 id,也可以采用自定义值,比如用户 ID

|

|||

|

||||

向上面自定义的用户查询,如果 routing 设置为 userid 的话,就可以直接查询出数据来,效率提升很多。

|

||||

|

||||

### Filter VS Query

|

||||

### 3.2. Filter VS Query

|

||||

|

||||

尽可能使用过滤器上下文(Filter)替代查询上下文(Query)

|