Merge branch 'jackfrued:master' into master

commit

b80b7ca781

|

|

@ -934,7 +934,7 @@ alter table tb_student drop index idx_student_name;

|

|||

drop index idx_student_name on tb_student;

|

||||

```

|

||||

|

||||

在创建索引时,我们还可以使用复合索引、函数索引(MySQL 5.7 开始支持),用好复合索引可以减少不必要的排序和回表操作,这样就会让查询的性能成倍的提升,有兴趣的读者可以自行研究。

|

||||

在创建索引时,我们还可以使用复合索引、函数索引(MySQL 5.7 开始支持),用好复合索引实现**索引覆盖**可以减少不必要的排序和回表操作,这样就会让查询的性能成倍的提升,有兴趣的读者可以自行研究。

|

||||

|

||||

我们简单的为大家总结一下索引的设计原则:

|

||||

|

||||

|

|

@ -0,0 +1,661 @@

|

|||

## 深入MySQL

|

||||

|

||||

### 索引

|

||||

|

||||

索引是关系型数据库中用来提升查询性能最为重要的手段。关系型数据库中的索引就像一本书的目录,我们可以想象一下,如果要从一本书中找出某个知识点,但是这本书没有目录,这将是意见多么可怕的事情!我们估计得一篇一篇的翻下去,才能确定这个知识点到底在什么位置。创建索引虽然会带来存储空间上的开销,就像一本书的目录会占用一部分篇幅一样,但是在牺牲空间后换来的查询时间的减少也是非常显著的。

|

||||

|

||||

MySQL 数据库中所有数据类型的列都可以被索引。对于MySQL 8.0 版本的 InnoDB 存储引擎来说,它支持三种类型的索引,分别是 B+ 树索引、全文索引和 R 树索引。这里,我们只介绍使用得最为广泛的 B+ 树索引。使用 B+ 树的原因非常简单,因为它是目前在基于磁盘进行海量数据存储和排序上最有效率的数据结构。B+ 树是一棵[平衡树](https://zh.wikipedia.org/zh-cn/%E5%B9%B3%E8%A1%A1%E6%A0%91),树的高度通常为3或4,但是却可以保存从百万级到十亿级的数据,而从这些数据里面查询一条数据,只需要3次或4次 I/O 操作。

|

||||

|

||||

B+ 树由根节点、中间节点和叶子节点构成,其中叶子节点用来保存排序后的数据。由于记录在索引上是排序过的,因此在一个叶子节点内查找数据时可以使用二分查找,这种查找方式效率非常的高。当数据很少的时候,B+ 树只有一个根节点,数据也就保存在根节点上。随着记录越来越多,B+ 树会发生分裂,根节点不再保存数据,而是提供了访问下一层节点的指针,帮助快速确定数据在哪个叶子节点上。

|

||||

|

||||

在创建二维表时,我们通常都会为表指定主键列,主键列上默认会创建索引,而对于 MySQL InnoDB 存储引擎来说,因为它使用的是索引组织表这种数据存储结构,所以主键上的索引就是整张表的数据,而这种索引我们也将其称之为**聚集索引**(clustered index)。很显然,一张表只能有一个聚集索引,否则表的数据岂不是要保存多次。我们自己创建的索引都是二级索引(secondary index),更常见的叫法是**非聚集索引**(non-clustered index)。通过我们自定义的非聚集索引只能定位记录的主键,在获取数据时可能需要再通过主键上的聚集索引进行查询,这种现象称为“回表”,因此通过非聚集索引检索数据通常比使用聚集索引检索数据要慢。

|

||||

|

||||

接下来我们通过一个简单的例子来说明索引的意义,比如我们要根据学生的姓名来查找学生,这个场景在实际开发中应该经常遇到,就跟通过商品名称查找商品是一个道理。我们可以使用 MySQL 的`explain`关键字来查看 SQL 的执行计划(数据库执行 SQL 语句的具体步骤)。

|

||||

|

||||

```SQL

|

||||

explain select * from tb_student where stuname='林震南'\G

|

||||

```

|

||||

|

||||

```

|

||||

*************************** 1. row ***************************

|

||||

id: 1

|

||||

select_type: SIMPLE

|

||||

table: tb_student

|

||||

partitions: NULL

|

||||

type: ALL

|

||||

possible_keys: NULL

|

||||

key: NULL

|

||||

key_len: NULL

|

||||

ref: NULL

|

||||

rows: 11

|

||||

filtered: 10.00

|

||||

Extra: Using where

|

||||

1 row in set, 1 warning (0.00 sec)

|

||||

```

|

||||

|

||||

在上面的 SQL 执行计划中,有几项值得我们关注:

|

||||

|

||||

1. `select_type`:查询的类型。

|

||||

- `SIMPLE`:简单 SELECT,不需要使用 UNION 操作或子查询。

|

||||

- `PRIMARY`:如果查询包含子查询,最外层的 SELECT 被标记为 PRIMARY。

|

||||

- `UNION`:UNION 操作中第二个或后面的 SELECT 语句。

|

||||

- `SUBQUERY`:子查询中的第一个 SELECT。

|

||||

- `DERIVED`:派生表的 SELECT 子查询。

|

||||

2. `table`:查询对应的表。

|

||||

3. `type`:MySQL 在表中找到满足条件的行的方式,也称为访问类型,包括:`ALL`(全表扫描)、`index`(索引全扫描,只遍历索引树)、`range`(索引范围扫描)、`ref`(非唯一索引扫描)、`eq_ref`(唯一索引扫描)、`const` / `system`(常量级查询)、`NULL`(不需要访问表或索引)。在所有的访问类型中,很显然 ALL 是性能最差的,它代表的全表扫描是指要扫描表中的每一行才能找到匹配的行。

|

||||

4. `possible_keys`:MySQL 可以选择的索引,但是**有可能不会使用**。

|

||||

5. `key`:MySQL 真正使用的索引,如果为`NULL`就表示没有使用索引。

|

||||

6. `key_len`:使用的索引的长度,在不影响查询的情况下肯定是长度越短越好。

|

||||

7. `rows`:执行查询需要扫描的行数,这是一个**预估值**。

|

||||

8. `extra`:关于查询额外的信息。

|

||||

- `Using filesort`:MySQL 无法利用索引完成排序操作。

|

||||

- `Using index`:只使用索引的信息而不需要进一步查表来获取更多的信息。

|

||||

- `Using temporary`:MySQL 需要使用临时表来存储结果集,常用于分组和排序。

|

||||

- `Impossible where`:`where`子句会导致没有符合条件的行。

|

||||

- `Distinct`:MySQL 发现第一个匹配行后,停止为当前的行组合搜索更多的行。

|

||||

- `Using where`:查询的列未被索引覆盖,筛选条件并不是索引的前导列。

|

||||

|

||||

从上面的执行计划可以看出,当我们通过学生名字查询学生时实际上是进行了全表扫描,不言而喻这个查询性能肯定是非常糟糕的,尤其是在表中的行很多的时候。如果我们需要经常通过学生姓名来查询学生,那么就应该在学生姓名对应的列上创建索引,通过索引来加速查询。

|

||||

|

||||

```SQL

|

||||

create index idx_student_name on tb_student(stuname);

|

||||

```

|

||||

|

||||

再次查看刚才的 SQL 对应的执行计划。

|

||||

|

||||

```SQL

|

||||

explain select * from tb_student where stuname='林震南'\G

|

||||

```

|

||||

|

||||

```

|

||||

*************************** 1. row ***************************

|

||||

id: 1

|

||||

select_type: SIMPLE

|

||||

table: tb_student

|

||||

partitions: NULL

|

||||

type: ref

|

||||

possible_keys: idx_student_name

|

||||

key: idx_student_name

|

||||

key_len: 62

|

||||

ref: const

|

||||

rows: 1

|

||||

filtered: 100.00

|

||||

Extra: NULL

|

||||

1 row in set, 1 warning (0.00 sec)

|

||||

```

|

||||

|

||||

可以注意到,在对学生姓名创建索引后,刚才的查询已经不是全表扫描而是基于索引的查询,而且扫描的行只有唯一的一行,这显然大大的提升了查询的性能。MySQL 中还允许创建前缀索引,即对索引字段的前N个字符创建索引,这样的话可以减少索引占用的空间(但节省了空间很有可能会浪费时间,**时间和空间是不可调和的矛盾**),如下所示。

|

||||

|

||||

```SQL

|

||||

create index idx_student_name_1 on tb_student(stuname(1));

|

||||

```

|

||||

|

||||

上面的索引相当于是根据学生姓名的第一个字来创建的索引,我们再看看 SQL 执行计划。

|

||||

|

||||

```SQL

|

||||

explain select * from tb_student where stuname='林震南'\G

|

||||

```

|

||||

|

||||

```

|

||||

*************************** 1. row ***************************

|

||||

id: 1

|

||||

select_type: SIMPLE

|

||||

table: tb_student

|

||||

partitions: NULL

|

||||

type: ref

|

||||

possible_keys: idx_student_name

|

||||

key: idx_student_name

|

||||

key_len: 5

|

||||

ref: const

|

||||

rows: 2

|

||||

filtered: 100.00

|

||||

Extra: Using where

|

||||

1 row in set, 1 warning (0.00 sec)

|

||||

```

|

||||

|

||||

不知道大家是否注意到,这一次扫描的行变成了2行,因为学生表中有两个姓“林”的学生,我们只用姓名的第一个字作为索引的话,在查询时通过索引就会找到这两行。

|

||||

|

||||

如果要删除索引,可以使用下面的SQL。

|

||||

|

||||

```SQL

|

||||

alter table tb_student drop index idx_student_name;

|

||||

```

|

||||

|

||||

或者

|

||||

|

||||

```SQL

|

||||

drop index idx_student_name on tb_student;

|

||||

```

|

||||

|

||||

在创建索引时,我们还可以使用复合索引、函数索引(MySQL 5.7 开始支持),用好复合索引实现**索引覆盖**可以减少不必要的排序和回表操作,这样就会让查询的性能成倍的提升,有兴趣的读者可以自行研究。

|

||||

|

||||

我们简单的为大家总结一下索引的设计原则:

|

||||

|

||||

1. **最适合**索引的列是出现在**WHERE子句**和连接子句中的列。

|

||||

2. 索引列的基数越大(取值多、重复值少),索引的效果就越好。

|

||||

3. 使用**前缀索引**可以减少索引占用的空间,内存中可以缓存更多的索引。

|

||||

4. **索引不是越多越好**,虽然索引加速了读操作(查询),但是写操作(增、删、改)都会变得更慢,因为数据的变化会导致索引的更新,就如同书籍章节的增删需要更新目录一样。

|

||||

5. 使用 InnoDB 存储引擎时,表的普通索引都会保存主键的值,所以**主键要尽可能选择较短的数据类型**,这样可以有效的减少索引占用的空间,提升索引的缓存效果。

|

||||

|

||||

最后,还有一点需要说明,InnoDB 使用的 B-tree 索引,数值类型的列除了等值判断时索引会生效之外,使用`>`、`<`、`>=`、`<=`、`BETWEEN...AND... `、`<>`时,索引仍然生效;对于字符串类型的列,如果使用不以通配符开头的模糊查询,索引也是起作用的,但是其他的情况会导致索引失效,这就意味着很有可能会做全表查询。

|

||||

|

||||

### 视图

|

||||

|

||||

视图是关系型数据库中将一组查询指令构成的结果集组合成可查询的数据表的对象。简单的说,视图就是虚拟的表,但与数据表不同的是,数据表是一种实体结构,而视图是一种虚拟结构,你也可以将视图理解为保存在数据库中被赋予名字的 SQL 语句。

|

||||

|

||||

使用视图可以获得以下好处:

|

||||

|

||||

1. 可以将实体数据表隐藏起来,让外部程序无法得知实际的数据结构,让访问者可以使用表的组成部分而不是整个表,降低数据库被攻击的风险。

|

||||

2. 在大多数的情况下视图是只读的(更新视图的操作通常都有诸多的限制),外部程序无法直接透过视图修改数据。

|

||||

3. 重用 SQL 语句,将高度复杂的查询包装在视图表中,直接访问该视图即可取出需要的数据;也可以将视图视为数据表进行连接查询。

|

||||

4. 视图可以返回与实体数据表不同格式的数据,在创建视图的时候可以对数据进行格式化处理。

|

||||

|

||||

创建视图。

|

||||

|

||||

```SQL

|

||||

-- 创建视图

|

||||

create view `vw_avg_score`

|

||||

as

|

||||

select `stu_id`, round(avg(`score`), 1) as `avg_score`

|

||||

from `tb_record` group by `stu_id`;

|

||||

|

||||

-- 基于已有的视图创建视图

|

||||

create view `vw_student_score`

|

||||

as

|

||||

select `stu_name`, `avg_score`

|

||||

from `tb_student` natural join `vw_avg_score`;

|

||||

```

|

||||

|

||||

> **提示**:因为视图不包含数据,所以每次使用视图时,都必须执行查询以获得数据,如果你使用了连接查询、嵌套查询创建了较为复杂的视图,你可能会发现查询性能下降得很厉害。因此,在使用复杂的视图前,应该进行测试以确保其性能能够满足应用的需求。

|

||||

|

||||

使用视图。

|

||||

|

||||

```SQL

|

||||

select * from `vw_student_score` order by `avg_score` desc;

|

||||

```

|

||||

|

||||

```

|

||||

+--------------+----------+

|

||||

| stuname | avgscore |

|

||||

+--------------+----------+

|

||||

| 杨过 | 95.6 |

|

||||

| 任我行 | 53.5 |

|

||||

| 王语嫣 | 84.3 |

|

||||

| 纪嫣然 | 73.8 |

|

||||

| 岳不群 | 78.0 |

|

||||

| 东方不败 | 88.0 |

|

||||

| 项少龙 | 92.0 |

|

||||

+--------------+----------+

|

||||

```

|

||||

|

||||

既然视图是一张虚拟的表,那么视图的中的数据可以更新吗?视图的可更新性要视具体情况而定,以下类型的视图是不能更新的:

|

||||

|

||||

1. 使用了聚合函数(`SUM`、`MIN`、`MAX`、`AVG`、`COUNT`等)、`DISTINCT`、`GROUP BY`、`HAVING`、`UNION`或者`UNION ALL`的视图。

|

||||

2. `SELECT`中包含了子查询的视图。

|

||||

3. `FROM`子句中包含了一个不能更新的视图的视图。

|

||||

4. `WHERE`子句的子查询引用了`FROM`子句中的表的视图。

|

||||

|

||||

删除视图。

|

||||

|

||||

```SQL

|

||||

drop view vw_student_score;

|

||||

```

|

||||

|

||||

> **说明**:如果希望更新视图,可以先用上面的命令删除视图,也可以通过`create or replace view`来更新视图。

|

||||

|

||||

视图的规则和限制。

|

||||

|

||||

1. 视图可以嵌套,可以利用从其他视图中检索的数据来构造一个新的视图。视图也可以和表一起使用。

|

||||

2. 创建视图时可以使用`order by`子句,但如果从视图中检索数据时也使用了`order by`,那么该视图中原先的`order by`会被覆盖。

|

||||

3. 视图无法使用索引,也不会激发触发器(实际开发中因为性能等各方面的考虑,通常不建议使用触发器,所以我们也不对这个概念进行介绍)的执行。

|

||||

|

||||

### 函数

|

||||

|

||||

MySQL 中的函数跟 Python 中的函数太多的差异,因为函数都是用来封装功能上相对独立且会被重复使用的代码的。如果非要找出一些差别来,那么 MySQL 中的函数是可以执行 SQL 语句的。下面的例子,我们通过自定义函数实现了截断超长字符串的功能。

|

||||

|

||||

```SQL

|

||||

delimiter $$

|

||||

|

||||

create function truncate_string(

|

||||

content varchar(10000),

|

||||

max_length int unsigned

|

||||

) returns varchar(10000) no sql

|

||||

begin

|

||||

declare result varchar(10000) default content;

|

||||

if char_length(content) > max_length then

|

||||

set result = left(content, max_length);

|

||||

set result = concat(result, '……');

|

||||

end if;

|

||||

return result;

|

||||

end $$

|

||||

|

||||

delimiter ;

|

||||

```

|

||||

|

||||

> **说明1**:函数声明后面的`no sql`是声明函数体并没有使用 SQL 语句;如果函数体中需要通过 SQL 读取数据,需要声明为`reads sql data`。

|

||||

>

|

||||

> **说明2**:定义函数前后的`delimiter`命令是为了修改定界符,因为函数体中的语句都是用`;`表示结束,如果不重新定义定界符,那么遇到的`;`的时候代码就会被截断执行,显然这不是我们想要的效果。

|

||||

|

||||

在查询中调用自定义函数。

|

||||

|

||||

```SQL

|

||||

select truncate_string('和我在成都的街头走一走,直到所有的灯都熄灭了也不停留', 10) as short_string;

|

||||

```

|

||||

|

||||

```

|

||||

+--------------------------------------+

|

||||

| short_string |

|

||||

+--------------------------------------+

|

||||

| 和我在成都的街头走一…… |

|

||||

+--------------------------------------+

|

||||

```

|

||||

|

||||

### 过程

|

||||

|

||||

过程(又称存储过程)是事先编译好存储在数据库中的一组 SQL 的集合,调用过程可以简化应用程序开发人员的工作,减少与数据库服务器之间的通信,对于提升数据操作的性能也是有帮助的。其实迄今为止,我们使用的 SQL 语句都是针对一个或多个表的单条语句,但在实际开发中经常会遇到某个操作需要多条 SQL 语句才能完成的情况。例如,电商网站在受理用户订单时,需要做以下一系列的处理。

|

||||

|

||||

1. 通过查询来核对库存中是否有对应的物品以及库存是否充足。

|

||||

2. 如果库存有物品,需要锁定库存以确保这些物品不再卖给别人, 并且要减少可用的物品数量以反映正确的库存量。

|

||||

3. 如果库存不足,可能需要进一步与供应商进行交互或者至少产生一条系统提示消息。

|

||||

4. 不管受理订单是否成功,都需要产生流水记录,而且需要给对应的用户产生一条通知信息。

|

||||

|

||||

我们可以通过过程将复杂的操作封装起来,这样不仅有助于保证数据的一致性,而且将来如果业务发生了变动,只需要调整和修改过程即可。对于调用过程的用户来说,过程并没有暴露数据表的细节,而且执行过程比一条条的执行一组 SQL 要快得多。

|

||||

|

||||

下面的过程实现了查询某门课程的最高分、最低分和平均分。

|

||||

|

||||

```SQL

|

||||

drop procedure if exists sp_score_stat;

|

||||

|

||||

delimiter $$

|

||||

|

||||

create procedure sp_score_stat(

|

||||

courseId int,

|

||||

out maxScore decimal(4,1),

|

||||

out minScore decimal(4,1),

|

||||

out avgScore decimal(4,1)

|

||||

)

|

||||

begin

|

||||

select max(score) into maxScore from tb_record where cou_id=courseId;

|

||||

select min(score) into minScore from tb_record where cou_id=courseId;

|

||||

select avg(score) into avgScore from tb_record where cou_id=courseId;

|

||||

end $$

|

||||

|

||||

delimiter ;

|

||||

```

|

||||

|

||||

> **说明**:在定义过程时,因为可能需要书写多条 SQL,而分隔这些 SQL 需要使用分号作为分隔符,如果这个时候,仍然用分号表示整段代码结束,那么定义过程的 SQL 就会出现错误,所以上面我们用`delimiter $$`将整段代码结束的标记定义为`$$`,那么代码中的分号将不再表示整段代码的结束,整段代码只会在遇到`end $$`时才会执行。在定义完过程后,通过`delimiter ;`将结束符重新改回成分号(恢复现场)。

|

||||

|

||||

上面定义的过程有四个参数,其中第一个参数是输入参数,代表课程的编号,后面的参数都是输出参数,因为过程不能定义返回值,只能通过输出参数将执行结果带出,定义输出参数的关键字是`out`,默认情况下参数都是输入参数。

|

||||

|

||||

调用过程。

|

||||

|

||||

```SQL

|

||||

call sp_score_stat(1111, @a, @b, @c);

|

||||

```

|

||||

|

||||

获取输出参数的值。

|

||||

|

||||

```SQL

|

||||

select @a as 最高分, @b as 最低分, @c as 平均分;

|

||||

```

|

||||

|

||||

删除过程。

|

||||

|

||||

```SQL

|

||||

drop procedure sp_score_stat;

|

||||

```

|

||||

|

||||

在过程中,我们可以定义变量、条件,可以使用分支和循环语句,可以通过游标操作查询结果,还可以使用事件调度器,这些内容我们暂时不在此处进行介绍。虽然我们说了很多过程的好处,但是在实际开发中,如果频繁的使用过程并将大量复杂的运算放到过程中,会给据库服务器造成巨大的压力,而数据库往往都是性能瓶颈所在,使用过程无疑是雪上加霜的操作。所以,对于互联网产品开发,我们一般建议让数据库只做好存储,复杂的运算和处理交给应用服务器上的程序去完成,如果应用服务器变得不堪重负了,我们可以比较容易的部署多台应用服务器来分摊这些压力。

|

||||

|

||||

如果大家对上面讲到的视图、函数、过程包括我们没有讲到的触发器这些知识有兴趣,建议大家阅读 MySQL 的入门读物[《MySQL必知必会》](https://item.jd.com/12818982.html)进行一般性了解即可,因为这些知识点在大家将来的工作中未必用得上,学了也可能仅仅是为了应付面试而已。

|

||||

|

||||

### MySQL 新特性

|

||||

|

||||

#### JSON类型

|

||||

|

||||

很多开发者在使用关系型数据库做数据持久化的时候,常常感到结构化的存储缺乏灵活性,因为必须事先设计好所有的列以及对应的数据类型。在业务发展和变化的过程中,如果需要修改表结构,这绝对是比较麻烦和难受的事情。从 MySQL 5.7 版本开始,MySQL引入了对 JSON 数据类型的支持(MySQL 8.0 解决了 JSON 的日志性能瓶颈问题),用好 JSON 类型,其实就是打破了关系型数据库和非关系型数据库之间的界限,为数据持久化操作带来了更多的便捷。

|

||||

|

||||

JSON 类型主要分为 JSON 对象和 JSON数组两种,如下所示。

|

||||

|

||||

1. JSON 对象

|

||||

|

||||

```JSON

|

||||

{"name": "骆昊", "tel": "13122335566", "QQ": "957658"}

|

||||

```

|

||||

|

||||

2. JSON 数组

|

||||

|

||||

```JSON

|

||||

[1, 2, 3]

|

||||

```

|

||||

|

||||

```JSON

|

||||

[{"name": "骆昊", "tel": "13122335566"}, {"name": "王大锤", "QQ": "123456"}]

|

||||

```

|

||||

|

||||

哪些地方需要用到JSON类型呢?举一个简单的例子,现在很多产品的用户登录都支持多种方式,例如手机号、微信、QQ、新浪微博等,但是一般情况下我们又不会要求用户提供所有的这些信息,那么用传统的设计方式,就需要设计多个列来对应多种登录方式,可能还需要允许这些列存在空值,这显然不是很好的选择;另一方面,如果产品又增加了一种登录方式,那么就必然要修改之前的表结构,这就更让人痛苦了。但是,有了 JSON 类型,刚才的问题就迎刃而解了,我们可以做出如下所示的设计。

|

||||

|

||||

```SQL

|

||||

create table `tb_test`

|

||||

(

|

||||

`user_id` bigint unsigned,

|

||||

`login_info` json,

|

||||

primary key (`user_id`)

|

||||

) engine=innodb;

|

||||

|

||||

insert into `tb_test` values

|

||||

(1, '{"tel": "13122335566", "QQ": "654321", "wechat": "jackfrued"}'),

|

||||

(2, '{"tel": "13599876543", "weibo": "wangdachui123"}');

|

||||

```

|

||||

|

||||

如果要查询用户的手机和微信号,可以用如下所示的 SQL 语句。

|

||||

|

||||

```SQL

|

||||

select

|

||||

`user_id`,

|

||||

json_unquote(json_extract(`login_info`, '$.tel')) as 手机号,

|

||||

json_unquote(json_extract(`login_info`, '$.wechat')) as 微信

|

||||

from `tb_test`;

|

||||

```

|

||||

|

||||

```

|

||||

+---------+-------------+-----------+

|

||||

| user_id | 手机号 | 微信 |

|

||||

+---------+-------------+-----------+

|

||||

| 1 | 13122335566 | jackfrued |

|

||||

| 2 | 13599876543 | NULL |

|

||||

+---------+-------------+-----------+

|

||||

```

|

||||

|

||||

因为支持 JSON 类型,MySQL 也提供了配套的处理 JSON 数据的函数,就像上面用到的`json_extract`和`json_unquote`。当然,上面的 SQL 还有更为便捷的写法,如下所示。

|

||||

|

||||

```SQL

|

||||

select

|

||||

`user_id`,

|

||||

`login_info` ->> '$.tel' as 手机号,

|

||||

`login_info` ->> '$.wechat' as 微信

|

||||

from `tb_test`;

|

||||

```

|

||||

|

||||

再举个例子,如果我们的产品要实现用户画像功能(给用户打标签),然后基于用户画像给用户推荐平台的服务或消费品之类的东西,我们也可以使用 JSON 类型来保存用户画像数据,示意代码如下所示。

|

||||

|

||||

创建画像标签表。

|

||||

|

||||

```SQL

|

||||

create table `tb_tags`

|

||||

(

|

||||

`tag_id` int unsigned not null comment '标签ID',

|

||||

`tag_name` varchar(20) not null comment '标签名',

|

||||

primary key (`tag_id`)

|

||||

) engine=innodb;

|

||||

|

||||

insert into `tb_tags` (`tag_id`, `tag_name`)

|

||||

values

|

||||

(1, '70后'),

|

||||

(2, '80后'),

|

||||

(3, '90后'),

|

||||

(4, '00后'),

|

||||

(5, '爱运动'),

|

||||

(6, '高学历'),

|

||||

(7, '小资'),

|

||||

(8, '有房'),

|

||||

(9, '有车'),

|

||||

(10, '爱看电影'),

|

||||

(11, '爱网购'),

|

||||

(12, '常点外卖');

|

||||

```

|

||||

|

||||

为用户打标签。

|

||||

|

||||

```SQL

|

||||

create table `tb_users_tags`

|

||||

(

|

||||

`user_id` bigint unsigned not null comment '用户ID',

|

||||

`user_tags` json not null comment '用户标签'

|

||||

) engine=innodb;

|

||||

|

||||

insert into `tb_users_tags` values

|

||||

(1, '[2, 6, 8, 10]'),

|

||||

(2, '[3, 10, 12]'),

|

||||

(3, '[3, 8, 9, 11]');

|

||||

```

|

||||

|

||||

接下来,我们通过一组查询来了解 JSON 类型的巧妙之处。

|

||||

|

||||

1. 查询爱看电影(有`10`这个标签)的用户ID。

|

||||

|

||||

```SQL

|

||||

select * from `tb_users` where 10 member of (user_tags->'$');

|

||||

```

|

||||

|

||||

2. 查询爱看电影(有`10`这个标签)的80后(有`2`这个标签)用户ID。

|

||||

|

||||

```

|

||||

select * from `tb_users` where json_contains(user_tags->'$', '[2, 10]');

|

||||

|

||||

3. 查询爱看电影或80后或90后的用户ID。

|

||||

|

||||

```SQL

|

||||

select `user_id` from `tb_users_tags` where json_overlaps(user_tags->'$', '[2, 3, 10]');

|

||||

```

|

||||

|

||||

> **说明**:上面的查询用到了`member of`谓词和两个 JSON 函数,`json_contains`可以检查 JSON 数组是否包含了指定的元素,而`json_overlaps`可以检查 JSON 数组是否与指定的数组有重叠部分。

|

||||

|

||||

#### 窗口函数

|

||||

|

||||

MySQL 从8.0开始支持窗口函数,大多数商业数据库和一些开源数据库早已提供了对窗口函数的支持,有的也将其称之为 OLAP(联机分析和处理)函数,听名字就知道跟统计和分析相关。为了帮助大家理解窗口函数,我们先说说窗口的概念。

|

||||

|

||||

窗口可以理解为记录的集合,窗口函数也就是在满足某种条件的记录集合上执行的特殊函数,对于每条记录都要在此窗口内执行函数。窗口函数和我们上面讲到的聚合函数比较容易混淆,二者的区别主要在于聚合函数是将多条记录聚合为一条记录,窗口函数是每条记录都会执行,执行后记录条数不会变。窗口函数不仅仅是几个函数,它是一套完整的语法,函数只是该语法的一部分,基本语法如下所示:

|

||||

|

||||

```SQL

|

||||

<窗口函数> over (partition by <用于分组的列名> order by <用户排序的列名>)

|

||||

```

|

||||

|

||||

上面语法中,窗口函数的位置可以放以下两种函数:

|

||||

|

||||

1. 专用窗口函数,包括:`lead`、`lag`、`first_value`、`last_value`、`rank`、`dense_rank`和`row_number`等。

|

||||

2. 聚合函数,包括:`sum`、`avg`、`max`、`min`和`count`等。

|

||||

|

||||

下面为大家举几个使用窗口函数的简单例子,我们先用如下所示的 SQL 建库建表。

|

||||

|

||||

```SQL

|

||||

-- 创建名为hrs的数据库并指定默认的字符集

|

||||

create database `hrs` default charset utf8mb4;

|

||||

|

||||

-- 切换到hrs数据库

|

||||

use `hrs`;

|

||||

|

||||

-- 创建部门表

|

||||

create table `tb_dept`

|

||||

(

|

||||

`dno` int not null comment '编号',

|

||||

`dname` varchar(10) not null comment '名称',

|

||||

`dloc` varchar(20) not null comment '所在地',

|

||||

primary key (`dno`)

|

||||

);

|

||||

|

||||

-- 插入4个部门

|

||||

insert into `tb_dept` values

|

||||

(10, '会计部', '北京'),

|

||||

(20, '研发部', '成都'),

|

||||

(30, '销售部', '重庆'),

|

||||

(40, '运维部', '深圳');

|

||||

|

||||

-- 创建员工表

|

||||

create table `tb_emp`

|

||||

(

|

||||

`eno` int not null comment '员工编号',

|

||||

`ename` varchar(20) not null comment '员工姓名',

|

||||

`job` varchar(20) not null comment '员工职位',

|

||||

`mgr` int comment '主管编号',

|

||||

`sal` int not null comment '员工月薪',

|

||||

`comm` int comment '每月补贴',

|

||||

`dno` int not null comment '所在部门编号',

|

||||

primary key (`eno`),

|

||||

constraint `fk_emp_mgr` foreign key (`mgr`) references tb_emp (`eno`),

|

||||

constraint `fk_emp_dno` foreign key (`dno`) references tb_dept (`dno`)

|

||||

);

|

||||

|

||||

-- 插入14个员工

|

||||

insert into `tb_emp` values

|

||||

(7800, '张三丰', '总裁', null, 9000, 1200, 20),

|

||||

(2056, '乔峰', '分析师', 7800, 5000, 1500, 20),

|

||||

(3088, '李莫愁', '设计师', 2056, 3500, 800, 20),

|

||||

(3211, '张无忌', '程序员', 2056, 3200, null, 20),

|

||||

(3233, '丘处机', '程序员', 2056, 3400, null, 20),

|

||||

(3251, '张翠山', '程序员', 2056, 4000, null, 20),

|

||||

(5566, '宋远桥', '会计师', 7800, 4000, 1000, 10),

|

||||

(5234, '郭靖', '出纳', 5566, 2000, null, 10),

|

||||

(3344, '黄蓉', '销售主管', 7800, 3000, 800, 30),

|

||||

(1359, '胡一刀', '销售员', 3344, 1800, 200, 30),

|

||||

(4466, '苗人凤', '销售员', 3344, 2500, null, 30),

|

||||

(3244, '欧阳锋', '程序员', 3088, 3200, null, 20),

|

||||

(3577, '杨过', '会计', 5566, 2200, null, 10),

|

||||

(3588, '朱九真', '会计', 5566, 2500, null, 10);

|

||||

```

|

||||

|

||||

例子1:查询按月薪从高到低排在第4到第6名的员工的姓名和月薪。

|

||||

|

||||

```SQL

|

||||

select * from (

|

||||

select

|

||||

`ename`, `sal`,

|

||||

row_number() over (order by `sal` desc) as `rank`

|

||||

from `tb_emp`

|

||||

) `temp` where `rank` between 4 and 6;

|

||||

```

|

||||

|

||||

> **说明**:上面使用的函数`row_number()`可以为每条记录生成一个行号,在实际工作中可以根据需要将其替换为`rank()`或`dense_rank()`函数,三者的区别可以参考官方文档或阅读[《通俗易懂的学会:SQL窗口函数》](https://zhuanlan.zhihu.com/p/92654574)进行了解。在MySQL 8以前的版本,我们可以通过下面的方式来完成类似的操作。

|

||||

>

|

||||

> ```SQL

|

||||

> select `rank`, `ename`, `sal` from (

|

||||

> select @a:=@a+1 as `rank`, `ename`, `sal`

|

||||

> from `tb_emp`, (select @a:=0) as t1 order by `sal` desc

|

||||

> ) t2 where `rank` between 4 and 6;

|

||||

> ```

|

||||

|

||||

例子2:查询每个部门月薪最高的两名的员工的姓名和部门名称。

|

||||

|

||||

```SQL

|

||||

select `ename`, `sal`, `dname`

|

||||

from (

|

||||

select

|

||||

`ename`, `sal`, `dno`,

|

||||

rank() over (partition by `dno` order by `sal` desc) as `rank`

|

||||

from `tb_emp`

|

||||

) as `temp` natural join `tb_dept` where `rank`<=2;

|

||||

```

|

||||

|

||||

> 说明:在MySQL 8以前的版本,我们可以通过下面的方式来完成类似的操作。

|

||||

>

|

||||

> ```SQL

|

||||

> select `ename`, `sal`, `dname` from `tb_emp` as `t1`

|

||||

natural join `tb_dept`

|

||||

where (

|

||||

select count(*) from `tb_emp` as `t2`

|

||||

where `t1`.`dno`=`t2`.`dno` and `t2`.`sal`>`t1`.`sal`

|

||||

)<2 order by `dno` asc, `sal` desc;

|

||||

> ```

|

||||

|

||||

### 其他内容

|

||||

|

||||

#### 范式理论

|

||||

|

||||

范式理论是设计关系型数据库中二维表的指导思想。

|

||||

|

||||

1. 第一范式:数据表的每个列的值域都是由原子值组成的,不能够再分割。

|

||||

2. 第二范式:数据表里的所有数据都要和该数据表的键(主键与候选键)有完全依赖关系。

|

||||

3. 第三范式:所有非键属性都只和候选键有相关性,也就是说非键属性之间应该是独立无关的。

|

||||

|

||||

> **说明**:实际工作中,出于效率的考虑,我们在设计表时很有可能做出反范式设计,即故意降低方式级别,增加冗余数据来获得更好的操作性能。

|

||||

|

||||

#### 数据完整性

|

||||

|

||||

1. 实体完整性 - 每个实体都是独一无二的

|

||||

|

||||

- 主键(`primary key`) / 唯一约束(`unique`)

|

||||

2. 引用完整性(参照完整性)- 关系中不允许引用不存在的实体

|

||||

|

||||

- 外键(`foreign key`)

|

||||

3. 域(domain)完整性 - 数据是有效的

|

||||

- 数据类型及长度

|

||||

|

||||

- 非空约束(`not null`)

|

||||

|

||||

- 默认值约束(`default`)

|

||||

|

||||

- 检查约束(`check`)

|

||||

|

||||

> **说明**:在 MySQL 8.x 以前,检查约束并不起作用。

|

||||

|

||||

#### 数据一致性

|

||||

|

||||

1. 事务:一系列对数据库进行读/写的操作,这些操作要么全都成功,要么全都失败。

|

||||

|

||||

2. 事务的 ACID 特性

|

||||

- 原子性:事务作为一个整体被执行,包含在其中的对数据库的操作要么全部被执行,要么都不执行

|

||||

- 一致性:事务应确保数据库的状态从一个一致状态转变为另一个一致状态

|

||||

- 隔离性:多个事务并发执行时,一个事务的执行不应影响其他事务的执行

|

||||

- 持久性:已被提交的事务对数据库的修改应该永久保存在数据库中

|

||||

|

||||

3. MySQL 中的事务操作

|

||||

|

||||

- 开启事务环境

|

||||

|

||||

```SQL

|

||||

start transaction

|

||||

```

|

||||

|

||||

- 提交事务

|

||||

|

||||

```SQL

|

||||

commit

|

||||

```

|

||||

|

||||

- 回滚事务

|

||||

|

||||

```SQL

|

||||

rollback

|

||||

```

|

||||

|

||||

4. 查看事务隔离级别

|

||||

|

||||

```SQL

|

||||

show variables like 'transaction_isolation';

|

||||

```

|

||||

|

||||

```

|

||||

+-----------------------+-----------------+

|

||||

| Variable_name | Value |

|

||||

+-----------------------+-----------------+

|

||||

| transaction_isolation | REPEATABLE-READ |

|

||||

+-----------------------+-----------------+

|

||||

```

|

||||

|

||||

可以看出,MySQL 默认的事务隔离级别是`REPEATABLE-READ`。

|

||||

|

||||

5. 修改(当前会话)事务隔离级别

|

||||

|

||||

```SQL

|

||||

set session transaction isolation level read committed;

|

||||

```

|

||||

|

||||

重新查看事务隔离级别,结果如下所示。

|

||||

|

||||

```

|

||||

+-----------------------+----------------+

|

||||

| Variable_name | Value |

|

||||

+-----------------------+----------------+

|

||||

| transaction_isolation | READ-COMMITTED |

|

||||

+-----------------------+----------------+

|

||||

```

|

||||

|

||||

关系型数据库的事务是一个很大的话题,因为当存在多个并发事务访问数据时,就有可能出现三类读数据的问题(脏读、不可重复读、幻读)和两类更新数据的问题(第一类丢失更新、第二类丢失更新)。想了解这五类问题的,可以阅读我发布在 CSDN 网站上的[《Java面试题全集(上)》](https://blog.csdn.net/jackfrued/article/details/44921941)一文的第80题。为了避免这些问题,关系型数据库底层是有对应的锁机制的,按锁定对象不同可以分为表级锁和行级锁,按并发事务锁定关系可以分为共享锁和独占锁。然而直接使用锁是非常麻烦的,为此数据库为用户提供了自动锁机制,只要用户指定适当的事务隔离级别,数据库就会通过分析 SQL 语句,然后为事务访问的资源加上合适的锁。此外,数据库还会维护这些锁通过各种手段提高系统的性能,这些对用户来说都是透明的。想了解 MySQL 事务和锁的细节知识,推荐大家阅读进阶读物[《高性能MySQL》](https://item.jd.com/11220393.html),这也是数据库方面的经典书籍。

|

||||

|

||||

ANSI/ISO SQL 92标准定义了4个等级的事务隔离级别,如下表所示。需要说明的是,事务隔离级别和数据访问的并发性是对立的,事务隔离级别越高并发性就越差。所以要根据具体的应用来确定到底使用哪种事务隔离级别,这个地方没有万能的原则。

|

||||

|

||||

<img src="https://gitee.com/jackfrued/mypic/raw/master/20211121225327.png" style="zoom:50%;">

|

||||

|

||||

### 总结

|

||||

|

||||

关于 SQL 和 MySQL 的知识肯定远远不止上面列出的这些,比如 SQL 本身的优化、MySQL 性能调优、MySQL 运维相关工具、MySQL 数据的备份和恢复、监控 MySQL 服务、部署高可用架构等,这一系列的问题在这里都没有办法逐一展开来讨论,那就留到有需要的时候再进行讲解吧,各位读者也可以自行探索。

|

||||

|

|

@ -0,0 +1,213 @@

|

|||

## Hive简介

|

||||

|

||||

Hive是Facebook开源的一款基于Hadoop的数据仓库工具,是目前应用最广泛的大数据处理解决方案,它能将SQL查询转变为 MapReduce(Google提出的一个软件架构,用于大规模数据集的并行运算)任务,对SQL提供了完美的支持,能够非常方便的实现大数据统计。

|

||||

|

||||

<img src="https://gitee.com/jackfrued/mypic/raw/master/20220210080608.png">

|

||||

|

||||

> **说明**:可以通过<https://www.edureka.co/blog/hadoop-ecosystem>来了解Hadoop生态圈。

|

||||

|

||||

如果要简单的介绍Hive,那么以下两点是其核心:

|

||||

|

||||

1. 把HDFS中结构化的数据映射成表。

|

||||

2. 通过把Hive-SQL进行解析和转换,最终生成一系列基于Hadoop的MapReduce任务/Spark任务,通过执行这些任务完成对数据的处理。也就是说,即便不学习Java、Scala这样的编程语言,一样可以实现对数据的处理。

|

||||

|

||||

Hive和传统关系型数据库的对比如下表所示。

|

||||

|

||||

| | Hive | RDBMS |

|

||||

| -------- | ----------------- | ------------ |

|

||||

| 查询语言 | HQL | SQL |

|

||||

| 存储数据 | HDFS | 本地文件系统 |

|

||||

| 执行方式 | MapReduce / Spark | Executor |

|

||||

| 执行延迟 | 高 | 低 |

|

||||

| 数据规模 | 大 | 小 |

|

||||

|

||||

### 准备工作

|

||||

|

||||

1. 搭建如下图所示的大数据平台。

|

||||

|

||||

|

||||

|

||||

2. 通过Client节点访问大数据平台。

|

||||

|

||||

|

||||

|

||||

3. 创建文件Hadoop的文件系统。

|

||||

|

||||

```Shell

|

||||

hadoop fs -mkdir /data

|

||||

hadoop fs -chmod g+w /data

|

||||

```

|

||||

|

||||

4. 将准备好的数据文件拷贝到Hadoop文件系统中。

|

||||

|

||||

```Shell

|

||||

hadoop fs -put /home/ubuntu/data/* /data

|

||||

```

|

||||

|

||||

### 创建/删除数据库

|

||||

|

||||

创建。

|

||||

|

||||

```SQL

|

||||

create database if not exists demo;

|

||||

```

|

||||

|

||||

或

|

||||

|

||||

```Shell

|

||||

hive -e "create database demo;"

|

||||

```

|

||||

|

||||

删除。

|

||||

|

||||

```SQL

|

||||

drop database if exists demo;

|

||||

```

|

||||

|

||||

切换。

|

||||

|

||||

```SQL

|

||||

use demo;

|

||||

```

|

||||

|

||||

### 数据类型

|

||||

|

||||

Hive的数据类型如下所示。

|

||||

|

||||

基本数据类型。

|

||||

|

||||

| 数据类型 | 占用空间 | 支持版本 |

|

||||

| --------- | -------- | -------- |

|

||||

| tinyint | 1-Byte | |

|

||||

| smallint | 2-Byte | |

|

||||

| int | 4-Byte | |

|

||||

| bigint | 8-Byte | |

|

||||

| boolean | | |

|

||||

| float | 4-Byte | |

|

||||

| double | 8-Byte | |

|

||||

| string | | |

|

||||

| binary | | 0.8版本 |

|

||||

| timestamp | | 0.8版本 |

|

||||

| decimal | | 0.11版本 |

|

||||

| char | | 0.13版本 |

|

||||

| varchar | | 0.12版本 |

|

||||

| date | | 0.12版本 |

|

||||

|

||||

复杂数据类型。

|

||||

|

||||

| 数据类型 | 描述 | 例子 |

|

||||

| -------- | ------------------------ | --------------------------------------------- |

|

||||

| struct | 和C语言中的结构体类似 | `struct<first_name:string, last_name:string>` |

|

||||

| map | 由键值对构成的元素的集合 | `map<string,int>` |

|

||||

| array | 具有相同类型的变量的容器 | `array<string>` |

|

||||

|

||||

### 创建和使用表

|

||||

|

||||

1. 创建内部表。

|

||||

|

||||

```SQL

|

||||

create table if not exists user_info

|

||||

(

|

||||

user_id string,

|

||||

user_name string,

|

||||

sex string,

|

||||

age int,

|

||||

city string,

|

||||

firstactivetime string,

|

||||

level int,

|

||||

extra1 string,

|

||||

extra2 map<string,string>

|

||||

)

|

||||

row format delimited fields terminated by '\t'

|

||||

collection items terminated by ','

|

||||

map keys terminated by ':'

|

||||

lines terminated by '\n'

|

||||

stored as textfile;

|

||||

```

|

||||

|

||||

2. 加载数据。

|

||||

|

||||

```SQL

|

||||

load data local inpath '/home/ubuntu/data/user_info/user_info.txt' overwrite into table user_info;

|

||||

```

|

||||

|

||||

或

|

||||

|

||||

```SQL

|

||||

load data inpath '/data/user_info/user_info.txt' overwrite into table user_info;

|

||||

```

|

||||

|

||||

3. 创建分区表。

|

||||

|

||||

```SQL

|

||||

create table if not exists user_trade

|

||||

(

|

||||

user_name string,

|

||||

piece int,

|

||||

price double,

|

||||

pay_amount double,

|

||||

goods_category string,

|

||||

pay_time bigint

|

||||

)

|

||||

partitioned by (dt string)

|

||||

row format delimited fields terminated by '\t';

|

||||

```

|

||||

|

||||

4. 设置动态分区。

|

||||

|

||||

```SQL

|

||||

set hive.exec.dynamic.partition=true;

|

||||

set hive.exec.dynamic.partition.mode=nonstrict;

|

||||

set hive.exec.max.dynamic.partitions=10000;

|

||||

set hive.exec.max.dynamic.partitions.pernode=10000;

|

||||

```

|

||||

|

||||

5. 拷贝数据(Shell命令)。

|

||||

|

||||

```Shell

|

||||

hdfs dfs -put /home/ubuntu/data/user_trade/* /user/hive/warehouse/demo.db/user_trade

|

||||

```

|

||||

|

||||

6. 修复分区表。

|

||||

|

||||

```SQL

|

||||

msck repair table user_trade;

|

||||

```

|

||||

|

||||

### 查询

|

||||

|

||||

#### 基本语法

|

||||

|

||||

```SQL

|

||||

select user_name from user_info where city='beijing' and sex='female' limit 10;

|

||||

select user_name, piece, pay_amount from user_trade where dt='2019-03-24' and goods_category='food';

|

||||

```

|

||||

|

||||

#### group by

|

||||

|

||||

```SQL

|

||||

-- 查询2019年1月到4月,每个品类有多少人购买,累计金额是多少

|

||||

select goods_category, count(distinct user_name) as user_num, sum(pay_amount) as total from user_trade where dt between '2019-01-01' and '2019-04-30' group by goods_category;

|

||||

```

|

||||

|

||||

```SQL

|

||||

-- 查询2019年4月支付金额超过5万元的用户

|

||||

select user_name, sum(pay_amount) as total from user_trade where dt between '2019-04-01' and '2019-04-30' group by user_name having sum(pay_amount) > 50000;

|

||||

```

|

||||

|

||||

#### order by

|

||||

|

||||

```SQL

|

||||

-- 查询2019年4月支付金额最多的用户前5名

|

||||

select user_name, sum(pay_amount) as total from user_trade where dt between '2019-04-01' and '2019-04-30' group by user_name order by total desc limit 5;

|

||||

```

|

||||

|

||||

#### 常用函数

|

||||

|

||||

1. `from_unixtime`:将时间戳转换成日期

|

||||

2. `unix_timestamp`:将日期转换成时间戳

|

||||

3. `datediff`:计算两个日期的时间差

|

||||

4. `if`:根据条件返回不同的值

|

||||

5. `substr`:字符串取子串

|

||||

6. `get_json_object`:从JSON字符串中取出指定的`key`对应的`value`,如:`get_json_object(info, '$.first_name')`。

|

||||

|

||||

|

|

@ -0,0 +1,96 @@

|

|||

create table `app_info` (

|

||||

`id` bigint(20) not null auto_increment comment '自增id, app的id',

|

||||

`app_name` varchar(255) default '' comment '名称',

|

||||

`icon_url` varchar(255) default '' comment 'icon地址',

|

||||

`version` varchar(32) default '' comment '版本号',

|

||||

`app_size` varchar(32) default '' comment '包大小',

|

||||

`banner_info` varchar(4096) default '' comment 'banner信息',

|

||||

`developer_id` varchar(255) default '' comment '开发者id',

|

||||

`summary` varchar(512) default '' comment '简介',

|

||||

`app_desc` text comment '详细信息',

|

||||

`download_url` varchar(255) default '' comment '下载链接',

|

||||

`price` int(10) default '0' comment '价格,单位:分',

|

||||

`status` tinyint(4) unsigned default '0' comment '状态,1:待审核,2:审核通过,3,已下线',

|

||||

`version_desc` varchar(4096) default '' comment '',

|

||||

`create_time` datetime not null default '0000-00-00 00:00:00' comment '创建时间',

|

||||

`update_time` datetime not null default '0000-00-00 00:00:00' comment '更新时间',

|

||||

primary key (`id`),

|

||||

key `idx_app_name` (`app_name`),

|

||||

key `idx_developer` (`user_id`)

|

||||

) engine=innodb auto_increment=100000 default charset=utf8 comment='app基本信息表';

|

||||

|

||||

create table `app_ext_info` (

|

||||

`id` bigint(20) not null auto_increment comment '自增id',

|

||||

`app_id` bigint(20) not null default '0' comment 'app_id',

|

||||

`install_count` bigint(20) unsigned not null default '0' comment 'app安装量',

|

||||

`score` int(10) unsigned not null default '0' comment '评分',

|

||||

`comment_count` int(10) unsigned not null default '0' comment '评论量',

|

||||

`create_time` int(10) not null default 0 comment '创建时间',

|

||||

`update_time` int(10) not null default 0 comment '更新时间',

|

||||

primary key (`id`),

|

||||

unique key `idx_app_id` (`app_id`)

|

||||

) engine=innodb default charset=utf8 comment='App扩展信息表';

|

||||

|

||||

create table `app_category` (

|

||||

`id` bigint(20) not null auto_increment comment '自增id',

|

||||

`parent_id` bigint(20) not null default '0' comment '父分类id',

|

||||

`name` varchar(64) not null default '' comment '分类名称',

|

||||

`icon` varchar(512) not null default '' comment 'icon地址',

|

||||

`category_desc` text comment '分类描述',

|

||||

`category_level` tinyint(4) unsigned not null default '0' comment '分类级别',

|

||||

`status` tinyint(4) unsigned not null default '0' comment '当前状态,1:使用中,隐藏',

|

||||

`display_order` int(10) unsigned not null default '0' comment '排序,值越大越靠前',

|

||||

`create_time` int(10) not null default 0 comment '创建时间',

|

||||

`update_time` int(10) not null default 0 comment '更新时间',

|

||||

primary key (`id`)

|

||||

) engine=innodb default charset=utf8 comment='分类信息表';

|

||||

|

||||

create table `app_category_rel` (

|

||||

`id` bigint(20) not null auto_increment comment '自增id',

|

||||

`app_id` bigint(20) not null default '0' comment 'app_id',

|

||||

`category_id` bigint(20) unsigned not null default '0' comment '最低层分类id',

|

||||

primary key (`id`),

|

||||

unique key `idx_category_app` (`category_id`,`app_record_id`),

|

||||

key `idx_app` (`app_id`)

|

||||

) engine=innodb default charset=utf8 comment='App和分类关联表';

|

||||

|

||||

create table `app_comment` (

|

||||

`id` bigint(20) not null auto_increment comment '自增id',

|

||||

`app_id` bigint(20) not null default '0' comment 'app_id',

|

||||

`title` varchar(255) default '' comment '评论标题',

|

||||

`content` varchar(2048) default '' comment '评论内容',

|

||||

`parent_id` bigint(20) default '0' comment '父评论id',

|

||||

`commenter_uid` bigint(20) default '0' comment '评论用户id',

|

||||

`commenter_name` varchar(255) default '' comment '评论用户名称',

|

||||

`commenter_avatar` varchar(255) default '' comment '评论用户头像',

|

||||

`top_flag` tinyint(4) default '0' comment '是否置顶',

|

||||

`like_count` int(10) default '0' comment '评论的赞数量',

|

||||

`status` tinyint(4) default '0' comment '评论状态',

|

||||

`create_time` int(10) not null default 0 comment '创建时间',

|

||||

`update_time` int(10) not null default 0 comment '更新时间',

|

||||

primary key (`id`),

|

||||

key `idx_app_status` (`app_id`, `status`, `top_flag`)

|

||||

) engine=innodb default charset=utf8 comment='评论信息表';

|

||||

|

||||

create table `user_app_relation` (

|

||||

`id` bigint(20) not null auto_increment comment '自增id',

|

||||

`user_id` bigint(20) unsigned not null default '0' comment '用户id',

|

||||

`app_id` bigint(20) not null default '0' comment 'app_id',

|

||||

`create_time` int(10) not null default 0 comment '创建时间',

|

||||

`update_time` int(10) not null default 0 comment '更新时间',

|

||||

`is_del` tinyint(4) not null default '0' comment '1:删除 0:未删除',

|

||||

primary key (`id`),

|

||||

key `idx_user_app` (`user_id`,`app_id`)

|

||||

) engine=innodb auto_increment=8063 default charset=utf8 comment='用户购买关系表';

|

||||

|

||||

create table `bot_score` (

|

||||

`id` bigint(20) not null auto_increment comment '自增id',

|

||||

`app_id` bigint(20) not null default '0' comment 'app_id',

|

||||

`score` int(10) default '0' comment '用户评分',

|

||||

`commenter_uid` bigint(20) default '0' comment '评分用户id',

|

||||

`status` tinyint(4) default '0' comment '评分状态',

|

||||

`create_time` int(10) not null default 0 comment '创建时间',

|

||||

`update_time` int(10) not null default 0 comment '更新时间',

|

||||

primary key (`id`),

|

||||

unique key `idx_uid_score` (`app_id`,`commenter_uid`)

|

||||

) engine=innodb default charset=utf8 comment='App评分表';

|

||||

|

|

@ -65,8 +65,8 @@ from vote import views

|

|||

urlpatterns = [

|

||||

path('', views.show_subjects),

|

||||

path('teachers/', views.show_teachers),

|

||||

path('praise/', views.prise_or_criticize),

|

||||

path('criticize/', views.prise_or_criticize),

|

||||

path('praise/', views.praise_or_criticize),

|

||||

path('criticize/', views.praise_or_criticize),

|

||||

path('admin/', admin.site.urls),

|

||||

]

|

||||

```

|

||||

|

|

|

|||

|

|

@ -0,0 +1,200 @@

|

|||

## 网络数据采集概述

|

||||

|

||||

爬虫(crawler)也经常被称为网络蜘蛛(spider),是按照一定的规则自动浏览网站并获取所需信息的机器人程序(自动化脚本代码),被广泛的应用于互联网搜索引擎和数据采集。使用过互联网和浏览器的人都知道,网页中除了供用户阅读的文字信息之外,还包含一些超链接,网络爬虫正是通过网页中的超链接信息,不断获得网络上其它页面的地址,然后持续的进行数据采集。正因如此,网络数据采集的过程就像一个爬虫或者蜘蛛在网络上漫游,所以才被形象的称为爬虫或者网络蜘蛛。

|

||||

|

||||

### 爬虫的应用领域

|

||||

|

||||

在理想的状态下,所有 ICP(Internet Content Provider)都应该为自己的网站提供 API 接口来共享它们允许其他程序获取的数据,在这种情况下就根本不需要爬虫程序。国内比较有名的电商平台(如淘宝、京东等)、社交平台(如微博、微信等)等都提供了自己的 API 接口,但是这类 API 接口通常会对可以抓取的数据以及抓取数据的频率进行限制。对于大多数的公司而言,及时的获取行业数据和竞对数据是企业生存的重要环节之一,然而对大部分企业来说,数据都是其与生俱来的短板。在这种情况下,合理的利用爬虫来获取数据并从中提取出有商业价值的信息对这些企业来说就显得至关重要的。

|

||||

|

||||

爬虫的应用领域其实非常广泛,下面我们列举了其中的一部分,有兴趣的读者可以自行探索相关内容。

|

||||

|

||||

1. 搜索引擎

|

||||

2. 新闻聚合

|

||||

3. 社交应用

|

||||

4. 舆情监控

|

||||

5. 行业数据

|

||||

|

||||

### 爬虫合法性探讨

|

||||

|

||||

经常听人说起“爬虫写得好,牢饭吃到饱”,那么编程爬虫程序是否违法呢?关于这个问题,我们可以从以下几个角度进行解读。

|

||||

|

||||

1. 网络爬虫这个领域目前还属于拓荒阶段,虽然互联网世界已经通过自己的游戏规则建立起了一定的道德规范,即 Robots 协议(全称是“网络爬虫排除标准”),但法律部分还在建立和完善中,也就是说,现在这个领域暂时还是灰色地带。

|

||||

2. “法不禁止即为许可”,如果爬虫就像浏览器一样获取的是前端显示的数据(网页上的公开信息)而不是网站后台的私密敏感信息,就不太担心法律法规的约束,因为目前大数据产业链的发展速度远远超过了法律的完善程度。

|

||||

3. 在爬取网站的时候,需要限制自己的爬虫遵守 Robots 协议,同时控制网络爬虫程序的抓取数据的速度;在使用数据的时候,必须要尊重网站的知识产权(从Web 2.0时代开始,虽然Web上的数据很多都是由用户提供的,但是网站平台是投入了运营成本的,当用户在注册和发布内容时,平台通常就已经获得了对数据的所有权、使用权和分发权)。如果违反了这些规定,在打官司的时候败诉几率相当高。

|

||||

4. 适当的隐匿自己的身份在编写爬虫程序时必要的,而且最好不要被对方举证你的爬虫有破坏别人动产(例如服务器)的行为。

|

||||

5. 不要在公网(如代码托管平台)上去开源或者展示你的爬虫代码,这些行为通常会给自己带来不必要的麻烦。

|

||||

|

||||

#### Robots协议

|

||||

|

||||

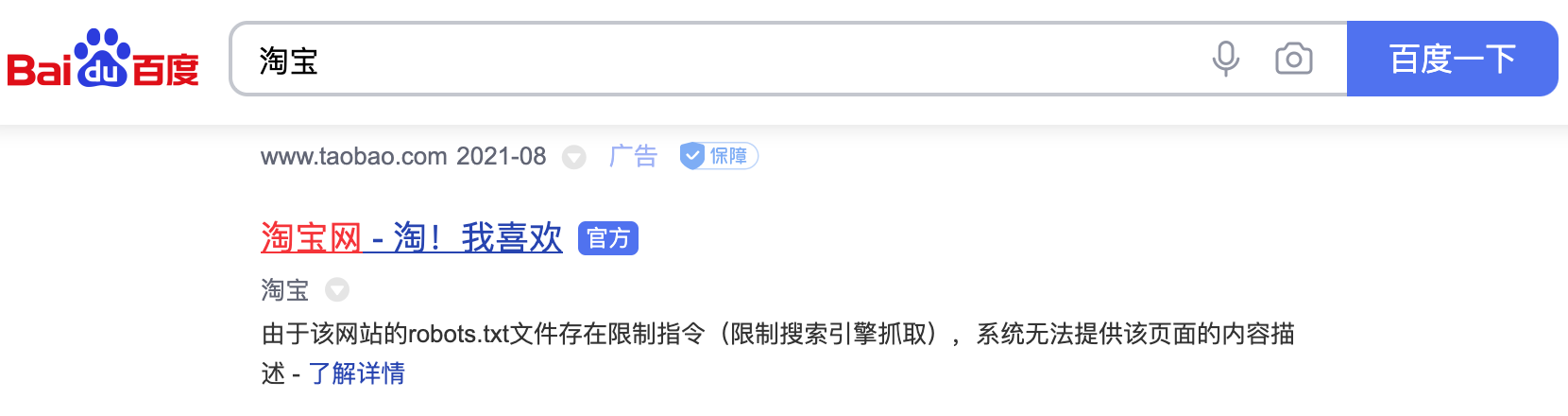

大多数网站都会定义`robots.txt`文件,这是一个君子协议,并不是所有爬虫都必须遵守的游戏规则。下面以淘宝的[`robots.txt`](http://www.taobao.com/robots.txt)文件为例,看看淘宝网对爬虫有哪些限制。

|

||||

|

||||

```

|

||||

User-agent: Baiduspider

|

||||

Disallow: /

|

||||

|

||||

User-agent: baiduspider

|

||||

Disallow: /

|

||||

```

|

||||

|

||||

通过上面的文件可以看出,淘宝禁止百度爬虫爬取它任何资源,因此当你在百度搜索“淘宝”的时候,搜索结果下方会出现:“由于该网站的`robots.txt`文件存在限制指令(限制搜索引擎抓取),系统无法提供该页面的内容描述”。百度作为一个搜索引擎,至少在表面上遵守了淘宝网的`robots.txt`协议,所以用户不能从百度上搜索到淘宝内部的产品信息。

|

||||

|

||||

图1. 百度搜索淘宝的结果

|

||||

|

||||

|

||||

|

||||

下面是豆瓣网的[`robots.txt`](https://www.douban.com/robots.txt)文件,大家可以自行解读,看看它做出了什么样的限制。

|

||||

|

||||

```

|

||||

User-agent: *

|

||||

Disallow: /subject_search

|

||||

Disallow: /amazon_search

|

||||

Disallow: /search

|

||||

Disallow: /group/search

|

||||

Disallow: /event/search

|

||||

Disallow: /celebrities/search

|

||||

Disallow: /location/drama/search

|

||||

Disallow: /forum/

|

||||

Disallow: /new_subject

|

||||

Disallow: /service/iframe

|

||||

Disallow: /j/

|

||||

Disallow: /link2/

|

||||

Disallow: /recommend/

|

||||

Disallow: /doubanapp/card

|

||||

Disallow: /update/topic/

|

||||

Disallow: /share/

|

||||

Allow: /ads.txt

|

||||

Sitemap: https://www.douban.com/sitemap_index.xml

|

||||

Sitemap: https://www.douban.com/sitemap_updated_index.xml

|

||||

# Crawl-delay: 5

|

||||

|

||||

User-agent: Wandoujia Spider

|

||||

Disallow: /

|

||||

|

||||

User-agent: Mediapartners-Google

|

||||

Disallow: /subject_search

|

||||

Disallow: /amazon_search

|

||||

Disallow: /search

|

||||

Disallow: /group/search

|

||||

Disallow: /event/search

|

||||

Disallow: /celebrities/search

|

||||

Disallow: /location/drama/search

|

||||

Disallow: /j/

|

||||

```

|

||||

|

||||

### 超文本传输协议(HTTP)

|

||||

|

||||

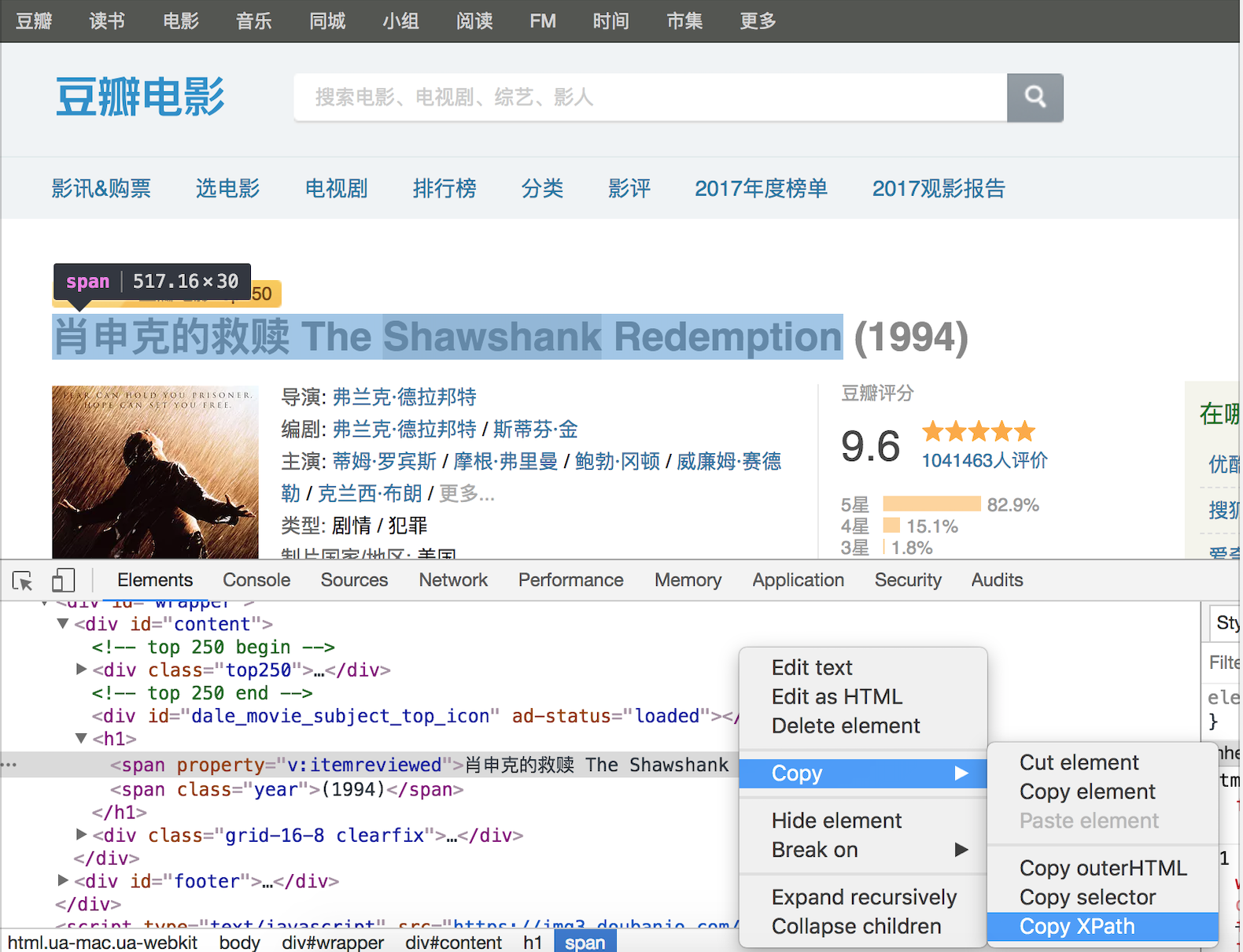

在开始讲解爬虫之前,我们稍微对超文本传输协议(HTTP)做一些回顾,因为我们在网页上看到的内容通常是浏览器执行 HTML (超文本标记语言)得到的结果,而 HTTP 就是传输 HTML 数据的协议。HTTP 和其他很多应用级协议一样是构建在 TCP(传输控制协议)之上的,它利用了 TCP 提供的可靠的传输服务实现了 Web 应用中的数据交换。按照维基百科上的介绍,设计 HTTP 最初的目的是为了提供一种发布和接收 [HTML](https://zh.wikipedia.org/wiki/HTML) 页面的方法,也就是说,这个协议是浏览器和 Web 服务器之间传输的数据的载体。关于 HTTP 的详细信息以及目前的发展状况,大家可以阅读[《HTTP 协议入门》](http://www.ruanyifeng.com/blog/2016/08/http.html)、[《互联网协议入门》](http://www.ruanyifeng.com/blog/2012/05/internet_protocol_suite_part_i.html)、[《图解 HTTPS 协议》](http://www.ruanyifeng.com/blog/2014/09/illustration-ssl.html)等文章进行了解。

|

||||

|

||||

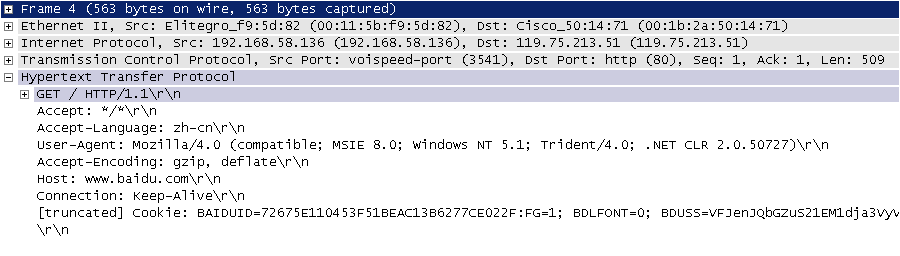

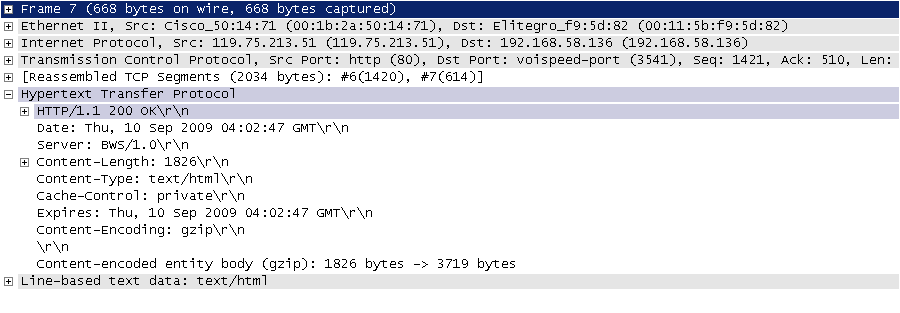

下图是我在四川省网络通信技术重点实验室工作期间用开源协议分析工具 Ethereal(WireShark 的前身)截取的访问百度首页时的 HTTP 请求和响应的报文(协议数据),由于 Ethereal 截取的是经过网络适配器的数据,因此可以清晰的看到从物理链路层到应用层的协议数据。

|

||||

|

||||

图2. HTTP请求

|

||||

|

||||

|

||||

|

||||

HTTP 请求通常是由请求行、请求头、空行、消息体四个部分构成,如果没有数据发给服务器,消息体就不是必须的部分。请求行中包含了请求方法(GET、POST 等,如下表所示)、资源路径和协议版本;请求头由若干键值对构成,包含了浏览器、编码方式、首选语言、缓存策略等信息;请求头的后面是空行和消息体。

|

||||

|

||||

<img src="https://gitee.com/jackfrued/mypic/raw/master/20210825002720.PNG" width="65%">

|

||||

|

||||

图3. HTTP响应

|

||||

|

||||

|

||||

|

||||

HTTP 响应通常是由响应行、响应头、空行、消息体四个部分构成,其中消息体是服务响应的数据,可能是 HTML 页面,也有可能是JSON或二进制数据等。响应行中包含了协议版本和响应状态码,响应状态码有很多种,常见的如下表所示。

|

||||

|

||||

<img src="https://gitee.com/jackfrued/mypic/raw/master/20210825002802.PNG" width="65%">

|

||||

|

||||

#### 相关工具

|

||||

|

||||

下面我们先介绍一些开发爬虫程序的辅助工具,这些工具相信能帮助你事半功倍。

|

||||

|

||||

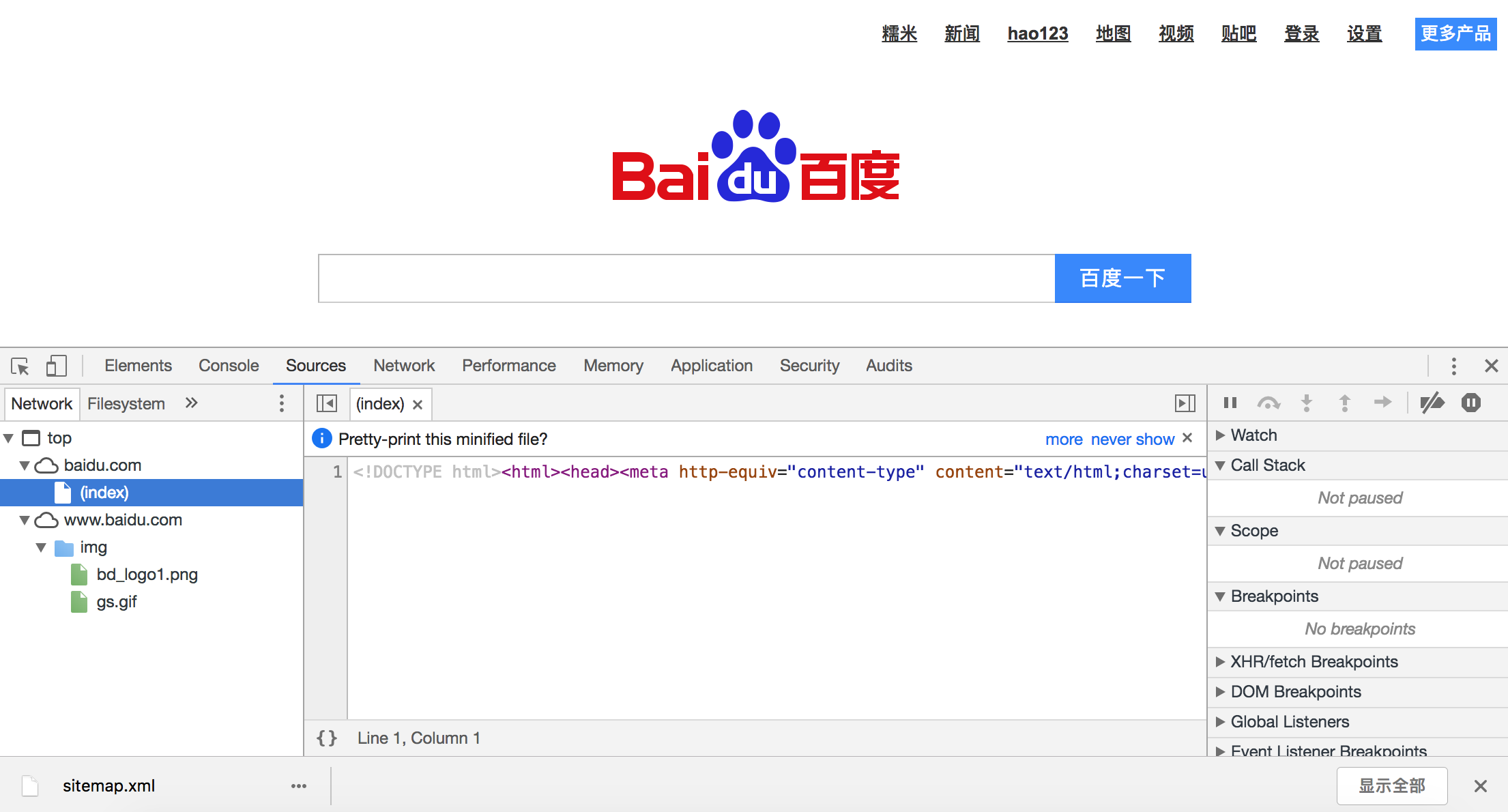

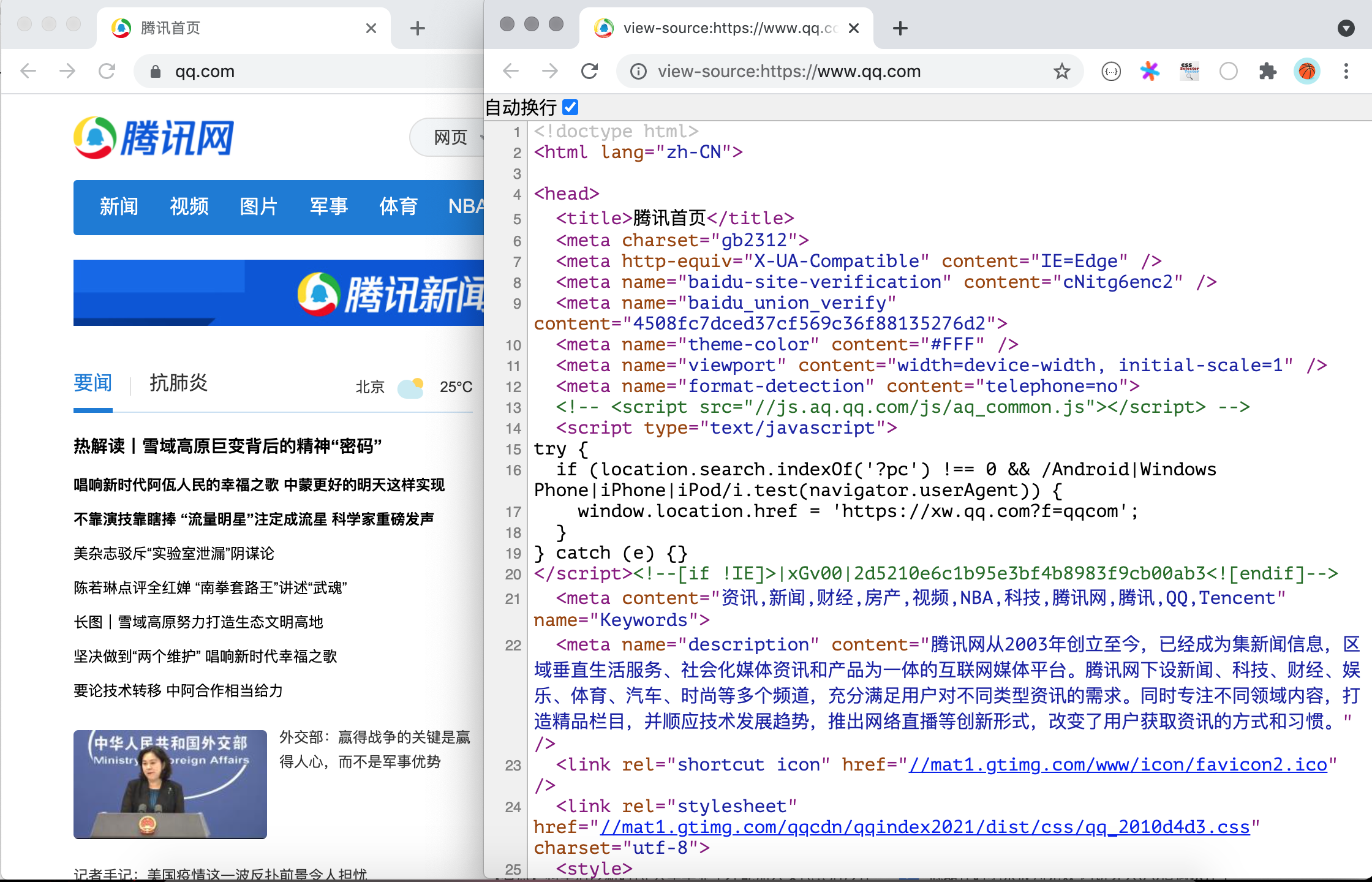

1. Chrome Developer Tools:谷歌浏览器内置的开发者工具。该工具最常用的几个功能模块是:

|

||||

|

||||

- 元素(ELements):用于查看或修改 HTML 元素的属性、CSS 属性、监听事件等。CSS 可以即时修改,即时显示,大大方便了开发者调试页面。

|

||||

- 控制台(Console):用于执行一次性代码,查看 JavaScript 对象,查看调试日志信息或异常信息。控制台其实就是一个执行 JavaScript 代码的交互式环境。

|

||||

- 源代码(Sources):用于查看页面的 HTML 文件源代码、JavaScript 源代码、CSS 源代码,此外最重要的是可以调试 JavaScript 源代码,可以给代码添加断点和单步执行。

|

||||

- 网络(Network):用于 HTTP 请求、HTTP 响应以及与网络连接相关的信息。

|

||||

- 应用(Application):用于查看浏览器本地存储、后台任务等内容,本地存储主要包括Cookie、Local Storage、Session Storage等。

|

||||

|

||||

|

||||

|

||||

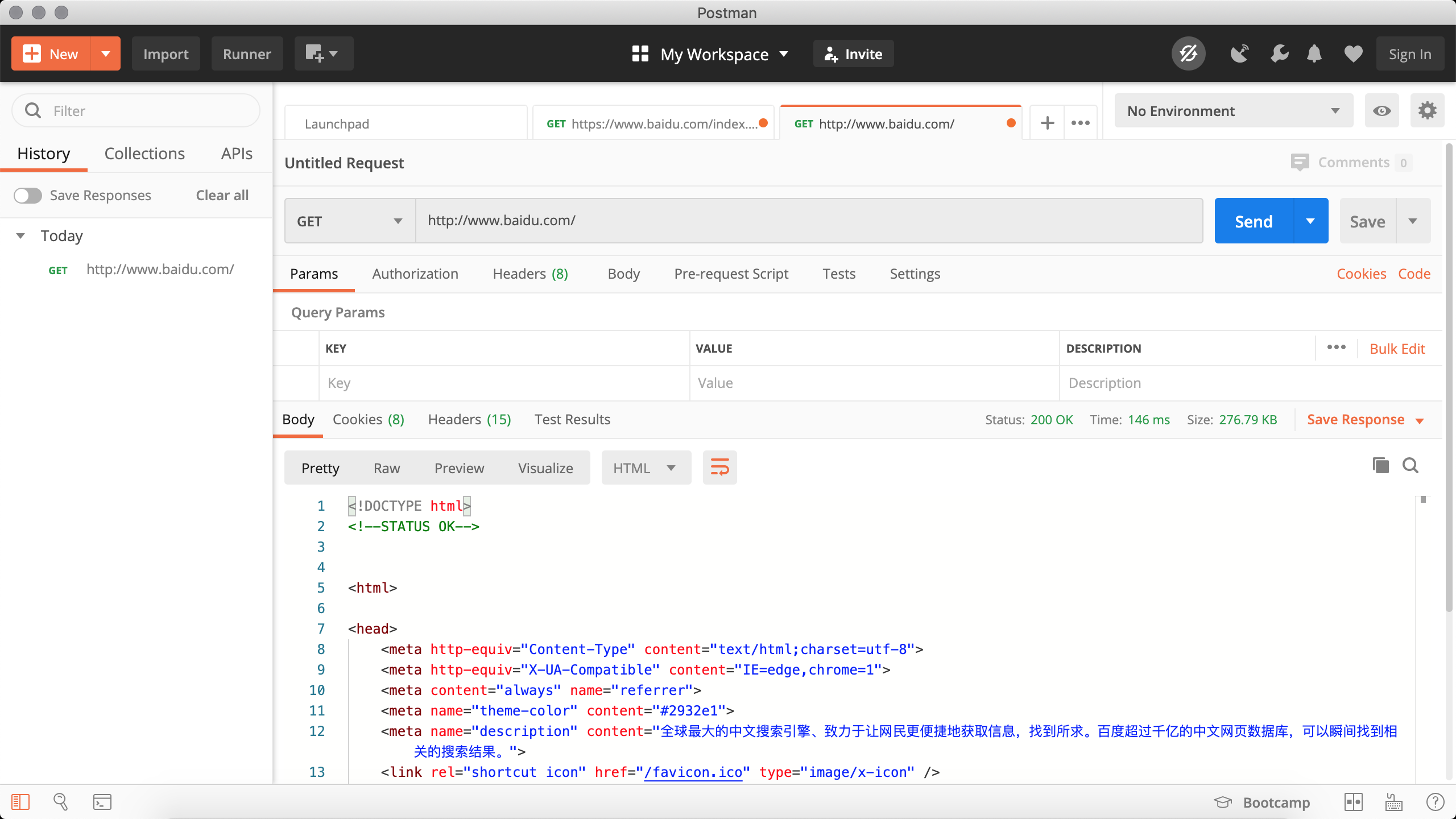

2. Postman:功能强大的网页调试与 RESTful 请求工具。Postman可以帮助我们模拟请求,非常方便的定制我们的请求以及查看服务器的响应。

|

||||

|

||||

|

||||

|

||||

3. HTTPie:命令行HTTP客户端。

|

||||

|

||||

安装。

|

||||

|

||||

```Bash

|

||||

pip install httpie

|

||||

```

|

||||

|

||||

使用。

|

||||

|

||||

```Bash

|

||||

http --header http --header https://movie.douban.com/

|

||||

|

||||

HTTP/1.1 200 OK

|

||||

Connection: keep-alive

|

||||

Content-Encoding: gzip

|

||||

Content-Type: text/html; charset=utf-8

|

||||

Date: Tue, 24 Aug 2021 16:48:00 GMT

|

||||

Keep-Alive: timeout=30

|

||||

Server: dae

|

||||

Set-Cookie: bid=58h4BdKC9lM; Expires=Wed, 24-Aug-22 16:48:00 GMT; Domain=.douban.com; Path=/

|

||||

Strict-Transport-Security: max-age=15552000

|

||||

Transfer-Encoding: chunked

|

||||

X-Content-Type-Options: nosniff

|

||||

X-DOUBAN-NEWBID: 58h4BdKC9lM

|

||||

```

|

||||

|

||||

4. `builtwith`库:识别网站所用技术的工具。

|

||||

|

||||

安装。

|

||||

|

||||

```Bash

|

||||

pip install builtwith

|

||||

```

|

||||

|

||||

使用。

|

||||

|

||||

```Python

|

||||

import ssl

|

||||

|

||||

import builtwith

|

||||

|

||||

ssl._create_default_https_context = ssl._create_unverified_context

|

||||

print(builtwith.parse('http://www.bootcss.com/'))

|

||||

```

|

||||

|

||||

5. `python-whois`库:查询网站所有者的工具。

|

||||

|

||||

安装。

|

||||

|

||||

```Bash

|

||||

pip3 install python-whois

|

||||

```

|

||||

|

||||

使用。

|

||||

|

||||

```Python

|

||||

import whois

|

||||

|

||||

print(whois.whois('https://www.bootcss.com'))

|

||||

```

|

||||

|

||||

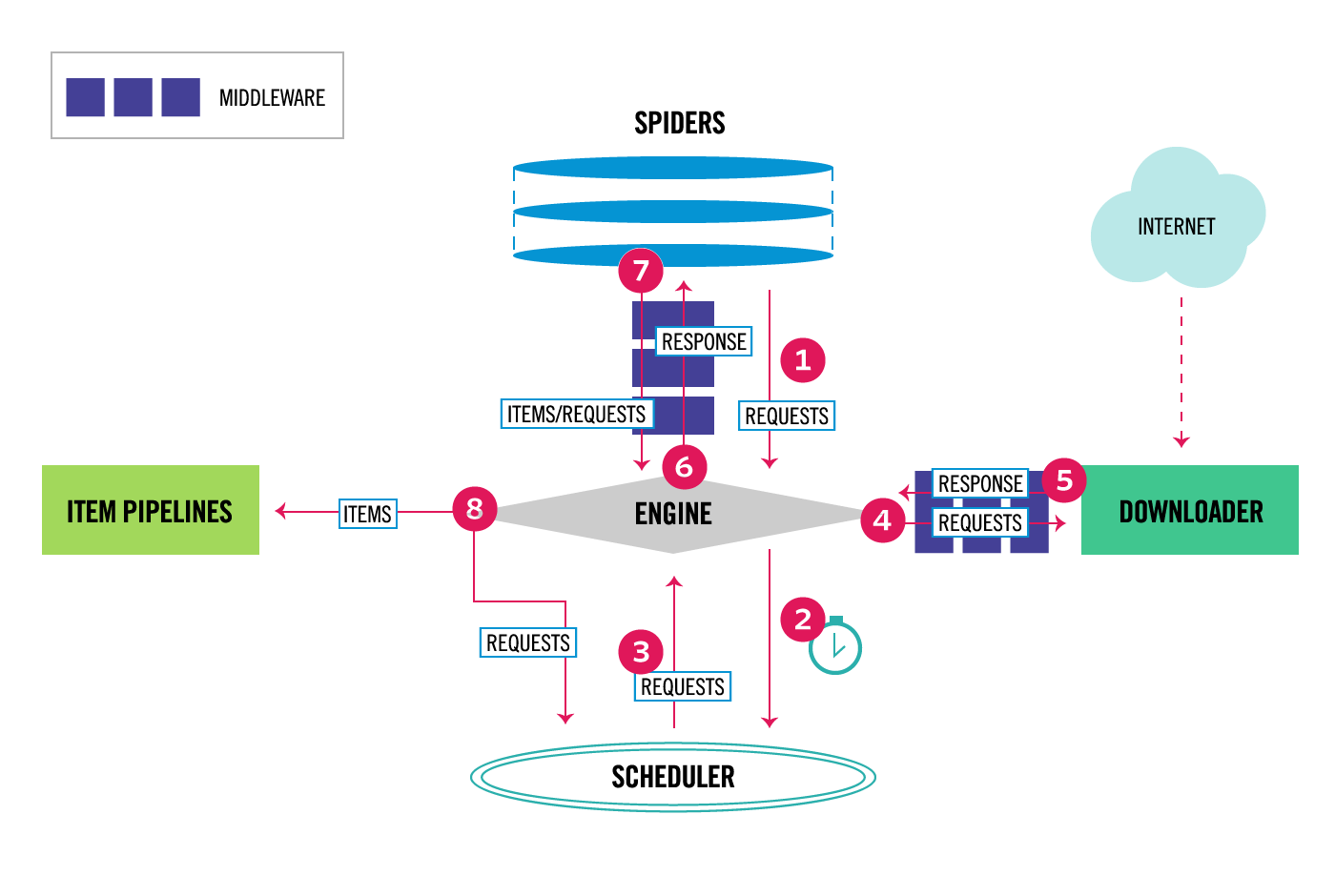

### 爬虫的基本工作流程

|

||||

|

||||

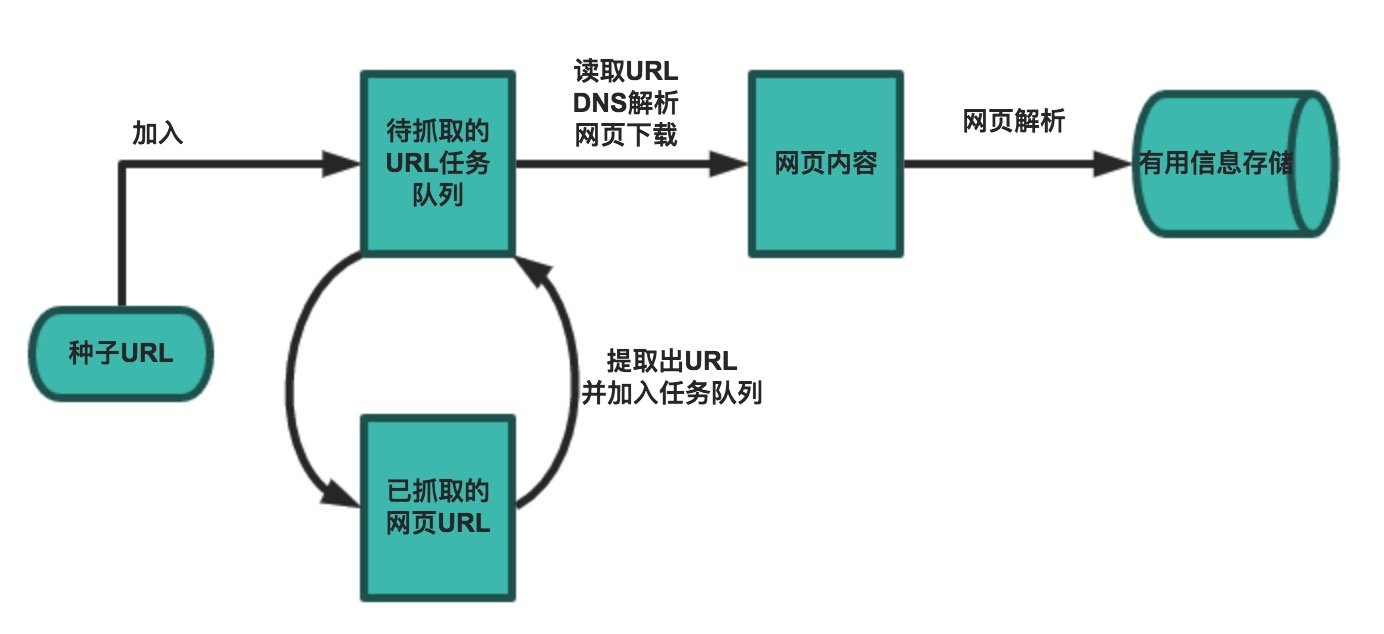

一个基本的爬虫通常分为数据采集(网页下载)、数据处理(网页解析)和数据存储(将有用的信息持久化)三个部分的内容,当然更为高级的爬虫在数据采集和处理时会使用并发编程或分布式技术,这就需要有调度器(安排线程或进程执行对应的任务)、后台管理程序(监控爬虫的工作状态以及检查数据抓取的结果)等的参与。

|

||||

|

||||

|

||||

|

||||

一般来说,爬虫的工作流程包括以下几个步骤:

|

||||

|

||||

1. 设定抓取目标(种子页面/起始页面)并获取网页。

|

||||

2. 当服务器无法访问时,按照指定的重试次数尝试重新下载页面。

|

||||

3. 在需要的时候设置用户代理或隐藏真实IP,否则可能无法访问页面。

|

||||

4. 对获取的页面进行必要的解码操作然后抓取出需要的信息。

|

||||

5. 在获取的页面中通过某种方式(如正则表达式)抽取出页面中的链接信息。

|

||||

6. 对链接进行进一步的处理(获取页面并重复上面的动作)。

|

||||

7. 将有用的信息进行持久化以备后续的处理。

|

||||

|

|

@ -1,319 +0,0 @@

|

|||

## 网络爬虫和相关工具

|

||||

|

||||

### 网络爬虫的概念

|

||||

|

||||

网络爬虫(web crawler),以前经常称之为网络蜘蛛(spider),是按照一定的规则自动浏览万维网并获取信息的机器人程序(或脚本),曾经被广泛的应用于互联网搜索引擎。使用过互联网和浏览器的人都知道,网页中除了供用户阅读的文字信息之外,还包含一些超链接。网络爬虫系统正是通过网页中的超链接信息不断获得网络上的其它页面。正因如此,网络数据采集的过程就像一个爬虫或者蜘蛛在网络上漫游,所以才被形象的称为网络爬虫或者网络蜘蛛。

|

||||

|

||||

#### 爬虫的应用领域

|

||||

|

||||

在理想的状态下,所有ICP(Internet Content Provider)都应该为自己的网站提供API接口来共享它们允许其他程序获取的数据,在这种情况下爬虫就不是必需品,国内比较有名的电商平台(如淘宝、京东等)、社交平台(如腾讯微博等)等网站都提供了自己的Open API,但是这类Open API通常会对可以抓取的数据以及抓取数据的频率进行限制。对于大多数的公司而言,及时的获取行业相关数据是企业生存的重要环节之一,然而大部分企业在行业数据方面的匮乏是其与生俱来的短板,合理的利用爬虫来获取数据并从中提取出有商业价值的信息是至关重要的。当然爬虫还有很多重要的应用领域,下面列举了其中的一部分:

|

||||

|

||||

1. 搜索引擎

|

||||

2. 新闻聚合

|

||||

3. 社交应用

|

||||

4. 舆情监控

|

||||

5. 行业数据

|

||||

|

||||

### 合法性和背景调研

|

||||

|

||||

#### 爬虫合法性探讨

|

||||

|

||||

1. 网络爬虫领域目前还属于拓荒阶段,虽然互联网世界已经通过自己的游戏规则建立起一定的道德规范(Robots协议,全称是“网络爬虫排除标准”),但法律部分还在建立和完善中,也就是说,现在这个领域暂时还是灰色地带。

|

||||

2. “法不禁止即为许可”,如果爬虫就像浏览器一样获取的是前端显示的数据(网页上的公开信息)而不是网站后台的私密敏感信息,就不太担心法律法规的约束,因为目前大数据产业链的发展速度远远超过了法律的完善程度。

|

||||

3. 在爬取网站的时候,需要限制自己的爬虫遵守Robots协议,同时控制网络爬虫程序的抓取数据的速度;在使用数据的时候,必须要尊重网站的知识产权(从Web 2.0时代开始,虽然Web上的数据很多都是由用户提供的,但是网站平台是投入了运营成本的,当用户在注册和发布内容时,平台通常就已经获得了对数据的所有权、使用权和分发权)。如果违反了这些规定,在打官司的时候败诉几率相当高。

|

||||

|

||||

#### Robots.txt文件

|

||||

|

||||

大多数网站都会定义robots.txt文件,下面以淘宝的[robots.txt](http://www.taobao.com/robots.txt)文件为例,看看该网站对爬虫有哪些限制。

|

||||

|

||||

```

|

||||

User-agent: Baiduspider

|

||||

Allow: /article

|

||||

Allow: /oshtml

|

||||

Disallow: /product/

|

||||

Disallow: /

|

||||

|

||||

User-Agent: Googlebot

|

||||

Allow: /article

|

||||

Allow: /oshtml

|

||||

Allow: /product

|

||||

Allow: /spu

|

||||

Allow: /dianpu

|

||||

Allow: /oversea

|

||||

Allow: /list

|

||||

Disallow: /

|

||||

|

||||

User-agent: Bingbot

|

||||

Allow: /article

|

||||

Allow: /oshtml

|

||||

Allow: /product

|

||||

Allow: /spu

|

||||

Allow: /dianpu

|

||||

Allow: /oversea

|

||||

Allow: /list

|

||||

Disallow: /

|

||||

|

||||

User-Agent: 360Spider

|

||||

Allow: /article

|

||||

Allow: /oshtml

|

||||

Disallow: /

|

||||

|

||||

User-Agent: Yisouspider

|

||||

Allow: /article

|

||||

Allow: /oshtml

|

||||

Disallow: /

|

||||

|

||||

User-Agent: Sogouspider

|

||||

Allow: /article

|

||||

Allow: /oshtml

|

||||

Allow: /product

|

||||

Disallow: /

|

||||

|

||||

User-Agent: Yahoo! Slurp

|

||||

Allow: /product

|

||||

Allow: /spu

|

||||

Allow: /dianpu

|

||||

Allow: /oversea

|

||||

Allow: /list

|

||||

Disallow: /

|

||||

|

||||

User-Agent: *

|

||||

Disallow: /

|

||||

```

|

||||

|

||||

注意上面robots.txt第一段的最后一行,通过设置“Disallow: /”禁止百度爬虫访问除了“Allow”规定页面外的其他所有页面。因此当你在百度搜索“淘宝”的时候,搜索结果下方会出现:“由于该网站的robots.txt文件存在限制指令(限制搜索引擎抓取),系统无法提供该页面的内容描述”。百度作为一个搜索引擎,至少在表面上遵守了淘宝网的robots.txt协议,所以用户不能从百度上搜索到淘宝内部的产品信息。

|

||||

|

||||

|

||||

|

||||

### 相关工具介绍

|

||||

|

||||

#### HTTP协议

|

||||

|

||||

在开始讲解爬虫之前,我们稍微对HTTP(超文本传输协议)做一些回顾,因为我们在网页上看到的内容通常是浏览器执行HTML语言得到的结果,而HTTP就是传输HTML数据的协议。HTTP和其他很多应用级协议一样是构建在TCP(传输控制协议)之上的,它利用了TCP提供的可靠的传输服务实现了Web应用中的数据交换。按照维基百科上的介绍,设计HTTP最初的目的是为了提供一种发布和接收[HTML](https://zh.wikipedia.org/wiki/HTML)页面的方法,也就是说这个协议是浏览器和Web服务器之间传输的数据的载体。关于这个协议的详细信息以及目前的发展状况,大家可以阅读阮一峰老师的[《HTTP 协议入门》](http://www.ruanyifeng.com/blog/2016/08/http.html)、[《互联网协议入门》](http://www.ruanyifeng.com/blog/2012/05/internet_protocol_suite_part_i.html)系列以及[《图解HTTPS协议》](http://www.ruanyifeng.com/blog/2014/09/illustration-ssl.html)进行了解,下图是我在四川省网络通信技术重点实验室工作期间用开源协议分析工具Ethereal(抓包工具WireShark的前身)截取的访问百度首页时的HTTP请求和响应的报文(协议数据),由于Ethereal截取的是经过网络适配器的数据,因此可以清晰的看到从物理链路层到应用层的协议数据。

|

||||

|

||||

HTTP请求(请求行+请求头+空行+[消息体]):

|

||||

|

||||

|

||||

|

||||

HTTP响应(响应行+响应头+空行+消息体):

|

||||

|

||||

|

||||

|

||||

> 说明:但愿这两张如同泛黄照片般的截图帮助你大概的了解到HTTP是一个怎样的协议。

|

||||

|

||||

#### 相关工具

|

||||

|

||||

1. Chrome Developer Tools:谷歌浏览器内置的开发者工具。

|

||||

|

||||

|

||||

|

||||

2. Postman:功能强大的网页调试与RESTful请求工具。

|

||||

|

||||

|

||||

|

||||

3. HTTPie:命令行HTTP客户端。

|

||||

|

||||

```Bash

|

||||

pip3 install httpie

|

||||

```

|

||||

|

||||

```Bash

|

||||

http --header http://www.scu.edu.cn

|

||||

HTTP/1.1 200 OK

|

||||

Accept-Ranges: bytes

|

||||

Cache-Control: private, max-age=600

|

||||

Connection: Keep-Alive

|

||||

Content-Encoding: gzip

|

||||

Content-Language: zh-CN

|

||||

Content-Length: 14403

|

||||

Content-Type: text/html

|

||||

Date: Sun, 27 May 2018 15:38:25 GMT

|

||||

ETag: "e6ec-56d3032d70a32-gzip"

|

||||

Expires: Sun, 27 May 2018 15:48:25 GMT

|

||||

Keep-Alive: timeout=5, max=100

|

||||

Last-Modified: Sun, 27 May 2018 13:44:22 GMT

|

||||

Server: VWebServer

|

||||

Vary: User-Agent,Accept-Encoding

|

||||

X-Frame-Options: SAMEORIGIN

|

||||

```

|

||||

|

||||

4. `builtwith`库:识别网站所用技术的工具。

|

||||

|

||||

```Bash

|

||||

pip3 install builtwith

|

||||

```

|

||||

|

||||

```Python

|

||||

>>> import builtwith

|

||||

>>> builtwith.parse('http://www.bootcss.com/')

|

||||

{'web-servers': ['Nginx'], 'font-scripts': ['Font Awesome'], 'javascript-frameworks': ['Lo-dash', 'Underscore.js', 'Vue.js', 'Zepto', 'jQuery'], 'web-frameworks': ['Twitter Bootstrap']}

|

||||

>>>

|

||||

>>> import ssl

|

||||

>>> ssl._create_default_https_context = ssl._create_unverified_context

|

||||

>>> builtwith.parse('https://www.jianshu.com/')

|

||||

{'web-servers': ['Tengine'], 'web-frameworks': ['Twitter Bootstrap', 'Ruby on Rails'], 'programming-languages': ['Ruby']}

|

||||

```

|

||||

|

||||

5. `python-whois`库:查询网站所有者的工具。

|

||||

|

||||

```Bash

|

||||

pip3 install python-whois

|

||||

```

|

||||

|

||||

```Python

|

||||

>>> import whois

|

||||

>>> whois.whois('baidu.com')

|

||||

{'domain_name': ['BAIDU.COM', 'baidu.com'], 'registrar': 'MarkMonitor, Inc.', 'whois_server': 'whois.markmonitor.com', 'referral_url': None, 'updated_date': [datetime.datetime(2017, 7, 28, 2, 36, 28), datetime.datetime(2017, 7, 27, 19, 36, 28)], 'creation_date': [datetime.datetime(1999, 10, 11, 11, 5, 17), datetime.datetime(1999, 10, 11, 4, 5, 17)], 'expiration_date': [datetime.datetime(2026, 10, 11, 11, 5, 17), datetime.datetime(2026, 10, 11, 0, 0)], 'name_servers': ['DNS.BAIDU.COM', 'NS2.BAIDU.COM', 'NS3.BAIDU.COM', 'NS4.BAIDU.COM', 'NS7.BAIDU.COM', 'dns.baidu.com', 'ns4.baidu.com', 'ns3.baidu.com', 'ns7.baidu.com', 'ns2.baidu.com'], 'status': ['clientDeleteProhibited https://icann.org/epp#clientDeleteProhibited', 'clientTransferProhibited https://icann.org/epp#clientTransferProhibited', 'clientUpdateProhibited https://icann.org/epp#clientUpdateProhibited', 'serverDeleteProhibited https://icann.org/epp#serverDeleteProhibited', 'serverTransferProhibited https://icann.org/epp#serverTransferProhibited', 'serverUpdateProhibited https://icann.org/epp#serverUpdateProhibited', 'clientUpdateProhibited (https://www.icann.org/epp#clientUpdateProhibited)', 'clientTransferProhibited (https://www.icann.org/epp#clientTransferProhibited)', 'clientDeleteProhibited (https://www.icann.org/epp#clientDeleteProhibited)', 'serverUpdateProhibited (https://www.icann.org/epp#serverUpdateProhibited)', 'serverTransferProhibited (https://www.icann.org/epp#serverTransferProhibited)', 'serverDeleteProhibited (https://www.icann.org/epp#serverDeleteProhibited)'], 'emails': ['abusecomplaints@markmonitor.com', 'whoisrelay@markmonitor.com'], 'dnssec': 'unsigned', 'name': None, 'org': 'Beijing Baidu Netcom Science Technology Co., Ltd.', 'address': None, 'city': None, 'state': 'Beijing', 'zipcode': None, 'country': 'CN'}

|

||||

```

|

||||

|

||||

6. `robotparser`模块:解析`robots.txt`的工具。

|

||||

|

||||

```Python

|

||||

>>> from urllib import robotparser

|

||||

>>> parser = robotparser.RobotFileParser()

|

||||

>>> parser.set_url('https://www.taobao.com/robots.txt')

|

||||

>>> parser.read()

|

||||

>>> parser.can_fetch('Baiduspider', 'http://www.taobao.com/article')

|

||||

True

|

||||

>>> parser.can_fetch('Baiduspider', 'http://www.taobao.com/product')

|

||||

False

|

||||

```

|

||||

|

||||

### 一个简单的爬虫

|

||||

|

||||

一个基本的爬虫通常分为数据采集(网页下载)、数据处理(网页解析)和数据存储(将有用的信息持久化)三个部分的内容,当然更为高级的爬虫在数据采集和处理时会使用并发编程或分布式技术,这就需要有调度器(安排线程或进程执行对应的任务)、后台管理程序(监控爬虫的工作状态以及检查数据抓取的结果)等的参与。

|

||||

|

||||

|

||||

|

||||

一般来说,爬虫的工作流程包括以下几个步骤:

|

||||

|

||||

1. 设定抓取目标(种子页面/起始页面)并获取网页。

|

||||

2. 当服务器无法访问时,按照指定的重试次数尝试重新下载页面。

|

||||

3. 在需要的时候设置用户代理或隐藏真实IP,否则可能无法访问页面。

|

||||

4. 对获取的页面进行必要的解码操作然后抓取出需要的信息。

|

||||

5. 在获取的页面中通过某种方式(如正则表达式)抽取出页面中的链接信息。

|

||||

6. 对链接进行进一步的处理(获取页面并重复上面的动作)。

|

||||

7. 将有用的信息进行持久化以备后续的处理。

|

||||

|

||||

下面的例子给出了一个从“搜狐体育”上获取NBA新闻标题和链接的爬虫。

|

||||

|

||||

```Python

|

||||

import re

|

||||

from collections import deque

|

||||

from urllib.parse import urljoin

|

||||

|

||||

import requests

|

||||

|

||||

LI_A_PATTERN = re.compile(r'<li class="item">.*?</li>')

|

||||

A_TEXT_PATTERN = re.compile(r'<a\s+[^>]*?>(.*?)</a>')

|

||||

A_HREF_PATTERN = re.compile(r'<a\s+[^>]*?href="(.*?)"\s*[^>]*?>')

|

||||

|

||||

|

||||

def decode_page(page_bytes, charsets):

|

||||

"""通过指定的字符集对页面进行解码"""

|

||||

for charset in charsets:

|

||||

try:

|

||||

return page_bytes.decode(charset)

|

||||

except UnicodeDecodeError:

|

||||

pass

|

||||

|

||||

|

||||

def get_matched_parts(content_string, pattern):

|

||||

"""从字符串中提取所有跟正则表达式匹配的内容"""

|

||||

return pattern.findall(content_string, re.I) \

|

||||

if content_string else []

|

||||

|

||||

|

||||

def get_matched_part(content_string, pattern, group_no=1):

|

||||

"""从字符串中提取跟正则表达式匹配的内容"""

|

||||

match = pattern.search(content_string)

|

||||

if match:

|

||||

return match.group(group_no)

|

||||

|

||||

|

||||

def get_page_html(seed_url, *, charsets=('utf-8', )):

|

||||

"""获取页面的HTML代码"""

|

||||

resp = requests.get(seed_url)

|

||||

if resp.status_code == 200:

|

||||

return decode_page(resp.content, charsets)

|

||||

|

||||

|

||||

def repair_incorrect_href(current_url, href):

|

||||

"""修正获取的href属性"""

|

||||

if href.startswith('//'):

|

||||

href = urljoin('http://', href)

|

||||

elif href.startswith('/'):

|

||||

href = urljoin(current_url, href)

|

||||

return href if href.startswith('http') else ''

|

||||

|

||||

|

||||

def start_crawl(seed_url, pattern, *, max_depth=-1):

|

||||

"""开始爬取数据"""

|

||||

new_urls, visited_urls = deque(), set()

|

||||

new_urls.append((seed_url, 0))

|

||||

while new_urls:

|

||||

current_url, depth = new_urls.popleft()

|

||||

if depth != max_depth:

|

||||

page_html = get_page_html(current_url, charsets=('utf-8', 'gbk'))

|

||||

contents = get_matched_parts(page_html, pattern)

|

||||

for content in contents:

|

||||

text = get_matched_part(content, A_TEXT_PATTERN)

|

||||

href = get_matched_part(content, A_HREF_PATTERN)

|

||||

if href:

|

||||

href = repair_incorrect_href(href)

|

||||

print(text, href)

|

||||

if href and href not in visited_urls:

|

||||

new_urls.append((href, depth + 1))

|

||||

|

||||

|

||||

def main():

|

||||

"""主函数"""

|

||||

start_crawl(

|

||||

seed_url='http://sports.sohu.com/nba_a.shtml',

|

||||

pattern=LI_A_PATTERN,

|

||||

max_depth=2

|

||||

)

|

||||

|

||||

|

||||

if __name__ == '__main__':

|

||||

main()

|

||||

```

|

||||

|

||||

### 爬虫注意事项

|

||||

|

||||

通过上面的例子,我们对爬虫已经有了一个感性的认识,在编写爬虫时有以下一些注意事项:

|

||||

|

||||

1. 上面的代码使用了`requests`三方库来获取网络资源,这是一个非常优质的三方库,关于它的用法可以参考它的[官方文档](https://requests.readthedocs.io/zh_CN/latest/)。

|

||||

|

||||

2. 上面的代码中使用了双端队列(`deque`)来保存待爬取的URL。双端队列相当于是使用链式存储结构的`list`,在双端队列的头尾添加和删除元素性能都比较好,刚好可以用来构造一个FIFO(先进先出)的队列结构。

|

||||

|

||||

3. 处理相对路径。有的时候我们从页面中获取的链接不是一个完整的绝对链接而是一个相对链接,这种情况下需要将其与URL前缀进行拼接(`urllib.parse`中的`urljoin()`函数可以完成此项操作)。

|

||||

|

||||

4. 设置代理服务。有些网站会限制访问的区域(例如美国的Netflix屏蔽了很多国家的访问),有些爬虫需要隐藏自己的身份,在这种情况下可以设置使用代理服务器,代理服务器有免费的服务器和付费的商业服务器,但后者稳定性和可用性都更好,强烈建议在商业项目中使用付费的商业代理服务器。如果使用`requests`三方库,可以在请求方法中添加`proxies`参数来指定代理服务器;如果使用标准库,可以通过修改`urllib.request`中的`ProxyHandler`来为请求设置代理服务器。

|

||||

|

||||

5. 限制下载速度。如果我们的爬虫获取网页的速度过快,可能就会面临被封禁或者产生“损害动产”的风险(这个可能会导致吃官司且败诉),可以在两次获取页面数据之间添加延时从而对爬虫进行限速。

|

||||

|

||||

6. 避免爬虫陷阱。有些网站会动态生成页面内容,这会导致产生无限多的页面(例如在线万年历通常会有无穷无尽的链接)。可以通过记录到达当前页面经过了多少个链接(链接深度)来解决该问题,当达到事先设定的最大深度时,爬虫就不再像队列中添加该网页中的链接了。

|

||||

|

||||

7. 避开蜜罐链接。网站上的有些链接是浏览器中不可见的,这种链接通常是故意诱使爬虫去访问的蜜罐,一旦访问了这些链接,服务器就会判定请求是来自于爬虫的,这样可能会导致被服务器封禁IP地址。如何避开这些蜜罐链接我们在后面为大家进行讲解。

|

||||

|

||||